![]()

Motivation

BERT 等预训练模型使得自然语言处理等相关研究能够充分利用大规模的无标注语料,推动了整个自然语言处理的发展。那么接下来如何进一步提升 BERT 等模型的效果是研究人员关注的一个重点。除了结构,训练方式等,一个重要的分支就是使用外部知识,利用外部知识提升模型的效果。

常规做法是增加一个额外的任务帮助模型利用外部知识,这种存在一个问题,额外的任务会影响 BERT 本身的结构和参数,因此提升效果是不稳定的,有没有更加简单有效的方法提升模型的效果呢?

针对这个问题,本文针对 BERT 在文本语义匹配任务上进行了一个深入的研究,并设计了一种简单有效的外部知识利用方法。

![]()

论文标题:

Using Prior Knowledge to Guide BERT’s Attention in Semantic Textual Matching Tasks

论文作者:

Tingyu Xia / Yue Wang / Yuan Tian / Yi Chang

论文链接:

https://arxiv.org/abs/2102.10934

代码链接:

https://github.com/xiatingyu/Bert_sim

![]()

为了分析如何引入外部知识,引入何种外部知识,作者首先对 BERT 进行了验证分析,分析 BERT 学到了哪些知识,是在哪些层中学习到的,然后在有针对性的设计外部知识以及知识引入方法。本文也根据作者的这个思路来介绍这篇文章。

在这部分,作者主要进行了两个方面的问题,数据增强分析,逐层表现分析。

2.1.1 数据增强分析

这部分的主要思想就是通过对比 BERT 在不同数据增强的数据上的表现,如果某个数据增强策略能够提升 BERT 的效果,那么就说明 BERT 并没有学习到这部分知识,还需要增强;否则说明 BERT 已经学习到这些知识了。

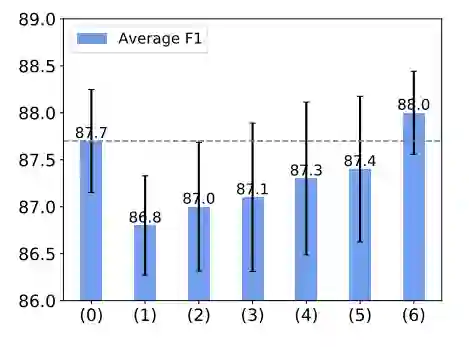

为此,作者选择了多种数据增强的方法,包括 Split and swap,Add random word ,Back translation ,Add high-TfIdf word ,Delete low-TfIdf word ,Replace synonyms 。相关的实验结果如下图所示:

![]()

其中虚线为原始 BERT 模型的基线效果,从图中可以看出在所有的数据增强方法中,除了替换同义词(Replace synonyms )之外,其他方法都导致模型效果下降,说明了 BERT 在同义词理解和利用方面仍存在一定的欠缺,可以使用这部分知识进行提升(

P.S. 这种方法可能会有一点问题,因为其他数据增强的方法可能会改变语义,而同义词替换并不会改变语义,这点仍值得商榷

)

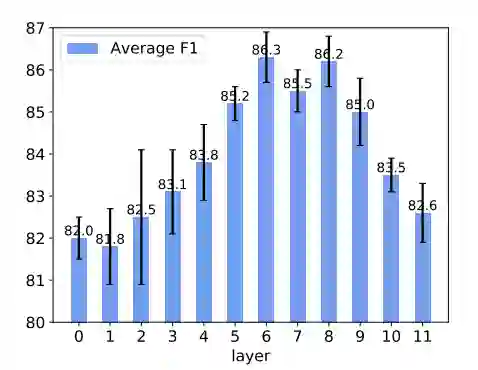

这部分相对来说简单一些,作者固定 BERT 的参数,然后分别抽取每一层的结果,然后利用一个简单的分类器进行文本语义匹配分类,通过实验结果看哪一层的效果最好,效果好说明这层学习到了知识,效果不好说明该层仍需要一定的改进和提升,相关实验结果图如下:

从实验结果看模型中间层的输出结果能够取得最好的效果,而底层和顶层的效果都不太好。这其实也很好解释,底层还没有真正学习到有用的知识,中间层学习的是相对通用的知识,而顶层的学习到底是任务相关的知识(NSP, MLM)。因此,从这个实验结果中可以看出,如果要增加额外知识的话,应该增加到底层。

2.2 外部知识引入

经过前一步的分析,本文已经大致确定了如何利用外部知识的思路,即使用同义词知识增强 BERT 模型底层的表现,从而提升模型的效果,因此作者提出了利用词相似知道底层注意力的计算。具体如下:

2.2.1 Word Similarity Matrix

输入两个句子之后,构建一个针对两个句子的词相似矩阵,其中每个元素值的确定方法:如果对应的两个词在 WordNet 中是同义词,那么值就为 1,如果不是,那就是 0,同样,对已一些停用词,或者这两个词并没有在 WordNet 中发现,均用 0 表示,然后使用在 WordNet 中的拓扑距离对整个词相似矩阵进行调整,具体可以参见(Verbs semantics and lexical selection)

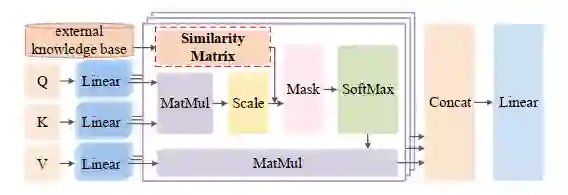

2.2.2 Knowledge-Guided Attention

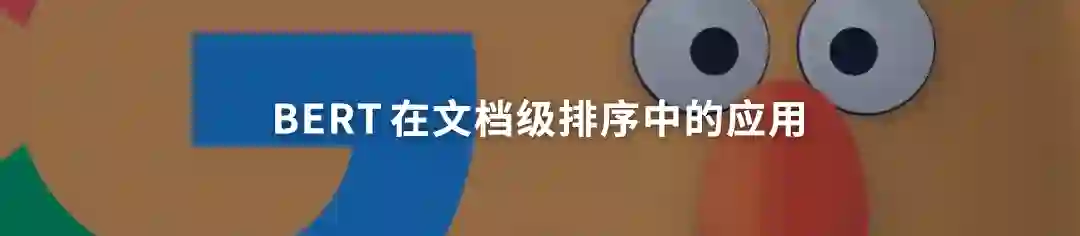

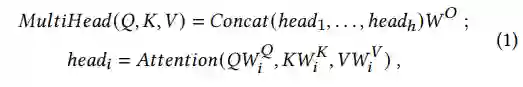

该步主要是将得到的词相似矩阵用于底层注意力计算的修正,具体而言,BERT 对输入的句子进行处理,然后计算注意力得分的过程可以表示为:

![]()

而作者直接将得到的词相似矩阵加到了 score 的计算过程中,这样公式2就被修正为如下形式:

通过这种形式就实现对外部知识的充分利用。该过程还可以使用下图表示:

需要说明的是相似度矩阵构建的方式可以有很多种,能够根据不同的需求进行不同的调整,是非常灵活的。

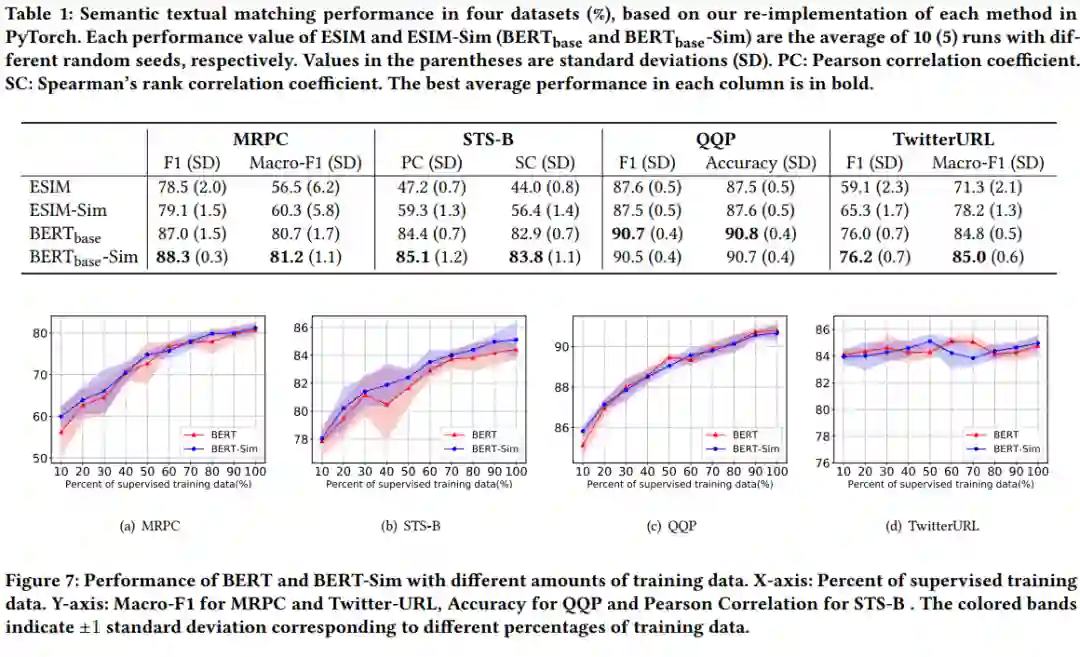

为了验证模型的效果,作者分别在多个语义匹配的数据集上进行了相关的实验,例如 MRPC, STS-B, QQP, Twitter-URL,相关的实验结果如下图所示:

还是可以很直观说明本文提出的方法的效果的。另外作者为了更好的验证提出的方法的效果,相同的操作也针对 ESIM 模型进行了验证,这里就不在举例了。

本文是 WWW 2021 的一篇文章,文章稳扎稳打,从模型分析引入,根据分析的结果得出改进方法,然后进行改进,接着进行改进方法的验证,有理有据,是一篇值得深挖和学习的文章。

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()

![]()