北京大学黄铁军 | 30年内或实现人造大脑

黄铁军教授,北京大学信息科学技术学院教授,计算机科学技术系主任,国家杰出青年科学基金获得者,教育部长江学者特聘教授。

黄铁军教授从人工智能的发展史出发,阐释了强人工智能的意义,以及它会对人类可能所产生的影响,在这一点上,他表示同意霍金和马斯克的威胁论观点。

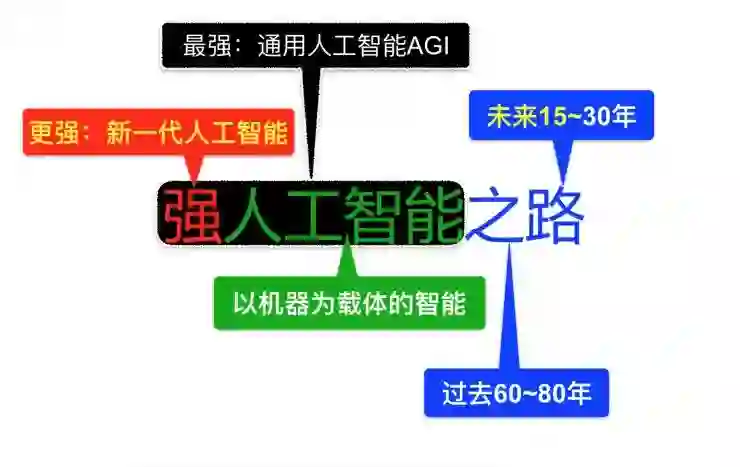

其次,尽管学界对人工智能是否能拥有「自我意识」存在争议,但他坚持认为这是实现强人工智能不可回避的问题。他提出「智能为用,机器为体」的观点,表示不做机器,只谈智能很难有颠覆性变化产生,要产生强人工智能,就一定要制造新一代机器。他预测,未来15-30年,人类将亲眼见证人造大脑变成现实。

近日,2017年度国家科学技术奖评选结果揭晓,北京大学黄铁军教授牵头研发完成的项目「高效视觉特征分析和压缩关键技术」荣获国家科学技术发明奖二等奖。

以下为黄铁军教授演讲内容实录:

我今天给大家报告的题目是《强人工智能之路》。第一,什么是人工智能,人工智能我想最经典的定义是「以机器为载体的智能」,我不想用「人工」这个词,因为这个词就好像人赋予它才叫智能。不是这样的,人的智能来自人和环境的互动和进化,机器也可以与环境互动,通过学习拥有越来越强的智能。

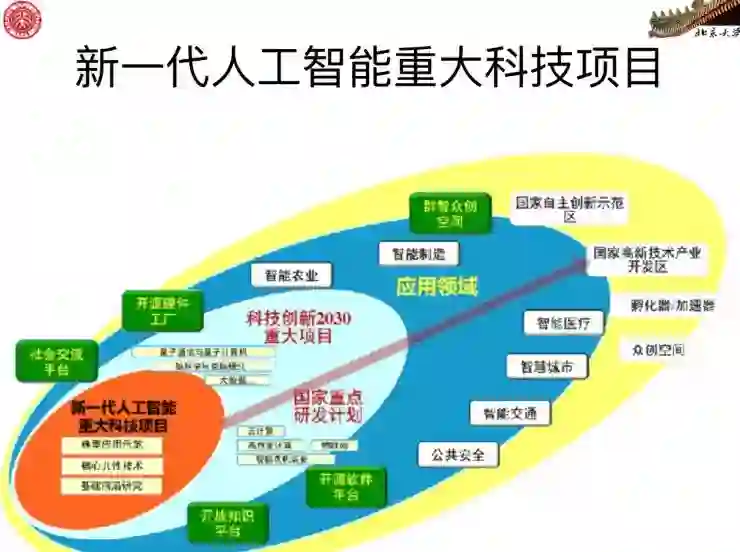

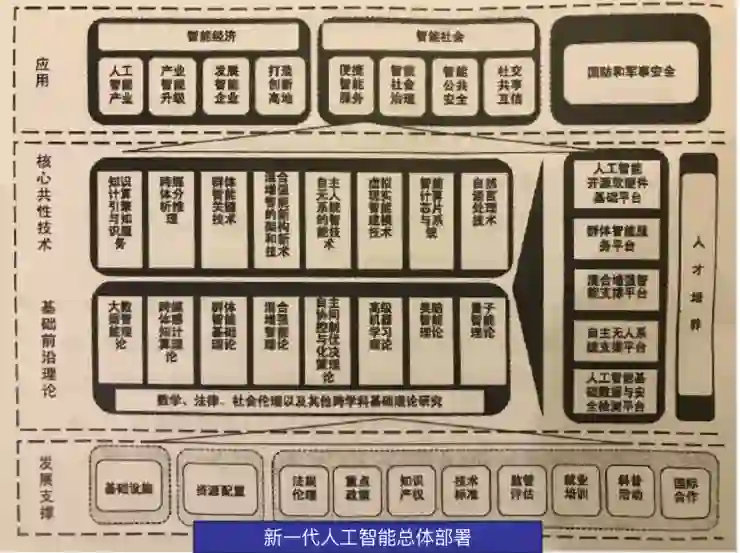

第二,「强」意味着「更强」。新一代人工智能国家规划都出来的,等会儿我会提到它比经典人工智能更强在什么地方。

「强」还意味着「最强」。什么是最强的人工智能?这就是强人工智能,这是人工智能的终极目标,我们制造出强人工智能,才算完成了历史使命。

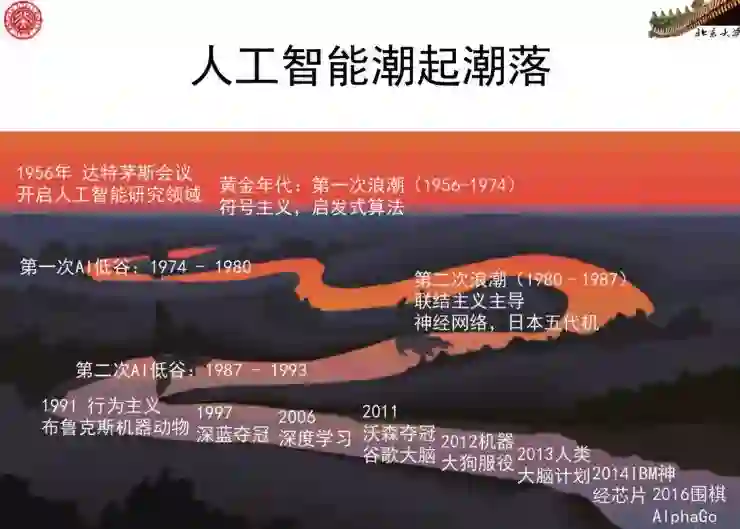

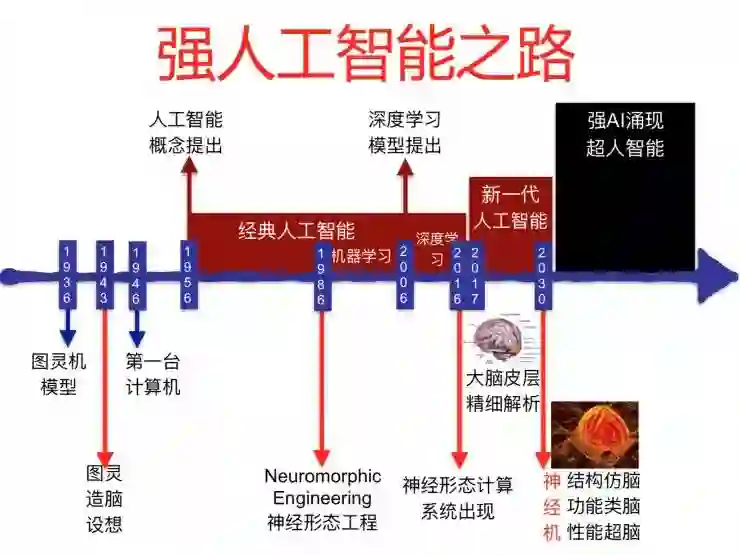

在历史上,一般我们讲人工智能60年,1956年到2016年。但事实上,在1956年之前,在计算机发明之前就有提出了相关思想,可以说人工智能和计算机一样差不多走过了八十年左右的时间。我还会讲一下未来,但做预测从来都是吃力不讨好的事情,或者说给自己立Flag,但是我还得立,不立我们往哪个方向走?所以我要讲一下未来15到30年可能发生的一些重要的事情。

强人工智能避不开「自我意识」

先说强人工智能,强人工智能是一个学术词语,不是一个媒体词语。在人工智能发展到上世纪七八十年代的时候,就已经有了很多争论,最后把人工智能分为两类,一类叫强人工智能,一类叫弱人工智能,或者一类叫通用人工智能,另一类叫专用人工智能。

通用人工智能或强人工智能说的是什么?它有一个根本的特征,就是能够适应环境,应对未知挑战,具有自我意识,达到人类水平,因此能超越人类,这种智能才能叫强人工智能,其他我们今天说的这些都不叫强人工智能。

当然,这个话马上就有争议,具有自我意识这个词是很敏感的一个说法,所以大家写学术论文,做这个政府文件的时候都不用这个词,因为一用这个词就知道你要说什么了。但我想,我们今天要探讨的就是这样一种人工智能。

在我们国家文件里边,比如说中共中央国务院2016年的《国家创新驱动发展战纲要》里边用的词叫「类人智能」;新一代人工智能发展规划中提到了大数据智能、跨媒体智能、群体智能、混合增加智能、自主无人系统和类脑智能,为什么都绕开这个核心词不去碰?

这个词特别敏感,但我今天还是要讲一下,再敏感的事情我们也要去讨论。

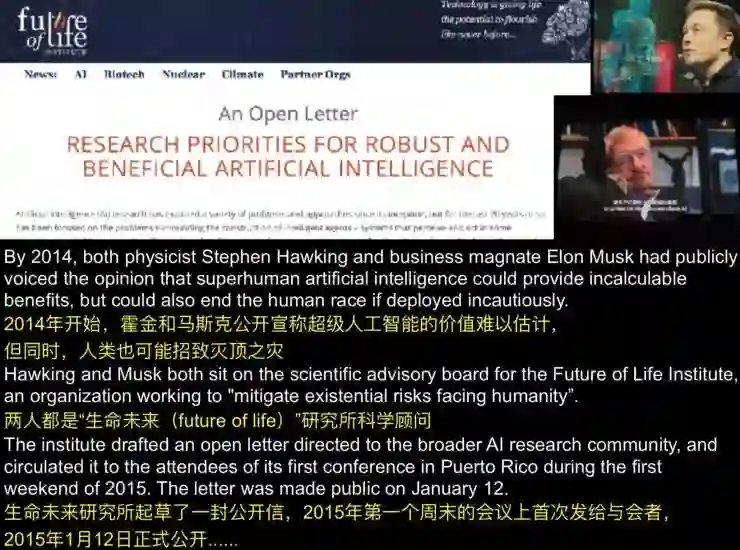

我个人对这件事的看法跟霍金、埃隆·马斯克的类似。他们在媒体上说这个人工智能很厉害,如果我们做出超级人工智能的话,人类就会招致灭顶之灾。很多人不以为然,一个搞物理的,一个搞创业的,他们怎么就对人工智能做出这样的判断呢?

他们正式公开表态是在2015年1月12日,大家可以搜一下。我说跟他们的看法一样,其实在一个星期之前,我就发表了一篇非学术文章《人类能制造出超级大脑吗?》,认为这件事会发生,而且会在不久的将来发生。多长时间呢?我认为,乐观地说,差不多就是15—30年之内。

又给自己立Flag了,我立这个是因为,反正30年之后我还得活着,我说对了,大家就能记住我当年说的,如果我说得不对,那北大本来也应该做创新性事情的(笑)。我说的不是开玩笑,我们真正要认真想这件事。

为什么会发生?因为历史已经进展到了这样一个阶段,以2016年作为历史坐标的话,我们看深度学习发展了十年,人工智能发展了60年,从1956年,第一台计算机发明70周年,1946年图灵提出计算机模型80周年,在这样的一个时间点上看,整个技术和思想在往什么方向发展?

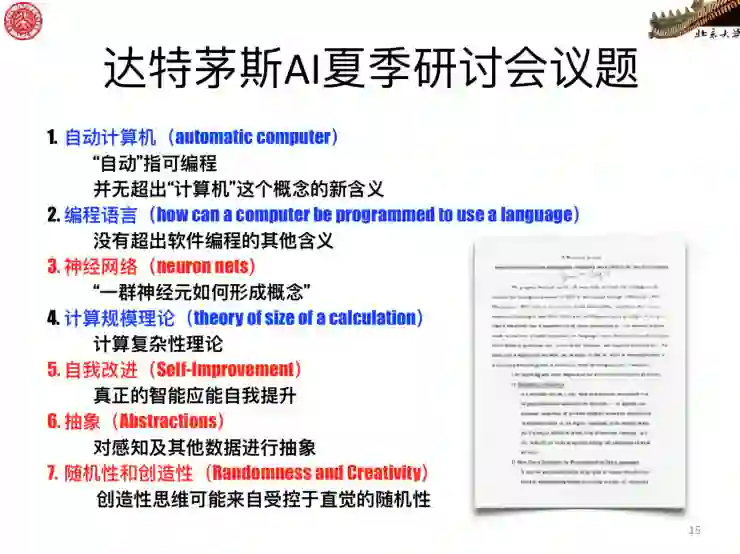

1956年,在提出人工智能概念的达特茅斯学院会议上,就提到通过计算机仿真实现人工智能,提出虽然当时计算机很慢,存储很小,但这不是主要问题,问题是在于能不能写出把这个潜力发挥出来的程序。计算机的能力会逐渐提高的,我们只要把这个程序(算法、模型、软件)写出来,关键应该在这个地方,这是他们当时的一个想法。60年来,人工智能发展有很多里程碑性的进步,一般总结人工智能我们有三大流派,符号主义、连接主义和行为主义,我不展开了。

我们关注什么问题呢?我们关注智能和人工智能背后实现的载体到底是什么。智能是一种功能,是一种现象,这种能力是靠什么东西来实现的?人的智能靠人的大脑和人的身体实现,那人工智能呢?承载智能的那台机器到底是什么?似乎最后一个跟没问一样,那不就是计算机吗?但实际我们不能这么简单的看。

大脑——强人工智能唯一参照物

经典计算机承载得了人工智能吗?我们看80年代的历史,我挑几个最重要的,图灵在1936年为了解决不可计算数存在这样一个数学问题提出了图灵机模型,这就是沿用至今的计算机概念模型。但计算机是个副产品,图灵是为了证明一个数学问题,就是计算机能够计算的数是很稀疏的,不可计算的数才是更广的。所以计算机的理论边界,在1936年它没出现的时候,就已经确定了。

大家要明白,因为这个机器出来之后,就想让它发挥更多作用,所以1956年开始就想在计算机上编算法、写程序,实现人工智能,但大家看看,计算机发明70周年都干了些什么?从科学计算到今天的大数据、云计算,哪一个真正触及了智能的核心问题?

我们不能说这些系统没有智能,我的意思是,都没有触碰智能的核心问题,它只是在解决规模越来越大、越来越复杂的应用问题。不是智能,只是有一些智能的表现,为什么是这样?

因为计算机的成功得益于晶体管,得益于集成电路,得益于摩尔定律,速度越来越快,规模越来越大,我们计算机专业就赶上了一个顺风车,但这不等于他自然就是人工智能的载体,它只不过是一个很好用的,很强的一个计算工具而已。我们看今天的人工智能,例如神经网络这样一种结构,为什么要在计算机这个平台上去实现?

我觉得不用做深度理论分析就知道,图灵、冯诺依曼提出了一个CPU、存储器,中间有一个总线这样的架构,凭什么就成了我们说的以神经网络为基础的新一代人工智能和未来人工智能的平台了?这两种结构没有什么相关性。计算机是为了解决计算和逻辑问题,而神经网络是大量神经元相互作用,这两个结构没有任何天然上的可比性。干嘛我们一定要在计算机上去实现这样的一种智能?

事实上,我们再回到1956年,我们看他们讨论了七大问题,分成两类,蓝色的部分就是我们今天计算机学科,包括今天我们给本科生上课设置的课程体系,包括计算机硬件、软件、算法、编程以及计算理论。但还有四个问题还不是计算机学科覆盖的主要内容,第三个,神经网络,第五个,自我改进,第六个,抽象,第七个,随机性和创造性。这些问题至今应该说还刚刚起步,还远远没有解决。

关于神经网络最根本的一个问题是第三个问题,即「一群神经元如何形成概念」。神经元、神经网络是物理存在,包括我们生物大脑的生物神经元和神经网络,而概念、思维、意识、精神是抽象存在,凭什么这样的物理存在就冒出了精神存在?不管是对人还是对机器,物理到精神的这一步怎么跨出去的?这一定是智能的根本性问题,但现在还没有解决。

回过来,靠什么样的平台实现人工智能?有很多,计算机是图灵提出来的,但图灵并不认为计算机是实现智能的合适平台,这在历史上很清楚。他跟信息论创始人香农在1943年的时候有一个争论,香农的提议,也就是我们今天大多数人认为的人工智能:把文化的东西,把知识、逻辑、理性这些东西灌输给大脑,这叫做人工智能系统。

而图灵观点截然相反,他说,「我对造一个能力越来越强的大脑不感兴趣,我要的只不过是一个寻常的大脑,这个大脑跟你们老板的脑袋一样,就是跟AT&T公司老板的脑袋一样,不需要很聪明,但是我需要一个这样的脑,我不关心你装很多东西给这样的机器,这是1943年,第一台计算机还没出现的时候,图灵就这么认为的。」

后来,到了1950年,图灵的《计算机与智能》这篇论文提出「机器能思考吗?」的问题,是人工智能的真正的起点。在这篇文章里,他也确实说了:制造一个真正的智能机器必须具有学习能力,而制造这种机器的方法就是先制造一个模拟童年的大脑。因为没有这颗大脑,你想训练出智能是不可能的。

冯·诺依曼也是这么认为的,他留给我们后人的是1958年出版的《计算机与人脑》,他一个数学家,一个提出计算机体系结构的人为什么要去研究人脑?为什么要去研究神经元?就是要为真正的智能找一个合适的平台。

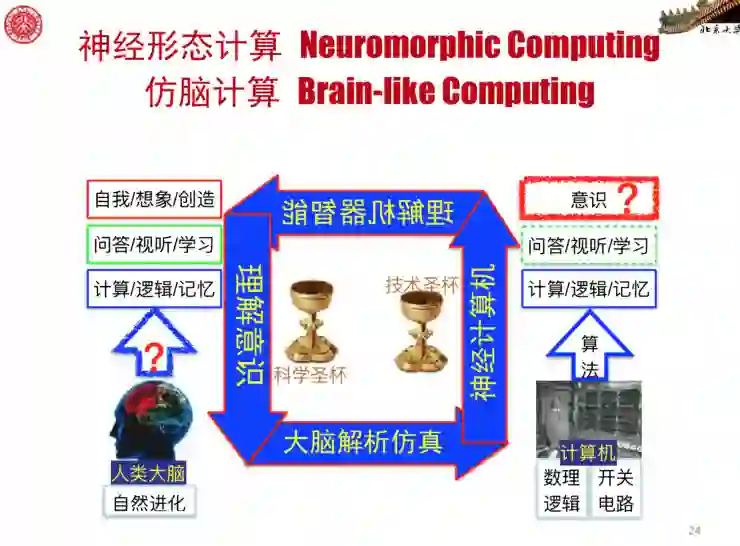

所以大家都认为要从大脑这边学。学什么?怎么学?这是一个关键问题,毫无疑问,我们的大脑有强人工智能,那好,我们从这个唯一的参照物里边怎么学?有很多人认为,比如最近热门的类脑计算,说要按照大脑怎么工作的这个原理设计算法,设计模型出来,就是模拟大脑功能这样一个思路。

这个思路对于有些简单问题是可能的,但是走不远,因为对于大脑的功能机理很难给出一个详细的描述,事实上这是人类面临的最大问题:意识的生物学基础是什么?靠怎么样的生物学机理意识就冒出来了?如果这个问题能解决,那自然我们搞信息的人照着这个模型去做算法就可以了。

造脑——神经计算机

问题是,这个问题什么时候能够解决?谁要敢告诉你这个问题三百年能解决,他就是很乐观的了。他要是告诉你,永远解决不了,这我也可以理解,因为这太难了。如果脑科学家回答不出这个问题,搞不清楚大脑是怎么思考的,我们搞信息的人就老老实实等着吧。如果是这样,那我现在就报告结束,不用做了。事实上不是这样的,我们不能这样等,不能等到他们把这个原理背后的机制搞清楚,我们才去做。

首先要搞清楚工程技术和科学的关系问题。工程技术绝大多数情况下都是领先于科学的,我说得太绝对可能大家不高兴,因为北大很多人都是搞科学的,但事实就是我们搞工程技术的先做出东西,搞科学的人再去解释这个东西背后的原理,而不是先有科学原理,再按照科学原理去做这个系统,后面这种情况不是真正的创新,真正的创新都是做出来一个科学原理都没法解释的系统,然后去解释,找科学原理。

对于大脑和这个未来的机器也是一样,我们要先去造一个机器。当然机器也不能乱造,你说造一个机器,凭什么就能产生智能?所以第一,要回到大脑,不是回到认知科学,而是要回到神经科学,我们要知道是什么样的神经网络产生了人类智能,是从大脑的物理层面看这件事,并不是从精神、意识这样的思维层面去看。

大脑的神经网络可以解析出来,然后基于这个图谱造神经计算机,进行训练让它产生智能,然后再去解释机器为什么就产生了智能呢,如果我们理解了背后的机理,我们再告诉脑科学家去检验生物大脑是否也是按照同样原理产生智能的。

当然这是一个工程量很大的事情,但是差不多十年左右把大脑精细解析是有可能的。欧洲的人类大脑计划,实际很多工作也在做这件事,美国脑计划也是一样的,首先要把大脑图谱弄出来,然后我们搞信息的人把它造出来做一台机器。

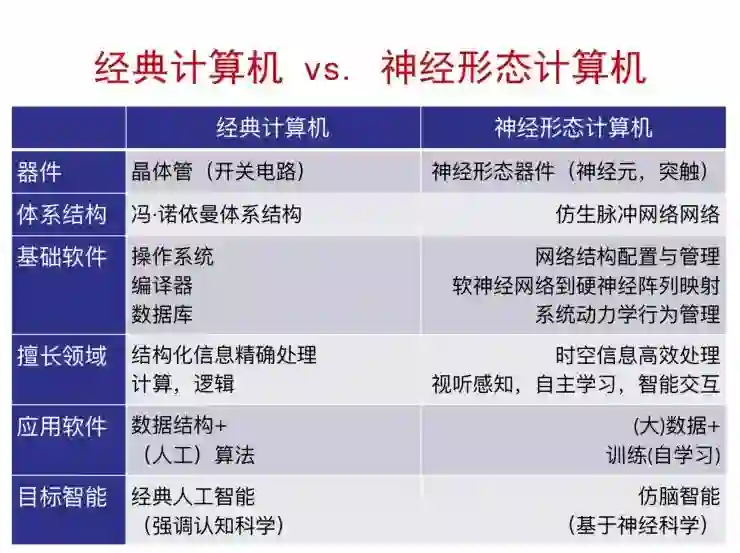

结构刚才说了,就是这样子,我们要做很多事,这台机器现在还没有名字,我们叫它神经计算机,或者叫神经形态机,它实际是按生物神经网络,用神经形态器件做的,这个器件就是人工突触和人工神经元,它处理的信息不是逻辑,不是要做计算,它就像一个生物要把感知这个世界的那些模态信息作为重要对象的一个机器。

这种机器如果我们跟经典计算机对比的话,每一层次都很清楚:基本器件是什么?结构应该怎么样?你怎么样训练这样的机器产生智能?你的科学基础是什么?科学基础主要是神经科学,不是认知科学,我说得有点绝对,但确实如此,认知科学是下一步的事情,现在我们需要的是神经科学。

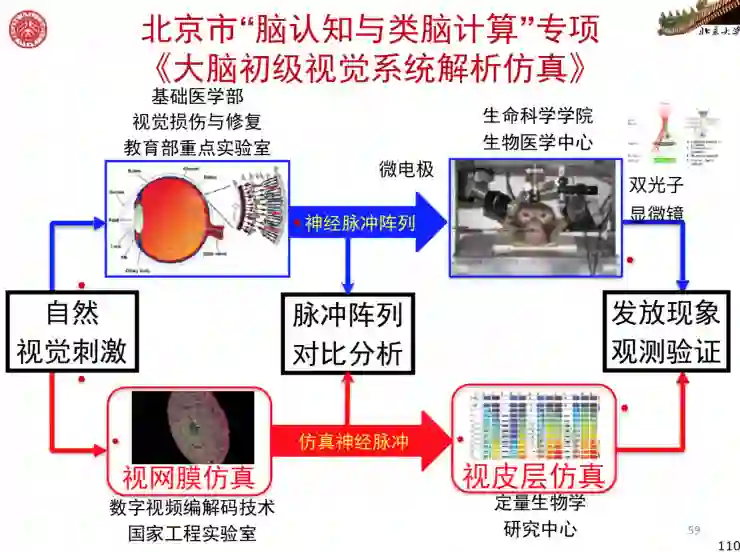

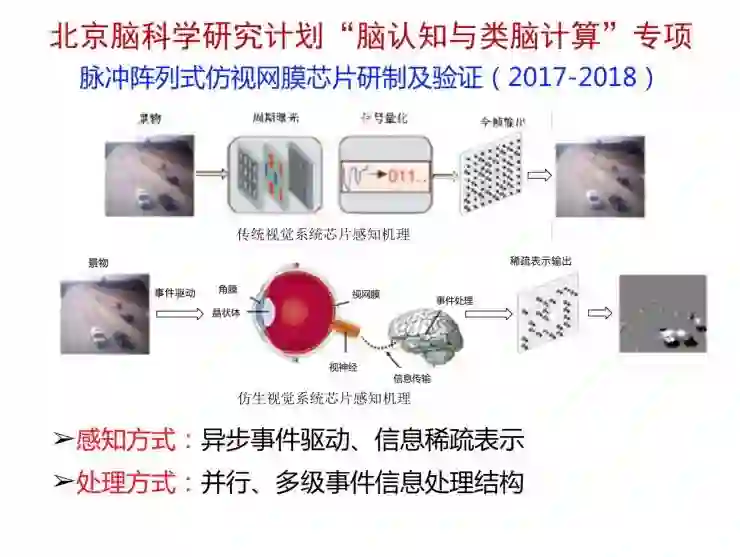

这个也是2015年开始的北京脑计划中「脑认知与类脑计算」专项规划的一个技术思路。美国也是这样的,它在2015年10月29号发布了一个报告,这也是会议的一个结果,也就是从材料到系统结构做这样的一个神经形态计算系统。这个方向已经发展了三十年,从1986年到今天已经三十多年了,但在国内的动静还比较小。在《斯坦福大学2030人工智能报告》里,最后一项讲的也是这项技术,是对人工智能未来影响最大的。

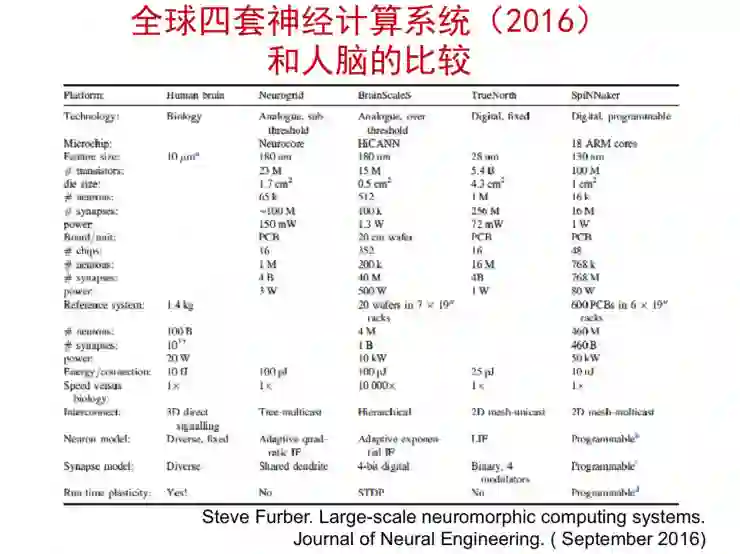

我说2016年是神经形态计算的元年,是因为全世界已有四套神经形态计算系统在运行,这四套系统从规模上当然都比不上人脑,但大家都在往这个方向逼近,包括IBM的SyNAPSE, 这大家都知道,2006年定的目标就是要做一个电子大脑皮层。然后海德堡大学,我们2015年去看欧洲人类大脑计划支持的刚刚在加电上线的系统,这个系统的目标是2022年做出一个硬件的电子大脑,信息处理能力和人脑相当。

我们国家的新一代人工智能规划里边也有这样一些东西,但是触不触碰这样一个核心问题,要不要造这样的机器,一直还有争论。我虽然坚决支持它,但毕竟还是人微言轻,还有很多不同的观点。总的来说,我觉得这是方向,必须去做。因为很简单,一个真正影响历史的东西不能停留在想法上,必须最终会变成物理的实现。

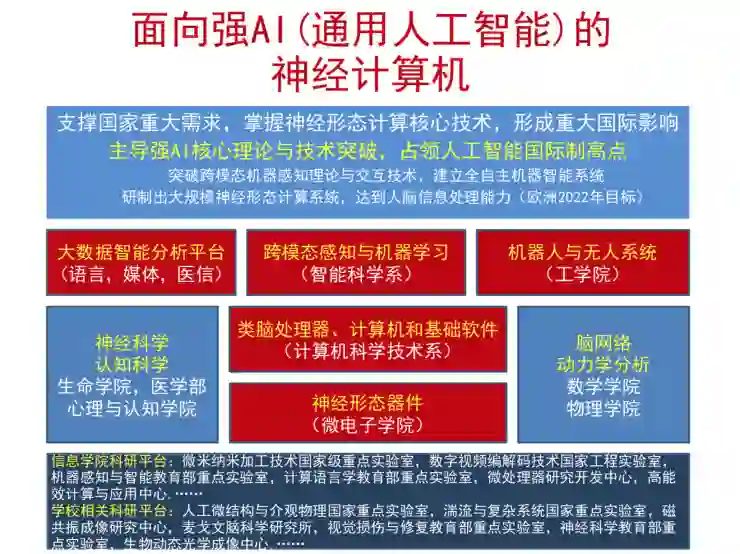

这种新型机器做出来之后,对通用人工智能的实现是基础性的。我们不能光在今天的计算机上玩算法,而是要造一个身体,造一个物理形态,这个物理形态要依赖于神经科学,也要依赖数理科学,要分析它的复杂功能,没有强大的数学物理,包括复杂系统理论,这个秘密我们最终是破解不了的。北大的有时就是学科齐全,有学术交叉基础,例如我们有最好的微电子基础做神经形态器件,也许还只有北大这种跨学科的学校才能做出来。

造眼——让强 AI 睁开眼睛

机器要想具有真正的智能,必须有一个真正的眼睛,像人的眼睛一样,这个眼睛不是摄像头,它要像生物研究一样工作。那生物眼睛怎么工作的?

现在所有的计算机视觉都是用视频,这是错的。视频是骗人眼睛的,生物视觉以及我们将来要做的超级人工智能的视觉,不能采用视频,而是要仿照生物信息处理的模式,这个模式就是神经脉冲,光电转换之后就变成神经脉冲,神经脉冲送出大脑,大脑是脉冲神经网络,采用脉冲进行信息的表达和处理。这里边有很多秘密,有很多科学问题要解决。

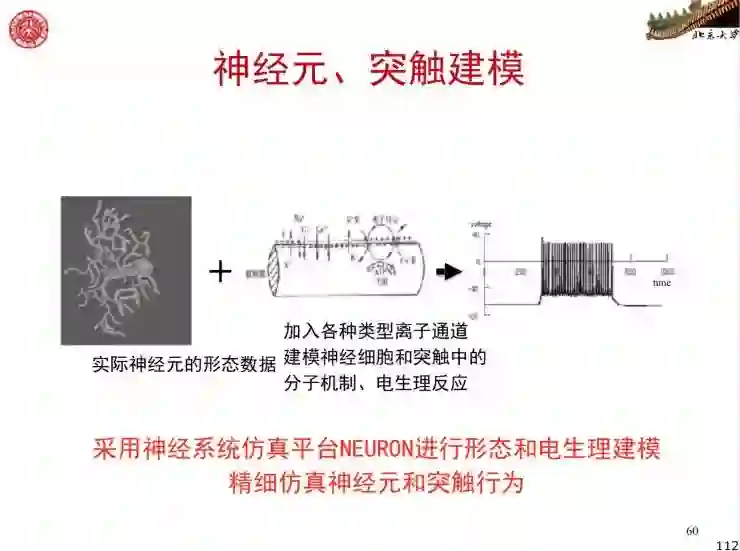

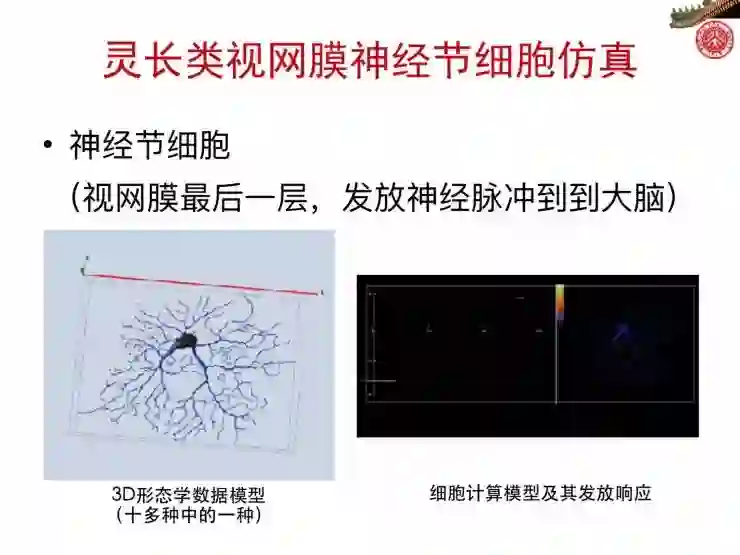

在北大,两年多时间我们做了一些工作,我给大家看一个结果,我们要把视网膜中每个神经元长什么样,以及生理特性测出来,然后在计算机上把它精确仿真出来,先不问为什么,生物是怎么做的,我们就去把它实现出来,这是一个神经元和它的发放过程。

把这样一些神经元都做出来之后,再连在一起。生物是怎么连在一起的,视网膜内的神经网络怎么连我们也怎么连。连完之后,它就是一个仿真的视网膜,到了这种规模,必须上超级计算机才能进行计算。把一个图像闪一下给它看,然后我们现在能看到这些神经元是怎么响应的。

这是神经节细胞,闪光的就是它在向大脑发放神经脉冲,把这个过程重构出来。重构出来之后干吗?当然要变成电子载体,所以今年的北京脑科学研究计划就支持我们做了一颗芯片。

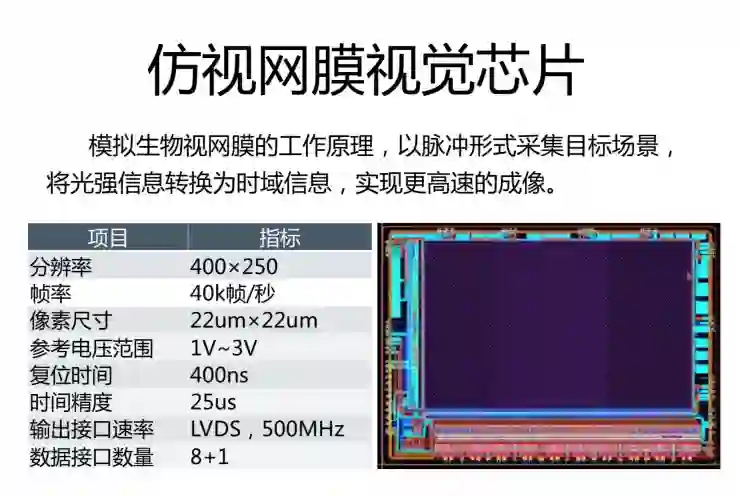

这个是仿视网膜的芯片。做芯片的时候不能把所有的生物细节都带进去,这样做不起,我们这个芯片只需要普通摄像头的成本,将来几十块钱就给大家用,比如用到机器人上,所以做了很多简化。这个芯片我还没拿到,我现在还都不能说百分之百做出来这种效果,下面是仿真的结果。

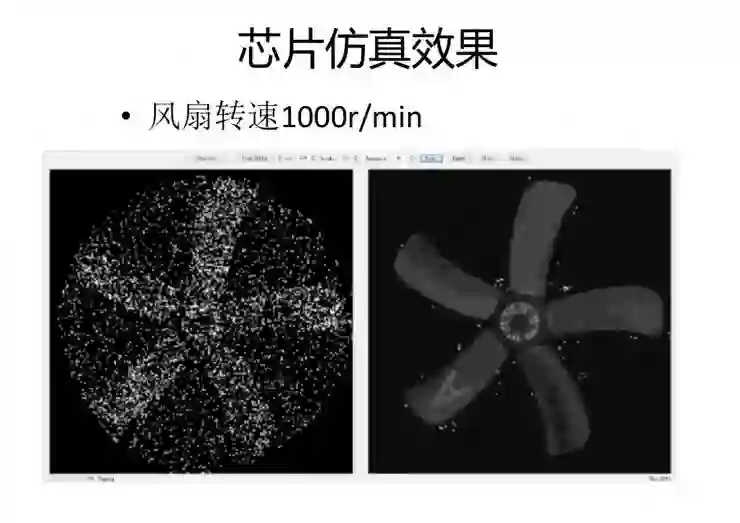

这是芯片看到的电扇转的过程,为了大家看清,慢速播放。左边是芯片产生的脉冲,然后我们就基于这个脉冲流重构,就像大脑皮层根据神经脉冲把这个画面重构出来一样。右边这个,能看清楚叶片上的数字,人做不到,我们肉眼看电扇,它一转起来就变成一团灰了。

它最大的一个特点就是,根据神经脉冲序列可以重构任意时刻的影像,视频的概念是每秒钟多少帧,也就是频率。而采用这种新型芯片,我们可以计算出任何一个时刻的影像,这是生物视觉。我们睁开眼看世界从来没有频率,为什么?因为你本身的信息处理机制不是按视频那种方式做的,这个芯片现在自然也具有这样的基本功能。

接着一个问题就是把速度做得更快,现在已经够快了,但是将来想做得更快,快到能看子弹、导弹,这都不是问题,只不过是一个速度加快的问题。这个当然都要花时间,现在目前定的就是五年,把眼睛完全搞透,然后把这个芯片做出来,后边还有很多工作要做。十年能把视皮层搞出来,我们就能搬到神经计算机上去实现。好在国家有脑科学和类脑研究这些重大科技项目,中国有资源可以做这件事情。

智能为用,机器为体

我们回过头来看,人工智能发展了这么多年,60年的经典时代,未来的15年,国家要做更强的人工智能,这是历史的发展过程,但是我们不能光看智能这个水面上的层次,而要看是什么样的一个物理载体支撑着这些智能的实现,那具体来说,就是经典计算机还是新的神经计算机?

1946年的计算机已经过去七十年,高速增长,这是我们今天人工智能谈的一个物理平台,但是它不是永远的平台,它也不是一个好的平台。好的平台,图灵在1943年就想到了。1986年开始,进入神经形态计算工程实验阶段,2016年,已经可以说有四套神经计算系统,预计不会超过15年,更强的、真正的神经计算机就会造出来,这种机器结构仿脑、功能类脑、性能超脑,它才是真正的强人工智能的一个物理平台。

我再简化一下说,这就叫「智能为用,机器为体」。不做机器,光说智能,很难有颠覆性的、革命性的变化,历史一再证明今天的人工智能发展了三十年,有起有落,深度学习发展这么些年,有了今天的热潮,但是我们如果往历史看的话,这些出现都是因为计算机的出现,而往未来看的话,就是我们一定要造新一代的机器。

今年是北京大学建校120年。北京大学1898年建校,在前两年,也就是1896年就有人说了一句话,这个人叫特斯拉,他说:我认为任何对人类心灵的冲击都比不过亲眼见证人把人造大脑变为现实。我认为这件事情的发生,很可能就在北京大学建校150周年之前。

📚往期文章推荐

🔗Judea Pearl | 机器学习的理论局限性与因果推理的七大特性

🔗Berkeley吴翼&FAIR田渊栋等人提出强化学习环境House3D

点击“阅读原文”,快速进入峰会报名通道!