本文约5495字,建议阅读10分钟

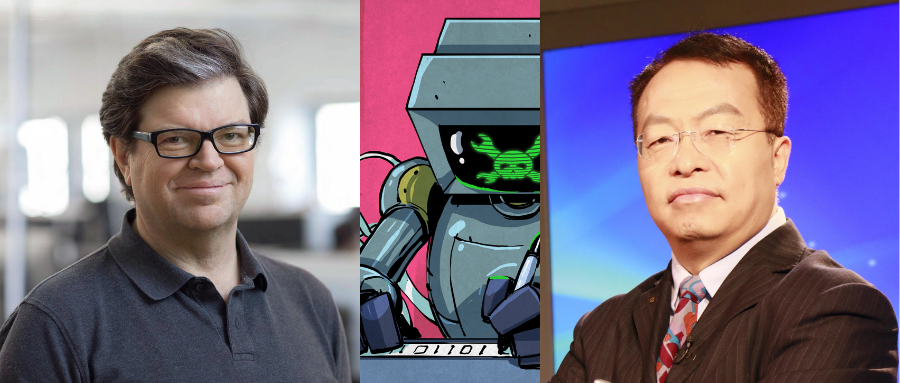

本文介绍了北京大学信息科学技术学院教授、智源研究院院长黄铁军与AI大牛Yann LeCun的观点碰撞。

![]()

东京大学编写的考试人工智能程序“东大”得到了好于80%考生的成绩,这说明日本高等教育的入学考试跟机器的智力一样肤浅。

索菲亚机器人算不上人工智能,只是一个完成度很高的塑料制品,并不比东京大学的“东大”更聪明。

如果有一家公司宣称实现了人类智能,那不是骗子,就是傻子。

上述言论每一句都毫不留情,透着耿直的味道。他的推特,也早就成了AI圈吃瓜群众的快乐源泉。

无论是批判人工智能无脑炒作,还是吐槽AI社区不够开放是历史倒退,亦或时不时发个思维小游戏逗乐自己,响应推特朋友圈上的AI joke,要么就给自己实验室的工作打打广告......只要逛逛他的推特,你就能看到一个立体的他。

作为一名知名学者,如此频繁而直言不讳地评论公共事件,自然不是为了立人设,他只是发自内心。不惧网络骂战的他,亦曾经被偏激的网友群体气的宣布推出推特。但不出数周,我们又再次刷到他的推文更新。

而在这本300页的新书中,你会发现,推特上的Yann LeCun,也只是他的人格投影。

《浪潮之巅》作者吴军如此评价他的性格:好学、广博、特立独行、执着,这些个人特质在他的自传《科学之路》中展露无遗。

在成为“AI网红”之前,Yann LeCun默默地为深度学习坚持数十年所付出的艰辛。

“尽管深度学习近几年一直是关注焦点,但

熟悉深度学习历史的人其实还是少数

。”北京大学信息科学技术学院教授、智源研究院院长黄铁军说道。”

深度学习的辉煌不是一夜造就的

,任何一项技术在落地前,都需要经历漫长的积累过程。”

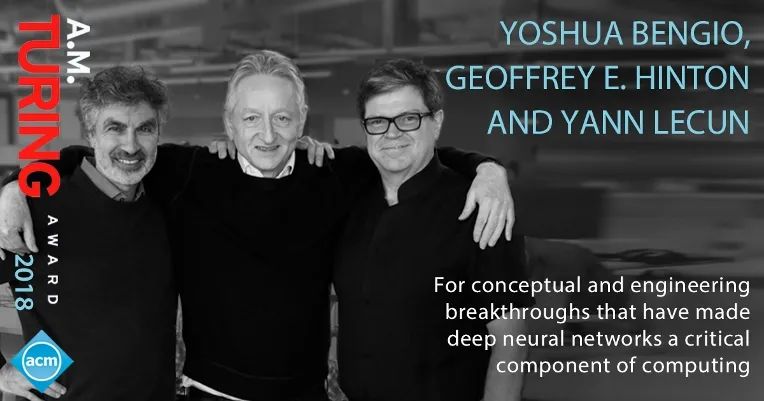

在学界普遍不看好神经网络的时候,Yann LeCun联合Geoffery Hinton、Yoshua Bengio,试图让人们认识到它的无限潜力。

但在这过程中,发论文首先就成为了一大阻力。包括ICML、CVPR、ICCV、NIPS(现名NeurIPS)等如今的AI顶级会议,当时均不欢迎深度学习论文。

幸好有CIFAR(加拿大高等研究院)对他们的支持,深度学习才开始在小小的讲习班讨论中逐步扩大它的影响力。Yann LeCun因此也对该研究院不吝溢美之词,“CIFAR这个名字名副其实,就是'see far'的意思。”

在深度学习前后端(数据和算力)尚未成熟的年代里,人们自然更加倾向于SVM等传统机器学习方法。但Yann LeCun不止一次抱怨,

人们拒绝深度学习的理由,实在令人无法接受

。“他们说这项技术太复杂了,除了Yann LeCun没人能让他发挥作用。这简直就是胡说八道。”LeCun还回忆道,Hinton亦曾经一度十分沮丧,感叹道“今天是我40岁生日,我的职业生涯到头了,什么也做不成了。”

后来,为了让人们相信深度学习的应用潜力,Hinton甚至用了一些“

小聪明

”。他将三名博士生分别送到了当时语音识别技术最领先的三家企业——微软、谷歌、IBM,并让他们在原有语音识别系统的中央模块中使用深度学习。自然,系统的性能得到了极大提升。一年半后,这三家公司都部署了新的基于深度学习的语音识别系统。

在Yann LeCun的直白叙述中,能感受更多的是他和合作伙伴对深度学习的坚持,而不是深度学习的科学创新。比如,对于CNN和反向传播算法的发明过程,Yann LeCun完全没有含糊其辞。

Geoffery Hinton开发的反向传播算法,是基于他的导师Dave Rumelhart的工作。他在Rumelhart开发的无法运行的程序雏形上做了改进,成功实现了反向传播算法。

Yann LeCun向Hinton的合作者Terry Sejnowski介绍他的HLM方法时,Hinton也早就实现了反向传播算法,并已经开始着手应用研究。Sejnowski不久后告诉Hinton:“法国有个孩子在进行跟我们同样的研究。”

Geoffrey Hinton(左)和Yann LeCun(右)

CNN的原型最初也是由日本科学家福岛邦彦发明的,他根据猫的视觉系统方面的研究开发了一种视觉算法,其原理是:用一层简单细胞检测铺满图像的小接收区域的简洁模式,而下一层利用复杂细胞处理收集到的激活信息。

这其实和CNN的工作原理非常相似,但当时他的算法无法调整所有层级的参数。直到反向传播算法的出现,这个问题才得以解决。

所以我们可以简单得出,他们并不是发明深度学习的第一人吗?但这种说法意义并不大,“

人工智能目前为止只是一门技术和工程学科,算不上科学

。”黄铁军说道,

“技术的进步是一步一步累进的,由于参与进来的学者会很多,因此每个人的贡献相对而言比较难以评估。比如飞机是法国人还是美国人发明的,历史上其实有过争论。”

而科学是从0到1的飞跃过程,其发现者的贡献就比较容易判断。比如物理学的牛顿定律和相对论,其诞生基本就是一夜之间的事情。

Yann LeCun还提到了不少学者做出了接近反向传播算法的成果,但这些工作都被用于其他领域,比如控制或微分方程数值解等,却从没想过用到神经网络上。

“

这三位学者对深度学习的贡献在于,他们坚持了下来,打通了深度学习的所有技术链路,并对深度学习做了大量的增量改进,同时在合适的时间点,让这一套技术发挥了很显著的作用。从这个角度来看,他们获得2018年图灵奖,实至名归

。”黄铁军表示。

Yoshua Bengio(左)、Geoffrey Hinton(中)、Yann LeCun(右)因对深度学习的概念和工程突破方面的贡献获得2018年图灵奖

CIFAR的助推最终取得了效果,三位学者亦不顾各种阻挠,长年在NIPS上举办研讨会。后来,深度学习文献也得到了AI会议的承认。

在2011年,因GPU的算力极大提升,以及前期互联网时代的数据积累,深度学习的革命开始启动。

人工智能作为一项工程技术,并不意味着比其他科学领域要低一阶。“其实很多重大科技进展,在从0~1的过程中,并不是在科学理论指导完成的,而是各种尝试探索的一个结果。”

掀起本轮人工智能浪潮的深度神经网络只是少见的成功个案,不过黄铁军认为,这就是技术探索的常态。

Yann LeCun 也曾说道,“在科学技术发展史上,工程创新往往首先出现,比如望远镜、蒸汽机、数字通信;而解释其功能和局限性的理论往往出现得较晚,比如折射定律、热力学和信息理论。”

在很多应用上,深度学习都达到了以前未能实现的效果,比如图像识别、机器翻译等等,人们也得以在探索智能本质的道路上更进一步。

深度学习一直被人诟病依赖大数据,但黄铁军不同意这个说法:“

深度学习的脆弱性,根本原因还是数据不够多

。”从生物进化百万年时间尺度来看,人类经历了大量的“环境数据”训练,并通过繁殖和遗传让这个训练过程得以持续进行,最后才有了现代的智能人类大脑。人出生时,已经具备适应地球环境的先验神经结构,这正是数百万年的数据沉淀。

“环境才是智能的真正来源,不同环境孕育不同智能。人们往往把今天人工智能系统的成功归结为三个要素:大数据+大算力+强算法

,数据就是环境的一种表现形式,是根本要素,另外两个要素主要影响效率

。”

“

所谓小数据方法,是以大数据‘预训练’为前提的

。”预训练模型是这两年人工智能的重点突破,目前还有很大的应用潜力。”只要有数据的地方,预训练模型就可以发挥作用。这条路线在未来几年都不会遇到瓶颈,并且也会持续带来新的发现。”

Yann LeCun也强调了一点,人类的信息处理能力并没有跟上信息时代数据增长的速度,深度学习将会是人类很好的辅助帮手。

而且,人们或许过于相信人类智能相对于机器的优越性了。不同算法拥有不同的先验,擅长任务也不同。人和机器也一样,

即便在感知方面,人也不一定比机器强

。

尽管人很擅长识别人脸,但黄铁军告诉我们,“ 人的人脸识别能力上限一般来说是1000个人脸左右,大约在数百到两千之间,再增加就会觉得容易撞脸。”而如今,一个人脸识别系统可以准确识别几百万人乃至数千万人。“这就好比计算机擅长逻辑推理,人类擅长类比和模拟,基本原因是其基础结构不同。”

另一方面,人们经常将大脑和AI的能耗对比作为评判AI不足的依据,比如为了实现和人脑一样的能力,计算机的能量消耗将是人脑的100万倍。然而,这背后也要考虑到,人类经过了进化过程的长期训练,才得以获得如今的能力

。在解决和先验不适应的任务时,耗费的计算量就会更大

。而对于我们需要什么样的先验这个问题上,我们或许不能局限于人类本身,毕竟现实世界还存在那么多“反人类”的枯燥工作。

在算法层面上,Yann LeCun也相信量变会带来质变。果蝇拥有25万个神经元、1000万个突触,人类拥有860亿个神经元、150万亿个突触,而相应地,这两个物种的智力差异也是巨大的。Yann LeCun认为,通过修改由简单的单元构成的网络中的连接,就能产生智能行为。

Yann LeCun坚信,人脑就是可以计算的机器,可以通过电子机器或计算机进行再现,而机器学习将完成这个使命。

他将学习或者智能定义为:

学习就是逐步减少系统误差的过程,机器学习就是机器进行尝试、犯错以及自我调整等操作

。

但黄铁军认为,这个定义还是比较片面,“机器的定义过于宽泛,没有深入到主体。”因此,他将智能定义为:

智能是系统通过获取和加工信息而获得的能力。智能系统的重要特征是能够从无序到有序(熵减)、从简单到复杂演化(进化)

。

这个定义强调了主体的存在,也就是说,智能要先回答“我是什么样的”,再回答“我怎么学”。而Yann LeCun对此强调不足,“只是在机器学习的范围内定义。”

在关于大数据和先验的讨论中,两位学者都非常注重前者,以及量变到质变的哲学规律。但同时,

对于智能的理论边界,他们似乎有着不同的认识

,黄铁军在这里重新审视了”先验“的意义。

Yann LeCun将目光聚焦于算法,认为只要集中精力深耕机器学习,就可以实现通用人工智能。黄铁军则表示,智能是一个多层次的结构,不仅仅要关注算法,还要关注底层硬件基础,这才是我们要关注的“主体”和“先验”。

认识论学家卡尔·波普尔提出,要以预测的能力而不是解释现有观察的能力来定义理论的质量。

Yann LeCun对此也深以为然,因为解释现有观察的理论只是提供了一个理解框架,如果不能用于预测,终究只是伪科学。

因此,基于预测的自监督学习范式,成为了Yann LeCun近几年一直追求的目标。自监督的基本范式其实就是,基于现有的数据在时间和空间上进行划分,并进行输入和输出的关联。

在时间上,我们可以根据过去、现在来预测未来,比如视频帧预测;根据现在来预测过去,比如追寻事件因果;根据当前时刻数据,根据部分数据预测另一部分数据,比如图像补全。

这种学习方式和人类观察世界的方式非常相似,并且无需花费大量成本进行数据标注。

而强调自监督学习只是表面,Yann LeCun更多地是基于对这种观察方式的理解。他认为人类通过观察世界在大脑中建立了世界模型,从而能够更好地执行预测。

世界模型在深度学习中的体现,或许存在于预训练模型的表征空间中,只是这个表征空间仍然非常复杂,难以提取出可理解的语义。

在世界模型的概念基础上,Yann LeCun提出了完整的智能框架:一个感知模块,一个世界模型,一个评判体系。

感知模块从外部世界获取数据,并根据任务类型,通过评判体系,将注意力集中到外部世界的重要部分,来构建内部的世界表征,也就是世界模型。而世界模型的最终目的,还是为了更好地完成任务。在获取外部世界数据时,智能体也需要规划自己的探索路径,使得这个过程更加有效率。反过来,世界模型的存在,也使得智能体的探索不至于盲目。

可以说,在这个框架内,世界模型是核心,智能的形成是世界模型不断和外部世界交互迭代的过程。世界模型既是训练得到的,也可以作为先验去限制智能体的搜索空间。“无模型强化学习算法没有世界模型,因此必须尝试所有的做法。”

Yann LeCun甚至认为,如果世界模型可以完整表征外部世界,就可以脱离外部世界,独立地在表征空间中进行脑内模拟,“比如,我们可以只靠世界模型来训练自动驾驶算法。”

但黄铁军则认为,这个世界模型不可能是完整的,其中必然存在无法被表征的外部世界现象。

底层硬件往往决定了算法的绝对潜力,比如人们期待量子计算的变革性力量,就在于它相对于经典计算机的绝对优势。

“脑科学至少可分为神经科学和认知科学两个层次,人工智能也至少应该分为功能和结构两个层次。”对比Yann LeCun提出的智能框架,其缺少对基础结构层次的关注。也就是说,

他提出的智能概念,不仅应该包含自监督学习和认知智能,还应该包括实现载体,而他可能已经假设是图灵计算机。

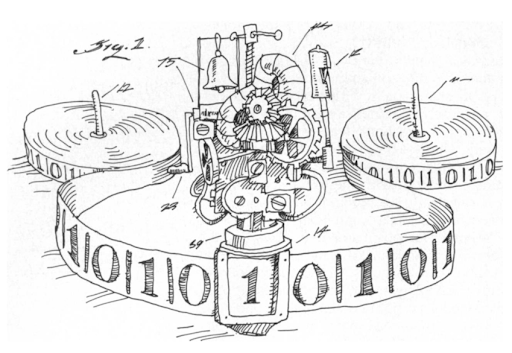

“我们不能只重视学习方法,而不重视执行学习的结构,两者结合才是完整的智能系统。”很多人没有考虑到的层面,就在于图灵计算机的极限。“人们现在有把计算的概念过度泛化的倾向,忘记了图灵当初定义可计算性的时候提出的基本概念。”

图灵机可以解决无数个问题,但无穷大实际上也存在级别差异

。

在集合论中,存在关于无穷大的分类。自然数的数量是无穷多个,但它是可数的,数量记为阿列夫零;实数数量也是无穷大的,但不可数,记为阿列夫一。

其中可数的意思是,对于自然数集合,我们可以按照顺序依次列出它们,并在无穷的迭代中穷尽它们,这是数学归纳法可信的基础。但对于实数集合,我们做不到这一点,所以实数集合是不可数的。

现代计算机都基于图灵机概念,而图灵机只能处理可计算数,不能处理不可计算数。可计算数和不可计算数构成了所有实数,而其对应数量亦分别等于阿列夫零和阿列夫一。阿列夫零相对于阿列夫一的大小,是无穷小。所以,可计算数与不可计算数的数量相比,是无穷小。基于这个对比,不难体会到图灵计算机的局限性。

这些不可计算数,可能对应于一些非线性的混沌现象

,“有些混沌现象用图灵计算机是无法真正模拟出来的。而这可能正是涌现等智能现象的基础。”黄铁军强调。

另外,

人脑神经元在做信号处理的时候,也不是简单的有和无两个状态,而是存在非线性的变换过程

。“所以,以晶体管为基础的,或以开关电路理论为基础的图灵计算系统所构建的机器智能,和人类的智能系统之间,是有绝对边界的。”

而在超越图灵可计算性的机器上实现的机器学习,或许也能带来完全不同的智能表现。

毕竟,图灵机原本就源于人类智能的抽象,要突破这个抽象,我们还要更加深入挖掘人脑工作的基本原理。

归根结底,

两位学者的观点并不存在绝对的冲突,只是关注的层面不同

。智能的定义,无论在机器还是人类的层面,在当前的技术发展阶段,则依然是个尚未解决的哲学问题。

![]()