有哪些省内存的大语言模型训练/微调/推理方法?

大模型(LLMs)现在是 NLP 领域的最主流方法之一了。

这个趋势带来的主要问题之一,就是大模型的训练/微调/推理需要的内存也越来越多。

举例来说,即使 RTX 3090 有着 24GB 的 RAM,是除了 A100 之外显存最大的显卡。但使用一块 RTX 3090 依然无法 fp32 精度训练最小号的 LLaMA-6B。

本文总结一些 Memory-Efficient 的 LLMs 的训练/微调/推理方法,包括:

● fp16

● int8

● LoRA

● Gradient checkpointing

● Torch FSDP

● CPU offloading

估算模型所需的RAM

首先,我们需要了解如何根据参数量估计模型大致所需的 RAM,这在实践中有很重要的参考意义。我们需要通过估算设置 batch_size,设置模型精度,选择微调方法和参数分布方法等。

接下来,我们用 LLaMA-6B 模型为例估算其大致需要的内存。

首先考虑精度对所需内存的影响:

其次,考虑模型需要的 RAM 大致分三个部分:

模型参数:等于参数量*每个参数所需内存。

对于 fp32,LLaMA-6B 需要 6B*4 bytes = 24GB内存

对于 int8,LLaMA-6B 需要 6B*1 byte = 6GB

梯度:同上,等于参数量*每个梯度参数所需内存。

优化器参数:不同的优化器所储存的参数量不同。

对于常用的 AdamW 来说,需要储存两倍的模型参数(用来储存一阶和二阶momentum)。

fp32 的 LLaMA-6B,AdamW 需要 6B*8 bytes = 48 GB

int8 的 LLaMA-6B,AdamW 需要 6B*2 bytes = 12 GB

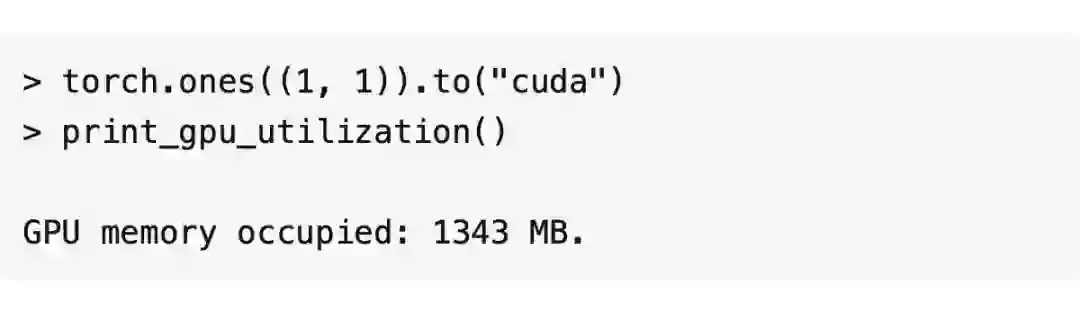

除此之外,CUDA kernel 也会占据一些 RAM,大概 1.3GB 左右,查看方式如下。

综上,int8 精度的 LLaMA-6B 模型部分大致需要 6GB+6GB+12GB+1.3GB = 25.3GB 左右。

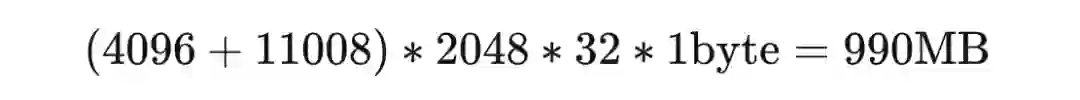

再根据LLaMA的架构(hidden_size = 4096, intermediate_size =11008, num_hidden_layers = 32, context_length = 2048)计算中间变量内存。

每个 instance 需要:

所以一张 A100(80GB RAM)大概可以在 int8 精度;batch_size = 50 的设定下进行全参数训练。

查看消费级显卡的内存和算力:

2023 GPU Benchmark and Graphics Card Comparison Chart

Fp16-mixed precision

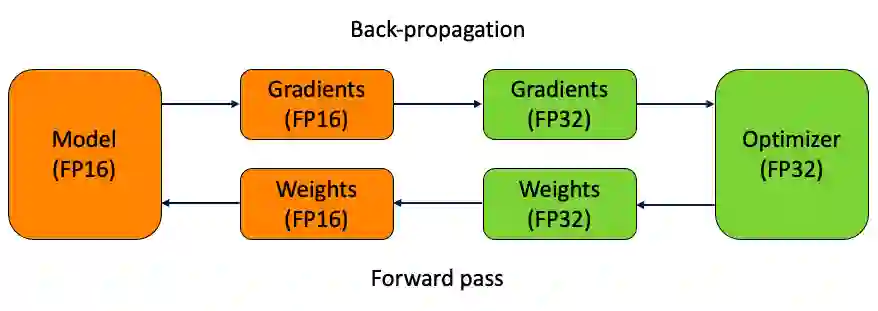

混合精度训练的大致思路是在 forward pass 和 gradient computation 的时候使用 fp16 来加速,但是在更新参数时使用 fp32。

用 torch 实现:

CUDA Automatic Mixed Precision examples

torch fp16 推理:直接使用 model.half() 将模型转换为fp16.

使用 Huggingface Transformers:在 TrainingArguments 里声明 fp16=True

https://huggingface.co/docs/transformers/perf_train_gpu_one#fp16-training

Int8-bitsandbytes

Int8 是个很极端的数据类型,它最多只能表示 - 128~127 的数字,并且完全没有精度。

为了在训练和 inference 中使用这个数据类型,bitsandbytes 使用了两个方法最大程度地降低了其带来的误差:

1. vector-wise quantization

2. mixed precision decompasition

Huggingface 在这篇文章中用动图解释了 quantization 的实现:

论文:

借助 Huggingface PEFT,使用 int8 训练 opt-6.5B 的完整流程:

https://github.com/huggingface/peft/blob/main/examples/int8_training/Finetune_opt_bnb_peft.ipynb

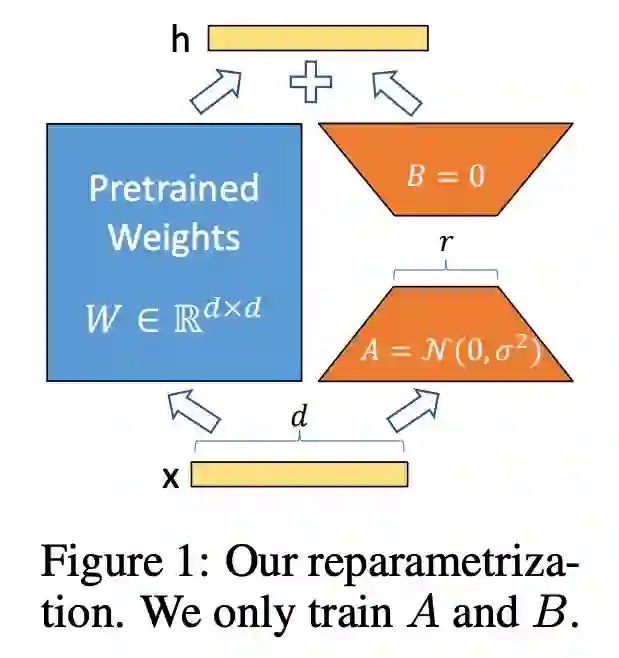

LoRA

Low-Rank Adaptation 是微调 LLMs 最常用的省内存方法之一。

Explore Gradient-Checkpointing in PyTorch

Torch FSDP+CPU offload

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧