推特2200赞:一只AI训练排出180吨二氧化碳,“您的机器学习一点也不环保!”

碳栗子 发自 凹非寺

量子位 报道 | 公众号 QbitAI

当你打开这篇文章的时候,你的模型可能正在安静地训练。

模型的身后,有飞速运转的GPU,为它提供训练的动力。

曲线显示,它的学习情况良好,你在一旁露出了“孺子可教”的围笑。

就在此时,有人向你发射了直击灵魂的提问:

你总是关心模型学得好不好,就不关心它学得累不累排放多少二氧化碳?

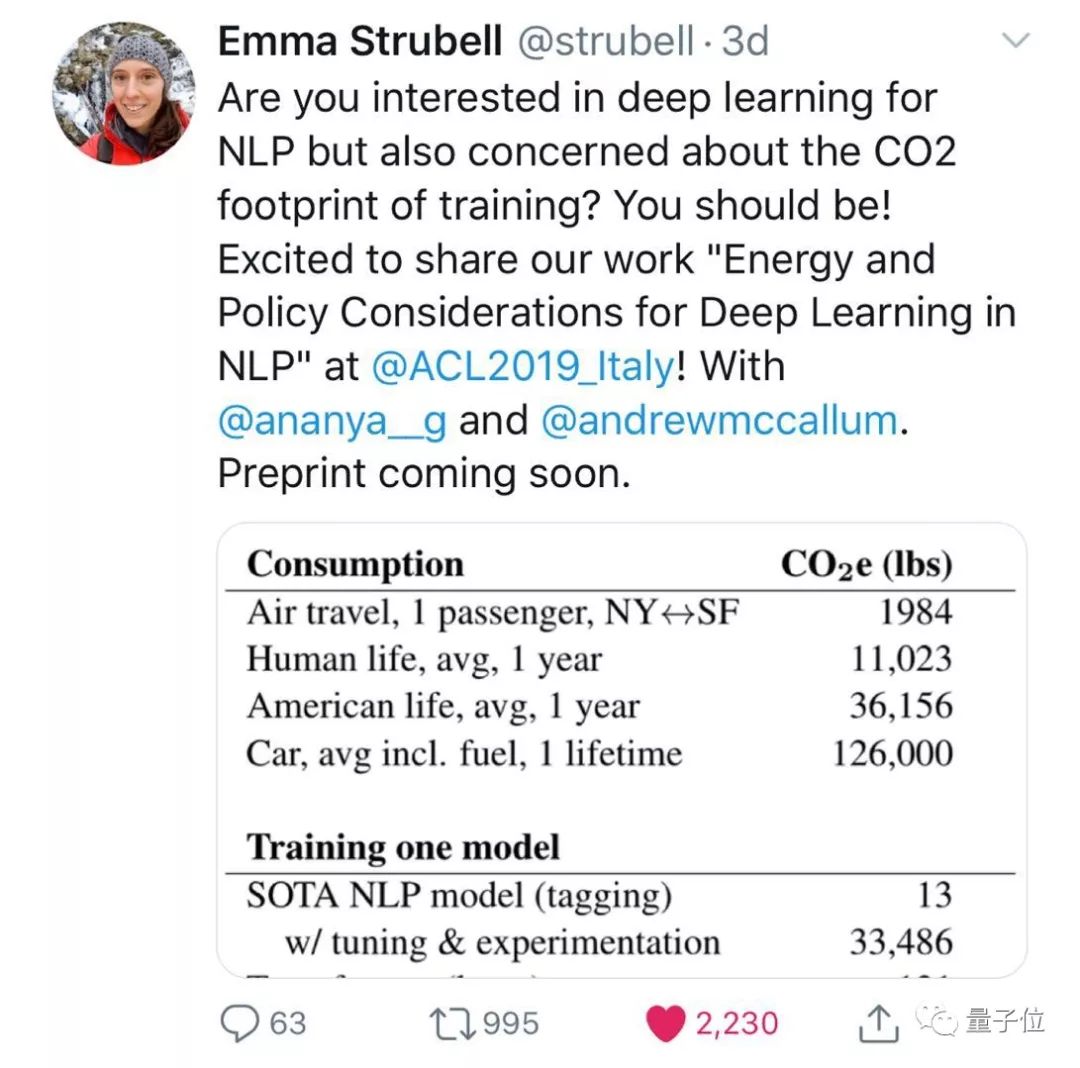

发问的是名叫Emma Strubell (简称艾玛) 的研究人员,来自美国马萨诸塞大学阿姆赫斯特分校。

艾玛和小伙伴一起,研究了许多优秀NLP (自然语言处理) 模型的碳排,还和人类日常生活的碳足迹做了对比:

比如,训练一只Transformer的碳排,相当于从坐飞机在旧金山和纽约之间往返200次。

过不了多久,团队就会前往ACL 2019,与NLP领域的佼佼者们,分享自家的成果。

而在那之前,这项酸爽的研究,已经在推特上引发了大规模围观,有2200人点赞,也惹来了不小的争议。

能排多少吨?

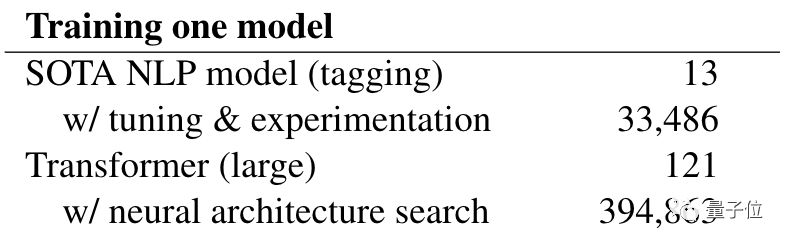

如果看艾玛提供的数据,训练好一只NLP领域的State-of-the-Art,包括调参包括实验,大概需要排放3.3万磅二氧化碳,相当于15吨:

而要训练一只Transformer,包含神经网络架构搜索 (NAS) 的那种,排放二氧化碳大概39.5万磅,相当于180吨。

比刚才的SOTA多了10倍不止。

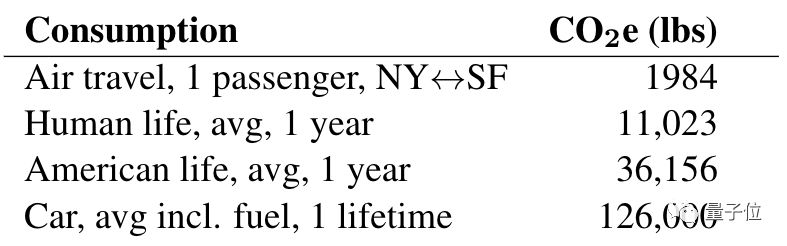

那么,这些吨位到底是什么概念?

如果还看艾玛提供的数据:

训练一只Transformer的碳排放量,相当于把三辆汽车从全新用到报废;

如果换算成,一个人从纽约坐飞机去旧金山,再从旧金山回纽约,可以往返200次。

一个 (平均) 美国人10年日常生活的碳排,不过如此。

一个 (平均) 地球人30年日常生活的碳排,也不过如此。

现在,完整论文还没放出,艾玛说快了快了。

即便如此,惊人的数据也已在众人瞩目之下,收获了许多质疑:

“你这碳排怎么算的?”

谷歌大脑的研究员David Ha,就提出了问题:

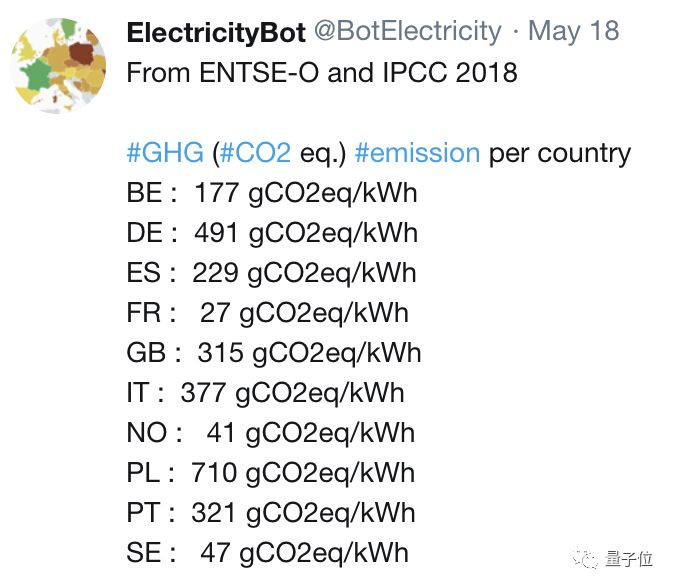

用千瓦时作指标才比较科学吧。因为不同的能源,每千瓦时的碳排会差出很多啊。看数据:

△ 不同国家的数据:每千瓦时,从41克到710克不等

他觉得,如果不知道能源是什么,就计算二氧化碳排放量,作为一篇论文并不严谨;

但如果是为了让大家重视环境问题,用碳排来博眼球,那就说得通了。

评论区,有同样感受的人类不在少数:

看来保护地球,也需要有一颗严谨的心。

One More Thing

当然,观众大多还是对这项研究表示喜闻乐见,有人说:

以后交论文的时候,应该要求把碳排信息附上。

阁下以为如何?

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

小程序|get更多AI学习干货

加入社群

量子位AI社群开始招募啦,社群矩阵:AI讨论群、AI+行业群、AI技术群;

目前已有4万AI行业从业者、爱好者加入,AI技术群更有来自海内外各大高校实验室大牛、各明星AI公司工程师等。互相ta

欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“微信群”,获取入群方式。(技术群与AI+行业群需经过审核,审核较严,敬请谅解)

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「在看」吧 !