联邦学习如何处理异质性?港科大最新《异质联邦学习》综述,46页pdf全面阐述异质联邦学习的数据空间、统计、系统和模型异质性

联邦学习(Federal learning, FL)可以在不破坏隐私和安全的情况下,通过组织间的协作训练模型来保护数据隐私,并虚拟地组装孤立的数据筒仓。然而,FL面临着数据空间、统计、系统异构等多方面的异质性。例如,没有利益冲突的协作组织通常来自不同的领域,并具有来自不同特征空间的异构数据。由于非IID和不均衡的数据分布以及各种资源受限的设备,参与者也可能希望训练异构的个性化本地模型。因此,我们提出异构FL来解决FL中的异质性问题。在本次综述中,我们从数据空间、统计、系统和模型异质性方面全面研究了异构FL的领域。本文首先对FL进行了概述,包括它的定义和分类。然后,根据问题设置和学习目标,对每种异构类型的FL学习设置进行精确的分类。我们还研究了处理FL异质性的迁移学习方法。我们进一步介绍了异质FL的应用。最后,我们强调了挑战和机遇,并展望了未来有前途的研究方向,即新的框架设计和可靠的方法。

https://www.zhuanzhi.ai/paper/bbf6f98f9e18e0c9d04f177d0c2fc7a7

概述

在过去的十年里,由于大数据的激增,机器学习(ML)取得了巨大的成功,并被广泛应用到许多领域。尽管ML取得了巨大的成功,但大规模数据集的缺乏严重限制了ML的广泛应用。此外,数据收集和标记可能非常昂贵,因此单个组织不可能收集足够的数据。在其他情况下,尽管公司可能已经有足够的关于录音数量的数据。他们可能希望通过合并分布在其他机构之间的辅助特征来丰富数据的特征空间。然而,在机构之间共享数据或聚合来自用户设备的数据会导致隐私泄露的风险。近年来,由于侵犯隐私行为的不断发生,对数据隐私保护的担忧日益凸显。因此,GDPR[1]和CCPA[2]等信息隐私政策和法律规定了公司之间的数据共享,以保护个人数据不被滥用。此外,数据对公司也有巨大的商业价值。出于隐私、安全和业务考虑,传输数据是不可行的。因此,有效地利用分布在多个机构中的数据进行ML是一项挑战。

联邦学习(FL)基于分布在客户机之间的数据[3],[4]来训练机器学习模型。在FL中,交换和聚合中间结果,如梯度,以更新模型无需原始数据传输。人们从隐私保护、鲁棒性、效率、安全性、可扩展性和性能[5]、[6]、[4]、[7]、[8]等各个方面致力于设计联邦学习算法。

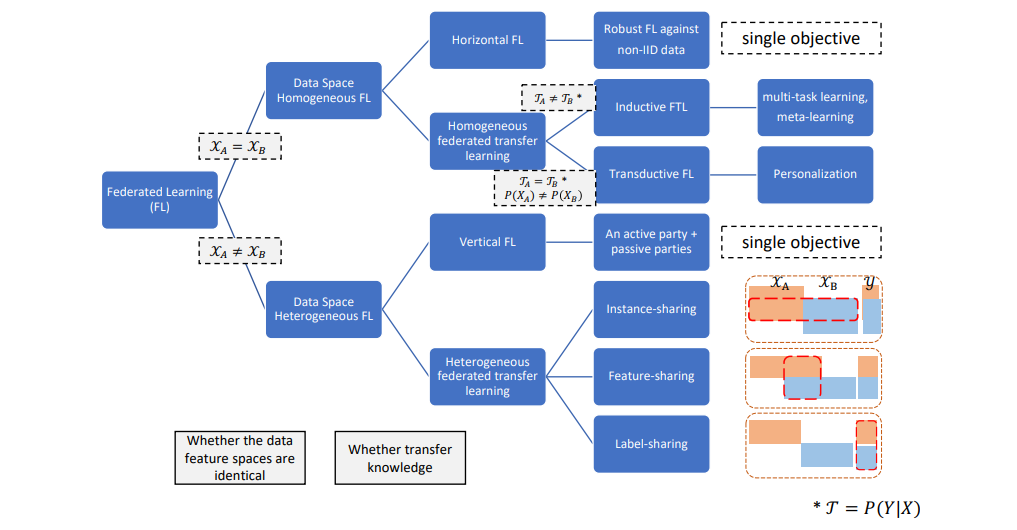

然而,FL面临着异质性的问题。FL的异质性来自多方面,包括数据分布不平衡、特征空间异质性、网络连接不稳定和设备资源有限。我们将FL中的异质性分为三种类型:数据空间异质性、统计异质性和系统异质性。近年来,所有类型的异质性都吸引了大量的研究兴趣。为了解决如上所述的异构性,各种利用模型异构性的方法也被广泛探索,因为异构模型可以帮助根据各方的特征空间和设备资源训练定制的模型架构。一些调查集中在统计异构FL[9],[10]和系统异构FL[11],[12]。部分工作对FL[13]的系统设计进行了研究,但对FL的上述异质性还缺乏全面的考察。

为了解决统计异质性问题,一些工作针对不同参与者[14],[15],[16],[7]中的非iid和不平衡分布训练了一个鲁棒的全局模型。另一种方法是通过将FL定义为多任务学习问题[17],[18],[19],为各方训练个性化的局部模型。类似地,为了解决系统异构问题,一些方法提出通过客户端选择[20]、[21]、[11]、异步聚合[22]、[23]和模型压缩[24]、[25]来有效地构建单个全局模型。当不同的资源约束设备想要部署一个个性化的本地模型时,可以通过模型拆分和聚类训练[26]、[27]、[28]来训练异构的本地模型。虽然大多数研究关注统计和系统异质性,但不同参与者的数据空间也可能不同。在许多现实世界的应用程序中,合作参与者是来自不同行业的组织(例如,银行或医院),没有利益冲突。因此,每个参与者的采集数据都来自异构特征空间。例如,在广告场景中,广告商持有用户的浏览历史和点击记录,而企业持有购买历史。为了利用来自两个特征空间的数据,双方必须进行数据空间异构FL,在联合特征空间上建立模型。数据空间的这种异质性给FL带来了多方面的新挑战。

根据数据空间分布的不同,数据空间异构迁移学习可分为垂直联邦学习(VFL)和异质联邦迁移学习(Hetero-FTL)。当数据按特征划分时,VFL的目标是在对齐的实例上训练模型。然而,在许多情况下,参与者可能共享有限的或没有对齐的实例和一些公共特性。特征空间或实例空间上的这种重叠提供了在各方之间转移知识的机会。提出了联邦迁移学习,利用迁移学习在参与者[29]之间进行知识共享。根据参与者之间共享的数据空间,将Hetero-FTL分为特征共享、实例共享和标签共享3种情况。与VFL相比,Hetero-FTL放宽了对实例对齐的要求,提高了模型的可用性。数据空间异构FL,特别是Hetero-FTL仍未得到充分探索,是一个有前途的研究方向,吸引了越来越多的研究兴趣。

我们研究了处理FL中不同类型异构的方法。主要有五种方法来处理异构:知识蒸馏、数据增强、参数共享、领域自适应和矩阵分解。对于每种方法,我们将讨论和回顾如何使用它们来处理每种类型的异构。我们还研究了异质FL在不同领域的应用,看到它正在积极促进工业应用。此外,我们总结了异构FL算法设计中面临的主要挑战和未来的发展方向。总的来说,我们的贡献有三个方面:

1) 首先对已有的关于数据空间、统计、系统和模型异质性的研究进行了综述。我们提出了基于问题设置和学习方法的每种异质类型的分类法。

2) 我们确定了五种迁移学习策略,以解决FL中的数据空间、统计和系统异质性,并从基于数据、基于架构和基于模型的角度回顾了文献。

3) 我们展望了未来有前途的研究方向,即新的框架设计和构建异质FL系统的可靠方法

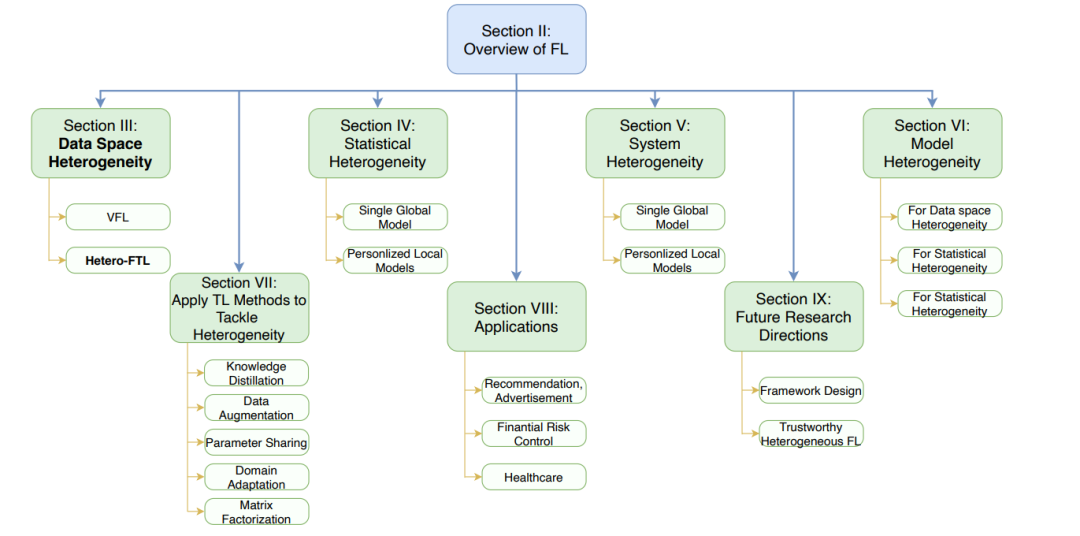

组织。综述的其余部分组织如图1所示。第二节概述了FL,介绍了FL的异质性、权衡和分类。第三节提出了数据空间异构FL的概念,并根据异构FL的数据分布提供了分类方法。第四节介绍了统计异质性。第五节讨论了系统异质性。第六节介绍了如何在FL中训练异质模型,以及模型异质如何帮助处理数据空间、统计和系统异构。第七节讨论了如何使用不同的迁移学习方法来应对FL中不同类型的异质性。第八节介绍了异质性FL的应用。第九节讨论了异质性FL的挑战。最后,第十节得出结论。表一列出了论文中使用的主要缩写词。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“HFLS” 就可以获取《联邦学习如何处理异质性?港科大最新《异质联邦学习》综述,46页pdf全面阐述异质联邦学习的数据空间、统计、系统和模型异质性》专知下载链接