「人工智能系统可信性度量评估研究」最新2022综述

人工智能系统可信性度量评估研究最新综述论文

近年来,人工智能技术突飞猛进,人工智能系统已经渗透到人们生活中,成为人们生活中不可或缺的一部分. 然而,人工智能系统需要数据训练模型,数据扰动会对其结果造成影响.并且随着人工智能系统业务多样化,规模复杂化,人工智能系统的可信性愈发受到人们的关注. 首先,在梳理不同组织和学者提出的人工智能系统可信属性基础上,提出了人工智能系统的九个可信属性; 接着, 从数据可信性、模型可信性和结果可信性分别介绍现有的人工智能系统数据、模型、结果可信性度量方法,设计了人工智能系统可信证据收集方法.其次, 总结当前人工智能系统的可信度量评估理论与方法.然后, 结合基于属性的软件可信评估方法与区块链技术, 建立了一个人工智能系统可信度量评估框架,包括可信属性分解及可信证据获取方法、联邦式可信度量模型与以及基于区块链的人工智能系统可信度量评估架构。最后,讨论人工智能系统可信度量技术面临的机遇和挑战.

http://www.jos.org.cn/jos/article/abstract/6592

引言

人工智能自 1956 年诞生以来,经历了从繁荣到衰退再到繁荣的螺旋式发展过程,出现了三次发展高潮[1]。第三次高潮起源于辛顿(Hinton)在 2006 年提出的深度学习概念[2],2016 年围棋机器人 AlphaGo[3]以该模型为 核心的算法战胜了人类顶级棋手引发广泛关注,极大地推动了人工智能的研究与应用高潮。近年来,欧美日 等国持续加大对人工智能基础理论和应用的重点投入,以保持其在人工智能技术方面的领先地位。我国政府 在 2017 年发布了《新一代人工智能发展规划》,将人工智能正式列入国家发展战略[4],学术界和产业界也掀 起了人工智能研发热潮,李国杰院士和陆汝钤院士等多位人工智能科学家在多个场合呼吁重视人工智能的发 展态势[5],华为、百度、腾讯、科大讯飞等人工智能领域企业也在不断增强其人工智能方面的研发力量,人工智能在图像识别、数据挖掘、自然语言处理、推荐算法、信息检索、语言识别和自动驾驶等领域均得到了 不同程度的应用。

然而,随着人工智能不断融入我们的日常生活,人工智能系统的表现还不尽如人意。例如,近年来,许 多学者发现,在图像识别领域,人工智能模型对训练数据非常敏感,当训练数据受到扰动时可能输出不恰当 的结果,这种对抗性扰动已经成为人工智能模型,尤其是神经网络模型的梦魇:对抗攻击[6][7][8]。而且,在自动驾驶领域也有研究发现,除了人为的对抗攻击,极端光照条件也会影响视觉系统识别,从而影响自动驾驶 [9]。另一方面,如果训练数据被偏见性地标注,相应机器学习模型的输出结果往往也会具有一定偏见性[10]。复旦大学管理学院企业管理系孙金云教授研究团队 2021 年发表的“2020 打车软件出行状态调研报告”表明, 打车软件通过“差异化的偏差信息”提高了平台自身的收益[11]。这些数据一旦被滥用于机器学习算法,不仅 可能导致偏见性的结果,还可能导致隐私泄露问题的出现。这类事件频繁出现,越来越多的专家和学者开始 关注人工智能系统的可信性[1][5][12]。系统的“可信性”是基于传统的“安全”“可靠”等概念产生的,简单来 说是指一个系统在实现给定目标时,其行为及其结果符合人们的期望[13]。刘克等人认为软件系统“可信性” 是人类心中对客观对象各属性较为整体的反映[14]。

在政府机构和有关学者的引导下,学术界和产业界都愈发关注人工智能系统可信性[15],构造可信人工智 能已经成为现代人工智能发展和应用的重要趋势和必然选择。然而,构造可信人工智能需要人们对人工智能 系统的可信性有着清晰的认知,因而如何综合评估判断人工智能系统的可信性已经成为可信人工智能研究中 的一个重要问题。因为人工智能系统可信性由其多维属性反映,并且人工智能系统的可信性问题需要从其训 练数据可信性、学习模型可信性和预测结果可信性三个方面来考虑,所以对人工智能系统可信性的综合评估 较为困难。本文从人工智能的可信属性入手,总结梳理人工智能应有的可信属性;接着讨论了数据、模型和 结果可信性的度量方法,为度量人工智能系统可信性提供证据基础。在此基础上,本文讨论了现有的人工智 能可信度量模型。然后,本文提出了一个基于可信属性的人工智能系统可信度量框架,期待推动人工智能可 信度量的研究与发展。本文将从以下几个方面讨论人工智能系统可信评估的研究现状和面临的挑战:

(1) 人工智能系统的可信属性

可信性是人类心中对客观对象各属性较为整体的反映,传统软件的可信属性通常包含可靠性、安全 性、可用性、正确性等诸多属性[14],人工智能系统作为软件系统的一种,其可信属性包括部分传统 软件的可信属性。但是,人工智能系统本身的特性又导致其具有普通软件所不具有的其他属性,例 如描述对抗数据干扰能力的鲁棒性,没有偏见的公平性等。因此,如何准确描述这些属性对人工智 能系统的可信评估有着重要作用。

(2) 人工智能系统数据、模型和结果可信性与人工智能系统度量模型

人工智能系统的可信性依赖于大量可靠的数据支撑、恰当的模型选择和符合预期输出结果,即其可 信性依赖于其训练数据可信性、学习模型可信性和预测结果可信性。数据可信性是训练出可信模型 的基础,模型可信性又是得到符合人们心理预期结果的基础,三者相辅相成,相互依赖,共同影响 着人工智能系统的可信性。为了实现对人工智能系统可信性的度量,需要从数据、模型和结果三方 面的度量结果收集可信证据。此外,现有对人工智能系统度量的工作也为人工智能系统可信性度量 模型建立打下了坚实的基础。

(3) 基于可信属性的的人工智能系统可信度量评估体系

传统软件可信评估理论经过数十年的发展,已经被证明在传统软硬件系统开发中是确保系统可信必 不可少的技术。例如列车控制系统和航空飞行系统开发国际标准中均要求将该方法贯穿于整个系统 的开发周期以获得较高的可信等级认证[16]。尤其是基于可信属性的软件可信度量评估,现在已经有 了较为成熟的研究成果,并被用于各种安全攸关软件的可信性度量中[17]。然而,由于目前人工智能 系统本身特有的性质,使得不能直接将软件可信评估理论简单地移植到人工智能系统,而是要针对 人工智能系统本身的可信性进一步研究可信度量评估理论与技术。本文结合人工智能系统可信性现 状和软件可信评估理论提出了一个人工智能系统可信度量评估框架,具体包括可信属性分解及可信 证据获取方法、联邦式可信度量模型与基于区块链的人工智能系统可信度量评估架构。该框架还将 保障数据可信性常用的区块链技术融入可信度量全过程,从而可以保障整个度量过程的不可篡改性。

1 研究现状和动机

1.1 人工智能现状

1950 年,计算机科学之父图灵在论文《计算机器与智能》中描述了智能的概念,并提出机器智能的测试 方法,即“图灵测试”[18]。随后在 1956 年的达特茅斯会议上,美国 10 位学者正式提出了人工智能概念,达 特茅斯会议也成为第一次人工智能研讨会,1956 年被称为“人工智能元年”[19]。人工智能的发展自其诞生以 来经历了三次高潮。2006 年辛顿提出的深度学习算法的概念[2],不仅掀起了深度学习研究与应用的热潮,而 且促进了人工智能第三次高潮的兴起。人工智能发展的潮起潮落引领着人工智能不断健康地发展,也使得人 工智能技术健康地服务人类。现在,人工智能技术在各个领域已经取得了丰硕的研究成果,图像识别[20]、自 然语言处理[21]、计算机视觉[22]、自动驾驶[23]、推荐系统[24]等技术中处处可见其身影。

1.2 可信人工智能发展战略规划

如何保障人工智能的健康发展已经成为当前社会和国家关注的主要问题之一,许多政府和学者都倡导科 学发展人工智能。2016 年 9 月,英国下议院提出应对机器人发展带来的伦理、法律和道德问题[25]。2018 年 3 月,欧洲政治战略中心提出要解决人工智能在发展过程中出现的偏见问题,研究人工智能的道德准则[26]。2018 年 4 月,欧盟确立人工智能的伦理和法律框架[27]。2018 年 12 月,欧盟委员会的人工智能高级专家组 (High-LevelExpertGrouponArtificialIntelligence,AIHLEG)发布了《可信人工智能伦理指南草案》,该指南提出了 一个可信人工智能框架,总计 10 项可信人工智能要求和 12 项实现人工智能的技术和非技术方法[28]。

2016 年 10 月,美国国家科学技术委员会(NSTC)探讨了人工智能潜在的公共问题[29][30]。2017 年年初, 美国国家科学基金会、国防部高级研究项目局(DARPA)启动可解释人工智能计划,发展可解释、可信的人 工智能技术[31]。2018 年 4 月,美国国防部发表《国防部人工智能战略》,旨在促进美国人工智能安全[32]。2018 年 9 月 DARPA 启动了 20 亿美元的 AINext 战略,明确发展第三代人工智能基础理论和技术,重点内容包括 鲁棒、对抗、高效知识推理,以及更强能力的人工智能理论和技术[33]。

2018 年 6 月,新加坡成立人工智能伦理委员会,以帮助政府制定伦理标准[34]。同一时间,印度政府发布 《人工智能国家战略》,其中重点涉及了道德隐私方面的问题[35]。我国政府从 2015 年开始就大力推进人工智 能技术发展[36],2016 年发展人工智能技术被列入“十三五”发展规划[37]。2017 年国务院和工信部提出新一 代人工智能发展规划[4][38],强调人工智能健康发展,2018 年国家标准化管理委员会发布的人工智能标准化白 皮书中提到关注人工智能的安全、伦理和隐私问题[39]。

1.3 软件可信性研究现状

1.3.1 软件可信性概念

随着科技的不断发展,计算机在人类社会的普及程度越来越高,无论是经济、军事还是社会生活中的方方面面,人们都越来越离不开软件,对软件的功能需求也在不断增加。随着软件系统日益复杂化,开发规模 不断扩大,或多或少都存在的软件缺陷使得人们越来越难以控制软件质量。各种各样的软件事故不断给用户 带来严重的损失,软件经常不按人们期望的方式工作[17][40],使得人们逐渐失去对软件的信任,可信性的概念 应运而生[14]。

“可信性”是在软件传统的“可靠”“安全”等概念的基础上发展而来的。1972 年,Anderson 提出可信 系统的概念[41],这是人们对计算机系统可信性的首次探索。但是此时人们大多关注硬件的可信性,直到美国 国防部制定可信计算机标准时才提到软件可信性的概念[42]。Laprie 指出可信性与可靠性是两个不同的概念, 前者比后者要复杂的多[43]。美国科学与技术委员会 NSTC 则认为即使在系统在危险情况下,即系统本身存在 错误,环境存在危险或者系统遭到其他人的致命攻击,设计者、实现者和使用者都能保障系统的大部分功能, 使其不会失效,则该系统是高可信的[44]。美国国家研究委员会 NRC 认为一个系统即使在运行环境出现问题、 操作人员失误操作、系统受到外界的致命攻击或者系统的设计和实现存在 Bug 的情况下,也能够按照原来设 定的预期运行,得到预期的结果,那么该系统是可信的[45]。德国奥尔登堡研究生院的研究发现可信性应该包 括正确性、安全性、服务质量、保密性和隐私性[46]。在我国国家自然科学基金委“可信软件基础研究”重大 研究计划中,何积丰等人[14]认为可信性是人类心中对客观对象各属性较为整体的反映,提出了可信软件 (TrustworthySoftware)是指软件系统的动态行为及其结果总是符合人们预期,并在受到干扰时不会失效, 并能提供连续服务的软件,这里的“干扰”包括操作错误、环境影响和外部攻击等。陈火旺院士则认为高可 信性质包括可靠性、防危性、安全性、可生存性、容错性和实时性[47]。

1.3.2 软件可信性发展计划

软件可信性保证对整个软件产业,特别对安全攸关软件研发的影响日益加深。各国政府、研究机构以及 各大公司都对软件可信性研究提出了相应的研究计划。美国自然科学基金会从 2005 年开始便在可信计算研究 领域投入约数亿美元[48],政府的“网络与信息技术研究发展计划”中重点强调“可信软件”相关领域[49];欧 洲于 2006 年 1 月启动了名为“开放式可信计算”(OpenTrustedComputing)的研究计划,旨在开发开源可信计 算软件,已有 23 个研究机构参加[50];欧盟于 1997 年 12 月通过的“第五框架计划”[51]和 2002 年 11 月通过 的“第六框架计划”[52]都把高可信软件作为软件技术发展的重点。构造可信软件已成为现代软件技术发展和 应用的重要趋势和必然选择。我国国家中长期科学和技术发展规划纲要(2006-2020 年)中将可信计算机的研究 作为发展重点[53];2007 年,“863”计划开展“高可信软件生产工具及集成环境”重点项目[54];国家自然科 学基金委于 2007 年提出开展“可信软件基础研究”重大研究计划[14],并将“软件的可信性度量与评估”列 为四个重要核心问题之首。

1.3.3 软件可信性度量评估

软件可信度量评估有助于软件可信性保障,因而其研究成果具有重大意义。国内外一系列学者专家专注 于此,并取得了丰硕的研究成果。Marascas 等使用问卷调查的方法,结合多元统计分析方法,将人的主观评 价和软件的客观度量结果相结合,形成综合的度量结果[55][56][57]。美国国家标准与技术研究院 NIST 提出一种 自上而下的软件可信性评估框架,使用形式化方法来确定软件可信值[58]。Alexopoulos 等将贝叶斯概率和 DS 证据理论结合,使用模块化的思想,量化相关风险并对软件组件可信性进行度量[59]。CHO 等提出了一个系统 级别的可信度度量框架,从可信属性的角度度量软件可信性,该框架包含安全性、信任、弹性和敏捷性度量 标准,称为 STRAM 框架[60]。

国内的许多科研团队同样在软件可信度量领域取得了丰硕的研究成果。杨善林院士团队采用专家打分的 效用值结合 DS 证据理论来计算软件可信性[61][62]。郑志明和李未院士团队使用动力学分析,研究软件在动态 开放环境下的行为统计学特征,建立软件关于可信属性的缩小化最优统计分析方法[63][64][65]。王怀民院士团队 对可信软件的概念做了进一步规范,也从可信属性的角度建立软件可信属性模型和软件可信等级,给出一种 基于验证的可信证据模型[66]。王青教授团队建立了支持软件过程可信评估的可信证据,从开发过程数据来评 估软件可信性[67]。陈仪香教授团队同样面向多维属性,基于公理化的方法建立面向软件多维属性的软件可信度量模型,并提出软件可信性分配模型与增强规范[17][68][69]。他们还从软件源代码角度,建立基于 Extensive 结构的软件可信性度量模型[70]。

1.4 人工智能系统可信度量动机研究

在人工智能技术发展初期,其应用主要是专家系统、定理证明、问题求解等领域[71],这些领域任务相对 较为简单,初期人工智能技术足以应付这些问题。随着人工智能技术发展,人们对人工智能系统和智能软件 的需求不仅仅停留在这些简单问题上,图像识别、语音识别、无人驾驶、推荐系统等越来越多的领域开始应 用人工智能技术,由此人工智能走向了第三次发展高潮。

然而,和软件发展一样,人工智能系统愈发复杂化的同时,其可信性越来越受到人们的关注。2015 年 8 月,印度一名配件公司员工由于离焊接金属板机器人太近而被机器人杀死[72]。2016 年 8 月,浙江大学徐文渊 教授带领的团队在 Defon 黑客大会上对特斯拉自动驾驶技术进行攻击,导致其自动驾驶失效[73]。2018 年 3 月 Uber 自动驾驶汽车在行驶过程中没有识别路上行人,撞倒了该行人并导致其死亡[74]。人工智能系统不仅 面临着传统软件所存在的可信问题,而且存在人工智能特有的问题。文献[75]发现医疗诊断工具对黑人患者分 配较少的医疗资源,并且对许多白人患者,该医疗诊断工具拒绝使用黑人患者已使用过的治疗设备。同样, 2018 年 5 月,亚马逊公司智能音箱出现故障,错误地把俄勒冈州一名女士和其丈夫的对话发到了他人邮箱[76]。这类事件使得人们对人工智能系统的可信性愈发关注,各个国家也在人工智能发展战略中提到发展可信人工 智能。

人工智能系统可信度量可以帮助人工智能系统的开发者和使用者了解人工智能的可信程度,使他们对人 工智能系统的可信程度有一个明确的认知。开发者可以通过可信度量得出的结果进一步改进开发的系统,使 得该系统可以保证用户安全的同时,让用户有更好的智能体验。用户也可以根据可信度量的结果对自己使用 的智能系统的可信程度有所了解,在使用过程中可以放心享受智能带来的快乐和方便。因而,对人工智能系 统进行可信度量是人工智能系统健康发展的必然选择。

2 人工智能可信属性

目前,越来越多的组织和学者关注人工智能系统的可信性,他们意识到,人工智能系统可信性不同于传 统软件的可信性,它的可信属性除了包含传统软件所需要的可信属性外,还应包含许多人工智能本身特性而 产生的相关性质。例如,人工智能模型的黑盒特性需要关注人工智能的可解释性与透明性。

欧盟委员会人工智能高级专家组提出可信人工智能伦理指南草案[28],为可信人工智能提出了可追责性、 数据治理、普惠性、人工智能自主性的管控、非歧视、尊重和强化人类自治、隐私保护、鲁棒性、安全性、 透明性共 10 个基本要求,这些要求给人工智能提出了可追责性、普惠性、自主性、公平性、隐私性、鲁棒性、 安全性、透明性共八个可信属性。美国和 OECD 组织认为,可信人工智能需要拥有包容性增长、可持续发展 和福祉、以人为本的价值观与公平、透明度和可解释性、鲁棒性以及安全性和防危性[77],这些要求对应了可 持续发展、价值观、公平性、透明性、可解释性、鲁棒性、安全性、防危性八个可信属性。美国国家标准与 技术研究所 NIST 对人工智能提出其需要拥有互操作性、安全性、可靠性、鲁棒性、公平性和可解释性共六 个可信属性的要求[78]。IBM 公司则认为,人工智能系统应拥有公平性、鲁棒性、透明度和问责制、价值观、 可解释性、隐私[79]。这意味着他们认为,人工智能系统的可信性应具有公平性、鲁棒性、透明性、可追责性、 价值观、可解释性、隐私性七个可信属性。

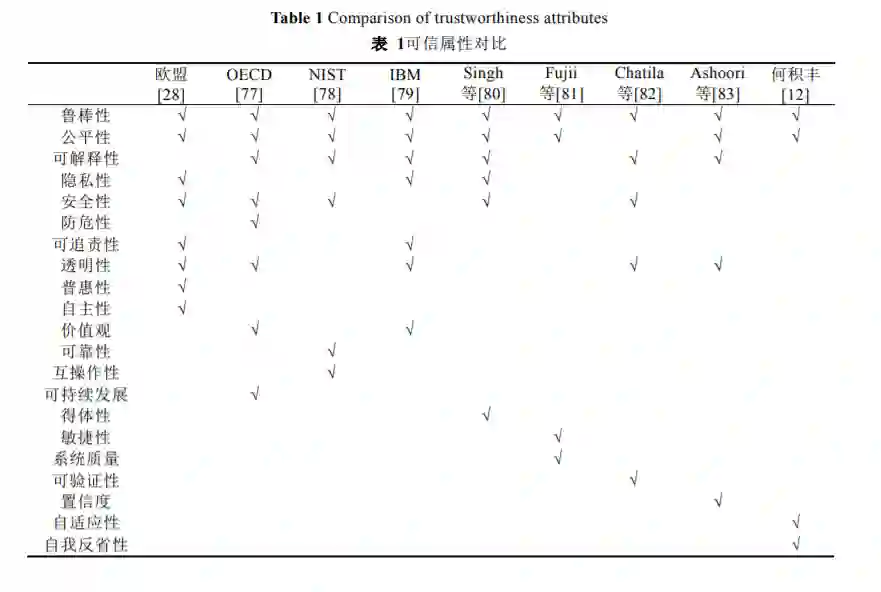

许多学者也对人工智能应用有的可信属性提出了自己的见解。Singh 等认为可信人工智能不应具有偏见, 应保证公平性,模型具有可解释性与透明度、应对对抗性攻击的鲁棒性,系统本身还要做到隐私保护,保证 安全性的同时也要具有得体性[80]。Singh 等对人工智能提出了公平性、可解释性、鲁棒性、隐私性、安全性、 得体性六个可信属性。Fujii 等则认为人工智能系统要保证数据的完整性、模型的鲁棒性、系统的高质量、过 程的敏捷性以及满足客户的期望[81],他们更加强调完整性、鲁棒性、系统质量以及敏捷性。而对于 Chatila 等而言,他们关注的是人工智能系统的透明性、可验证性、可解释性、安全性与鲁棒性[82]。Ashoori 等也提出了影响人们信任人工智能的七个因素[83],分别是决策风险、决策者、训练方法、模型的可解释性、训练和 测试集的说明、社会透明性与模型置信度。这些因素强调了可信人工智能的公平性、鲁棒性、可解释性、透 明性与置信度。我国何积丰院士也提出人工智能应具有鲁棒性、自我反省性、自适应性和公平性[12]。下表 1 中列出了各个不同组织机构和学者对可信属性的见解。这些可信属性从不同的角度提出了对人工智能系统可 信性的要求。从传统软件可信性的角度提出了人工智能系统可信性应满足的要求:隐私性、安全性、防危性、 可靠性、系统质量和敏捷性;从人工智能模型的黑盒特性对其行为结果产生的影响提出了:公平性、鲁棒性、 可解释性、透明性、可追责性、可验证性和置信度等属性;从人工智能要为人类服务的角度提出了可信需求:普惠性、可持续发展和互操作性;从人工智能应具有人的特征提出了:自主性、价值观、得体性、自适应性 和自我反省性。

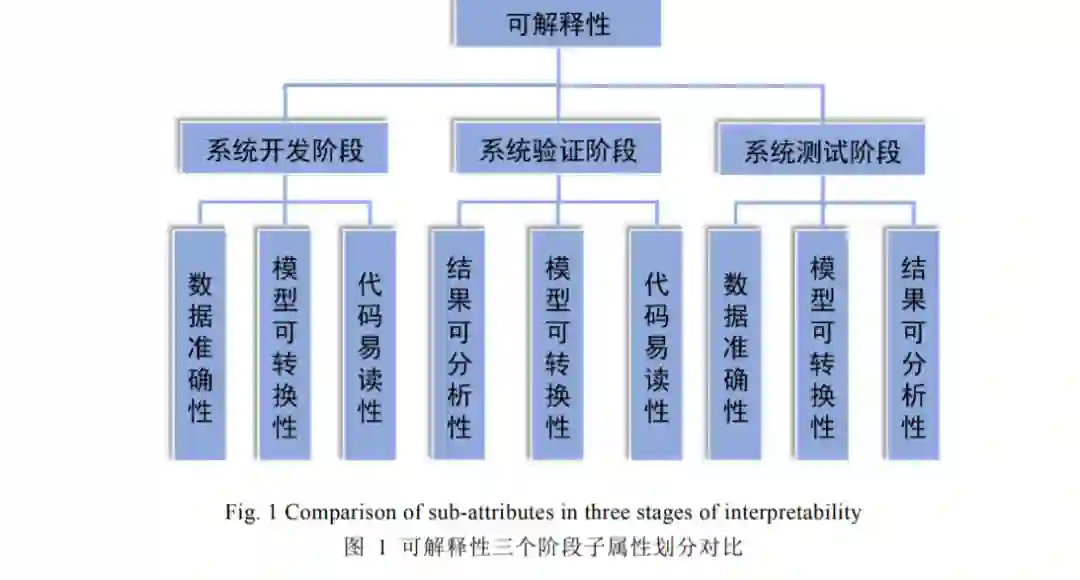

人工智能系统作为软件系统的一种,其可信性需要满足传统软件的要求,而作为人工智能系统,其可信 性又要强调其本身的特性和人的特征。因而,本文认为人工智能系统的可信属性应包含可靠性、隐私性、安 全性、防危性、公平性、鲁棒性、可解释性、自适应性和自我反省性共九个属性。其中,可靠性要求人工智 能系统能提供可靠服务,其数据、结果等应是可靠的;隐私性要求人工智能系统能保护其所拥有和使用的数 据隐私不被泄露;安全性要求人工智能系统可以抵抗外来因素,保护系统信息完整性、机密性和可用性;防 危性要求人工智能系统失效时不会产生不可接受的风险;公平性要求人工智能系统可以公平地对待所有使用 者;鲁棒性要求人工智能系统可以在受到扰动时输出正确的结果;可解释性要求人工智能系统中的模型可解 释,其判断过程可以被人类所理解;自适应性要求人工智能系统在新环境下可以适应,输出正确的结果;自 我反省性要求人工智能系统对自身性能或错误能够有所感知。这些属性不仅结合了人工智能系统本身的特性、 和传统软件可信属性,而且也从为人类服务的角度考虑,更加准确地反应了人工智能系统的可信性特征,为 度量人工智能系统的可信性奠定多维属性基础。

3 人工智能系统可信度量证据

人工智能系统可信证据是指可从人工智能系统中提取且用于衡量人工智能系统可信性的相关指标。因为 人工智能系统的可信性问题可以从其训练数据的可信性、学习模型的可信性和预测结果的可信性三个方面来 考虑,本节从这三个方法讨论了相关度量方法,并设计了人工智能系统可信证据的收集方法。

4 人工智能系统可信度量模型

在之前的部分,我们讨论了人工智能系统的可信属性,总结梳理了人工智能系统的九个可信属性。然后, 为了度量人工智能系统可信性,本文从训练数据可信性、学习模型可信性和预测结果可信性三方面讨论了度 量方法,为可信性度量提供可信证据。近年来,有部分学者对人工智能系统的可信度量评估进行了研究,本 节将着重介绍这些研究。

Shepperd 和 Nakamochi 从软件质量的度量出发,对人工智能系统进行度量。Shepperd 回顾了软件度量的 相关概念,并进一步介绍了人工智能和软件工程的关系,他认为软件度量的许多度量指标都可以被应用在专 家系统的管理和质量保证方面,包括软件结构度量等,但是由巴里·勃姆(BarryBoehm)提出的软件成本估 算方法 COCOMO 无法直接应用于专家系统[115]。Nakamichi 等重点研究了机器学习系统所要求的质量特性, 以满足企业信息系统的质量要求。他们通过确定与机器学习系统需求规范相关的 22 个问题,包括环境/用户、 系统/基础设施、模型和数据,将传统的软件质量标准 ISO25010 的质量扩展到机器学习系统所拥有的特性, 提出了评价质量特性的指标和测量方法,并通过一个行业的实证研究,验证了所提出模型和测量方法的可行 性[116]。

也有一些学者针对不同类型的人工智能系统提出了度量模型。Cheng 等提出了一个基于主观逻辑的神经 网络可信量化框架 DeepTrust,其构建了人工智能算法的概率逻辑描述,同时考虑了数据集和内部算法工作的 可信度[117]。DeepTrust 同时适用于分类和回归问题,其输入值不影响可信度的计算。DeepTrust 不仅能够在训 练数据和训练过程可访问的前提下,对训练阶段神经网络的意见进行量化,而且在给定预训练神经网络的情 况下,它还可以用于神经网络决策或输出的可信量化。神经网络预测的意见和可信度量化提供了对输入数据 和神经网络内部工作可信度的评估,并且在神经网络过拟合时非常有效。Uslu 等则首次提出了一种可信指标 框架来评估人工智能系统在食品、能源和水管理决策中的验收标准,在评估专家选择每个人工智能系统提出 的最合适的解决方案中,计算从这些人工智能系统提出的解决方案到专家给出的最佳参考方案的距离,并使 用提出的信任框架计算系统的可信接受度[118]。此外,他们通过信任系统来聚合了多个专家的度量评估结果。Chowdhury 等使用车载单元(OBU)组件、GPS 数据和安全信息来确定自动驾驶车辆的可信性,通过计算和 处理相关的不确定性,利用确定性逻辑和主观逻辑开发了评估可信值的理论模型,并对提出的模型产生的可 信值进行了对比分析[119]。作者还在模拟城市交通平台 SUMO 和澳大利亚历史交通数据 VicRoads 验证提出的 模型,其中,基于特定逻辑的模型产生的可信值比主观逻辑产生的可信值对被破坏的组件更加敏感。Chattopadhyay 等对机器人进行可信评估,分析了 Zumi 和 Cozmo 社交机器人的内部缺陷,并使用 IEEEA/IS 可信 AI 指南对其总体设计进行了评估,研究该社交机器人是否与可信人工智能框架描述的原则相一致[120]。

总体而言,学者们近几年来开始愈发关注人工智能系统可信性,并且尝试对其可信性进行评估,从而开 发出更加可信的人工智能产品。目前,大多数研究聚焦在如何改善和提高人工智能系统可信性,而人工智能 可信度量评估并没有受到很大关注,因此也没有像软件可信度量评估那样,经过数十年发展积累丰厚的研究 成果。因此,人工智能可信度量评估领域还需要进行深入系统的研究。

5 基于属性的人工智能系统可信度量评估框架

尽管目前人工智能系统在可信性度量评估已经有部分研究成果,但鲜有研究从基于属性的软件可信度量 的角度度量人工智能系统的可信性。人工智能系统作为软件系统,其可信量化评估也可以使用软件可信度量 理论来实施。本文提出一个人工智能可信度量评估框架,将软件可信度量理论应用于人工智能系统的可信度 量评估,而且为了保证度量过程数据的可信性不被篡改,本文将保证数据可信性常用的区块链技术应用于框 架中,整个框架包括人工智能系统可信属性分解与证据获取方法、联邦式可信度量模型以及基于区块链的人 工智能可信评估架构 AITrust 三个部分。本文期望该框架可以为人工智能系统可信度量研究人员提供参考, 以推动人工智能系统可信度量研究进一步发展。

6 总结与展望

本文对人工智能系统的可信性度量进行了综述性的分析和研究。首先对人工智能技术和软件可信度量的 背景进行了讨论,分别对两个方向的研究现状进行了论述,并阐述了人工智能系统可信度量的动机和可信人 工智能的战略与规划。然后,本文对人工智能系统的可信属性进行详细探讨,比较了各个组织和学者给出的可信属性,提出了人工智能系统基础的九个可信属性。接着,分别从训练数据可信性、学习模型可信性、预 测结果可信性方面讨论了相关度量方法,设计了人工智能系统可信证据收集方法。然后,讨论了现有的人工 智能系统可信度量方法,结合基于属性的软件可信度量技术,本文建立一个人工智能系统可信度量评估框架, 该框架包括可信属性分解与证据获取方法,联邦式可信度量模型和基于区块链的人工智能系统可信评估架构 AITrust,将基于属性的软件可信度量技术应用于人工智能系统的可信评估,并且使用区块链技术保障了评估 过程的可信性。

人工智能系统可信性已经获得越来越多人的关注,人工智能系统可信度量评估可以保障人工智能系统的 可信性,为人工智能系统开发与使用人员提供相应参考。然而,人工智能系统可信度量的发展仍然面临着许 多问题和挑战:

1) 针对人工智能系统的可信属性,各个机构与学者关注点不尽相同,本文虽然讨论并总结梳理出了九 个人工智能基础的可信属性,然而对于面向不同领域的人工智能系统,使用不同机器学习模型的人 工智能系统,其可信属性可能会有所扩展,且其度量模型也有可能不同。因此,人工智能可信属性 的完备性值得关注,从而设计面向不同领域的不同系统、不同模型、甚至不同数据的可信属性集合 以及其度量模型,形成更加完备的人工智能可信属性模型。

2) 就人工智能系统的可信证据而言,在人工智能系统的训练数据可信性、学习模型可信性和预测结果 可信性度量方面虽然有许多研究,但是这些研究过于杂乱,量纲难以统一,很难形成统一的可信证 据度量模型,为后续可信度量模型的建立造成一定难度。因而,统一可信证据量纲,形成科学合理 的可信证据模型同样值得关注。

3) 目前,面向人工智能系统的可信度量模型研究还比较初步,相关的研究还比较少,本文提出了一个 面向属性的人工智能系统可信度量框架,但其中的可信度量模型还需进一步完善,从而建立科学合 理的人工智能系统可信度量模型,使其度量结果具有可信性。并且,本文建立的人工智能系统可信 度量框架是面向可信属性,仅从静态角度来度量可信性,并未考虑人工智能系统运行时的动态变化 与用户反馈。因此,建立科学合理且全面的人工智能系统可信度量评估模型是人工智能可信度量评 估的又一挑战。

4) 在建立人工智能系统可信度量方法的基础上,开发人工智能系统可信度量评估综合工具,使得人工 智能系统可信度量评估工程化,把人工智能系统的度量评估融入人工智能系统的实际开发和使用过 程中,提高人工智能系统的可信性,为人工智能系统更好地服务人类奠定基础。希望通过本文的讨论、探索、思考和提出的人工智能系统可信度量评估框架,为人工智能系统可信度量 评估的发展和应用开辟更加广阔的道路。

参考文献:

[1] Fang BX. Artificial Intelligence Safety and Security. Beijing: Publishing House of Electronics Industry. 2020. 1-10(in Chinese)

[2] Hinton G.E., Osindero S, Teh Y-W. A Fast Learning Algorithm for Deep Belief Nets. Neural Computation, 2014, 18(7):1527-1554.

[3] Silver D et al. Mastering the game of Go with deep neural networks and tree search. Nature 529 (2016): 484-503.

[4] Notice of the State Council on printing and distributing the development plan of new generation artificial intelligence, GF [2017] No.35 Development plan of new generation artificial intelligence, July 8, 2017. (in Chinese)

[5] Science popularization and education research support center, Department of Chinese Academy of Sciences. China Science and technology hot book review 2019. Beijing: China Science Publishing & Media Ltd. 2020. 89-137. (in Chinese)

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“TMAI” 就可以获取《「人工智能系统可信性度量评估研究」最新2022综述》(附下载)》专知下载链接