【资源推荐】BERT论文合集

【导读】 BERT的全称是Bidirectional Encoder Representations from Transformers,它是一种新型的语言模型。之所以说是一种新型的语言模型,是因为它通过联合调节所有层中的双向Transformer来训练预训练深度双向表示。

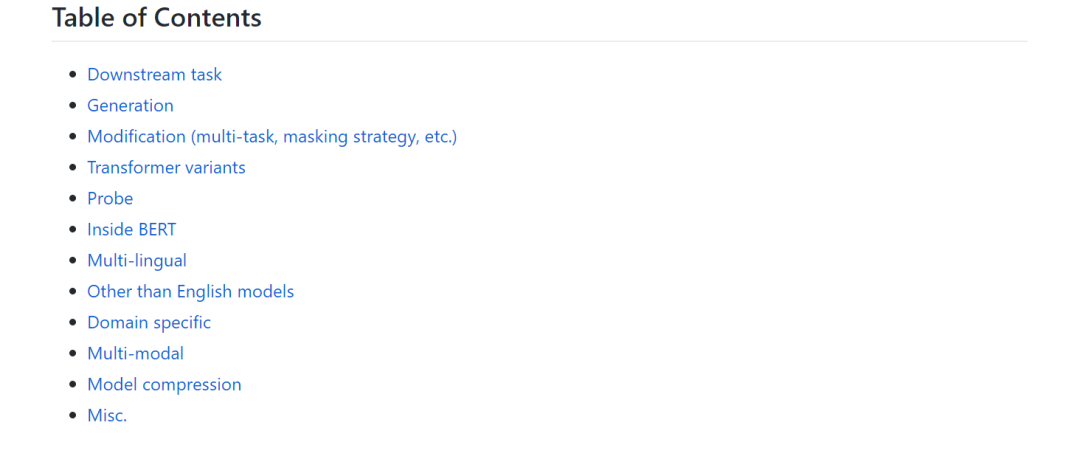

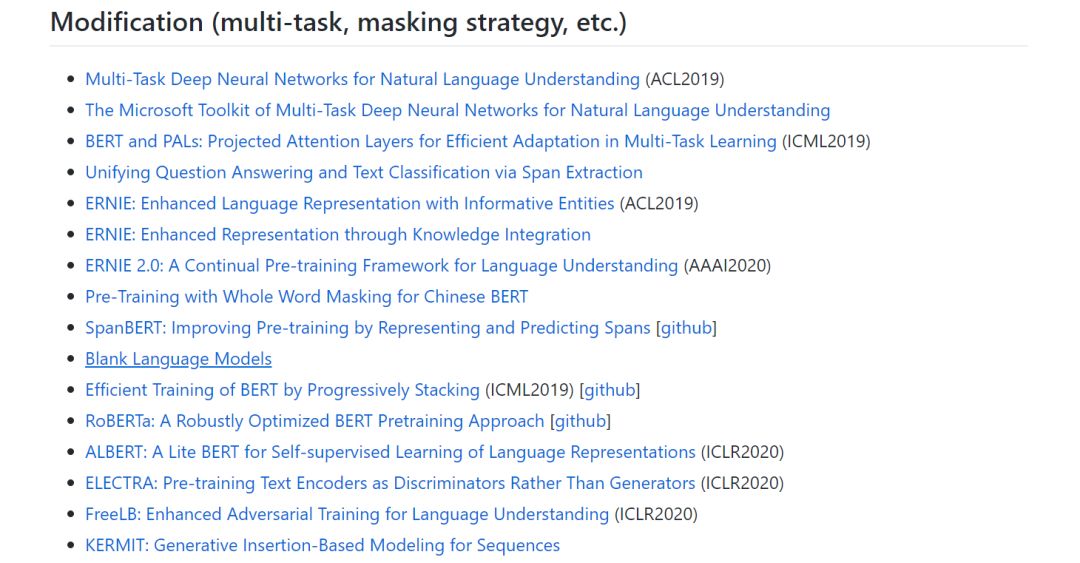

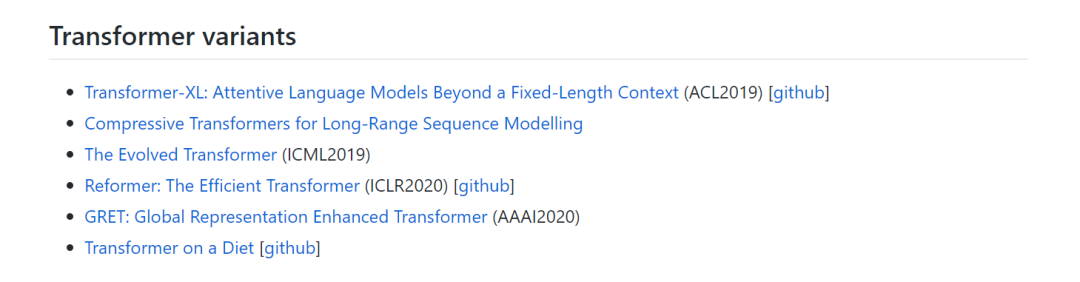

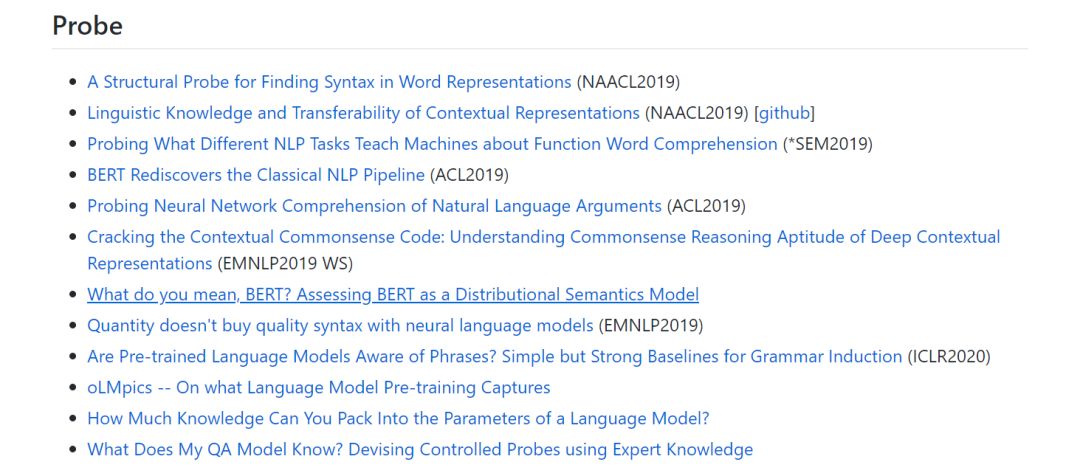

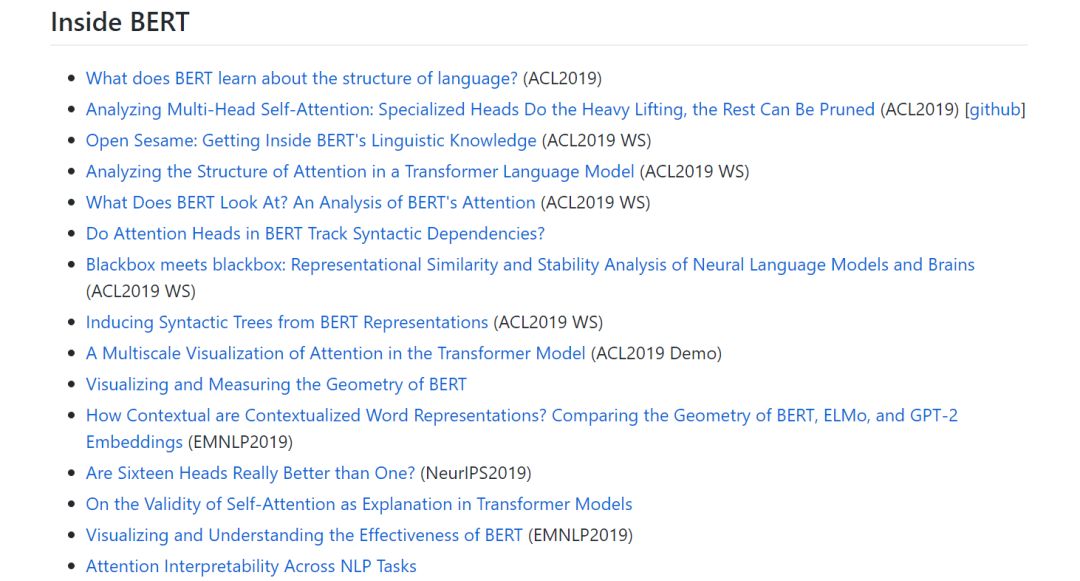

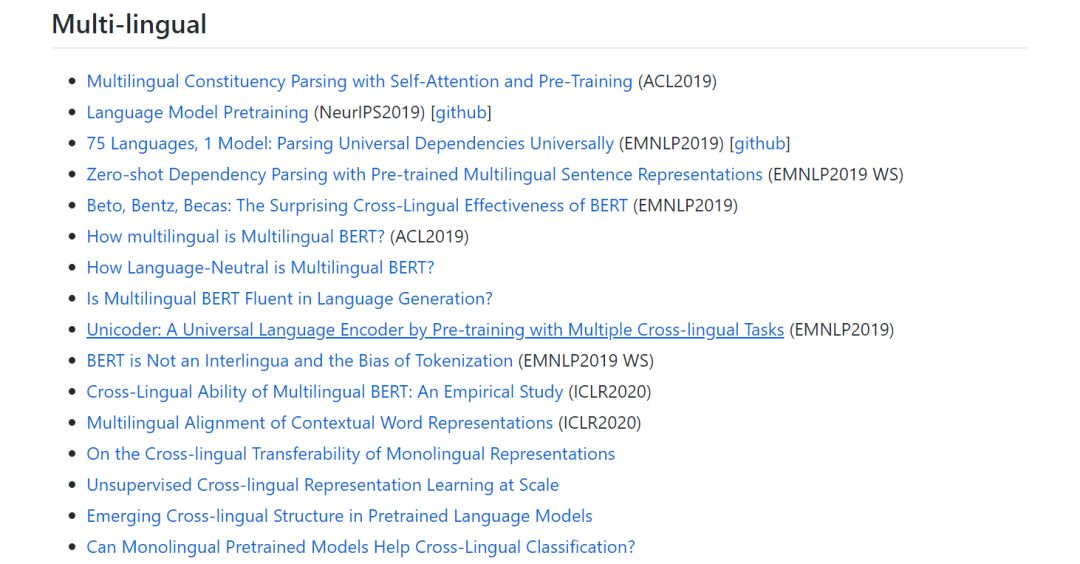

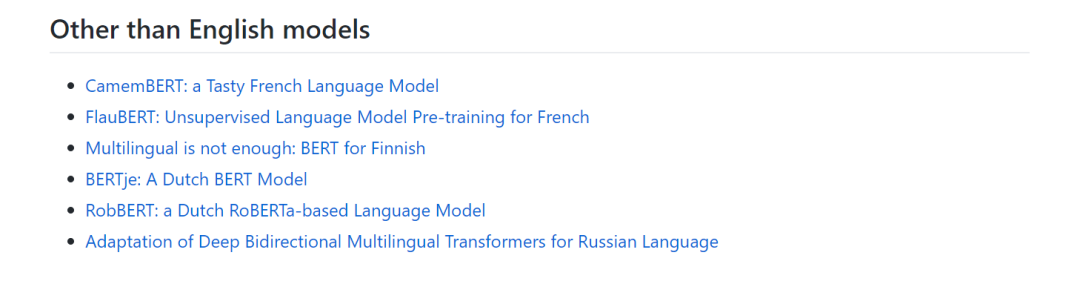

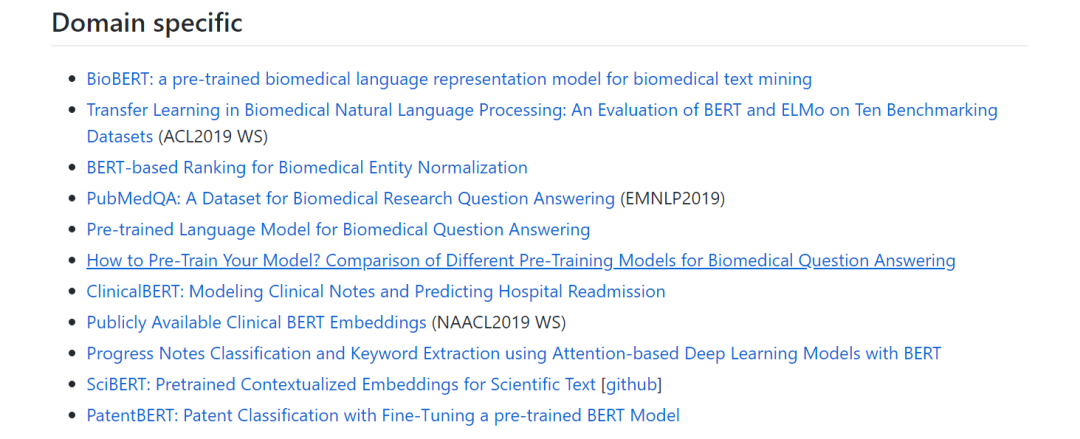

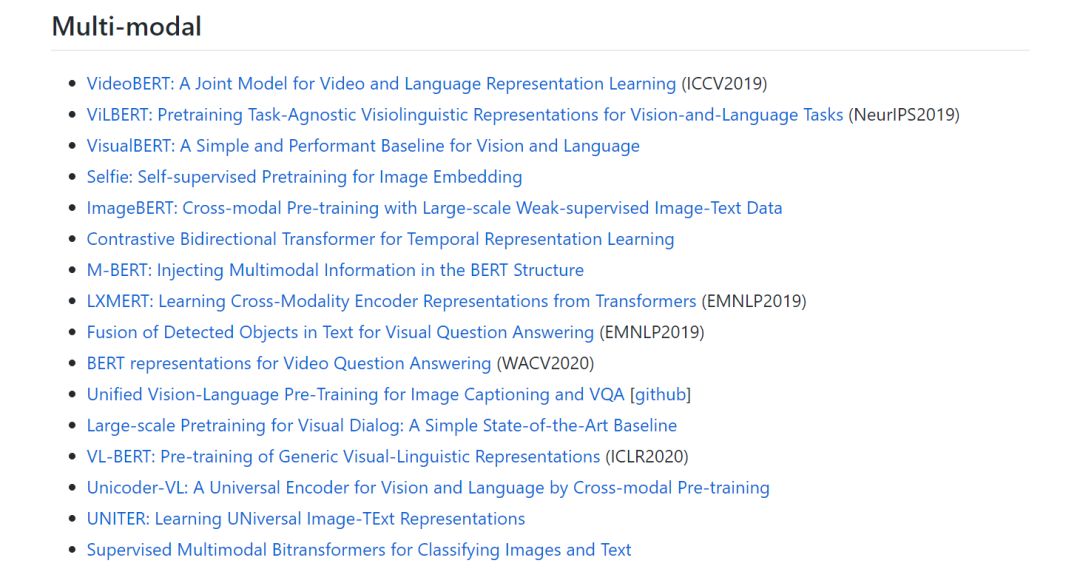

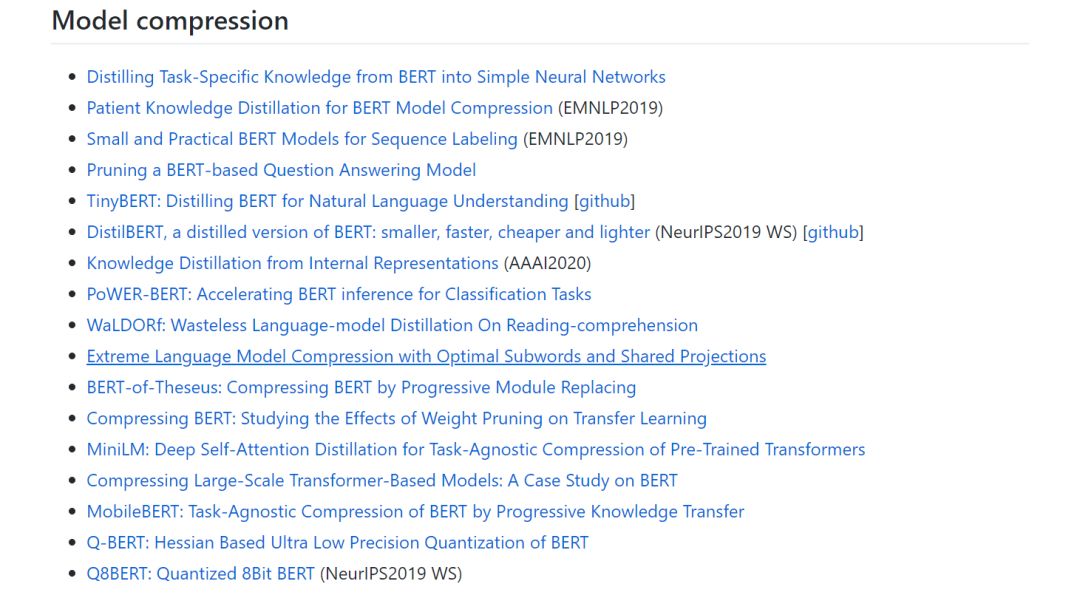

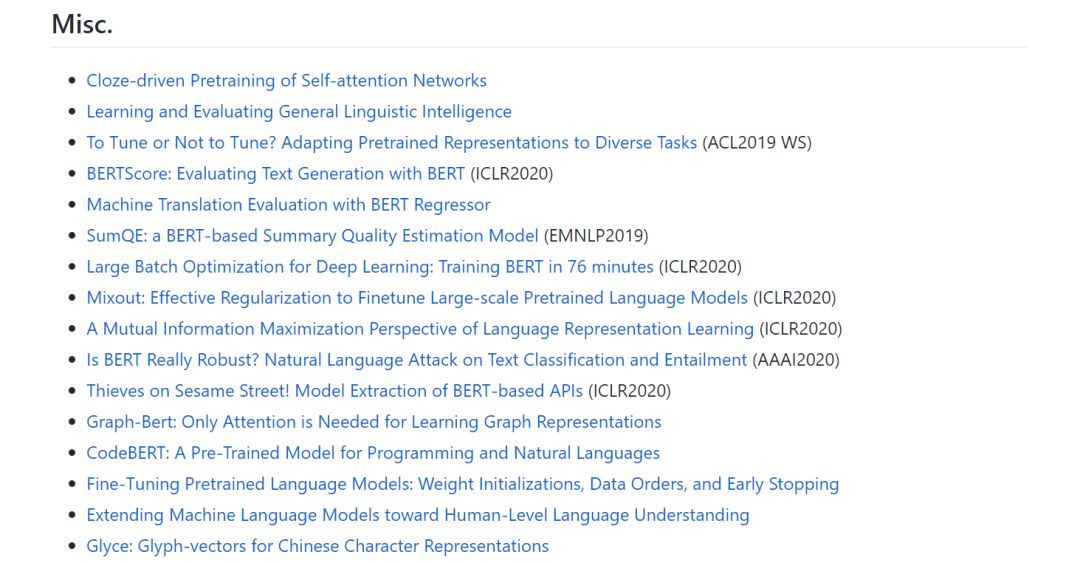

本资源整理了与BERT相关的论文,并按应用类别进行分类,包括:Downstream task、Generation、Modification (multi-task, masking strategy, etc.)、Transformer variants、Probe、Inside BERT、Multi-lingual(多语言)、Other than English models(英语以外的模型)、Domain specific(特定领域)、Multi-modal(多模态)、Model compression(模型压缩)、Misc(其他混杂论文)。

目录

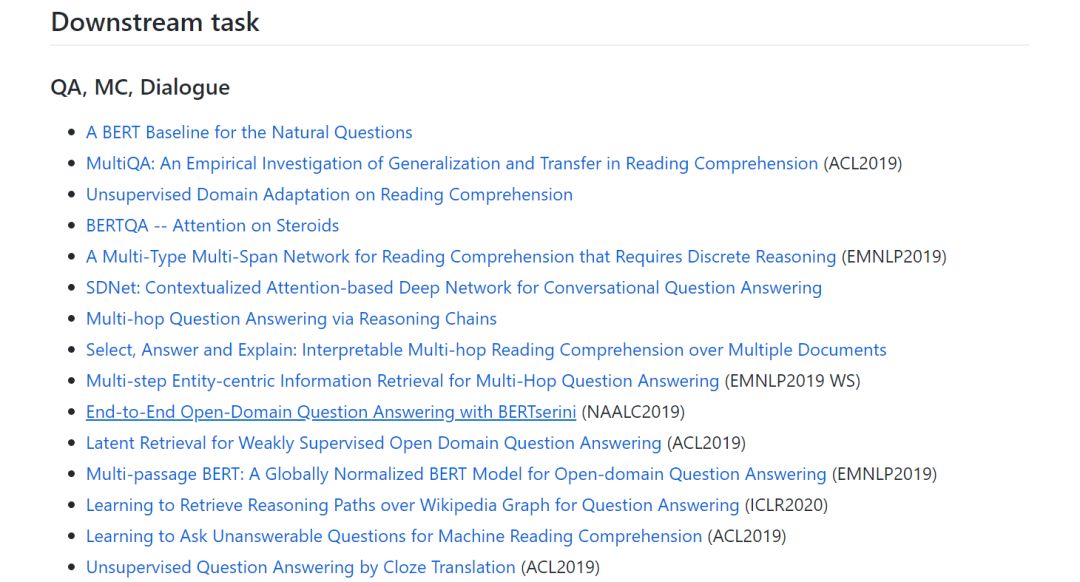

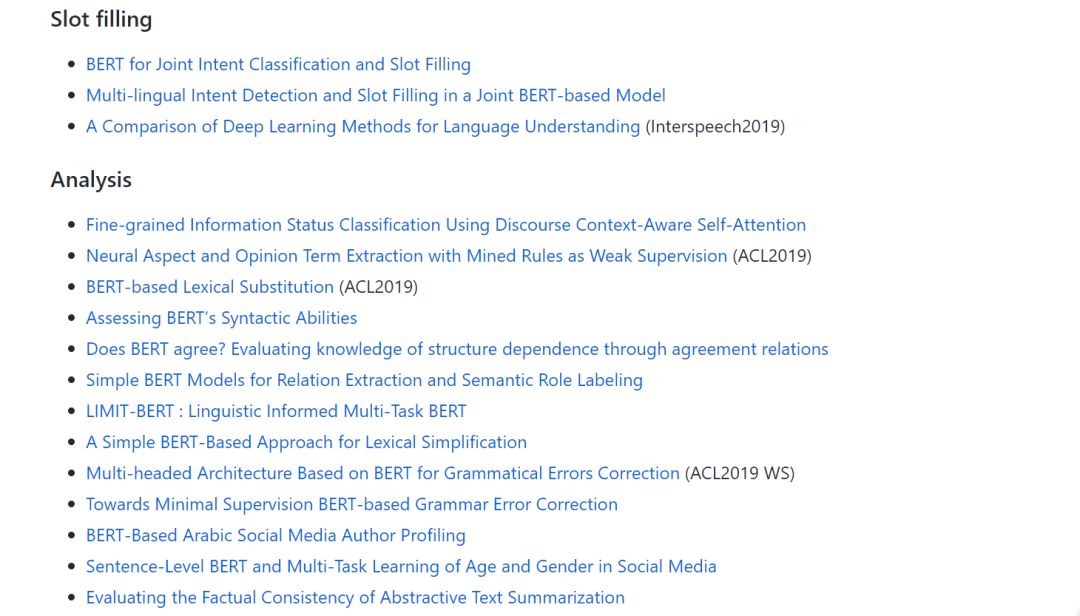

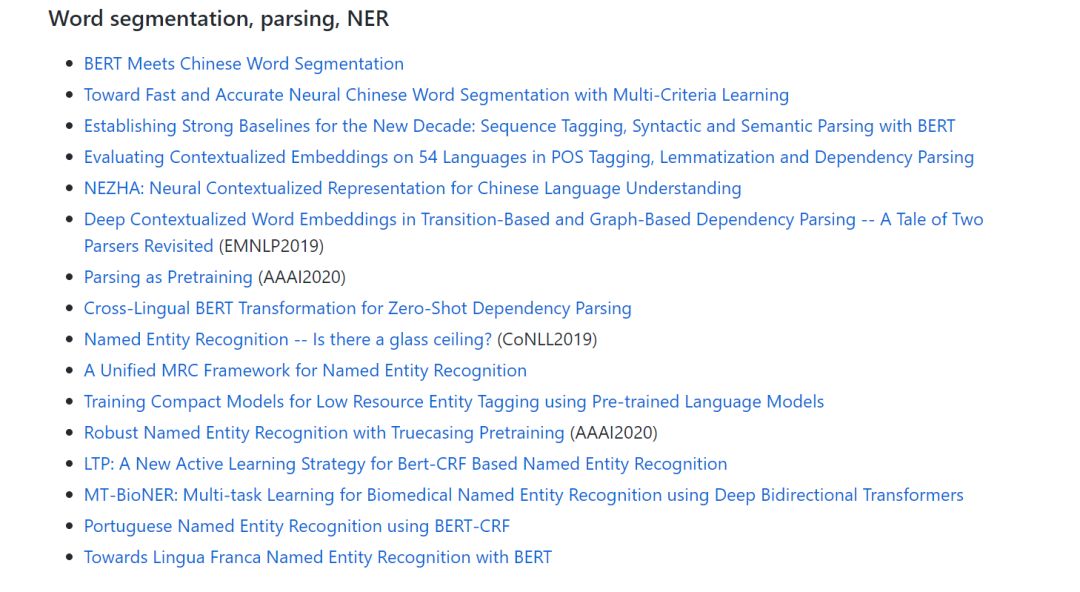

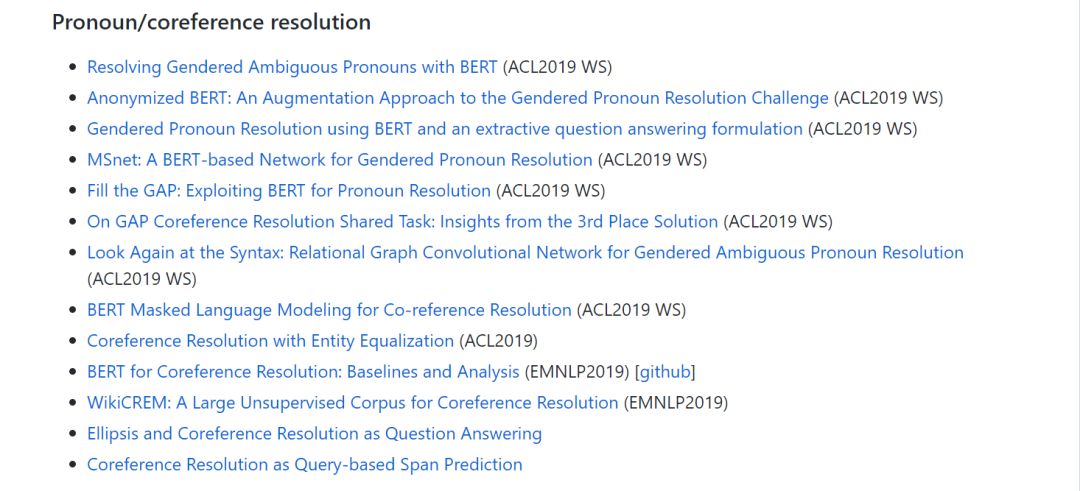

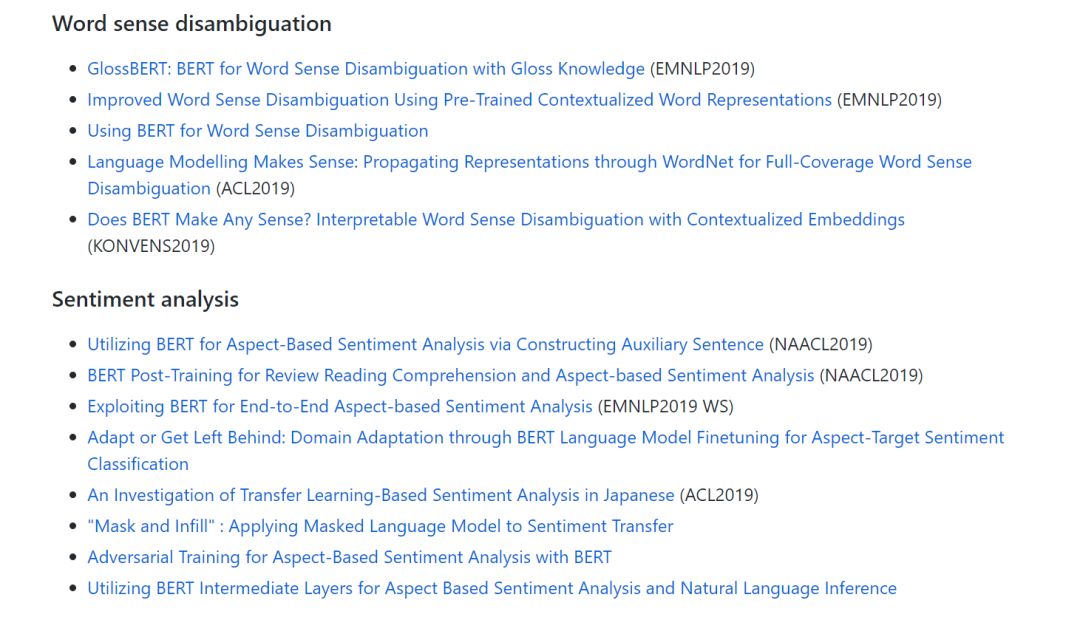

Downstream task

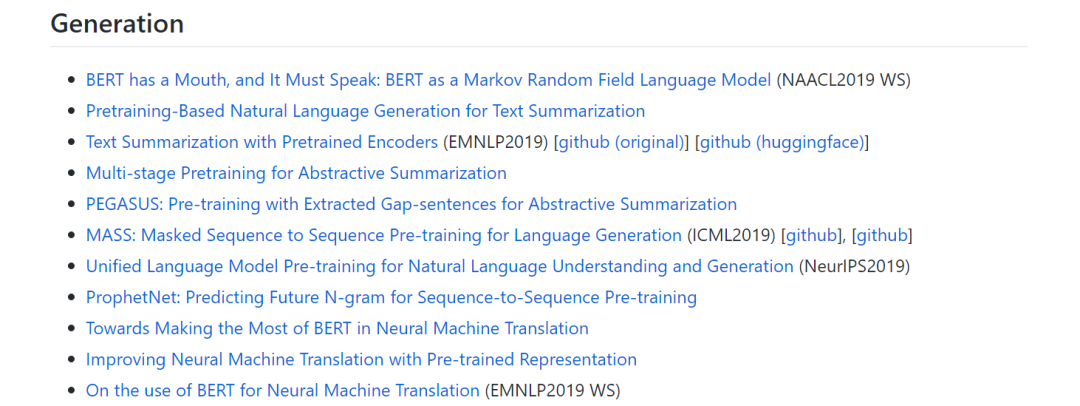

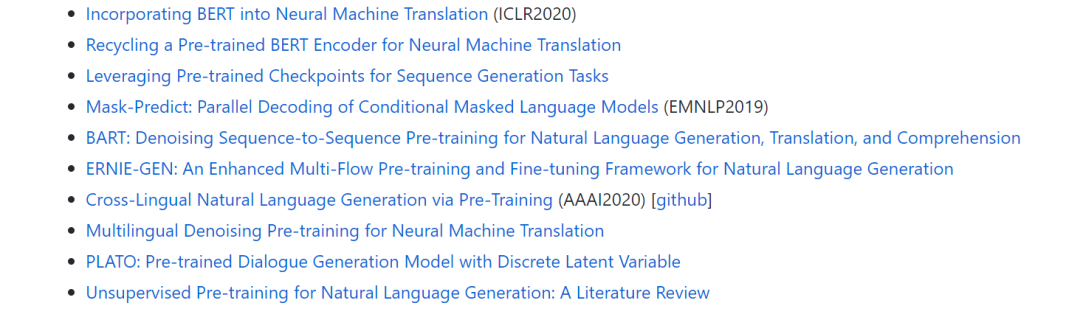

Generation

Modification

Transformer variants

robe

Inside BERT

Multi-lingual

Other than English models

Domain specific

Multi-modal

Model compression

Misc

地址连接:

https://github.com/tomohideshibata/BERT-related-papers#domain-specific

登录查看更多

相关内容

Arxiv

4+阅读 · 2019年9月11日