登顶VOT2018!南京大学提出FCOT:全卷积式在线跟踪器

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文作者:07wlm

https://zhuanlan.zhihu.com/p/147835138

本文已由原作者授权,不得擅自二次转载

今天介绍一下我们在单目标跟踪领域的新工作FCOT(Fully Convolutional Online Tracking),目前在VOT2018/LaSOT/TrackingNet/GOT10k等多个数据集上达到了实时trackers的state-of-the-art效果,并且能达到47fps。

论文地址:

https://arxiv.org/abs/2004.07109

代码(已公开各数据集raw results,代码整理后放出):

https://github.com/MCG-NJU/FCOT

思考

近年来,基于Siamese的方法可以说是占据了视觉跟踪领域的半壁江山,涌现了像Siamfc, SiamRPN, SiamRPN++, SiamFC++等优秀的方法,既能保证比较好的跟踪效果,又达到了很高的FPS。然而另一类判别式的跟踪模型也同样值得瞩目,像ATOM/DiMP取得了当时的SOTA效果,并且也能达到实时。如果将目标跟踪任务分为分类(粗定位目标)和回归(精确回归目标的框)两个子任务,那么DiMP这类判别式的方法充分证明了对分类任务进行跟踪过程中的在线训练,可以有效地提升tracker的鲁棒性,对于区分前景和背景颇有帮助,也因此在多个数据集上达到了当时最好的跟踪效果。基于此,我们就思考:既然对于分类分支的在线训练已经证明了其有效性,那是否对回归分支进行在线训练能使得跟踪过程中框的准确性更高呢?

动机

1. 解决跟踪过程中由于目标形态变化等引发的目标框回归不准确的问题,对回归分支首次进行了在线训练;

2. 为了实现回归分支的在线训练并且能达到跟踪的实时性,就需要一个简洁而有效的回归分支,因此借鉴了检测领域Anchor-free的工作FCOS的思路,直接回归目标的中心点到四个边的距离;

3. 既然要直接回归目标的中心点到边界的距离,那么首先分类分支中定位出的目标中心点要相对比较准确才能保证较高的精度,因此我们产生了更高分辨率的分类score map。另外我们发现高分辨率的score map对定位精度有效,而低分辨率的score map则对tracker的鲁棒性有帮助,因此我们提出了将多个不同分辨率的分类score map融合进行定位的策略。

具体实现

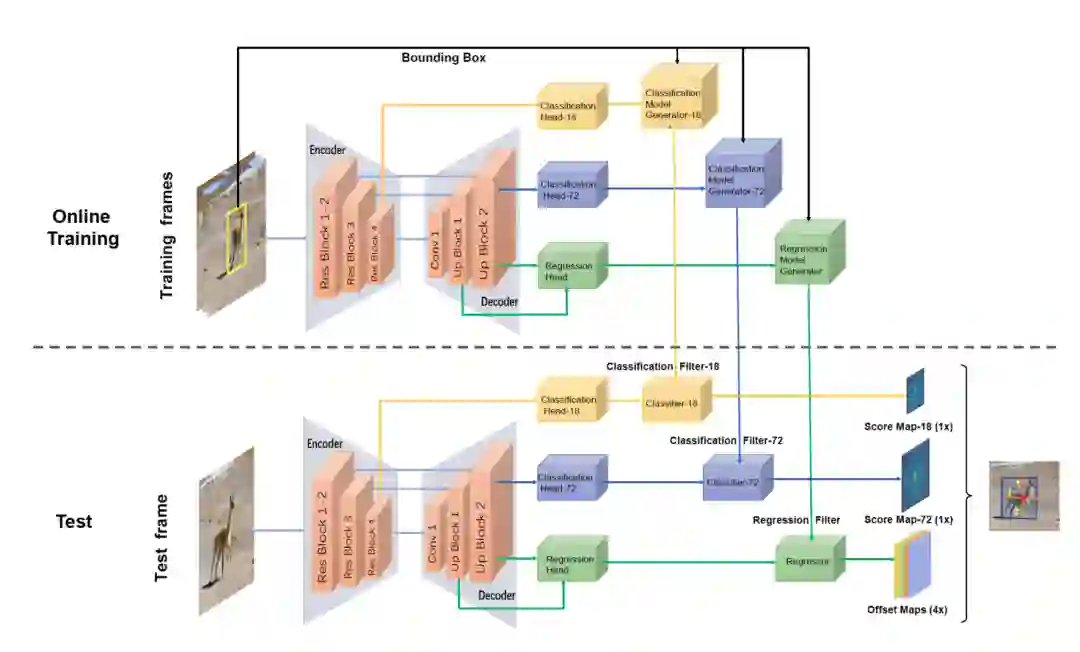

该网络的上半部分为在线训练部分,用来通过训练帧(给定的第一帧以及以及跟踪结束的之前帧)产生分类model和回归model(即卷积核),下半部分为测试部分,通过上面产生的model来对当前的测试帧进行分类和回归,得到目标的中心点和中心点到四个边界的偏移,从而产生最终的目标框。

首先backbone我们采用了Encoder-Decoder的结构来产生不同分辨率的score map和offset map。Encoder采用了R esnet-50的Layer1-layer4,Decoder则采用了简单的几个上采样层。在backbone提取了公共特征之后,再对于不同分辨率的分类分支和回归分支分别采用不同的head来提取针对特定任务的特征。

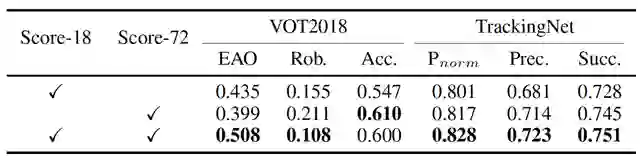

多尺度分类.

为了保证分类分支定位目标中心点的精度,我们生成了大小为72的分类score map,然后发现score map-72对于相似目标的判定效果不是好,而大小为18的低分辨率score map,虽然精度没有score map-72高,但是鲁棒性更好一些。因此我们将两个不同scale的score map融合进行预测,下面的消融实验也会详细验证。

Anchor-free 回归.

对于回归分支,不同于siamRPN等方法的RPN结构和ATOM等采用的Iou预测来迭代回归框的方式,我们借鉴了FCOS,采用了anchor-free的回归方式,直接预测中心点到边界的距离,不仅简化了结构,更能高效地实现该分支的在线训练。

Regression Model Generator.

该部分用来实现回归分支的在线训练,包括一个初始化模块和在线优化模块,初始化模块仅仅使用第一帧训练图像产生一个初始的regression model,而在线优化模块则采用了最速下降法来显式地求出每次迭代的步长(DiMP在分类分支在线训练中验证了该方式较梯度下降迭代次数更快,效率更高一些)。具体的细节可以参照论文。

实验

Ablation

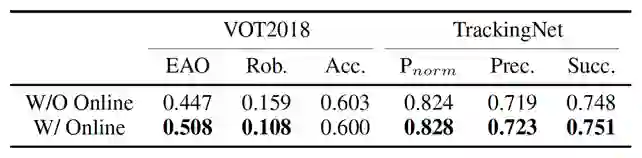

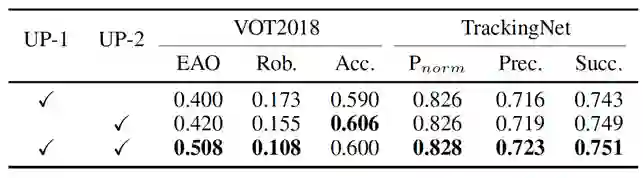

在消融实验中,我们主要验证了三部分:多尺度分类,回归分支的在线训练,回归分支的特征融合。

Score map-18对于鲁棒性的提高有帮助,而score map-72则会提高定位的精度,从而提升框的精度,我们在论文的appendix中也有更详尽的可视化和讨论。

从VOT2018和trackingnet可以明显的看出回归分支在线训练的作用,而VOT的accuracy这个指标之所以比不用在线训练低,是和vot的测试方式有关的。在vot数据集的测试过程中,如果跟丢了目标就会计作lost一次,重新给定目标的真实框进行跟踪。而FCOT加上在线训练之后框更加准确一些,所以也促进了分类分支的在线训练效果,因此lost次数更少,每次跟踪的序列更长一些,accuracy在长序列中就会降低一点。

回归分支的特征融合对于跟踪性能的提升也是有帮助的。

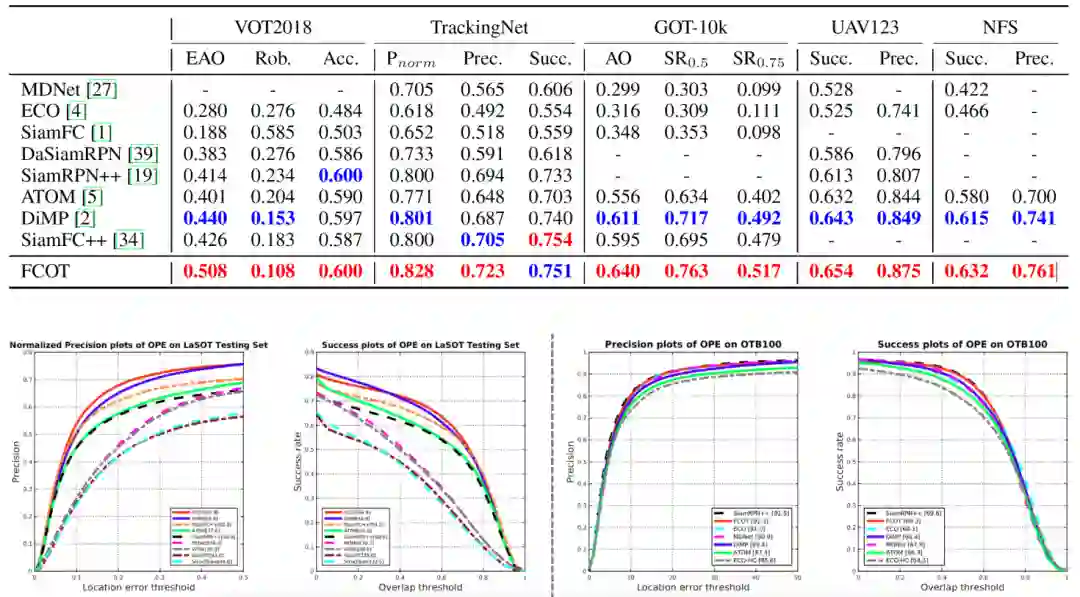

State-of-the-art对比

为了验证FCOT的性能,我们在主流的单目标跟踪数据集进行了测试,包括VOT2018/GOT-10k/OTB100/UAV123/NFS几个重要的短时数据集以及LaSOT和TrackingNet两个较大的数据集上进行了测试,其中在VOT2018数据集上的EAO和Robustness达到了0.508和0.108,相对于ICCV2019的DiMP以及AAAI2020的SiamFC++有很大提升,此外在TrackingNet和LaSOT数据集normalized precision也提升很大,在GOT-10k等数据集上也达到了SOTA的效果。FCOT在取得当前SOTA效果的同时,还能达到47fps。

总结

FCOT在较高的FPS的基础上,实现了很好的定位精度和框的回归精度,提升了跟踪的性能。但是目标跟踪领域还是存在着很多问题,像如何处理遮挡等等,总之还需要我们去进一步发掘。

论文下载

在CVer公众号后台回复:FCOT,即可下载本论文

重磅!CVer-目标跟踪 微信交流群已成立

扫码添加CVer助手,可申请加入CVer-目标跟踪 微信交流群,目前已汇集1400人!涵盖单目标跟踪、多目标跟踪等。互相交流,一起进步!

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、TensorFlow和PyTorch等群。

一定要备注:研究方向+地点+学校/公司+昵称(如目标跟踪+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加群

▲长按关注我们

请给CVer一个在看!