ARKit 2眼动追踪,人机交互新模式

在ARKit 2.0发布之后不久,不少开发者发现了新版本ARKit对利用iPhone X前置结构光摄像头进行眼动追踪的支持。

类似的功能我们在过去也见识过(不会写程序怎么当好艺术家?跳出iPhone X屏幕的3D立体视觉效果)

该艺术效果的开发者就是利用了前置景深摄像头获取眼球位置,根据位置实时改变动画呈现角度。

但严格意义来说,这并不算是眼动追踪,只是对眼球位置的识别,换言之如果头部和手机的相对位置不改变,眼球转动时画面不发生变化。

而ARKit 2下眼动追踪的效果效果就非常惊艳了

转动眼睛,屏幕中的十字光标便会随着注视点的移动而移动,响应速度和精确度都很不错

通过眨眼睛(忍不住想眨眼了怎么办,会不会误触)完成点击选择,操纵手机全程不需要动手,在很多场景中可以说是非常方便了。得益于红外方案,即便是在黑暗中也能实现眼动追踪。

手机眼球追踪

用眼动追踪来控制手机,是不少开发者一直以来都在设想的。

去年年初发布的ZTE Hawkeye加入的眼球追踪利用前置摄像机检测用户的虹膜运动,上下或左右滑动控制屏幕。

滑动的功能能方便人们在手上没空的情况下简单的操作手机,但是对于一些使用群体(肢体残障)来说,他们渴望功能更加强大的眼动追踪方案。

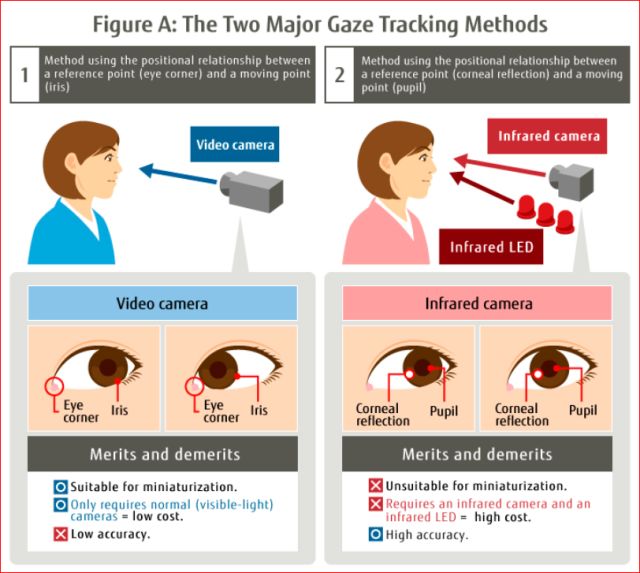

一般而言,有两种跟踪眼球的方案,即普通摄像头和红外摄像头。

普通摄像头方便小型化,低成本但是精度低,红外方案体积大,造价高,同时精度高。

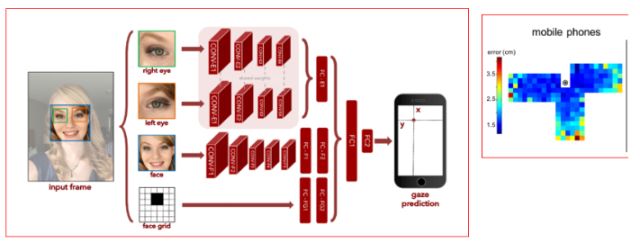

但随着技术的发展,优缺点不能一刀切,针对普通摄像头方案,2016年麻省理工开设的“Eye tracking for everyone”就利用了卷积神经网络(CNN)预测用户对手机或者平板的注视位置,只使用普通摄像机的情况下让精度变为1.34cm到2.12cm。

尽管精度上有所提高,但从目前的市场情况可见虽然该技术还并没有成熟。

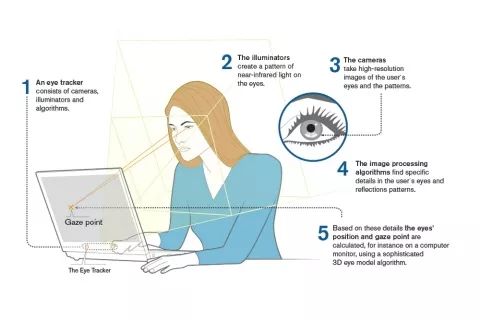

红外摄像头则一直都是主流的眼动追踪识别方案

例如Tobii眼动仪采用的技术就是通过识别用户眼球上角膜、瞳孔产生的反射图像,使用两个图像传感器分别采集眼睛与反射图像,通过图像处理算法和一个三维眼球模型精确地计算出眼球、注视点在空间中的具体位置。

解决了小型化问题的True-Depth相机模组是否也采用了相似地技术原理呢?

6月20日,开发者Andrew Zimmer在Twitter发布了一个demo,展示ARKit 2对眼睛注视点位置的实时追踪效果,随着Andrew眼球的转动,注视点点的移动在屏幕上画出一条连贯的曲线。在图中,颜色越暖(橘色、红色),代表注视时间越长。注视点位置的检测精确,识别轨迹流畅连贯,在未来的人机交互中潜力巨大。

有相当数量的患者由于操作不便,与信息时代脱节。其中有不少唯一与设备相互动的渠道就是眼睛,眼球追踪加入智能手机的交互模式同样也能造福健全人,让我们在手上没空的情况下操作手机比如做饭看菜谱、开车看导航。

不过同时,技术也带来了很大的隐私问题。相信大家都有同感,在网上浏览过某一类商品之后,pc和手机app的各种广告和弹窗中会根据你的浏览内容推荐一堆类似商品。当未来的APP知道了你因为感兴趣而长时间注视的内容,内容推送会更加精确,人们的注视内容信息会被拿去贩卖,更无隐私可言了。