人工智能正在重塑战略规划领域,其中多智能体强化学习(MARL)使得自主智能体能够在复杂场景中实现协同作战。然而,由于缺乏可解释性——这是建立信任、保障安全以及与人类战略保持一致的关键因素——该技术在敏感军事领域的实际部署仍受限制。本研究系统回顾并评估了当前多智能体强化学习可解释性方法的研究进展,重点关注模拟空战场景。我们通过将多种可解释性技术适配到不同空战场景中,以获取关于模型行为的解释性见解。通过将人工智能生成的战术与人类可理解的推理相连接,我们强调透明度对于确保可靠部署和有意义的人机交互至关重要。通过阐明可解释性在推进作战防御多智能体强化学习中的关键重要性,我们的工作不仅支持战略规划,还通过提供具有洞察力且易于理解的分析来助力军事人员训练。

人工智能在兵棋推演中的潜力

人工智能已成为诸多领域的变革性力量,在通用应用和兵棋推演等专业领域均取得重大进展。近年来,人工智能在战略决策、适应性及复杂环境应对方面展现出强大能力,这些正是兵棋推演的关键特质。强化学习作为人工智能的重要分支,其智能体通过与环境进行试错交互来学习最优行为,无需专家人类数据即可识别有效行动方案。强化学习使自主智能体能够适应不断变化的战场条件并制定策略。其在象棋等游戏中的成功突显了其在不确定性环境下进行高级推理、规划与执行的潜力。多智能体强化学习将强化学习扩展到共享环境中多个交互智能体的系统,这使其特别适用于兵棋推演——可模拟军事冲突中复杂的协作与竞争动态。多智能体强化学习支持协调策略模拟、实时适应和涌现行为,成为开发和测试先进战术的理想框架。将多智能体强化学习集成到军事模拟中可实现训练与作战规划双目标,为现实决策提供宝贵见解。本研究聚焦空战场景,其中智能体使用多智能体强化学习算法进行训练。特别关注的是狗斗场景,其特点是战斗机之间进行近距离、高机动性的空战。我们的目标是训练智能体飞行员并分析其最终行为。

多种方法应用强化学习与多智能体强化学习来训练空战场景中的智能体。这些方法不仅限于战斗机的狗斗机动,还包括无人机群和不同类型飞机(异质智能体)的协同作战。小规模空战通常侧重于使用强化学习控制飞机并获得位置优势,同时尽可能降低遭遇反击的风险。早期方法涉及专家系统或与学习分类器的混合系统,而近期工作则使用强化学习技术。

为推导更强行动方案,现代方法采用更先进技术,如深度Q网络、深度确定性策略梯度、课程学习或自我对抗训练(即智能体与自身副本进行训练)。另一方面,大规模交战侧重于高层战术决策或武器-目标分配,即行动方案的规划。此处,多智能体强化学习因维度灾难问题及利用智能体对称性的潜力而显得尤为合适。先进方法包括多智能体深度确定性策略梯度、分层强化学习和基于注意力的神经网络。先前一种先进方法引入了带有注意力机制的分层多智能体强化学习模型,该模型可学习对特定特征分配重要性,并使用近端策略优化进行训练。该方法还考虑了异质智能体,这在当前文献中仍属罕见。引入异质智能体会增加协调复杂性,因为智能体可能不了解彼此的技能与能力。使用强化学习方法的其他空战模拟方法可参阅文献[20]。

理解决策过程

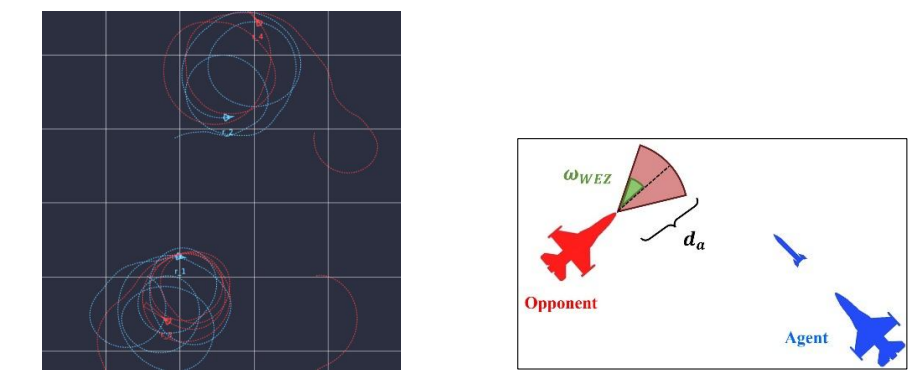

深度强化学习利用神经网络在兵棋推演等复杂现实环境中进行决策。然而,这些模型常因其有限的可解释性而被视为黑箱。可解释强化学习旨在通过揭示在给定情境中采取特定行动的原因,使强化学习模型的决策过程变得可理解。可解释强化学习面临的挑战包括:科学评估与操作可靠性相关风险、缺乏普遍接受的评估指标,以及为复杂任务提供全面解释的难度。在敏感的军事行动中,理解神经网络的决策过程对于错误诊断、模型性能提升和复杂智能体行为理解至关重要。可解释强化学习方法在建立军事人员信任、确保安全关键任务的透明度以及促进符合严格操作与监管标准方面发挥着关键作用。此外,精确的可解释性(即有意义且可靠的解释)有助于更好的风险评估与管理,改进人类与人工智能智能体间的协调,并支持将先进人工智能系统集成到现有军事框架中,同时保持操作可靠性与有效性。空战场景常涉及众多因素,包括机动、目标锁定、威胁规避、燃油管理和与其他单位协调,其中智能体必须做出瞬间决策以实现战略目标。具体示例:智能体探测到来自敌方的导弹逼近。为应对,其快速释放箔条并执行桶滚机动以迷惑导弹的热传感器并规避敌方瞄准。在此场景中,导弹的观测成为执行箔条释放和桶滚动作的重要特征。现有可解释强化学习方法可大致分为:一)策略简化以追踪决策步骤;二)奖励影响将奖励信号分解为子组件;三)特征贡献以识别输入数据中最显著信息;四)因果模型以识别因果关系;五)分层模型以检查子策略选择行为。由于大多数可解释性方法针对单智能体强化学习,我们遵循先前工作将其适配到多智能体设置。我们回顾多智能体强化学习可解释性的最新进展,并引入新颖用例以突显其在分析模拟空战场景中智能体行为的作用(图1)。通过检视这些进步,我们强调可解释性在理解和改进智能体行为方面的重要性,尤其是在军事模拟等复杂环境中的应用。本文探讨可解释性方法如何增强战略规划、促进人机协作并确保关键任务中人工智能驱动决策的可信度。通过这些见解,我们旨在证明可解释多智能体强化学习在高风险场景的研究与实际部署中的紧迫性。

空战可解释性方法

前三种方法(策略简化、奖励分解和特征贡献)属于反应式解释。这些方法关注短时域,基于即时行为提供反馈。例如,“为何飞机发射导弹?”的问题可能以“对手进入武器交战区”作答。此类解释强调个体行动而非 战略意图。相反,前瞻性解释跨越更长时域,更适用于战略决策。它们可能阐明为何具有特定技能的智能体切换到防御模式而其他智能体采取进攻策略。因果与分层强化学习模型支持此类解释,为空战中的长期策略和协调机动提供见解。

在深度强化学习中,神经网络用作函数逼近器以学习决策函数(即策略或Q函数),我们的分析聚焦于策略。策略简化是指降低策略复杂性使其可被人解释的过程。这可通过以下方式实现:以决策树形式学习策略以追踪每个决策步骤;将学习到的策略转换为“如果-那么”规则集;使用状态抽象将相似状态分组并降低状态空间维度;或用高级、人类可读编程语言表示学习到的策略。这些方法实现的简洁性是关键优势,因其便于生成解释并培养对系统的信任。在智能体较少的简单环境中,策略简化能良好泛化并产生有意义的解释,这也可能适用于意外空战场景。在具有多目标和不同技能水平智能体的复杂设置中,这变得更为困难,其中解释往往保持静态。该方法主要缺点在于模型性能与可解释性间的权衡:随着可解释性水平提高,模型准确性常会下降。在空战模拟中,真实性对获得有用见解至关重要,保持准确性极为关键。这常需使用深度神经网络的复杂模型、精细调参、先进算法和高度动态的场景。尽管简化限制了策略表示和整体性能,但它提供了实用起点。简化策略可训练和解释空战中的基本控制行为,为未来模型奠定坚实基础,这些模型能在场景复杂性增加时更好地平衡可解释性与性能。

在强化学习训练期间,总累积奖励难以识别影响决策的具体因素。奖励分解通过将总奖励R拆分为有意义的组件R_i来解决该问题,每个组件代表环境的不同方面。当智能体在状态s下采取行动a时,预期奖励是这些组件的总和。该分解揭示了每个R_i如何贡献于总奖励,从而帮助解释智能体的偏好或识别每个智能体对团队成功的贡献。

奖励分解依赖于奖励函数能否被有意义地拆分为与环境和任务相关的组件。设计此类函数很困难,因其需激励正确行为而不引发意外行为。设计不良的奖励可能导致智能体以偏离预期目标的方式利用函数。在具有不同技能水平和变化目标的多智能体空战模拟中,为每个智能体或组定义奖励组件至关重要但复杂。组件间可能出现冲突,例如避免雷达暴露与接战敌机的需求相冲突。这些冲突可能导致个体与全局目标间的不一致。尽管如此,奖励分解通过澄清人工智能智能体为何偏好某些行动或战术来提高透明度。它有助于解释关键行为,如接战敌人、威胁规避和任务成功。指挥官可用其理解、调整和验证符合任务目标的智能体决策。它还允许调整优先级,例如平衡攻防。例如,如果智能体的奖励包括位置、距离、燃油使用和命中成功,它可能选择撤退,因为保存燃油和维持位置的价值超过命中奖励。分解表明智能体考虑了燃油效率和站位,而非仅眼前战斗收益。此外,它有助于平衡个体与团队目标,例如生存任务与实现空中优势,从而支持更协调的策略。文献[22]中的可视化方法进一步提高了空战中智能体行为的可解释性,我们将在实验中类似地适配这些方法。