图在表示社交网络、知识图谱和分子发现等各种领域的复杂关系中发挥着重要作用。随着深度学习的出现,图神经网络(GNNs)已成为图机器学习(Graph ML)的基石,促进了图结构的表示和处理。最近,大语言模型(LLMs)在语言任务中展示了前所未有的能力,并广泛应用于计算机视觉和推荐系统等多种应用中。这一显著的成功也吸引了人们将LLMs应用于图领域的兴趣。人们越来越多地努力探索LLMs在推进图机器学习的泛化、可迁移性和小样本学习能力方面的潜力。同时,图,特别是知识图谱,富含可靠的事实知识,可以用来增强LLMs的推理能力,潜在地缓解它们的局限性,如幻觉现象和缺乏可解释性。鉴于这一研究方向的迅速进展,对LLMs时代图机器学习的最新进展进行系统的综述是必要的,以便为研究人员和实践者提供深入的理解。因此,在这篇综述中,我们首先回顾了图机器学习的最近发展。然后,我们探讨如何利用LLMs来提高图特征的质量,减轻对标记数据的依赖,并应对图异质性和分布外(OOD)泛化等挑战。之后,我们深入探讨了图如何增强LLMs,突出了它们提升LLM预训练和推理的能力。此外,我们还研究了各种应用,并讨论了这一有前途的领域的潜在未来发展方向。

图数据在许多实际应用中都有广泛的应用,包括社交图、知识图谱和推荐系统。通常,图由节点和边组成,例如,在社交图中,节点代表用户,边代表关系。除了拓扑结构外,图还倾向于拥有各种节点特征,如文本描述,这些特征提供了有关节点的宝贵上下文和语义信息。为了有效地建模图,图机器学习(Graph ML)已引起了重大关注。随着深度学习(DL)的出现,图神经网络(GNNs)因其消息传递机制而成为图机器学习的关键技术。该机制允许每个节点通过递归接收和聚合来自邻近节点的消息来获取其表示,从而捕捉图结构中的高阶关系和依赖性。为了减少对监督数据的依赖,许多研究集中于开发自监督图机器学习方法,以提升GNNs捕捉可迁移图模式的能力,增强它们跨各种任务的泛化能力。鉴于图数据应用的指数级增长,研究人员正在积极开发更强大的图机器学习方法。

最近,大语言模型(LLMs)开启了人工智能的新趋势,并在自然语言处理(NLP)中展示了显著的能力。随着这些模型的发展,LLMs不仅被应用于语言任务,还在计算机视觉(CV)、推荐系统等各种应用中展示了巨大的潜力。LLMs在复杂任务中的有效性归因于它们在架构和数据集大小上的广泛规模。例如,拥有1750亿参数的GPT-3展示了生成类人文本、回答复杂问题和编程的激动人心的能力。此外,由于其庞大的训练数据集,LLMs能够掌握广泛的通用知识和复杂的推理能力。因此,它们在语言语义和知识推理方面的能力使它们能够学习语义信息。此外,LLMs展示了在有限或无特定训练的新任务和领域中的突出能力,这一属性预计将在不同的下游数据集和任务中提供高泛化能力,即使在少样本或零样本情况下也是如此。因此,利用LLMs在图机器学习(Graph ML)中的能力引起了越来越多的关注,并有望增强Graph ML,推动图基础模型(GFMs)的发展。

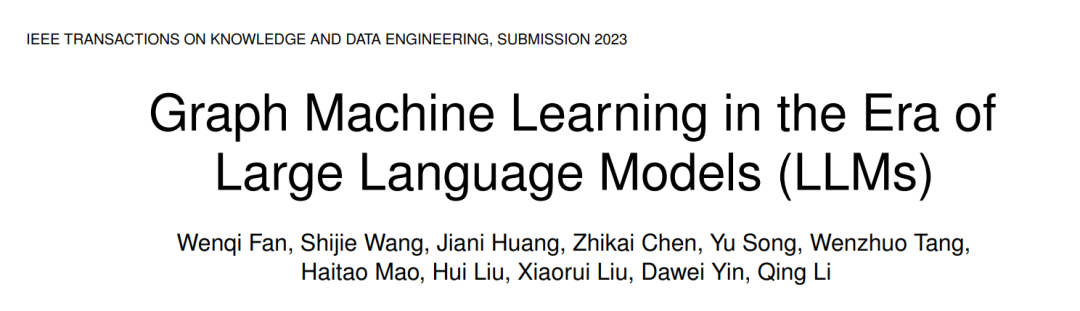

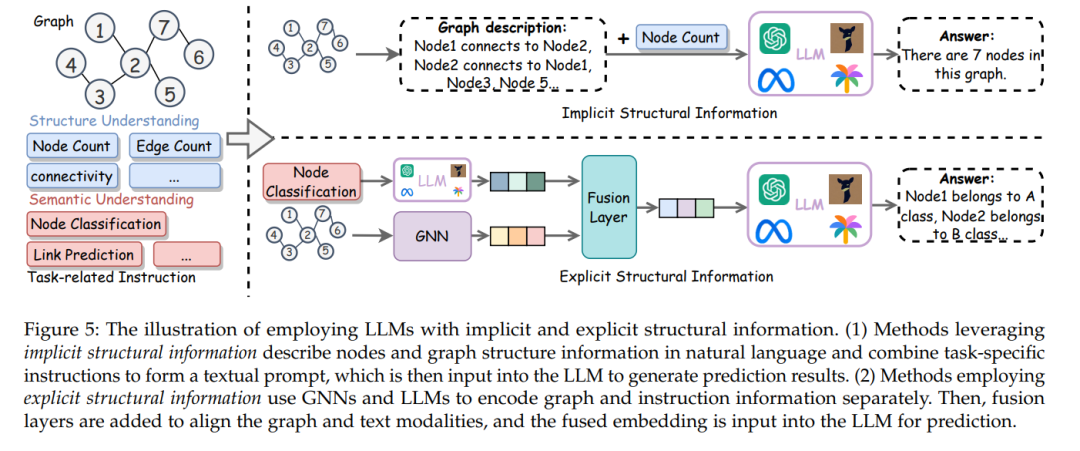

GFMs通常在广泛的数据上训练,并可以适应广泛的下游任务。通过利用LLMs的能力,有望增强Graph ML在各种任务中的泛化能力,从而促进GFMs的发展。目前,研究人员已经进行了一些初步努力,探索LLMs在推进Graph ML向GFMs发展中的潜力。图1展示了将LLMs和GNNs集成用于各种图任务的一个例子。首先,一些方法利用LLMs减轻原始Graph ML对标记数据的依赖,它们根据隐含和显式图结构信息进行推断。例如,InstructGLM通过将图数据序列化为令牌并编码图的结构信息来解决图任务,对诸如LlaMA和T5的模型进行微调。其次,为了克服特征质量的挑战,一些方法进一步利用LLMs提高图特征的质量。例如,SimTeG在文本图数据集上对LLMs进行微调,获取文本属性嵌入,然后利用这些嵌入增强GNN以执行各种下游任务。此外,一些研究探索使用LLMs来解决图的异质性和OOD问题。

另一方面,尽管LLM在各个领域取得了巨大成功,但它仍面临几个挑战,包括幻觉、实际意识缺乏和解释性不足。图,尤其是知识图谱,以结构化格式捕获大量高质量可靠的事实知识。因此,将图结构整合到LLMs中可以提高LLMs的推理能力并缓解这些限制。为此,已进行了一些努力,探索图在增强LLMs解释性和缓解幻觉方面的潜力。鉴于这一领域的迅速发展和巨大潜力,对LLMs时代图应用和图机器学习的最新进展进行全面回顾是必要的。

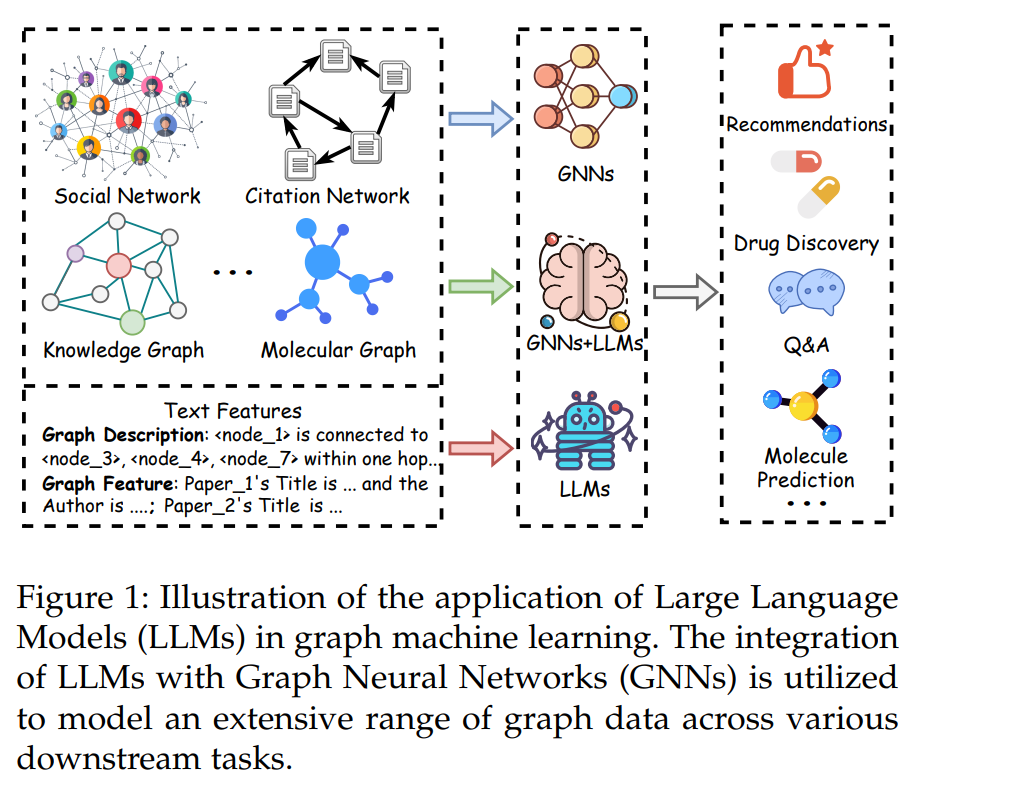

因此,在这篇综述中,我们旨在提供关于LLMs时代图机器学习的全面回顾。综述的大纲如图2所示:第二部分回顾与图机器学习和基础模型相关的工作。第三部分介绍了图上的深度学习方法,重点是各种GNN模型和自监督方法。随后,综述深入探讨了如何在第四部分使用LLMs来增强Graph ML,以及在第五部分如何采用图来增强LLMs。最后,第六部分和第七部分分别讨论了Graph ML在LLMs时代的一些应用和潜在的未来方向。我们的主要贡献可以总结如下:

我们详细描述了从早期图学习方法到LLMs时代最新的GFMs的演变; 我们提供了当前LLMs增强的Graph ML方法的全面分析,突出了它们的优势和局限,并提供了系统的分类; 我们彻底调查了图结构应对LLMs限制的潜力;

我们探索了Graph ML在LLMs时代的应用和未来方向,并讨论了各个领域的研究和实际应用。 与我们的综述同时进行的,Wei等人回顾了图学习的发展。Zhang等人提供了大型图模型的前瞻性回顾。Jin等人和Li等人分别回顾了在图上预训练语言模型(特别是LLMs)及其应用到不同类型的图的不同技术。Liu等人根据流程回顾了图基础模型。Mao等人关注基本原则,并讨论了GFMs的潜力。

与这些同时进行的综述不同,我们的综述提供了更全面的回顾,具有以下不同之处:(1)我们提供了关于Graph Machine Learning发展的更系统的回顾,并进一步探索了LLMs对Graph ML向GFMs的发展;(2)我们提出了LLMs时代Graph ML最新进展的更全面和细致的分类;(3)我们深入探讨了最近Graph ML的局限性,并提供了从LLMs的角度克服这些局限性的洞见;(4)我们进一步探讨了如何使用图来增强LLMs;(5)我们彻底总结了广泛的应用范围,并提出了对挑战和未来方向的更前瞻性讨论。

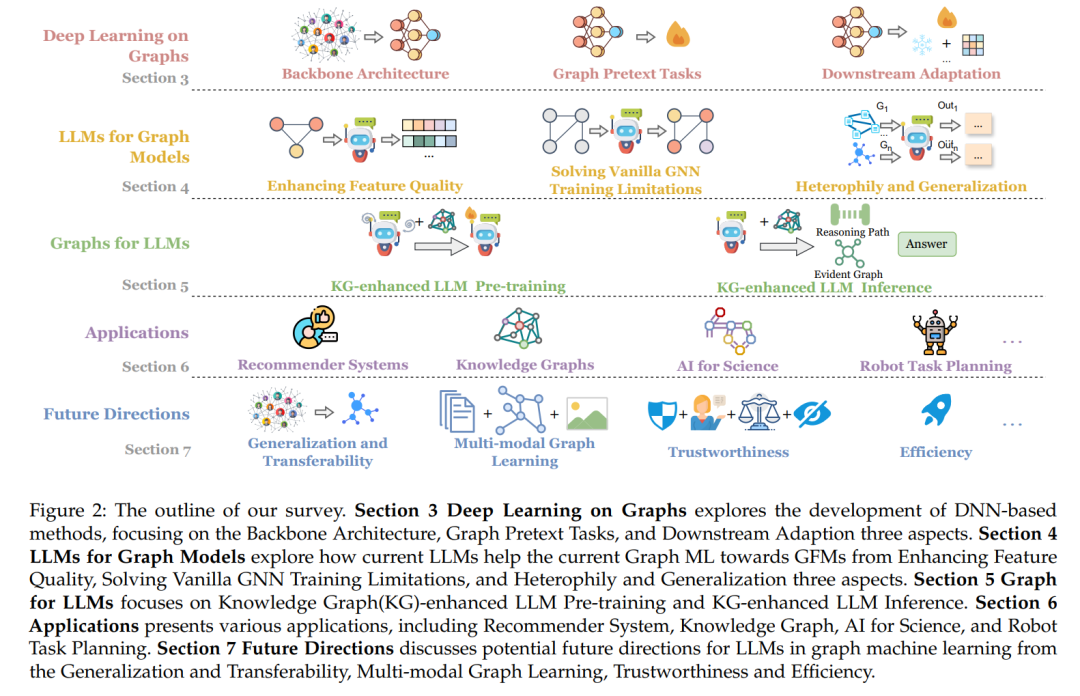

尽管具有巨大潜力,基于GNN的图机器学习(Graph ML)仍存在固有局限。首先,常规的GNN模型通常需要标记数据进行监督,获取这些注释可能在时间和成本上非常耗资源。其次,现实世界中的图往往包含丰富的文本信息,这对下游任务至关重要。然而,GNN通常依赖于浅层文本嵌入来提取语义,从而限制了它们捕捉复杂语义和文本特征的能力。此外,图的多样性为GNN模型在不同领域和任务中的泛化提出了挑战。最近,大语言模型(LLMs)在处理自然语言方面取得了显著成功,具有如下激动人心的特点:(1)进行零/少样本预测;(2)提供统一的特征空间。这些能力为解决图机器学习和图基础模型(GFMs)所面临的上述挑战提供了潜在的解决方案。因此,本节旨在研究当前LLMs能为提升图机器学习向GFMs的进展做出什么贡献,同时也审视它们当前的局限性,如图4所示。

大语言模型(LLMs)在各个领域展示了令人印象深刻的语言生成和理解能力。然而,它们仍面临几个迫切的挑战,包括事实性认知、幻觉、推理过程中的有限可解释性等问题。为了缓解这些问题,一种潜在的方法是利用知识图谱(KGs),知识图谱以结构化格式存储高质量、人工策划的事实知识。最近的综述[152]–[154]总结了使用KGs来增强语言模型(LMs)的研究。Hu等人[152]提供了关于知识增强的预训练语言模型用于自然语言理解和自然语言生成的综述。Agrawal等人[153]系统地回顾了通过利用KGs来减轻LLMs中的幻觉的研究,这些研究涵盖三个维度:推理过程、学习算法和答案验证。Pan等人[154]从三个不同的视角全面总结了KGs和LLMs的整合:KG增强的LLMs、LLM增强的KGs和双方相互加强的LLMs与KGs的协同作用。在本节中,我们将深入探讨相关研究,这些研究探索了使用KGs实现知识增强的语言模型预训练、减轻幻觉和提高推理可解释性的用途。

结论

在这项综述中,我们全面回顾了大语言模型(LLMs)时代图应用和图机器学习(Graph ML)的最新进展,这是图学习中的一个新兴领域。我们首先回顾了图机器学习的发展,然后深入探讨了各种LLMs增强图机器学习的方法。由于在各个领域的显著能力,LLMs有巨大的潜力推动图机器学习向图基础模型(GFMs)发展。我们进一步探索了用图增强LLMs,突出了它们在增强LLM预训练和推理方面的能力。此外,我们展示了它们在多样化应用中的潜力,如分子发现、知识图谱和推荐系统。尽管取得了成功,这个领域仍在发展中,呈现了许多进一步发展的机会。因此,我们进一步讨论了几个挑战和潜在的未来方向。总的来说,我们的综述旨在为研究人员和实践者提供一个系统和全面的回顾,激发对这一有前途领域的未来探索。