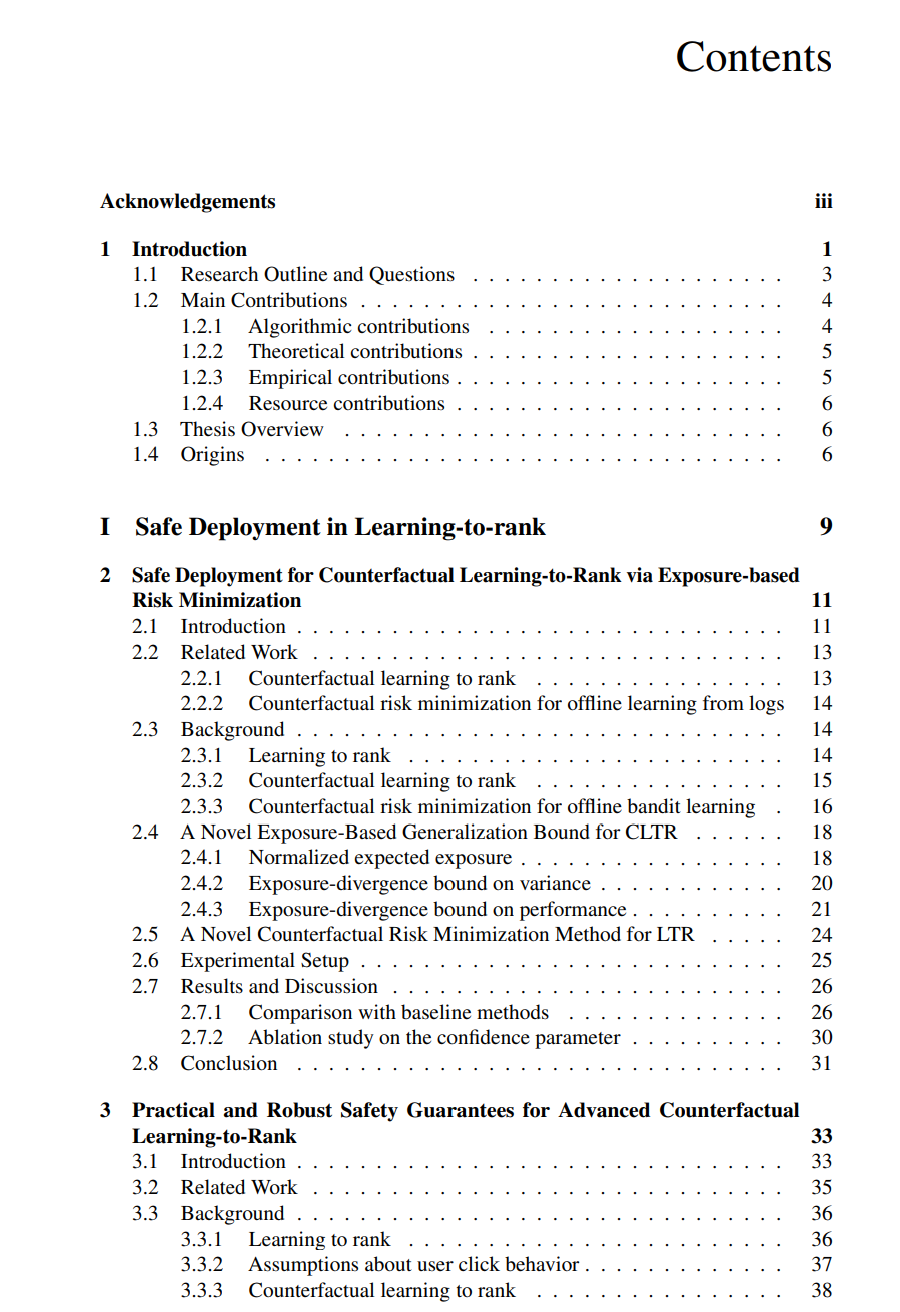

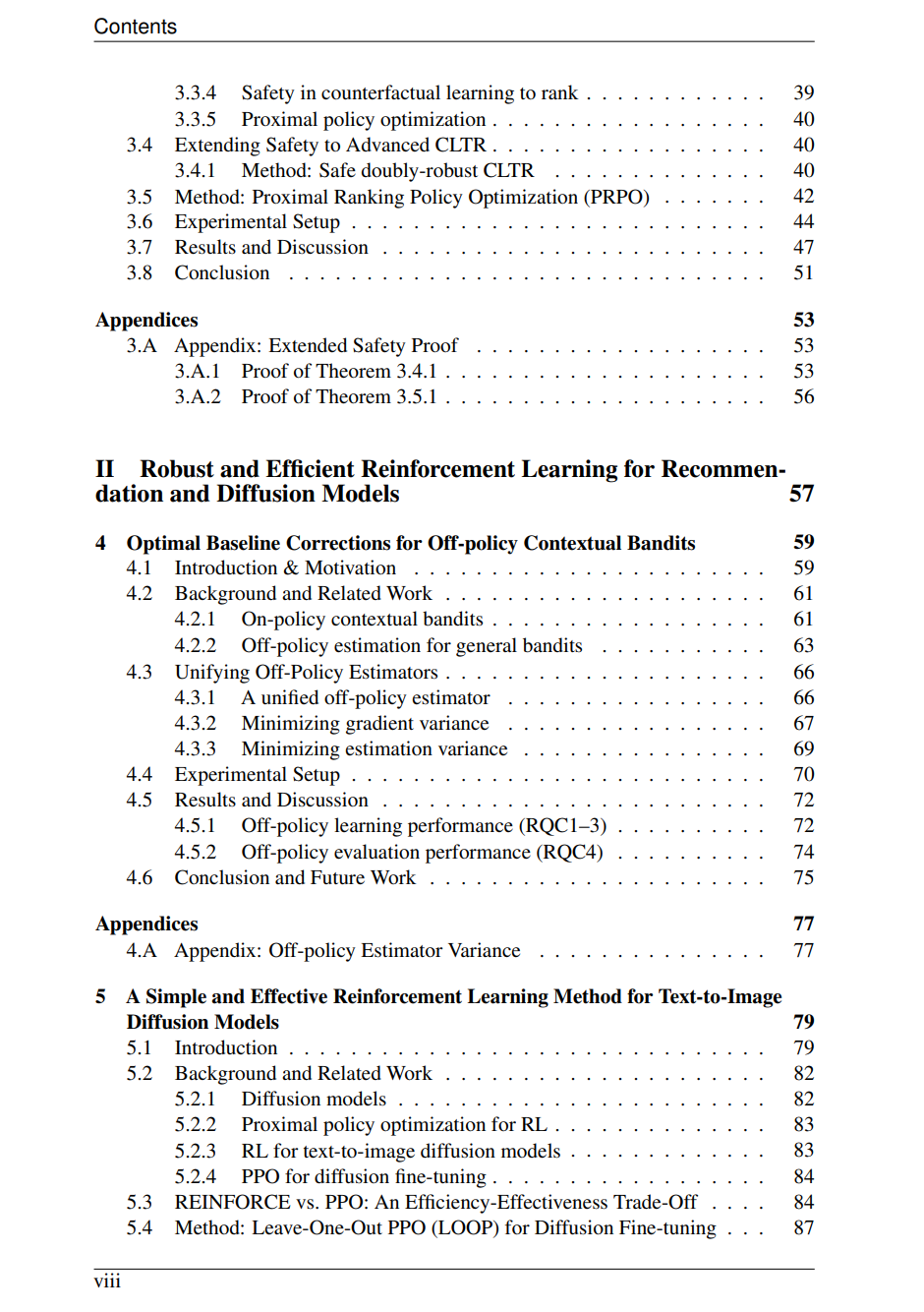

本论文研究如何设计安全(safe)、高效(sample-efficient)且鲁棒(robust)的强化学习(Reinforcement Learning, RL)方法。本文以情境多臂老虎机强化学习(contextual-bandit RL)为统一视角,聚焦于两个主要应用领域——排序与推荐(ranking and recommendation)以及文本到图像扩散模型(text-to-image diffusion models)。 论文的第一部分针对排序系统中的安全部署问题,发展了相关理论与算法。我们推导出一种基于曝光(exposure-based)的泛化界(generalisation bound),并由此得到一种反事实风险最小化(counterfactual risk minimisation)目标,其最优解在稀疏反馈条件下仍可保证性能不劣于日志策略(logging policy)。这一保证进一步扩展至双重鲁棒(doubly robust)估计器,即便在对抗性或模型设定错误的用户行为模型下,也能保持安全性,并为实践者提供对可接受效用损失的显式控制。 论文的第二部分研究单动作多臂老虎机(single-action bandits)问题,在其中我们统一了多种离线策略估计器(off-policy estimators),并提出了一个**基线修正(baseline correction)框架。我们推导出一种封闭形式的最优基线(closed-form optimal baseline),该基线可同时最小化评估方差与策略梯度方差,从而显著提升离线强化学习的可靠性(off-policy learning reliability)。 论文的最后一部分探讨了生成式强化学习(generative RL)中效率与效果之间的权衡。通过对 PPO 与 REINFORCE 的系统性研究,我们提出了Leave-One-Out PPO(LOOP)**算法。该方法在 PPO 的截断目标函数(clipped objective)中引入基于 REINFORCE 的基线,并结合多条扩散轨迹(multiple diffusion trajectories),实现了与 PPO 相当的采样效率(sample efficiency),同时生成结果在语义一致性与文本属性对齐(textual attribute alignment)方面表现更为优异。