生成高质量标注合成图像数据的能力,是构建和维护机器学习数据集的关键工具。然而,确保计算机生成数据质量达标极具挑战性。本报告旨在评估并改进"虚拟自主导航环境系统与环境传感器引擎"(VANE::ESE)生成的合成图像数据,同时记录为处理、分析VANE::ESE图像数据集并基于其训练模型所开发的全套工具集。研究还呈现多项实验结果,涵盖对可解释AI技术应用的探索,以及在不同合成数据集训练的多模型性能对比分析。

虚拟自主导航环境(VANE)是由软件工具与虚拟场景构成的自动驾驶建模与仿真系统集合。其环境传感器引擎组件(VANE::ESE)专用于在虚拟环境中高精度模拟车辆传感器物理特性(涵盖摄像头、激光雷达、毫米波雷达等)(Carrillo et al. 2020)。本报告聚焦评估、优化VANE::ESE仿真引擎在生成合成图像数据方面的性能——该类数据用于训练机器学习(ML)计算机视觉模型,以执行目标检测与图像分类任务。合成数据生成能力的核心价值体现在两方面:首先,因数据基于预设场景生成,可为每个图像样本实现自动标注,能零成本构建超大规模数据集;其次,可构建特定虚拟场景生成数据,有效覆盖现实采集难以企及的高危边界场景(例如战损建筑或车辆的图像数据)。快速生成特定场景的标注数据集对机器人与自主系统等广泛领域具有重要价值。

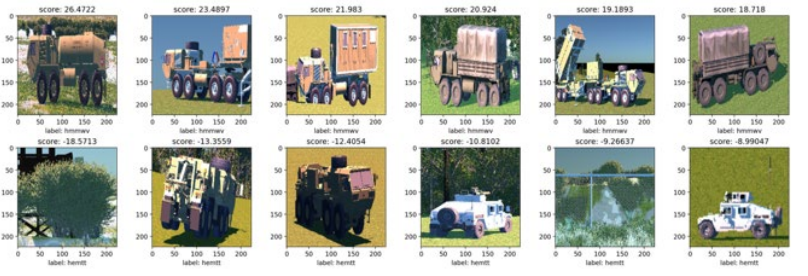

然而,利用合成数据训练ML模型仍面临双重挑战:其一,海量合成数据集存在标注准确性保障及多格式标签转换等通用问题;其二,弥合真实数据与合成数据之间的差异尤为困难。现有研究提出多种解决方案——包括通过全域自适应技术改进模型(Wang and Deng 2018)、采用生成对抗网络转换图像(Pfeiffer et al. 2019),以及直接提升仿真图像的视觉真实感。真实图像数据存在巨大差异(即便同类物体样本间亦如此),要在保留准确标注的前提下复现这种差异性与真实度极具挑战。本研究采用务实性操作路径优化VANE::ESE图像数据:接收生成数据集→运用本报告记录的多重方法与工具分析→向开发团队反馈优化建议→迭代提升后续数据集质量。

本工作的核心目标是提升VANE::ESE合成图像数据在目标检测与分类神经网络训练中的泛化能力,次要目标是开发并完整记录用于处理分析VANE::ESE数据集的软件工具集。