哈工大SCIR《自然语言处理:基于预训练模型的方法》一书出版

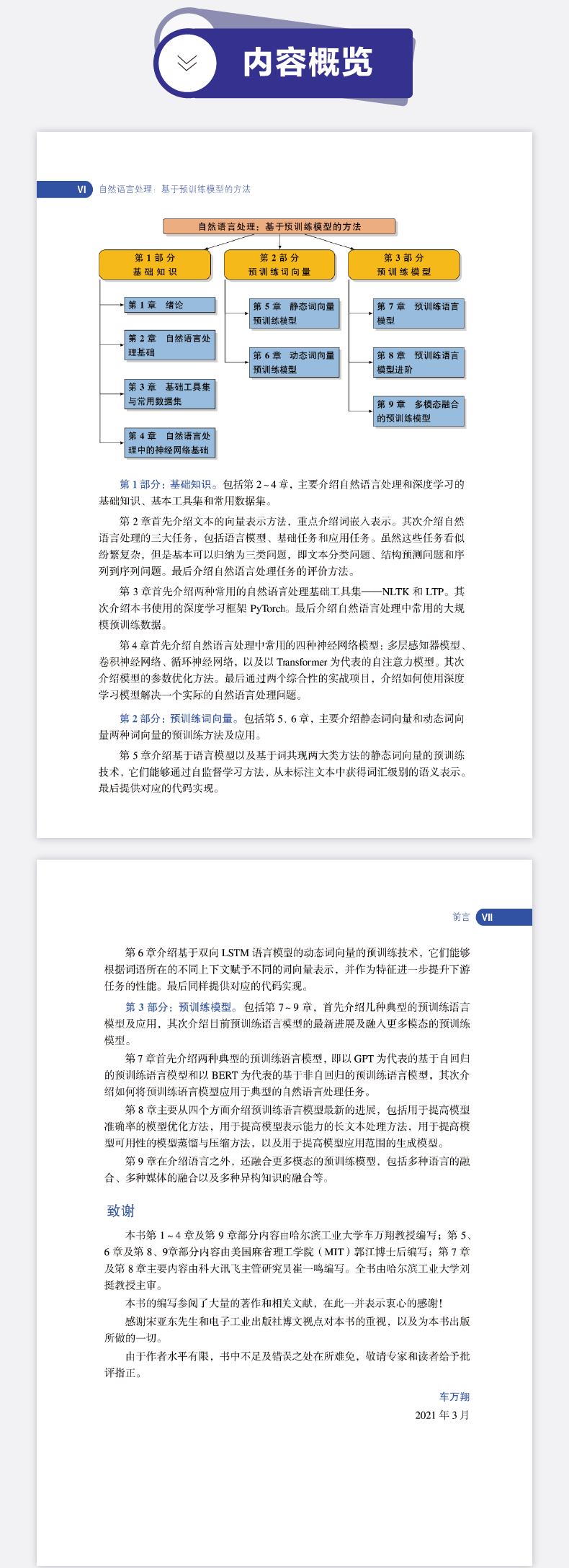

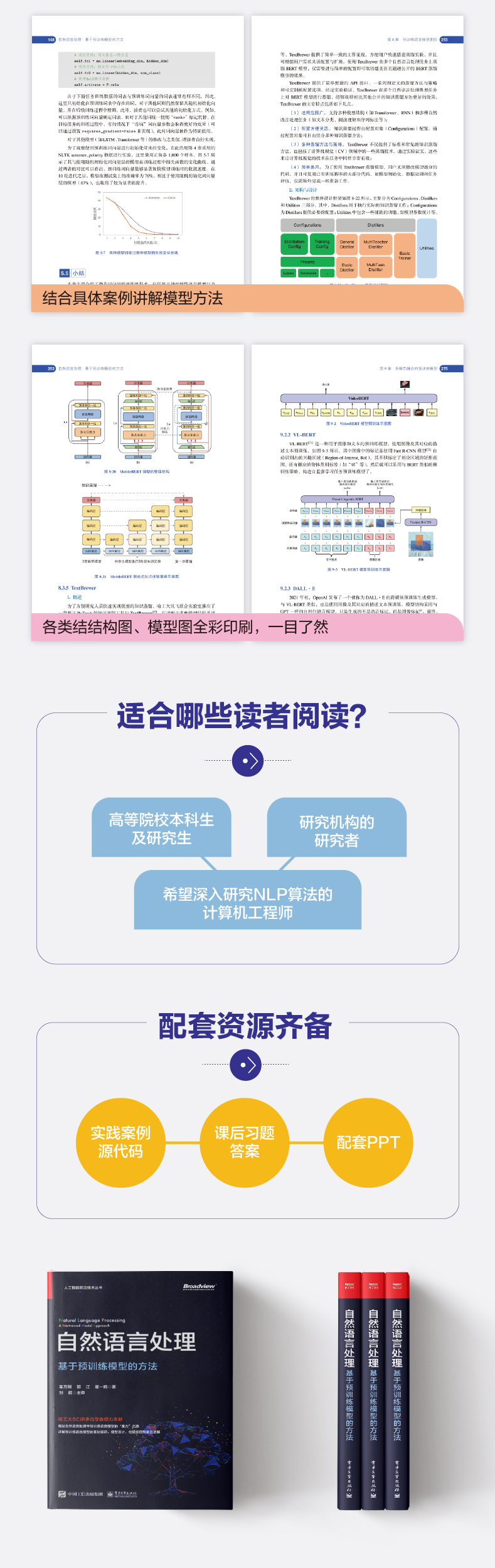

近些年来,以GPT、BERT为代表的预训练模型在自然语言处理领域掀起了一股浪潮,打开了“预训练+精调”的自然语言处理新范式的大门。由电子工业出版社博文视点出版的《自然语言处理:基于预训练模型的方法》一书,通过基础知识、预训练词向量以及预训练模型三大部分九个章节,详细介绍了预训练模型发展的来龙去脉,并通过示例代码进一步加深了读者对相关技术的理解与实践方式。

本书由哈工大社会计算与信息检索研究中心(SCIR)多位学者编写,由哈工大社会计算与信息检索研究中心(SCIR)副主任车万翔教授、麻省理工大学(MIT)计算机科学与人工智能实验室博士后研究员郭江博士、科大讯飞北京研究院副院长崔一鸣编著,由哈工大计算学部主任刘挺教授主审。本书既适合具有一定机器学习基础的高等院校学生、研究机构的研究者,以及希望深入研究自然语言处理算法的计算机工程师阅读,也适合对人工智能、深度学习和自然语言处理感兴趣的学生和希望进入人工智能应用领域的研究者参考。

本期责任编辑:刘 铭

登录查看更多

相关内容

专知会员服务

48+阅读 · 2019年10月21日