有奖征集 | TFLite 2 周年:活跃设备数量突破 30 亿台!

TFLite 2 岁了!在如此短的时间里,我们全力打造了这个用于海量应用,拥有数十亿活跃设备的产品。

让我们来一起回顾这两年:

TensorFlow World

TensorFlow Lite:在设备上运行 ML 的解决方案

https://v.youku.com/v_show/id_XNDQyNDk1MDM5MgTensorFlow 模型优化:量化与剪枝

https://v.youku.com/v_show/id_XNDQyNDk3NDg1Ng观看更多 TensorFlow World 视频

https://v.youku.com/v_show/id_XNDQyMDUyNzE4OA

TensorFlow Lite:从入门到精通

全程引领与会者学习构建用于数字识别(https://codelabs.developers.google.com/codelabs/digit-classifier-tflite) 的 Android 应用和用于手势预测的 Arduino 程序

tinyML 聚会

https://www.meetup.com/tinyML-Enabling-ultra-low-Power-ML-at-the-Edge/

TensorFlow World 版嵌入式机器学习开发者月度聚会

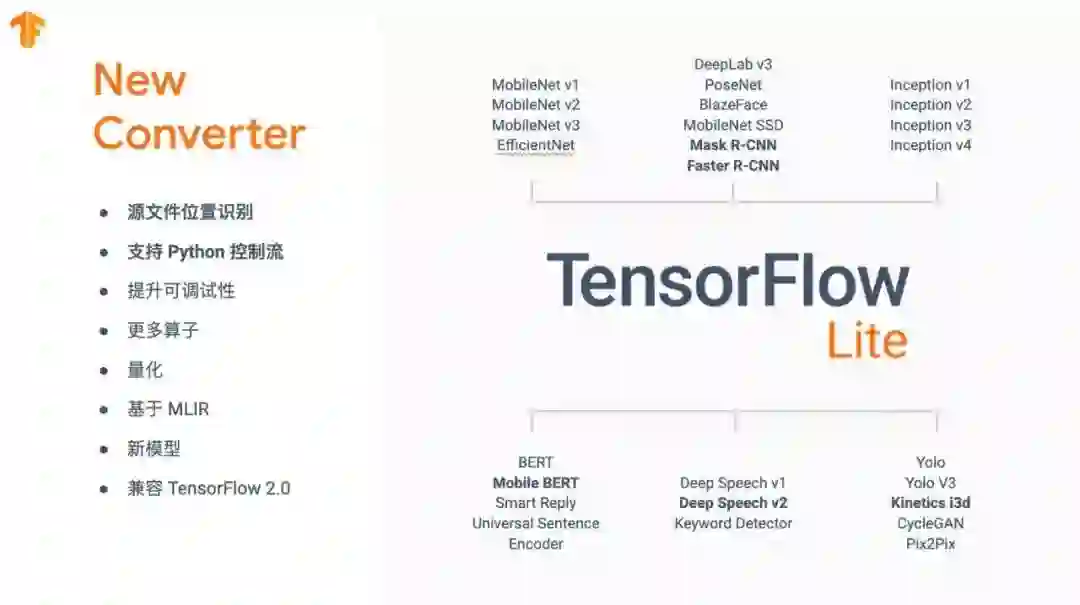

近期发布

阅读更多相关内容

https://groups.google.com/a/tensorflow.org/forum/#!topic/tflite/C7Ag0sUrLYg

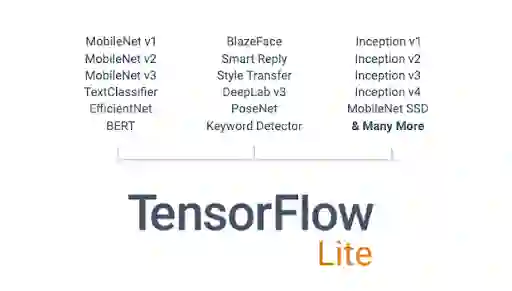

许多模型和示例应用均支持下载,并可立即应用至生产环境,例如风格迁移、智能回复、文本分类和常见问答等。查看

https://tensorflow.google.cn/lite/models/

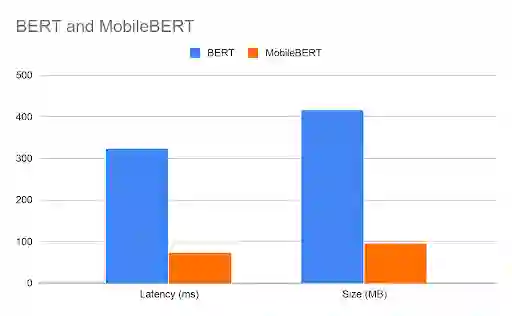

我们发布了一款问答应用,经移动优化的 BERT 加持,不断探索设备端部署 NLP 的新可能性。

比 BERT 更快速、更小巧

适用于所有手机

4.4x 加速(74 毫秒)

规模缩小 4 倍(不足 100 MB)

准确度相同

设备搭载 4 核 Pixel 4 - CPU,序列长度 128,词汇量 30000,测试时间 2019 年 10 月

了解更多相关内容:

https://tensorflow.google.cn/lite/models/bert_qa/overview

我们已发布 TFLite 模型自定义工具包,以便在部署设备上 ML 模型时,简化迁移学习和模型调整流程。了解更多请试用以下两个 Colab:

图像分类:

https://github.com/tensorflow/examples/blob/master/tensorflow_examples/lite/model_customization/demo/image_classification.ipynb文本分类:

https://github.com/tensorflow/examples/blob/master/tensorflow_examples/lite/model_customization/demo/text_classification.ipynb

更多相关内容请阅读:

https://github.com/tensorflow/examples/tree/master/tensorflow_examples/lite/model_customization

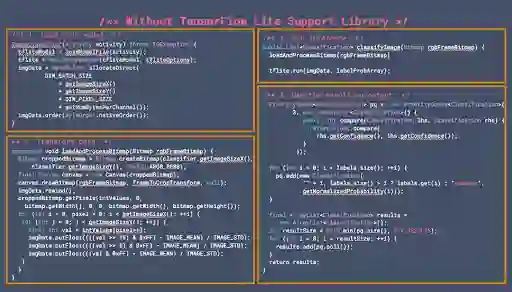

我们正在努力让 ML 模型推理的数据预处理和转换变得更加简单。例如,在使用新版支持库进行图像分类时,您可以利用便捷的图像实用工具(例如图像大小调整或裁剪)来大大缩减代码内容。

新版支持库

https://github.com/tensorflow/examples/blob/master/lite/examples/image_classification/android/EXPLORE_THE_CODE.md

阅读更多相关内容:

https://github.com/tensorflow/tensorflow/blob/master/tensorflow/lite/experimental/support/java/README.md

在不久的将来,您可以使用 TFLite Support Codegen 工具来进一步简化将模型部署到移动设备上的过程。该工具会自动生成带有高级 API 的模型包装器,如下所示:

我们还在 Udacity 中,上线了新的学习资源,参与免费课程,一起学习 TFLite~

TFLite 入手指南

https://www.udacity.com/course/intro-to-tensorflow-lite--ud190

可助 ARM 架构下的 x86 CPU 获得 30% 到 300% 的性能加速

提升了采用 OpenCL 的 GPU 的加速性能

支持 Android Q NNAPI 的新算子和功能

将搭载 Qualcomm 数字信号处理器 (DSP) 的中低端设备上的模型加速进行量化

用于发掘最佳性能的新基准和性能工具

大幅缩短高中低端设备和模型的延迟时间。仅需将最新版 TensorFlow Lite 部署至您的应用,无须作任何更改,即可享受上述性能提升。

您无需采取任何操作,只需使用最新版 TFLite 库。

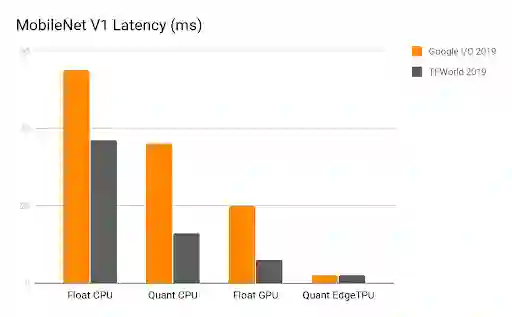

MobileNetV1 的延迟时间(以毫秒为单位)

即将推出

更多算子和支持模型

性能提升(CPU、GPU 和 TPU 等)

TF Hub 集成

设备端训练和个性化内容

自动化性能探索工具

TFLite 支持库

iOS 和 CoreML 支持

更优质的文档

联系信息

如有疑问,请联系 tflite@tensorflow.org。

#今日话题#

#我用 TensorFlow …#

在本文末留言,分享你

使用 TensorFlow 的场景,做出产品/实验的方向

向小伙伴们展示 TensorFlow 还有哪些奇思妙想的应用

幸运的小伙伴将有机会得到 TensorFlow 帆布包一个

并且~ 点赞最高的一位小伙伴将得到

TensorFlow 定制 Tee 一件

** 小编将从留言中随机选取 5 位小伙伴赠送帆布包

截止时间:2019/12/25 17:00