![]()

随着各界对 AI 伦理的日益重视,AI 系统的可解释性也逐渐成为热点,甚至上升到立法和监管的要求。许多人工智能领域的专家都把 2021 年视为“AI 可解释元年”,在这一年,不仅政府出台相应的监管要求,国内外许多科技公司,譬如谷歌、微软、IBM、美团、微博、腾讯等,也都推出了相应的举措。

在这一背景下,腾讯研究院、腾讯天衍实验室、腾讯优图实验室、腾讯 AI Lab 等组成的跨学科研究团队,历时近一年,完成业内首份

《可解释AI发展报告 2022——打开算法黑箱的理念与实践》

,全面梳理可解释AI的概念、监管政策、发展趋势、行业实践,并提出未来发展建议。

在 1 月 11 日线上举办的腾讯科技向善创新周“透明可解释 AI 论坛”上,由腾讯研究院秘书长张钦坤、腾讯优图实验室人脸技术负责人丁守鸿进行了发布。

学界和业界专家普遍认为,《可解释AI发展报告 2022》非常必要,也非常及时。这份报告开了个好头,推动人工智能向着可解释这个极为重要的方向发展。

“可解释AI是一个庞杂的领域,这份报告起了一个非常好的头,在这个基础上需要开展长期的研究。现在的各种算法还无法在效率和可解释性两方面都达到很高要求,需要根据不同需求进行取舍。而且AI的可解释性是一个长期的问题,不会很快就有一个通用的可解释框架,可以在一些比较重要的领域先行探索解决方法,指明未来的发展方向。”

微众银行首席人工智能官 杨强

“可解释AI、透明AI是现阶段非常迫切需要解决的问题,这份报告在国内率先走出这一步,是开创性的,意义和价值非常重要。未来这个领域的进一步探讨,需要不同学科、不同领域的学者都能参与进来,哲学和科技哲学对于解释有将近一百年的探索和积累,未来可以提供很多借鉴。”

“这份报告非常及时,全面反映了各方面专家的意见。不同人群、不同应用场景对AI算法的可解释性期待是不一样的,不应搞一刀切,将一个统一的标准适用于所有情形。在深度学习普遍缺乏可解释性的情况下,透明度就显得尤其重要,需要适当披露AI算法的相关信息。”

“对AI系统落地来说透明性和可解释性是必不可少的,研究前景非常好;但AI的透明性、可解释性和性能之间存在固有的矛盾,一个可能的方向是根据不同的场景、可解释的目的,寻找不同的折中方案,以此促进AI技术的落地。 ”

“本报告阐述了腾讯在AI技术研发和实践过程中的对于可解释AI的最新思考,是践行腾讯倡导的AI向善、科技向善发展理念的重要举措。报告从多个维度展现了可解释AI的发展现状和未来趋势,并提出了切实可行的建议,对于AI研究与工程人员、监管方和使用者都将具有很高的参考价值。”

“AI系统的说明书路径需要考虑商业秘密的保护,比较好的方式是针对可解释性、鲁棒性、准确性、隐私保护、公平性等方面建立量化标准,并进行测评,形成AI系统的说明书,从而让使用者可以清晰直观地知道AI系统是否满足可信的要求。未来,可信AI以及可解释性等方面需要各个学科、领域的人一起合作,共同推进这个领域的发展。”

https://docs.qq.com/pdf/DSmVSRHhBeFd0b3Zu

目前人工智能已经成为了通用型技术,以深度学习为代表的机器学习加速渗透到各行各业,产生了非常丰富的应用。作为引领 AI 技术加速变革的重要法宝,机器学习是一把双刃剑。

一方面,以深度学习为主要技术模型的机器学习可以帮助 AI 摆脱对人为干预和设计的依赖,形成 AI 的自主学习、自我创造以及自动迭代机制,使得 AI 在学习思维上无限接近于人类大脑。

另一方面,机器学习又日益暴露出 AI 在自动化决策

(Automated decision-making)

中无可回避的难解释性和黑箱性。基于人工神经网络结构的复杂层级,在AI深度学习模型的输入数据和输出结果之间,存在着人们无法洞悉的“黑盒”,即使是专家用户也无法完全理解这些“黑盒”。

因此,可解释AI便应运而生,可解释AI可以分为全局可解释

(使公众理解算法模型本身)

和局部可解释

(使公众理解算法模型的输出结果)

。如果不解决这两个问题,不仅影响到用户对 AI 应用的信任,而且也可能会带来算法歧视、算法安全和算法责任等方面的相关问题。

在这样的背景下,可解释 AI 成为 AI 伦理甚至是立法、监管的必选项。从 2017 年的 IEEE 的《人工智能设计的伦理准则》,到 2019 年 4 月欧盟的《可信 AI 伦理指南》,再到 2020 年 11 月美国的《人工智能应用监管指南》,再到中国 2021 年 9 月的《新一代人工智能伦理规范》,以及 2021 年联合国的《人工智能伦理问题建议书》,其中都在强调可解释性和透明性的问题。

我国的《个人信息保护法》、网信办等九部委出台的《关于加强互联网信息服务算法综合治理的指导意见》、以及《互联网信息服务算法推荐管理规定

(征求意见稿)

》等相关立法也开始对人工智能算法应用的透明度和可解释性提出要求。

在此背景下,可解释 AI 也成为了各大主流科技公司研究的新兴领域,学术界与产业界等纷纷探索理解 AI 系统行为的方法和工具。目前各主流科技公司对可解释 AI 的探索实践主要有两大路径,路径一是建立“模型说明书”标准,促进算法模型本身的透明度和可理解,第二种路径则是打造可解释性工具,推动构建可解释的 AI 模型

(XAI)

。

路径一旨在促进模型的透明度,增加相关主体对模型的理解和信任。

譬如,谷歌的模型卡片机制

(model cards)

,对模型的输入、输出、模型架构、性能、局限性等进行描述,旨在以简明、易懂的方式让人们看懂并理解算法的运作过程。再如,IBM的AI事实清单机制

(AI fact sheets)

,旨在提供与 AI 模型或服务的创建和部署有关的信息,包括目的、预期用途、训练数据、模型信息、输入和输出、性能指标、偏见、鲁棒性、领域转移、最佳条件、不良条件、解释、联系信息等。

国内互联网行业也开始采取类似做法,促进算法模型的透明度,如 2021 年,美团两次发文阐释其外卖配送算法的相关规则,促进其算法的透明度;同年 8 月,微博也首次公开其热搜的算法规则。这些实践都是从受众的角度出发,增强用户对人工智能系统的理解与信任。腾讯也致力于推动人脸识别、医疗 AI 应用的可解释性,构建负责任、可信的 AI 算法应用。

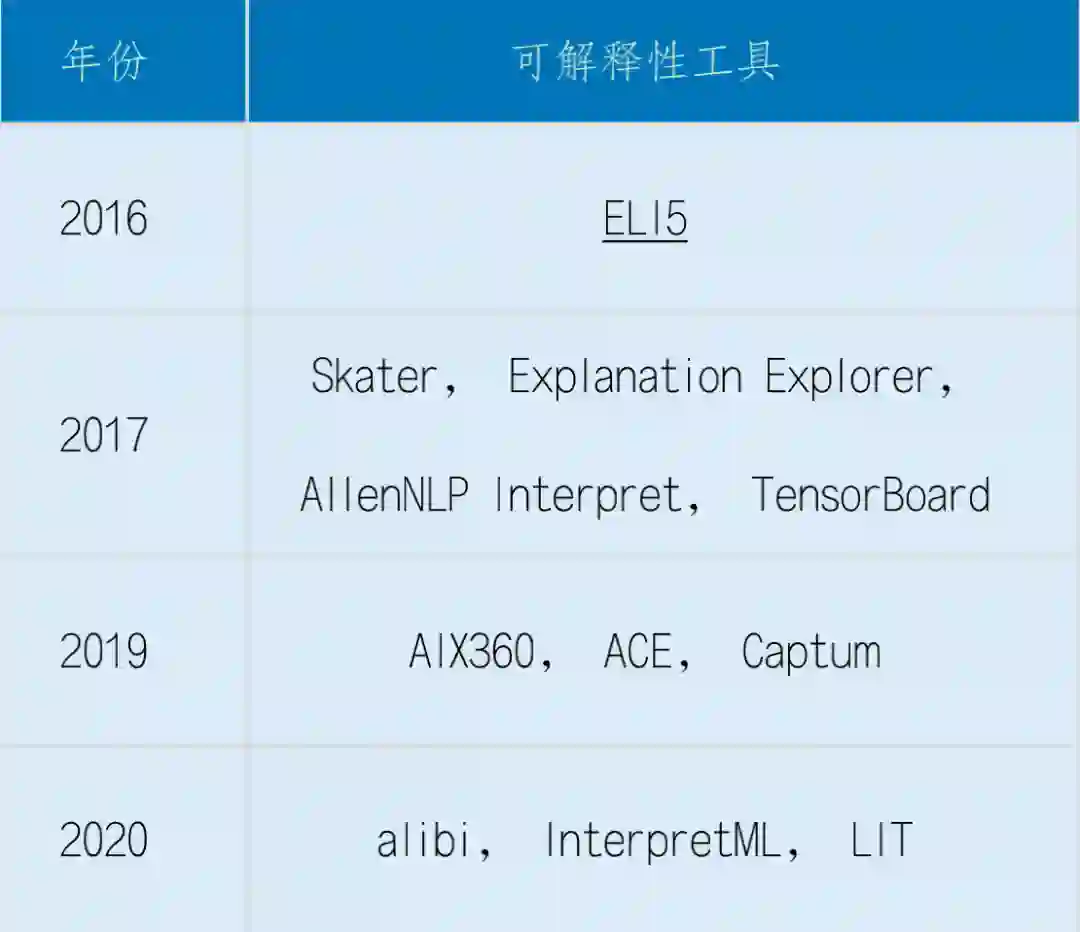

路径二主要是可解释性工具、可解释模型方面的研究,从技术层面解决可解释性的问题。

随着可信 AI 和 AI 监管日益得到重视,行业更加重视可解释 AI 研究,寻求解决 AI 的可解释性问题的技术方案。越来越多的可解释性工具被发布出来,可以对不同的统计机器学习模型和深度学习模型进行解释,包括一般的泛线性模型、集成学习模型、图像识别模型以及自然语言处理模型等。

近年来头部的人工智能公司,包括微软、谷歌等,更是推出了更加强大与丰富的可解释性工具,囊括了诸多可诠释

(Interpretable)

方法与可解释

(Explainable)

方法,为实际面临的可解释性问题的解决提供了巨大的帮助。

![]()

透明性与可解释性,连同公平性评价、安全考虑、人类 AI 协作、责任框架,都是 AI 领域的基本问题。我们需要找到一个平衡的可解释 AI 的路径,来打造可信、负责任 AI,确保科技向善。具体来说,在设计可解释性要求时,需要考虑可解释性要求和其他重要的伦理价值和目的

(诸如公平、安全、隐私、网络安全等)

之间的平衡。因为可解释性本身不是目的,而是实现其他目的的手段。所以在设计可解释性要求时,首先需要考虑想要实现什么目标,其次需要思考在特定情境下如何更好地匹配这些目标。

第一,立法和监管宜遵循基于风险的分级分类分场景治理思路,在鼓励科技创新、追求科技向善、维护社会公共利益之间找到平衡点

。首先,披露 AI 算法模型的源代码是无效的方式,不仅无助于对 AI 算法模型的理解,反倒可能威胁数据隐私、商业秘密以及技术安全;其次,不宜不加区分应用场景与时空场合地要求对所有的算法决策结果进行解释;再次,侧重应用过程中的披露义务;最后,避免强制要求披露用来训练AI模型的数据集,这不仅不具有可操作性,而且容易与版权保护冲突,侵犯用户的数据隐私或违反合同义务。

第二,探索建立适应不同行业与场景的可解释性标准。

具体可以从三个方面来着手:一是针对 AI 系统的一些示范性应用场景提供可解释性标准的指南,给行业和企业带来有益参考;二是发布 AI 可解释最佳实践做法案例集、负面做法都是值得尝试的,包括用以提供解释的有效的用户界面,面向专家和审计人员的记录机制(例如详细的性能特征,潜在用途,系统局限性等);三是创建一个说明不同级别的可解释性的图谱,这个图谱可被用来给不同行业与应用场景提供最小可接受的衡量标准。

第三,探索可解释的替代性机制,多举措共同实现可信、负责任 AI。

虽然可解释性是完善 AI 技术的最优解之一,但并非所有的AI系统及其决策都可以解释。当 AI 系统过于复杂,导致难以满足可解释性要求,或是导致解释机制失灵、效果不乐观时,就要积极转变规制的思路,探索更多元化、实用化的技术路径。目前在技术上主张的是采取适当的替代性机制,如第三方标记反馈、用户申诉和人工审查、常规监测、审计等,这些替代性机制可以对 AI 算法的决策起到监督和保障作用。

第四,增强算法伦理素养,探索人机协同的智能范式。

开发者和使用者是 AI 生态的核心参与者,需要提升他们的算法伦理素养。一方面,加强科技伦理教育,提升 AI 从业人员的算法伦理素养;另一方面,通过教育、新闻报道、揭秘等方式提高公众的算法素养,构建和谐的人机协同关系。

最后,引导、支持行业加强可解释 AI 研究与落地。

由于 AI 技术的快速发展迭代,可解释 AI 的工作应主要由企业与行业主导,采取自愿性机制而非强制性认证。因为市场力量

(market force)

会激励可解释性与可复制性,会驱动可解释 AI 的发展进步。企业为维持自身的市场竞争力,会主动提高其 AI 相关产品服务的可解释程度。

长远来看,政府、社会、企业、行业、科研机构、用户等主体需要共同探索科学合理的可解释 AI 落地方案及相关的保障与防护机制,推动科技向善。

研究顾问:

司 晓 吳文達 郑冶枫 吴运声 张正友

研究策划:

张钦坤 周政华

写作团队:

腾讯研究院:曹建峰 王焕超

腾讯天衍实验室:魏东 黄予 张先礼 孙旭

腾讯优图实验室:丁守鸿 尹邦杰 陈超 黄余格

厦门大学:詹好

研究支持团队:

马锴 李博 王强 赵子飞 李南 刘金松 吴保元 卞亚涛 吴秉哲 黄俊 陈瑶 田小军 朱开鑫 胡锦浩 梁竹

研究联系:

腾讯研究院 曹建峰(邮箱:jeffcao@tencent.com)

![]()