大会 | AAAI 2018论文:视频语义理解的类脑智能

AI 科技评论按:近日,美图云视觉技术部门与中科院自动化所共同合作研发,提出一种基于类脑智能的无监督的视频特征学习和行为识别的方法 NOASSOM (Hierarchical Nonlinear Orthogonal Adaptive-Subspace Self-Organizing Map based Feature Extraction for Human Action Recognition),该方法不依赖于标签信息,可以自适应地、无监督地学到视频的特征表示,相关成果已发表在 AAAI 2018 上,并以 oral 的形式在大会上进行了报告。

视频语义理解一直是学术界的研究热点之一。近两年随着短视频领域的火爆发展,围绕短视频的业务场景应用也在增长,工业界应用场景都对视频内容理解提出了迫切的落地需求。与学术界用的确定性数据集不同,工业界业务产生的视频数据具有如下特点:首先,数据量大,每天都会有成千上百万的视频被上传;其次,内容未知,现实生活中的场景是很复杂的,尤其对于 UGC 内容,无法确定用户上传的视频中的主体和场景,行为更是无法预测;再次,时效性,在不同的时间段内视频的主题、场景以及行为是不同的,它可能会随着时间发生变化进行转移。因此,在这样的数据集上人工建立标签体系非常困难。NOASSOM 算法的提出有效解决了算法模型在训练过程中无标签输入的问题。

NOASSOM 是通过模拟视觉皮层中表面区域的结构来构建的,以数据驱动自组织更新,恢复基本视觉皮层中的神经元对输入刺激的反应。NOASSOM 是对 ASSOM 方法的改进。ASSOM 是一种特征提取方法,它可以从输入数据中学习统计模式,并对学到的模式进行自组织排列,从而进行特征表示。但是 ASSOM 只能处理有标签的数据,并且只对线性化的数据有效,无法胜任其他复杂情形。NOASSOM 的提出解决了 ASSOM 的这两个重要问题。首先,NOASSOM 通过引入一个非线性正交映射层,处理非线性的输入数据,并使用核函数来避免定义该映射的具体形式。其次,通过修改 ASSOM 的损失函数,使输入数据的每个样本可以独立地贡献于损失函数,而不需要标签信息。这样,NOASSOM 可以有效地、无监督地学习数据的统计模式和本征表示。图 1 示意了 NOASSOM 与 ASSOM 的网络结构区别。

图 1 NOASSOM 与 ASSOM 网络结构

ASSOM 由输入层、子空间层、输出层组成。NOASSOM 比 ASSOM 增加一个非线性正交映射层,用于实现输入层和子空间层的非线性正交映射。为保证映射后的子空间基向量仍然保持正交性,NOASSOM 采用正交约束的核函数:

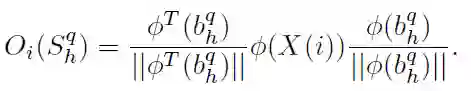

输出层使用输入在子空间的投影表示:

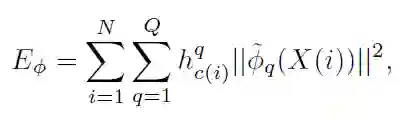

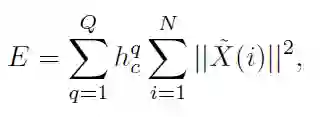

使用投影残差构建损失函数:

原始的 ASSOM 的损失函数表示如下:

通过修改损失函数使每个样本独立地贡献于损失函数,而不必使用 Class-specific 的数据进行有监督训练。NOASSOM 使用随机梯度下降法对网络进行训练。

在每次迭代之后,重新对基向量进行正交化处理。算法流程图如下:

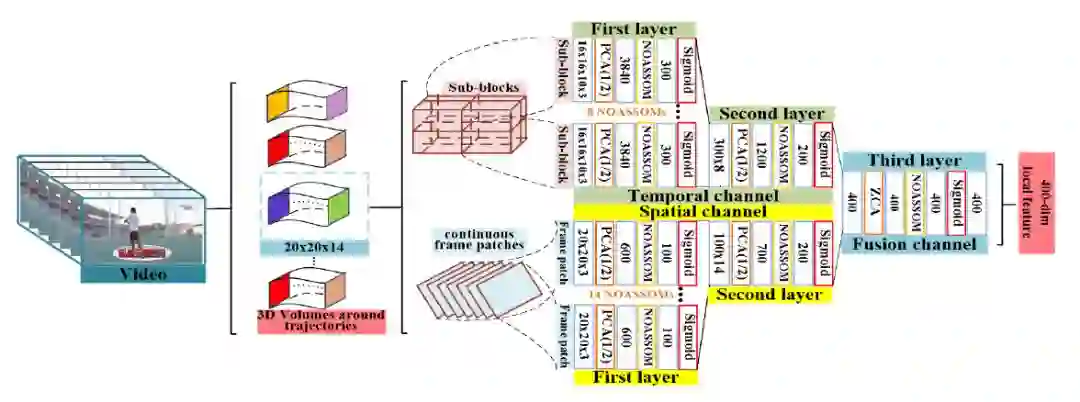

NOASSOM 论文进一步还提出一个层级的 NOASSOM 来提取高层的抽象特征,有效地描述视频中行为轨迹的表观和运动信息,构建了一个层级的 NOASSOM 结构提取视频中的局部行为特征,并使用 FISHER VECTOR 进行聚合编码,采用 SVM 进行分类,如图 2 所示。

图 2 层级 NOASSOM 特征提取框架

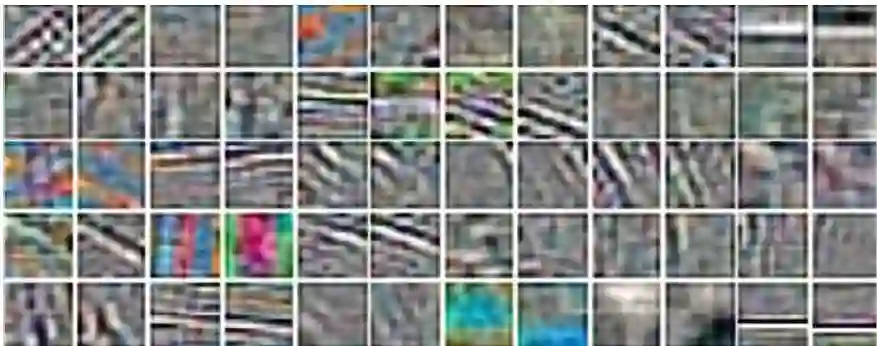

训练得到的基向量的可视化结果如图 3 所示,左边是表观信息滤波器,右边是运动信息滤波器。可以看出表观信息滤波器可以学到一些类似边缘检测的滤波器,这样类型的滤波器对图像的水平边沿和垂直边沿能进行检测,从而提取良好的轮廓纹理信息。右边的运动信息滤波器学到了一些类似 Gabor 滤波器的滤波器,这样的滤波器对运动信息更加敏感,实现对运动信息进行良好的提取。

图 3 NOASSOM 中基向量的可视化结果

NOASSOM 中训练得到的基向量的可视化结果如图 2 所示,左边是表观信息滤波器,右边是运动信息滤波器。可以看出表观信息滤波器可以学到一些类似边缘检测的滤波器,这样类型的滤波器能对图像的水平边沿和垂直边沿进行检测,从而提取良好的轮廓纹理信息。右边的运动信息滤波器学到了一些类似 Gabor 滤波器学到的信息,这样的滤波器对运动信息更加敏感,实现对运动信息地鲁棒性提取。

NOASSOM 在国际公开大型数据集 UCF101, HMDB51 和小型数据集 KTH 上进行了评测,获得了 93.8%,69.3% 和 98.2% 的识别率。在 UCF101 和 HMDB51 上,分别超出使用手工特征的 iDt+HSV 基准方法 5.9% 和 8.2%,并且分别超出使用卷积神经网络模型的 iDt+CNN 方法 2.3% 和 3.4%,在 KTH 上超过 iDT+MBH 的基准方法 3.2% 以及基于 3D CNN 的方法 8.0%。公开数据集上的实验结果表明,这种方法优于之前基于手工特征的方法和大多基于深度特征的方法。此外,在小数据库上,性能更加优于基于 CNN 的方法。更多的技术细节和实验结果请参考原始论文。

NOASSOM 方法的独特优势在于,可以从大量没有标签的数据进行更加快速的训练,并且获得和其他基于有标签数据方法性能相当甚至更加优越的性能。基于这项技术的输出将被应用于美拍短视频多个业务场景中,如相似视频的推荐和大规模视频检索,基于短视频内容的用户聚类和画像,以及基于短视频内容的运营标签挖掘等等。

附:

美图云视觉技术部门,专注于文本、图像和视频等领域的视觉算法研发和平台构建。部门主导研发的 AI 视觉分析平台 DeepNet,提供检测、分类、语义理解、哈希、OCR 等多个方向的技术支撑,正在为美图各产品和业务,如美拍短视频运营、商业化广告、推荐业务、搜索业务和安全审核等提供算法支撑。视觉部门长期招纳视觉领域相关人才,方向不限,有意者请发简历至 lili.zhao@meitu.com

对了,我们招人了,了解一下?

三大模块,五大应用,知识点全覆盖;海外博士讲师,丰富项目分享经验;

理论+实践,带你实战典型行业应用;专业答疑社群,结交志同道合伙伴。

点击阅读原文或扫码立即参团~

┏(^0^)┛欢迎分享,明天见!