微软亚洲研究院多模态模型NÜWA:以自然语言创造视觉内容

(本文阅读时间:12分钟)

人类对于信息的感知有五种途径,包括视觉、听觉、嗅觉、触觉和味觉,其中视觉是接受信息的最主要渠道,也是创造力的源泉。在推动人工智能发展的道路上,计算机视觉已经成为一个重要的研究领域,尤其是近几年视觉创作类应用的频繁涌现,让创作变得越来越便捷,越来越多的用户可以用这些工具制作和分享身边的美好生活。与此同时,视觉类应用的广泛使用也促进了计算机视觉领域的研究。

然而,尽管这些工具功能强大,但仍有不足之处:其一,它们需要创作者手动收集和处理视觉素材,导致现有的大规模视觉数据中所包含的视觉知识无法自动地有效利用。其二,这些工具往往是通过图形界面与创作者交互,并非自然语言指令,因此对于一些用户来说,具有一定的技术门槛,他们需要拥有丰富的使用经验。在微软亚洲研究院看来,下一代可视化内容创建工具应该能够利用大数据、AI 模型帮助用户更便捷地进行内容创作,并使用自然语言作为更加友好的交互界面。

在这样的理念下,微软亚洲研究院在视频生成预训练模型的基础上进行再创新,开发了多模态的 NÜWA(Neural visUal World creAtion)模型。通过自然语言指令,NÜWA 可以实现文本、图像、视频之间的生成、转换和编辑,帮助视觉内容创作者降低技术门槛,提高创造力。同时,开发者也可以利用 NÜWA 构建基于 AI 的视觉内容创造平台。(点击阅读原文,查看 NÜWA 论文原文)

NÜWA 目前支持八大视觉生成和编辑任务。其中,支持图像的四类任务包括:文本到图像,草图到图像,图像补全,图像编辑;支持视频的四类任务包括:文本到视频,视频草图到视频,视频预测,视频编辑。

下面,让我们以 Windows 经典桌面为例,试一下 NÜWA 的几个功能。(更多 NÜWA 在八大任务中的效果,请见文末。)

给定一张原始图片:

让 NÜWA 将图片补全为256x256(图像补全):

让 NÜWA 在图片的红框位置处添加“一匹在草地上行走的马”(图像编辑):

让 NÜWA 将这张图片生成为一个能“动”起来的视频(视频预测):

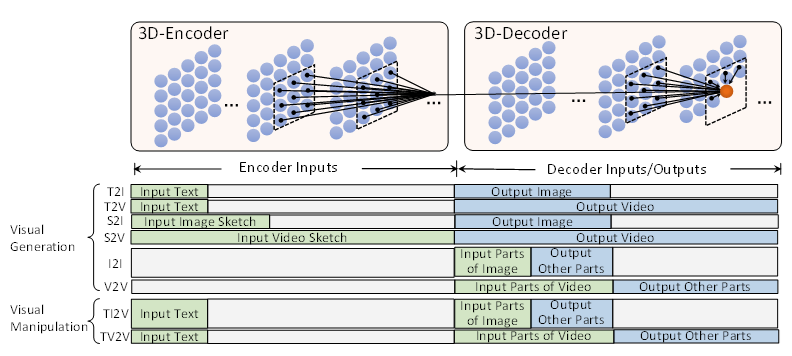

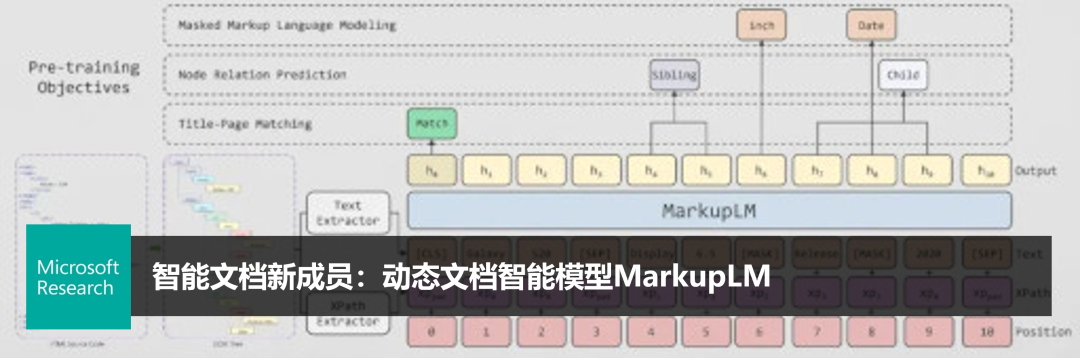

NÜWA 模型提出了一种全新的 3D 编码器-解码器框架。编码器可以支持包括文本、图像、视频,或者草图等多种不同的输入条件,甚至是部分图片或部分视频,让模型补全后续的视频帧;解码器则将这些输入条件转换为离散的视觉标记,根据训练数据输出图像、视频内容。

在预训练阶段,研究员使用了自回归模型作为预训练任务来训练 NÜWA,其中 VQ-GAN 编码器将图像和视频转换为相应的视觉标记,作为预训练数据的一部分。在推理阶段,VQ-GAN 解码器会基于预测的离散视觉标记重建图像或视频。

NÜWA 还引入了三维稀疏注意力(3D Nearby Attention,3DNA)机制来应对 3D 数据的特性,可同时支持编码器和解码器的稀疏关注。也就是说,在生成特定图像的一部分或者一个视频帧时,NÜWA 不仅会看到已经生成的历史信息,还会关注与其条件所对应位置的信息,比如,在由视频草图生成视频的过程中,生成第二帧时,模型就会考虑第二帧草图对应的位置是什么,然后按照草图的变化生成满足草图变化的视频,这就是编码器和解码器的同时稀疏。而此前的工作通常只是一维或二维的稀疏关注,而且只在编码器稀疏,或只在解码器稀疏。通过使用 3DNA 机制,NÜWA 的计算复杂度得到了简化,提升了计算效率。

图1:NÜWA 基于 3D 编码-解码架构

为了支持文本、图片、视频这些多模态任务的创建,跨越不同领域数据的鸿沟,研究员采用了逐步训练的方式,在预训练中使用不同类型的训练数据。首先训练文本-图片任务和图片-视频任务,待任务稳定后,再加入文本-视频的数据进行联合训练,而且研究员们还使用了视频完成任务,根据给定的部分视频作为输入生成后续视频,使得 NÜWA 拥有强大的零样本视觉内容生成与编辑能力,实现图像、视频内容的增、删、改操作,甚至可以对视频的未来帧进行可控调整。

微软亚洲研究院高级研究员段楠表示,“NÜWA 是第一个多模态预训练模型。我们希望 NÜWA 可以实现真实世界的视频生成,但在训练过程中模型会产生大量的‘中间变量’,消耗巨大的显存、计算等资源。因此,NÜWA 团队与系统组的同事们联手协作,为 NÜWA 在系统架构上设置了多种并行机制,如张量并行、管道并行和数据并行,使得我们的跨模态训练成为可能。”

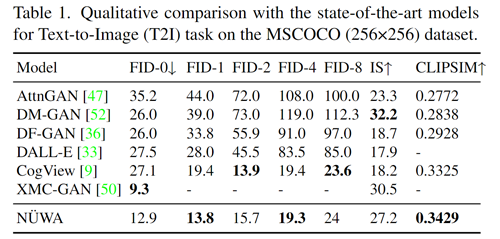

NÜWA 覆盖了11个数据集和11种评估指标。在文本到图像生成的弗雷切特起始距离(Frechet Inception Distance, FID)指标上,NÜWA 的表现超过了 DALL-E 和 CogView,在视频生成的 FVD 指标上超越了 CCVS,均取得了当前 SOTA 结果。其中,测试结果如下(更多 NÜWA 在不同数据集和评估指标中的测试结果,请点击阅读原文,查看论文细节):

表1:文本到图像任务测试结果

NÜWA 模型已基本包含了视觉创作的核心流程,可在一定程度上辅助创作者提升效率,但在实际创作中,创作者还有很多多样且高质量的需求。为此,微软亚洲研究院的研究员们在 NÜWA 的基础之上更新迭代,于近日提出了NÜWA-LIP 模型,并且在视觉领域的典型任务——缺陷图像修复中取得了新突破。

尽管此前也有方法完成了类似的图像修复,但是模型的创作却比较随意,无法符合创作者的意愿,而NÜWA LIP 几乎可以按照给定的自然语言指令修复、补全成人们肉眼可接受的图像。下面,让我们直观感受一下 NÜWA-LIP 神奇的图像修复效果。

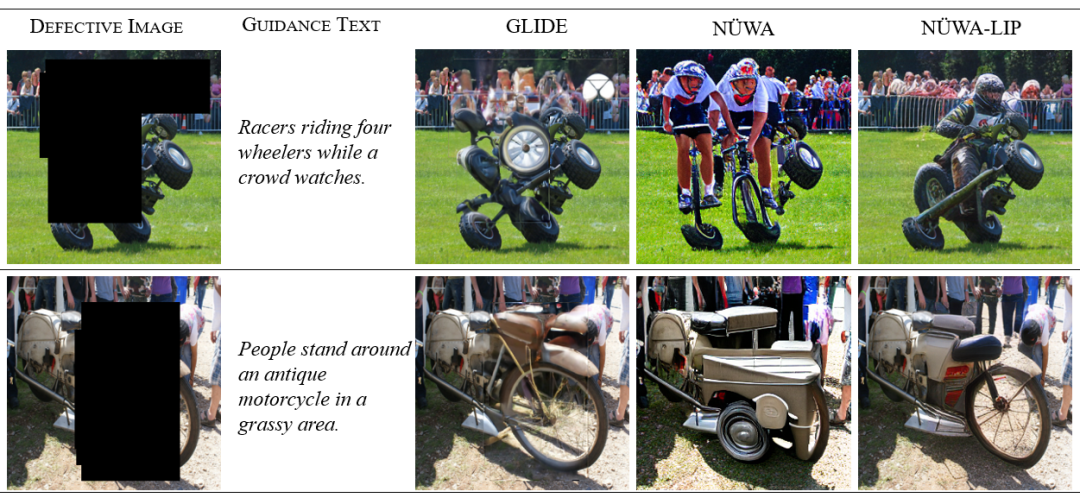

图2:在图像编辑任务上,NÜWA-LIP 展现出优秀的性能

图2给出了两个例子。第一个例子是希望模型可以按照“Racers riding four wheelers while a crowd watches”(一群人在看摩托车手骑四轮车)来补全黑色区域。已有工作 GLIDE 虽然可以补全,但是可以看到边界处有明显的白线,并且补全的区域比较模糊。NÜWA 模型使用自回归的方式从左到右依次扫描生成,边界处相比于 GLIDE 更加自然。但是由于在补全黑色区域时看不到右侧的车轮,因此标准的 NÜWA 模型存在补全边界衔接不对的问题。NÜWA-LIP 修复了 NÜWA 这一不足,它会提前预看整个图像,并创新地使用无损编码技术,然后再自回归地生成,因此可以做到黑色区域边界处衔接自然,并且补全区域也很清晰。

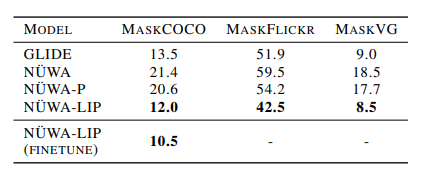

在 FID 指标测试中,通过将修复图与原始图对比,NÜWA-LIP 在自然语言指示图像修复的任务上取得了最好分数。(注:FID 分数越低表示修复图像的质量越高。)

表2:NÜWA-LIP 在图像编辑任务中的 FID 指标达到10.5

除了图像修复之外,微软亚洲研究院在高分辨率、大图像的横向延展方面也进行了持续研究,提出了 NÜWA Infinity 模型。顾名思义,NÜWA Infinity 可以根据给定的图像生成无限连续的高清“大片”。“一开始 NÜWA 能够生成、编辑的图像和视频的分辨率相对较低,一般是256×256分辨率的小图。我们希望通过模型可以生成更高清的大图,形成更大的视觉冲击,满足不同创作者的实际需求。简单来说,NÜWA Infinity 会根据图像的不同层次内容扫描每一帧窗口,不断渲染形成高像素、连续的大图,”微软亚洲研究院研究员吴晨飞介绍说。

想知道 Windows 经典桌面的右侧是什么样么?点击下图,NÜWA-Infinity 为你“揭开”神秘面纱。(请手机横屏查看)

段楠补充说,“表面看 NÜWA Infinity 解决了之前 NÜWA 生成图片不高清,以及视频帧数有限的问题。但其实 NÜWA Infinity 从底层形成了一套生成机制,不仅可以对图片进行延展式的生成,也可以应用于视频预测创作,而这也是我们接下来要攻克的研究课题。”

自此,NÜWA-LIP 让机器接受语言指令自动修图成为了可能,而 NÜWA-Infinity 则使得图像生成质量向高清、无限的真实世界迈进了一大步。按照这样的迭代创新步伐,未来创作者拥有一套趋于“无限流”的视觉创作辅助工具,指日可待。

未来,随着人工智能技术的发展,增强现实、虚拟现实等沉浸式的人机交互界面将会得到更广泛的应用,数字世界和物理世界的结合也将越来越紧密。而不同类型的多模态内容则是拉近虚拟空间与现实世界的强力胶,因此,虚拟内容的创建、编辑和交互将至关重要。NÜWA 提供的视觉内容生成和编辑技术,为这些应用提供了无限的想象空间。当多模态技术成为未来人工智能应用发展的方向时,多模态模型将会为学习、广告、新闻、会议、娱乐、社交网络、数字人、脑机交互等领域带来更多的下一代“杀手级”应用。

相关论文链接:

NÜWA:https://arxiv.org/abs/2111.12417

NÜWA-LIP:https://arxiv.org/abs/2202.05009

附录:

NÜWA 在八大任务中的效果。

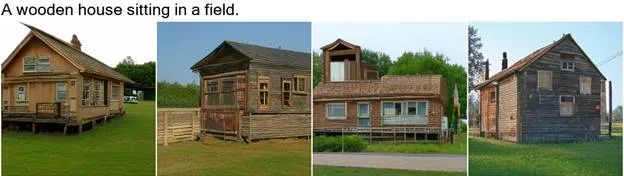

图3:文本到图像任务。例如,给定文本“A wooden house sitting in a field”(一个小木屋坐落在田野间)。NÜWA 创作了4种不同拍摄角度的小木屋,这些小木屋不仅朝向风格多样、而且真实性很好。

图4:草图到图像任务。例如,给定一张公共汽车的草图(第一行第一列),NÜWA 创作了3种满足草图形状和位置的图像,包括窗户的反光也清晰可见。

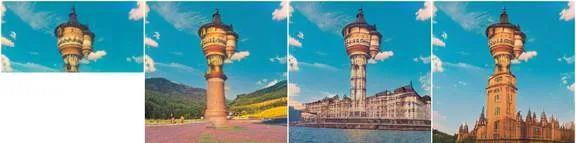

图5:图像补全任务。例如第1行,输入上方的塔尖(50%的原图),NÜWA 可以补全出塔下方的样子,圆柱甚至屋顶。对于第2行,当仅仅给5%的图像区域时,NÜWA 依然可以做到图像补全。

图6:图像编辑。例如第1幅图,给定待编辑的图像、需要编辑的图像区域(红框)以及图像上方的文本“Beach and sky”(海滩和天空),第2幅图则给出了编辑后的结果。

图7:图像到视频任务。NÜWA 不仅可以依据常见的文本 “Play golf on grass”(在草地上玩高尔夫球)来生成视频,而且可以生成现实中不可能的视频,例如“Play golf on the swimming pool”(在泳池玩高尔夫球)。

图8:视频草图到视频。输入视频草图,NÜWA 可以生成帧和帧连续的视频。

图9:视频预测。输入静止图像,NÜWA 可以输出将其“动”起来的视频。

图10:视频编辑。输入编辑文本、视频,NÜWA 可以输出编辑之后的视频。例如,原视频潜水员在水平游动,经过第二幅图“The diver is swimming to the surface”(潜水员在向水面游去)的控制,生成的视频潜水员在向上游。

你也许还想看:

相关内容

微软亚洲研究院(Microsoft Research Asia)位于北京市海淀区中关村丹棱街5号微软大厦2号楼12-14层,是微软研究院之一,也是微軟在海外最大的研究院及微软在亚洲的第一個研究院,2004年被麻省理工学院《技术评论》称为“世界上最火的计算机实验室”。经过多年的发展,微软亚洲研究院拥有超过230名全职研究员、工程师与超过250名访问学者与实习生。