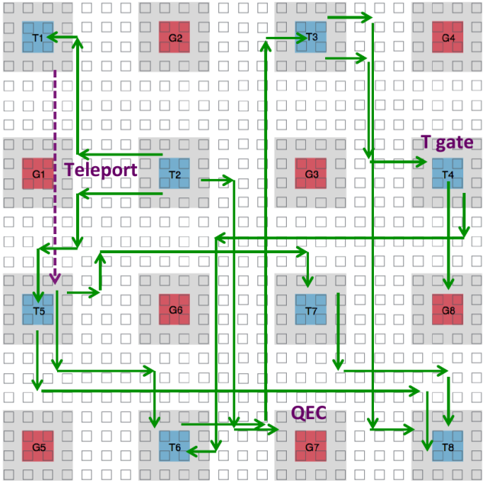

未来畅想:如何实现100万个量子比特的纠缠和量子计算

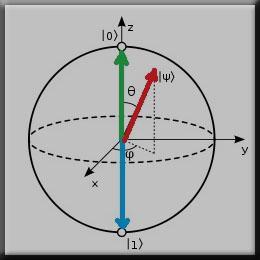

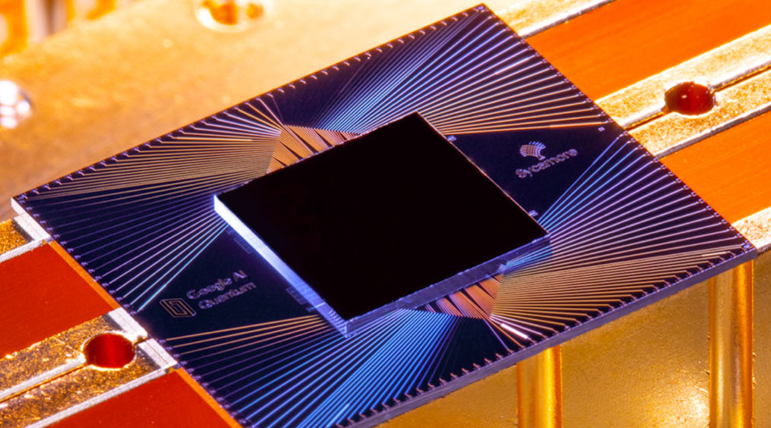

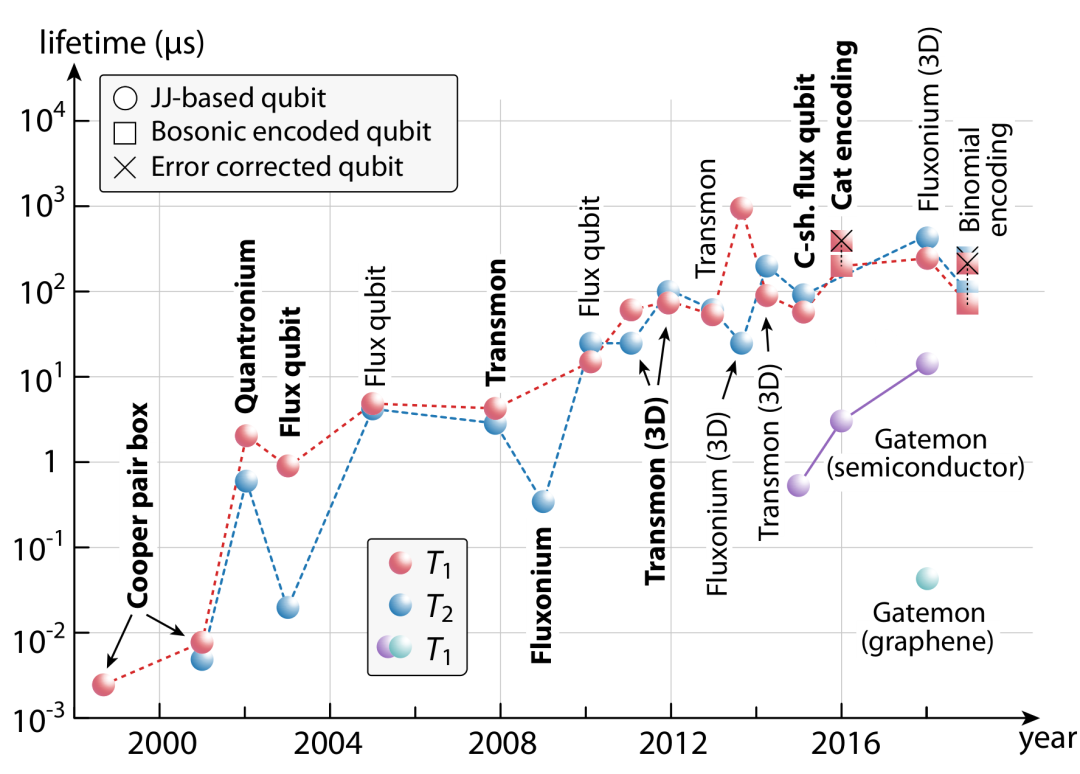

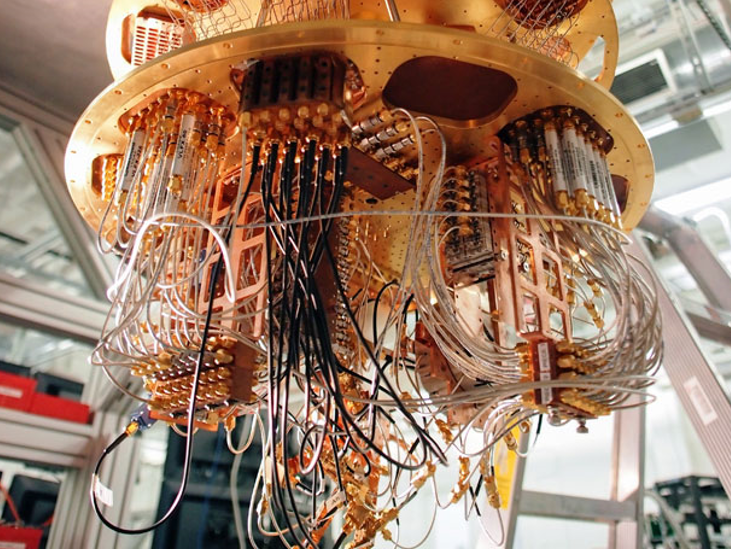

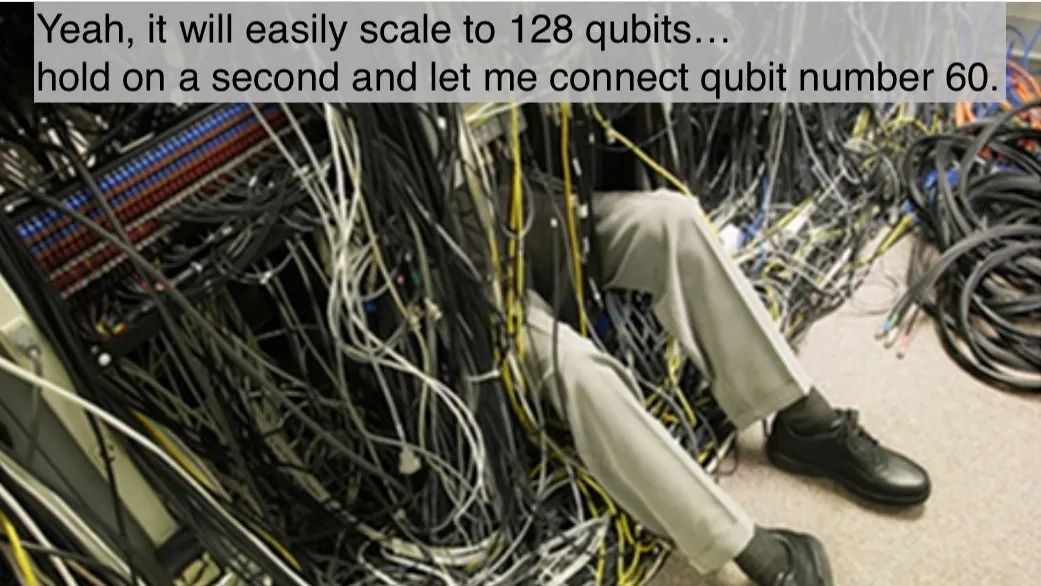

超导量子计算

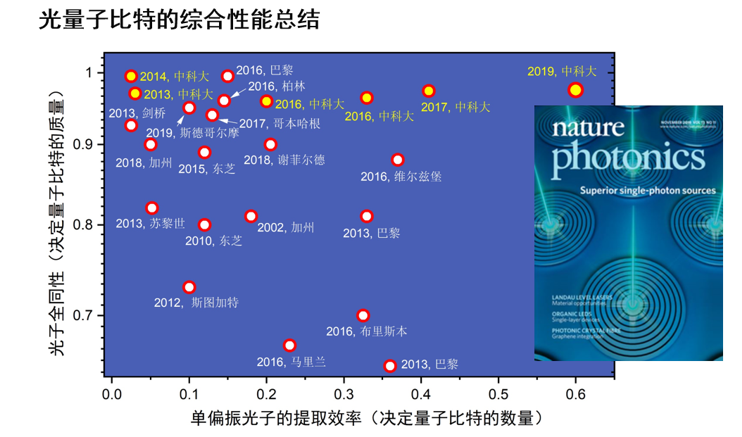

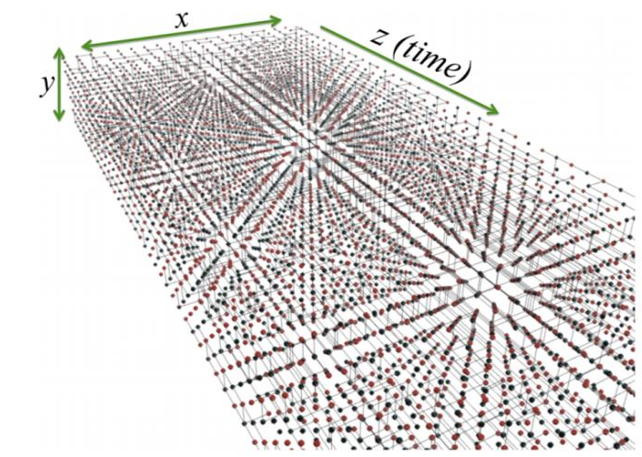

光量子计算

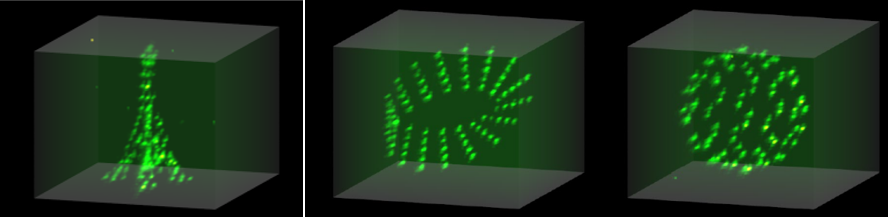

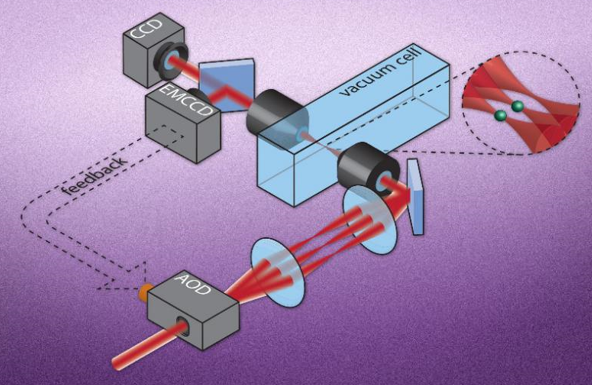

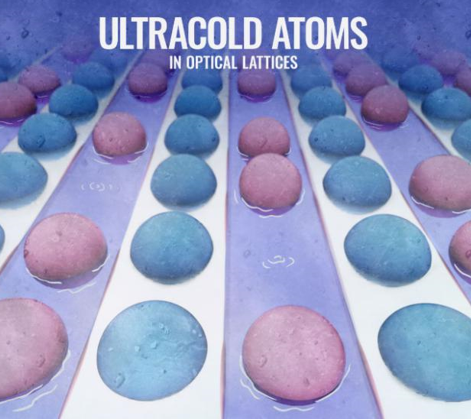

超冷原子量子模拟和量子计算

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年2月4日