多喝点水,语音的“货”超级干

在过去的30年里,语音识别系统经历了两个时代。从80年代末到2010年左右,语音识别系统大多基于高斯混合模型(GMM)和隐马尔可夫模型(HMM);在最近的10年,这个框架被新兴的神经网络所取代。

本周末(1月27日、28日),七月在线特邀王赟老师讲解【 语音识别技术的前世今生】。王赟,美国卡内基梅隆大学(CMU)计算机学院语言技术研究所(LTI)博士。曾在清华电子系专业课排名第一,后在Facebook语言技术组实习,现在CMU专攻语音识别。在本次课程中,王赟老师会带领大家从零开始,了解语音识别系统的各个模块,体验它们更新换代的过程。

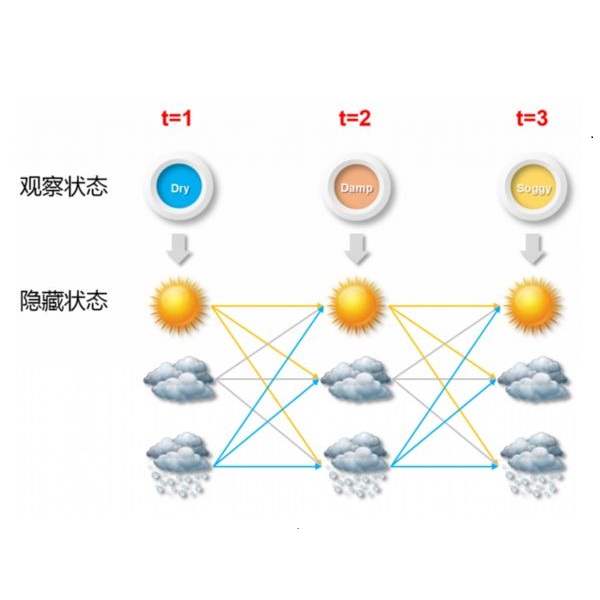

我们的旅程从最简单的孤立词识别系统开始。在这里,你会学习如何从复杂多变的语音信号中提取出对语音识别系统有用的特征,如何用GMM描述单词各部分的发音,以及如何用HMM描述这些部分之间的转移关系。一个孤立词识别系统,就可以识别「开机」「关机」「前进」「转弯」等简单的命令了。

实用的语音识别系统,要处理大词汇量、连续的语音。大词汇量要求更细致的建模单位。在孤立词识别系统中,每个HMM代表一个单词;在大词汇量系统中,每个HMM代表一个音素。连续语音识别还要求有一个语言模型,来刻画怎样的单词序列连起来更像一句正常的话。

从90年代末至2010年,语音识别系统的框架没有变化,但识别性能却芝麻开花节节高。原来,在这个期间,人们给语音识别系统的基本框架打了各种各样的补丁。这些补丁虽然提高了系统的性能,但也让系统变得复杂而难以驾驭。天下大势,分久必合,终于神经网络横空出世,收拾了GMM + HMM系统的残局。

神经网络是由一层层的神经元堆叠起来形成的、复杂的函数。它的功能十分灵活,理论上几乎可以解决一切机器学习问题;尤其是循环神经网络的结构,十分适合处理语音这种序列型数据。在上个世纪,由于数据量和计算能力的限制,神经网络的研究一直处于寒冬;到了现在,大数据和GPU的出现终于解锁了神经网络的潜力。本课中,老师将向大家展示神经网络如何一步一步地蚕食掉了GMM + HMM框架的每一个模块,形成所谓的“端到端”模型——即只用一个神经网络完成传统系统中所有模块的功能。

目前语音识别技术的前沿,是CTC、transducer、注意力三种网络结构,它们各有优劣,尚未分出明确的胜负。语音识别同样也有很多待解决的问题,例如噪声和口音往往会让识别结果惨不忍睹。本次课程就将带领大家来到这一前沿,展望未来的发展方向。

有这么多干货,小编可是非常心动啊!更重要的是,这么超值的课程,线上直播竟然只需199元(现在团购是99元),还提供1年的回放,以及学员群的交流和答疑服务!可以让时间紧张的小伙伴有充足的复习时间。

悄悄告诉大家,课程这周末就开始了,有些事情错过了,就永远错过了。起码,直播间里跟老师的实时对话,以后永远不会有了。

扫码下方图片二维码进入报名通道!