【CVPR2021】自监督几何感知

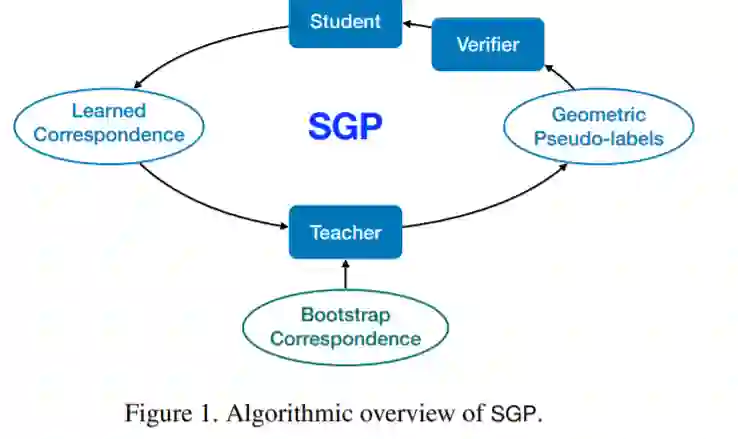

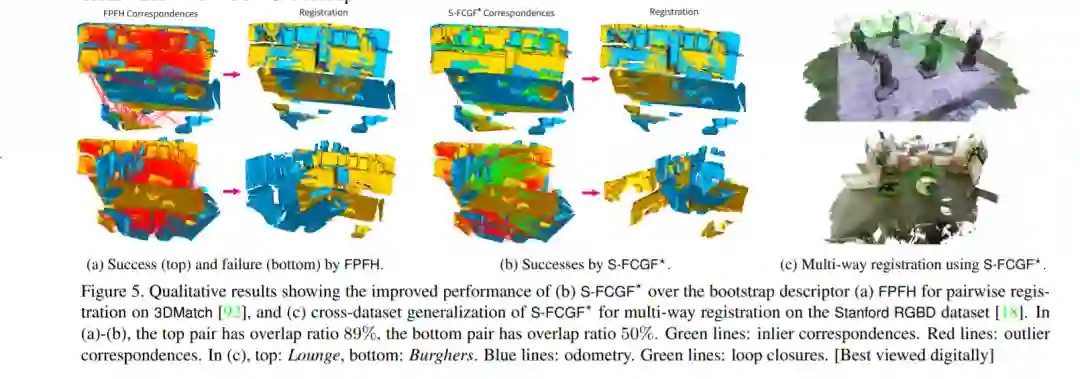

我们提出了自监督几何感知(SGP),这是第一个学习特征描述符进行对应匹配的通用框架,不需要任何真实的几何模型标签(例如,相机姿态,刚性转换)。我们的第一个贡献是将几何感知形式化为一个优化问题,在给定大量视觉测量数据(如图像、点云)的基础上,联合优化特征描述符和几何模型。在这个优化公式下,我们展示了视觉领域的两个重要的研究流,即鲁棒模型拟合和深度特征学习,对应着优化未知变量的一个块,同时固定另一个块。这种分析自然引出了我们的第二个贡献——SGP算法,它执行交替最小化来解决联合优化。SGP迭代地执行两个元算法:一个教师对已知的学习特征进行鲁棒模型拟合以生成几何伪标签,一个学生在伪标签的嘈杂监督下进行深度特征学习。作为第三个贡献,我们将SGP应用于大规模真实数据集上的两个感知问题,即MegaDepth上的相对相机姿态估计和3DMatch上的点云配准。我们证明,SGP达到了最先进的性能,与使用真实标签训练的受监督的模型相当。

https://www.zhuanzhi.ai/paper/21db003f32377530d0fb1ddeaf7f2f94

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SGP” 就可以获取《【CVPR2021】自监督几何感知》专知下载链接

登录查看更多

相关内容

Arxiv

11+阅读 · 2018年3月23日