给研究思路就能推荐数据集,还能分析语料“毒性”,CMU博士后等人推出NLP数据处理神器

明敏 发自 凹非寺

量子位 | 公众号 QbitAI

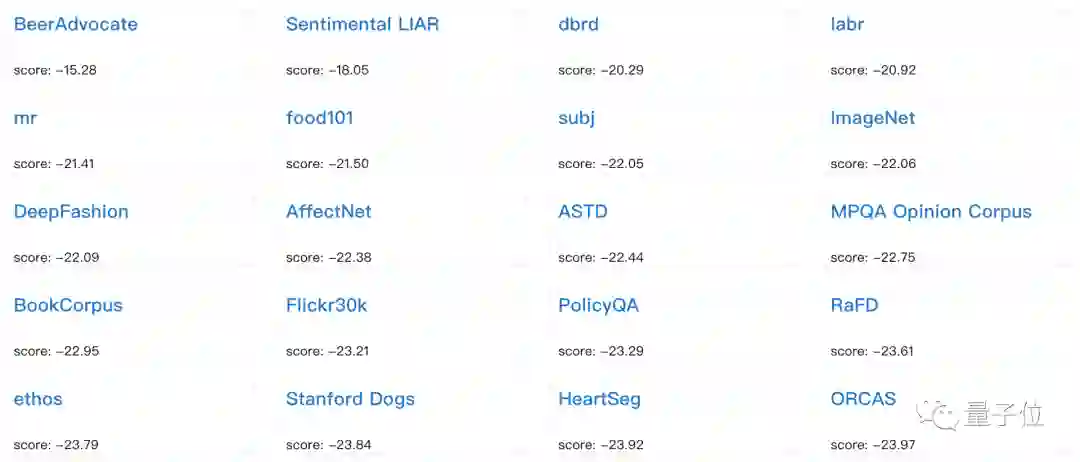

说出你的研究思路,就能给你推荐合适的数据集:

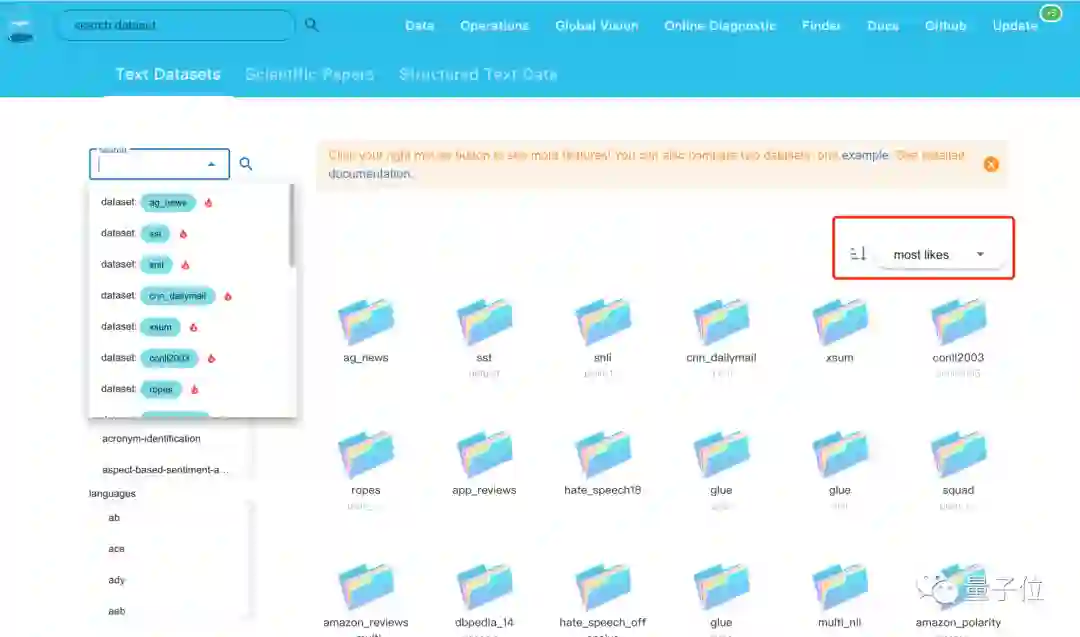

当然还可自己按需检索,同时标出不同数据集的热度:

更厉害的是能直接帮你分析数据集。

语料中是否包含仇恨言论、性别歧视语料等,所占比例是多少,通通都能告诉你。

以上,是一个名叫DataLab的通用数据处理平台。

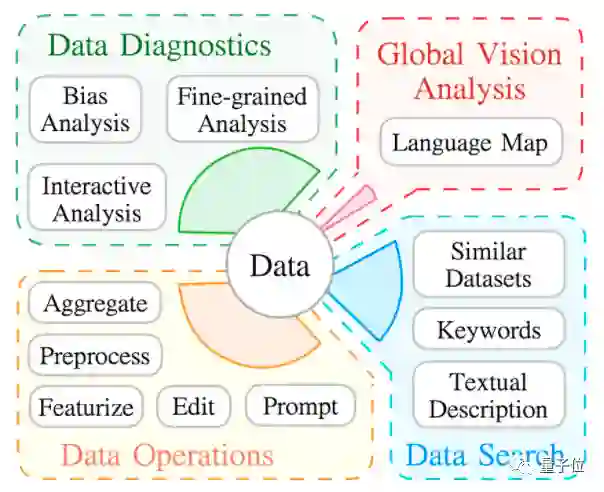

它包含1715个数据集,提供数据诊断、数据搜索、全局分析、标准化处理4方面的功能。

不仅可以帮助用户分析数据的特征,还能对不同数据集进行标准化处理。

其幕后打造者之一为卡内基梅隆大学博士后刘鹏飞,他博士毕业于复旦大学。

方便,方便,还是方便

其实对于很多人来说,构建模型往往在数据集阶段就会被卡住。

现在网络上的数据集虽然一抓一大把,但质量参差不齐。

而且很多新入门的童鞋也对于自己应该用什么样的数据集,非常迷茫。

那么,一个覆盖数据集范围广、还能进行分析的平台,或许能帮助你找到心仪的数据集。

基于这样的背景下,刘鹏飞所在团队就搞了个DataLab。

就拿找数据集来说吧,在DataLab上你不仅可以按照模型的需求来筛选合适数据集,还能看看哪些数据集最受欢迎、哪些下载量最多、哪些访问量最多。

毕竟“大家说好才是真的好”,这句话在哪也受用嘛。

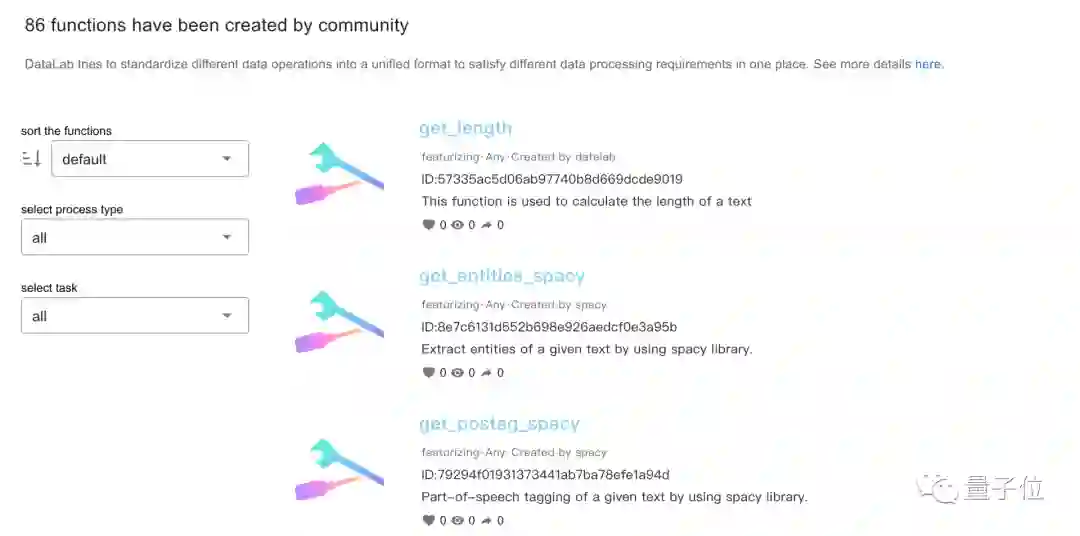

再来看标准化处理上。

DataLab提供86个功能,可以将不同的数据集标准化处理为统一格式。

如果你构建模型时不知道该用什么样的数据集,还能直接问DataLab。

比如当你输入研究思路:

我想训练一个可以识别啤酒评论中包含的积极和消极情绪的模型。

DataLab就能给出20个数据集任君选择,每一个点进去还有更加详细的介绍。

除了提供数据集分析和处理功能,DataLab还可以根据现有的数据为大家提供一些全球视野的分析。

比如它能展现全球不同国家AI本地化技术积累的情况。

其开发者刘鹏飞表示,数据,尤其是标注数据是训练一个AI系统的关键。所以很多时候,数据集的积累可以体现技术壁垒。

从DataLab上的大数据分析可以看出,美国在语言数据集上的优势巨大,因为很多现有公开、流行的数据集都是以英文为主。

相较之下,中文数据集的积累情况就不够好。

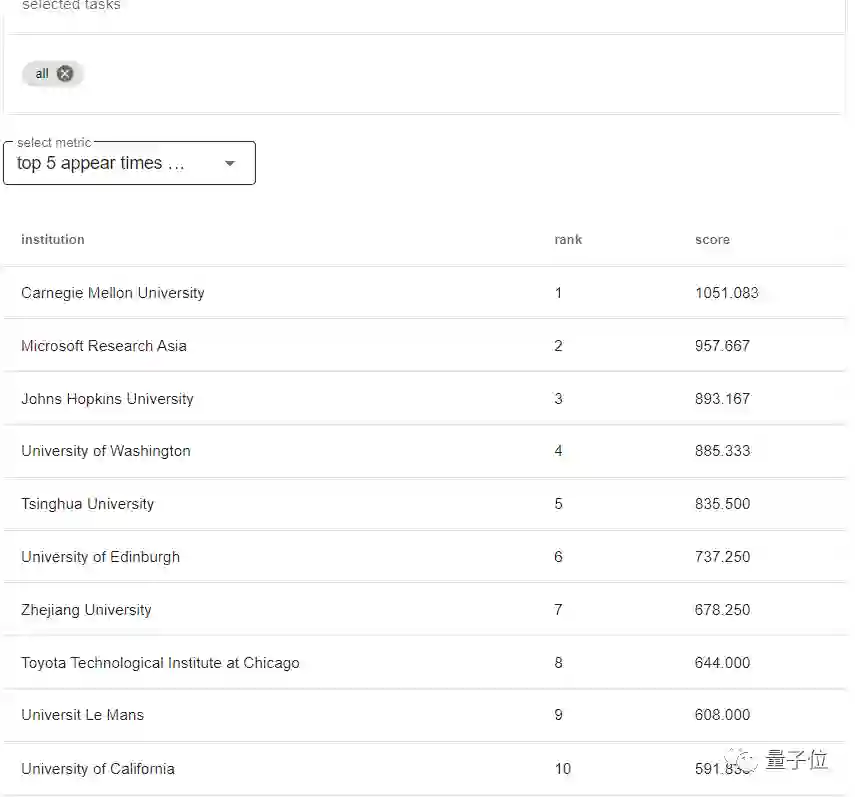

同时,这一平台也能对全球不同研究机构在不同任务数据集上的表现进行排名。

从下表中可以看到,CMU、微软亚研院、JHU、UW几个机构位居前四,清华大学在国内排名最高。

不过平台开发者也提醒大家,平台上的数据统计有可能因为用户提交数据不全而导致结果不准确/考虑不周全,仅作为参考之一。

用户也可以在DataLab官网进行数据纠正。

复旦校友领衔打造

DataLab由卡内基梅隆大学语言技术研究所(LTI)博士后刘鹏飞领衔打造。

刘鹏飞于2019年在复旦大学计算机系获得博士学位,师从邱锡鹏教授、黄萱菁教授。

研究兴趣包括NLP模型可解释性、迁移学习、任务学习等。

博士期间,他包揽了各种计算机领域的奖学金,包括IBM博士奖学金、微软学者奖学金、腾讯人工智能奖学金、百度奖学金。

谈到打造DataLab这一平台的初衷,刘鹏飞向量子位表示:

机器学习领域有太多技术需要被标准化和统一,也需要技术被折叠,不然就会造成一种资源过剩带来的浪费。

他提到,UC伯克利大学的明星实验室RISELab曾打造出很多新颖的技术工具,比如高性能分布式执行框架Ray。

其掌舵人Ion Stoica教授在一次分享中提到“统一是它们成功的关键”。

DataLab这次的工作其实也是如此。

它的意义在于提供了一个“数据+操作”的统一框架,让未来很多事情都可以转化成两件事:

定义/引入一个新的数据类型;

定义/引入一个新的数据操作(比如现在火热的Prompt Learning,本质上就是重构数据)。

由此,研究者和开发者就可以有一个统一的入口去进行他们需要的各种数据分析与操作。

在DataLab里,不同数据类型、操作类型都被标准化,其目的就是让用户在前人已经解决的事情上不要再浪费时间,而是使用已经有的技术去探索新的技术发展。

当然,如果再深入一点,刘鹏飞表示创建DataLab还源于一股内在驱动力:

如何让自己做的事情能够在推动人类社会生产力发展上扮演一些重要的角色。

事实上,刘鹏飞也不是第一次为开发者、研究人员们打造便利的“小工具”了。

比如帮助开发者提出创新学术idea的辅助工具ExplainaBoard。

还有可自动生成论文评审结果的Demo网站ReviewAdvisor,只需要上传PDF论文,即可自动生成评审结果。

哦对了,刘鹏飞还会在知乎上分享自己在NLP方面的一些研究心得。

比如这篇《近代自然语言处理技术发展的“第四范式”》就曾在网上引起过不小的反响。

感兴趣的童鞋,欢迎移步大佬知乎围观~

DataLab地址:

http://datalab.nlpedia.ai/

GitHub地址:

https://github.com/ExpressAI/DataLab/

刘鹏飞知乎:

https://www.zhihu.com/people/liu-peng-fei-65-23/posts

— 完 —

「人工智能」、「智能汽车」微信社群邀你加入!

欢迎关注人工智能、智能汽车的小伙伴们加入我们,与AI从业者交流、切磋,不错过最新行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~