【CVPR2021】用Transformers无监督预训练进行目标检测

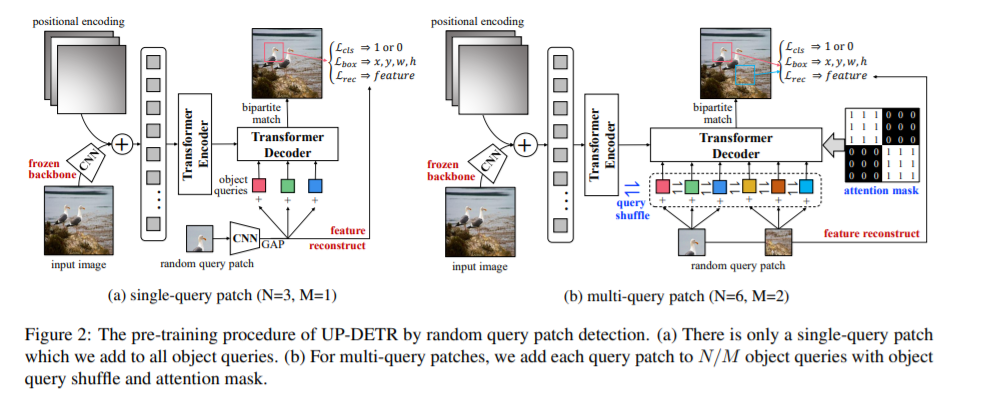

通过一个Transformer编码器-解码器架构的目标检测transformers (DETR)取得了与Faster R-CNN相匹配的性能。受预训练transformer在自然语言处理中取得的巨大成功的启发,我们提出了一种基于随机查询补丁检测的无监督预训练目标检测任务。具体地说,我们从给定的图像中随机裁剪小块,然后将它们作为查询输入解码器。该模型经过预训练,从原始图像中检测出这些查询补丁。在预训练,我们解决了两个关键问题:多任务学习和多查询定位。(1)为了权衡在前置任务中分类和定位的多任务学习,我们冻结CNN骨干,提出一个与patch检测联合优化的patch特征重构分支。(2)为实现多查询定位,我们引入了单查询补丁的UP-DETR ,并将其扩展为具有对象查询洗牌和注意掩码的多查询补丁。在我们的实验中,UP-DETR算法在PASCAL VOC和COCO数据集上具有更快的收敛速度和更高的精度,显著提高了DETR算法的性能。代码很快就会发布。

https://www.zhuanzhi.ai/paper/853834bf1a11589a505c42a963aa4fd5

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DETR” 就可以获取《【CVPR2021】用Transformers无监督预训练进行目标检测》专知下载链接

登录查看更多

相关内容

Arxiv

10+阅读 · 2020年12月31日

Arxiv

6+阅读 · 2018年3月30日