【CVPR2021】基于噪声鲁棒深度学习的快速元更新策略

Faster Meta Update Strategy for Noise-Robust Deep Learning [Oral]

Youjiang Xu, Linchao Zhu, Lu Jiang, Yi Yang

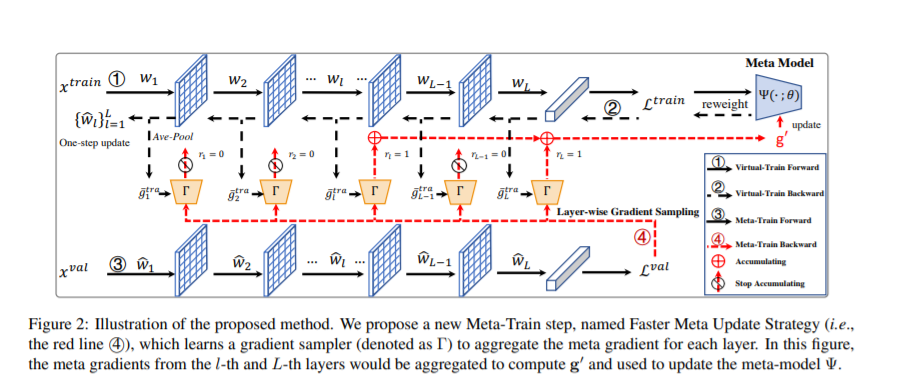

基于meta-learning的方法在有噪声标注的图像分类中取得了显著的效果。这类方法往往需要大量的计算资源,而计算瓶颈在于meta-gradient的计算上。本文提出了一种高效的meta-learning更新方式:Faster Meta Update Strategy (FaMUS),加快了meta-learning的训练速度 (减少2/3的训练时间),并提升了模型的性能。首先,我们发现meta-gradient的计算可以转换成一个逐层计算并累计的形式; 并且,meta-learning的更新只需少量层数在meta-gradient就可以完成。基于此,我们设计了一个layer-wise gradient sampler 加在网络的每一层上。根据sampler的输出,模型可以在训练过程中自适应地判断是否计算并收集该层网络的梯度。越少层的meta-gradient需要计算,网络更新时所需的计算资源越少,从而提升模型的计算效率。

并且,我们发现FaMUS使得meta-learning更加稳定,从而提升了模型的性能。最后,我们在有噪声的分类问题以及长尾分类问题都验证了我们方法的有效性。

https://www.zhuanzhi.ai/paper/fda93b750216436e45e6f660ed76776e

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FMUS” 就可以获取《【CVPR2021】基于噪声鲁棒深度学习的快速元更新策略》专知下载链接

登录查看更多

相关内容

Arxiv

4+阅读 · 2018年7月29日

Arxiv

4+阅读 · 2018年3月30日