美国播客节目《指数视角》专访李飞飞:疫情、 AI 伦理、人才培养

来源:HyperAI超神经

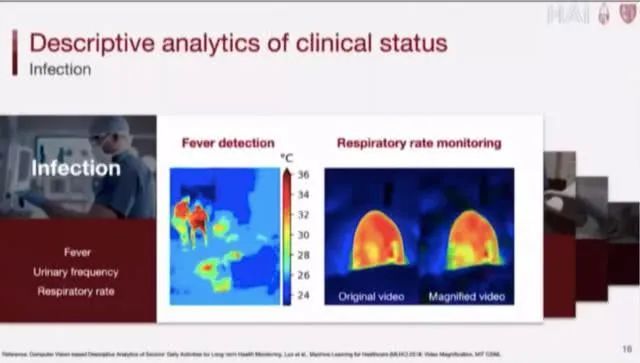

李飞飞:疫情让我用 AI 帮助和保护老年人

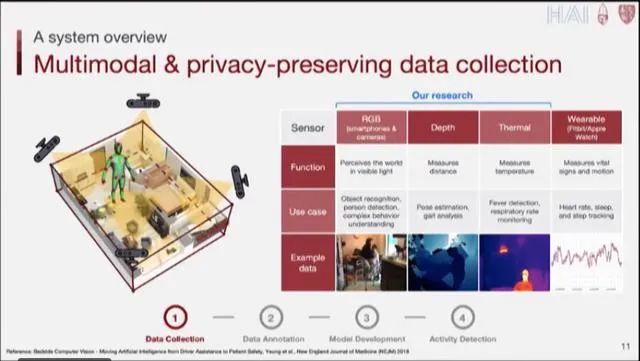

技术发展与隐私问题之间的权衡

李飞飞:我的学生,需要懂技术也要理解场景

技术是中立的吗?

ImageNet:彻底转变图像识别

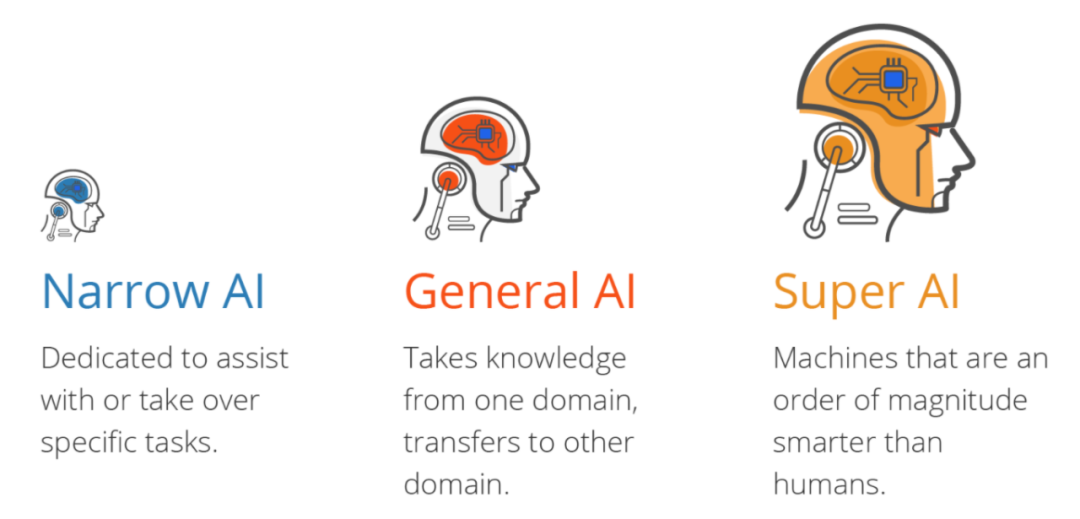

李飞飞眼中的通用人工智能(AGI)

——END——

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年6月11日