【纽约大学Sean】神经文本退化:一致性和学习,93页ppt

Sean Welleck是纽约大学的博士生,他的顾问是Kyunghyun Cho和Zheng Zhang。他的研究兴趣包括深度学习和结构预测,以及在自然语言处理中的应用。他曾在Facebook人工智能研究公司(AI research)担任实习生,由杰森·韦斯顿(Jason Weston)担任顾问。他在宾夕法尼亚大学获得了理学学士和理学硕士学位。他的研究成果发表在ICML、NeurIPS、ICLR和ACL上,包括两项Nvidia AI实验室开拓性研究奖。

神经文本退化:一致性和学习

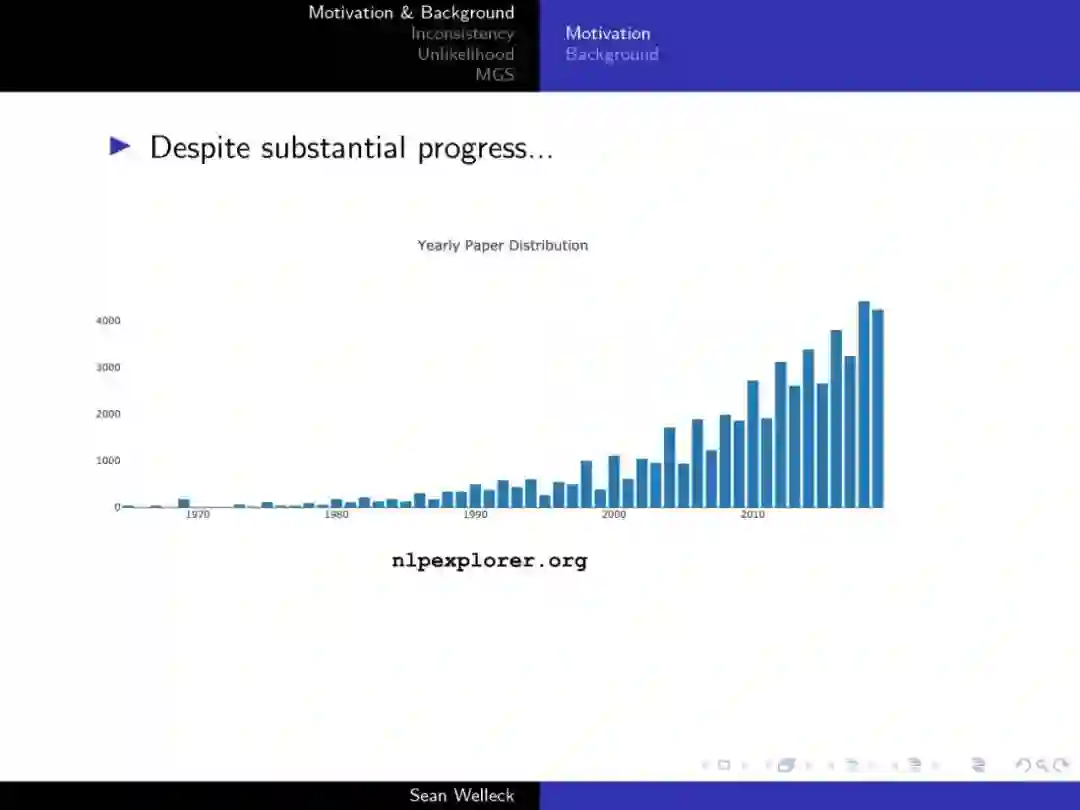

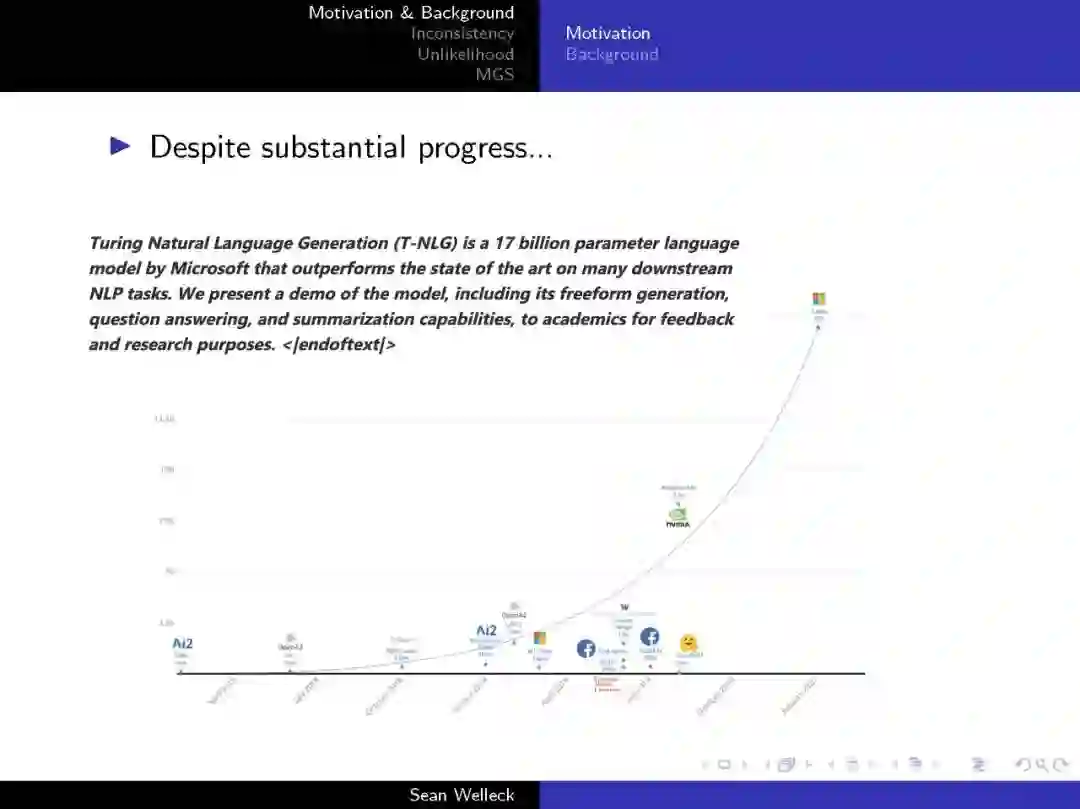

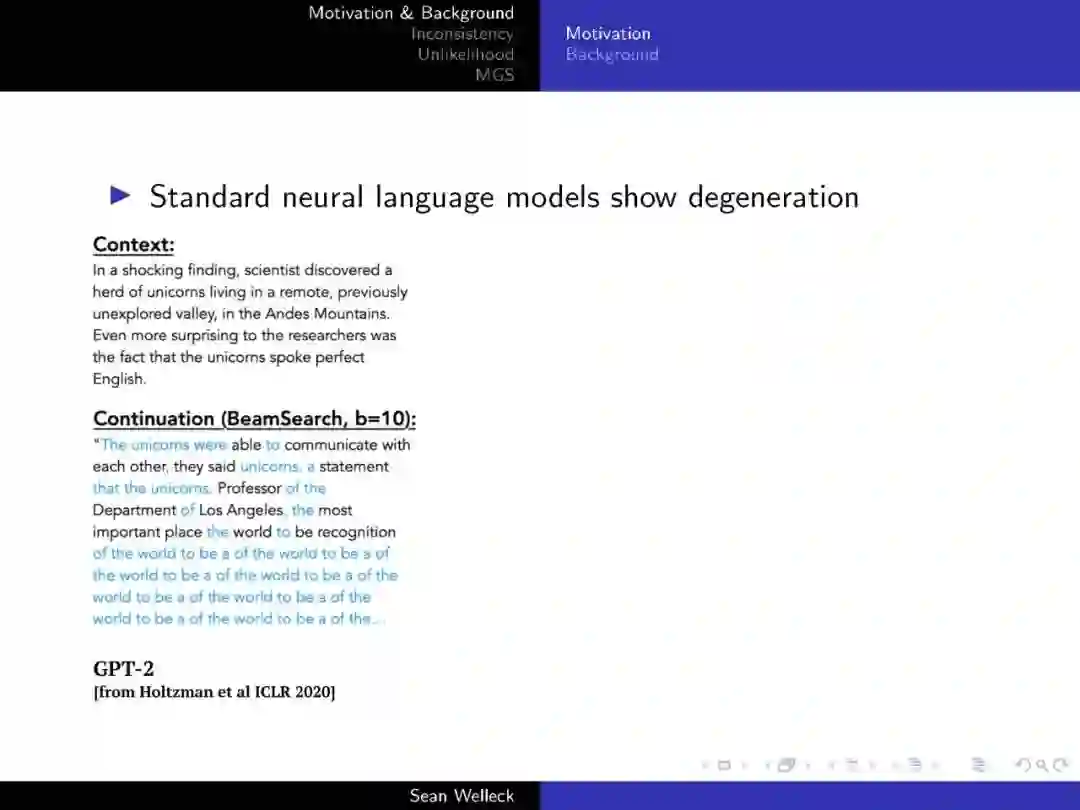

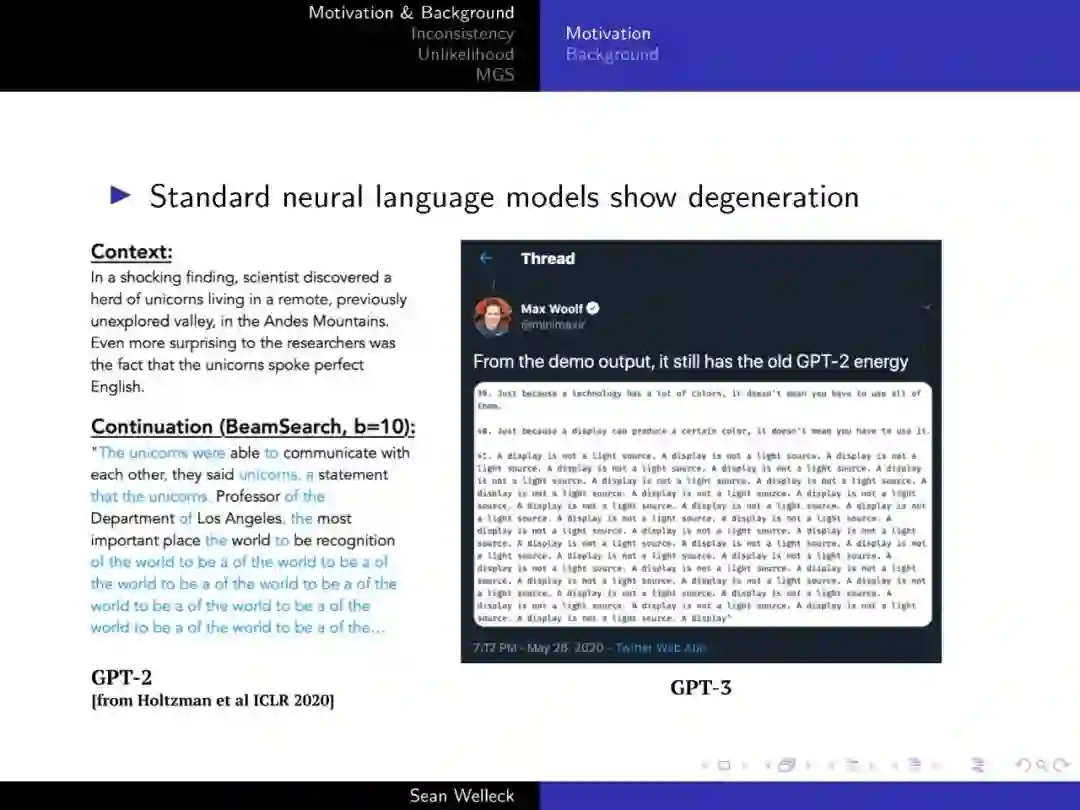

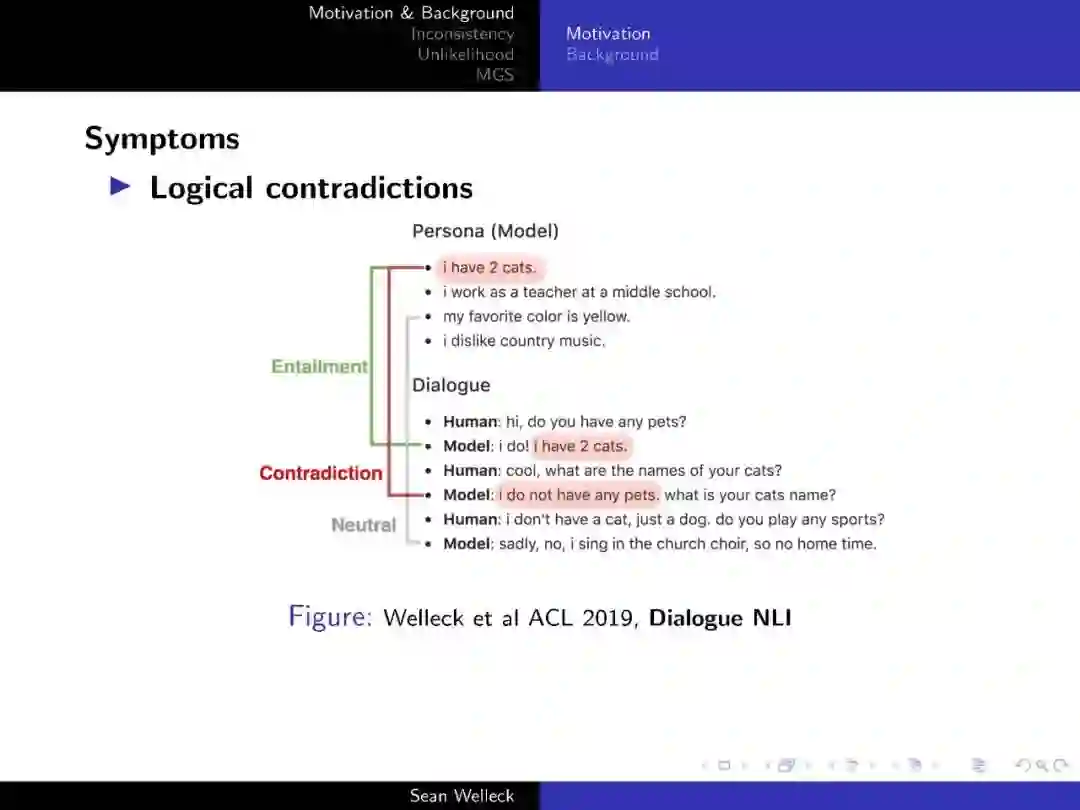

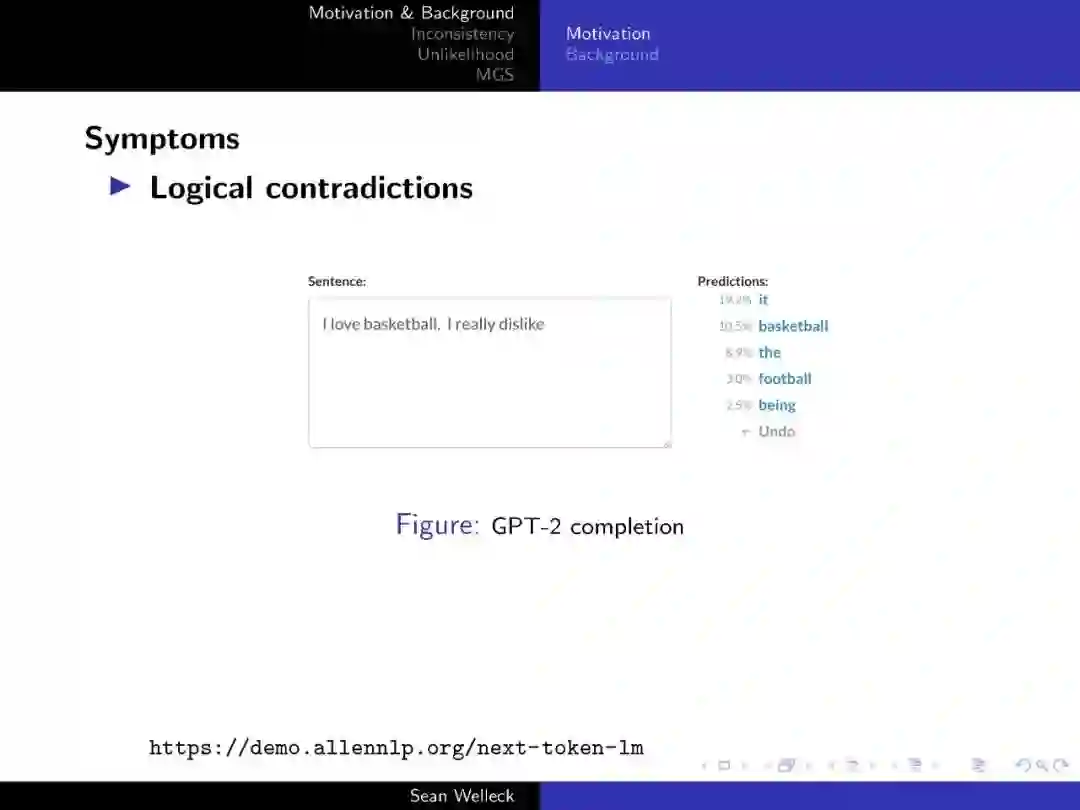

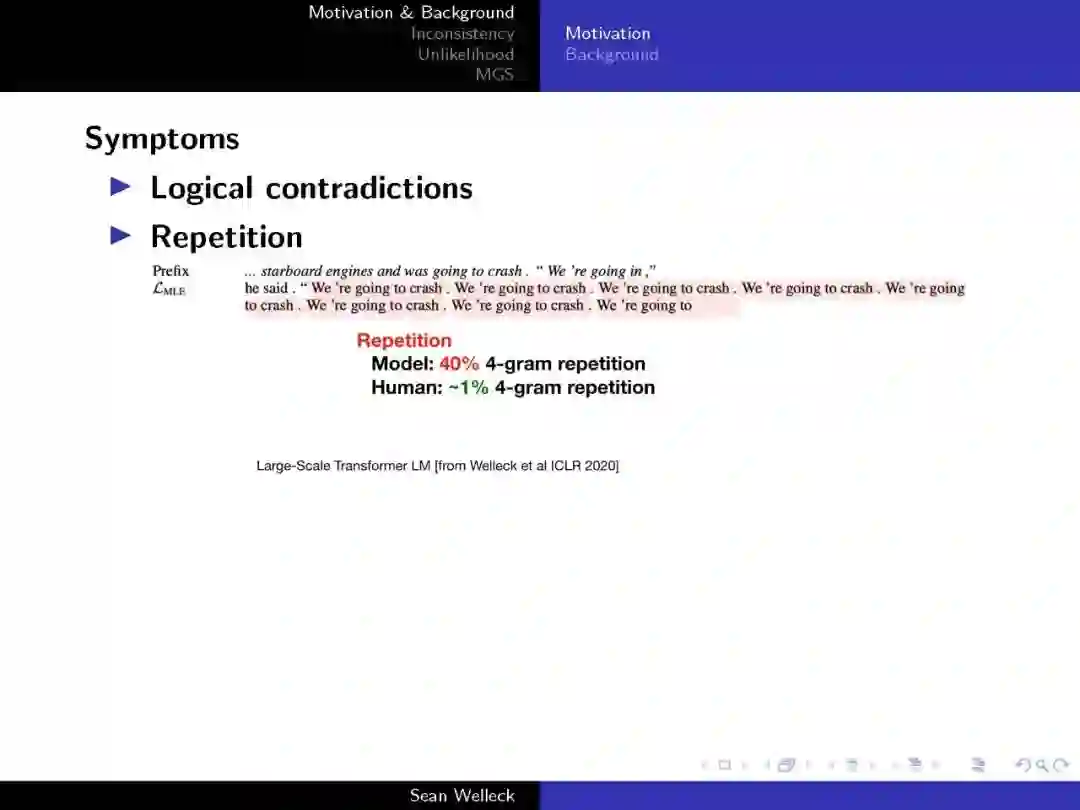

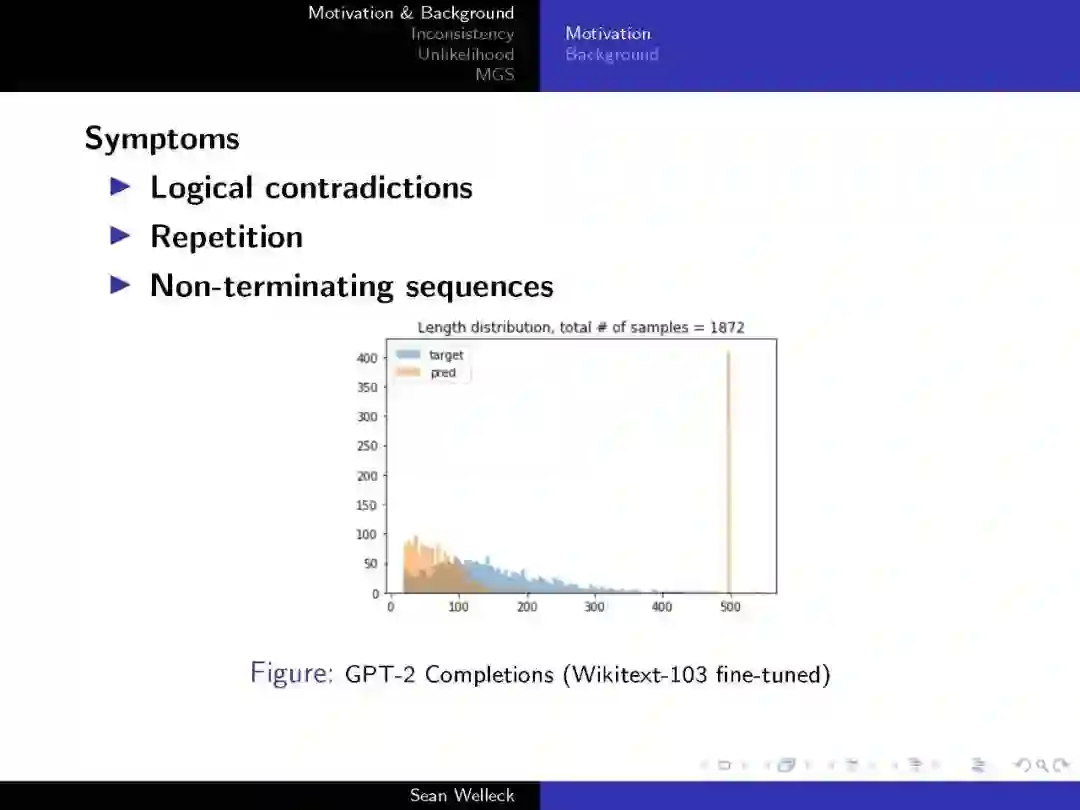

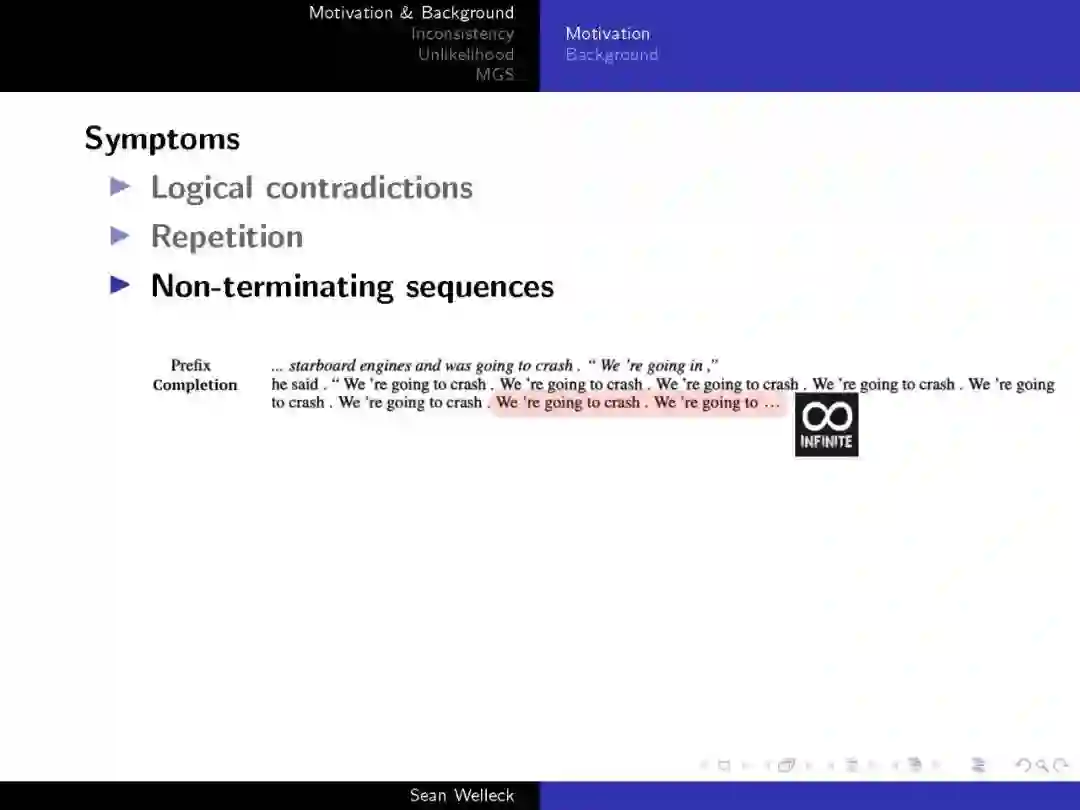

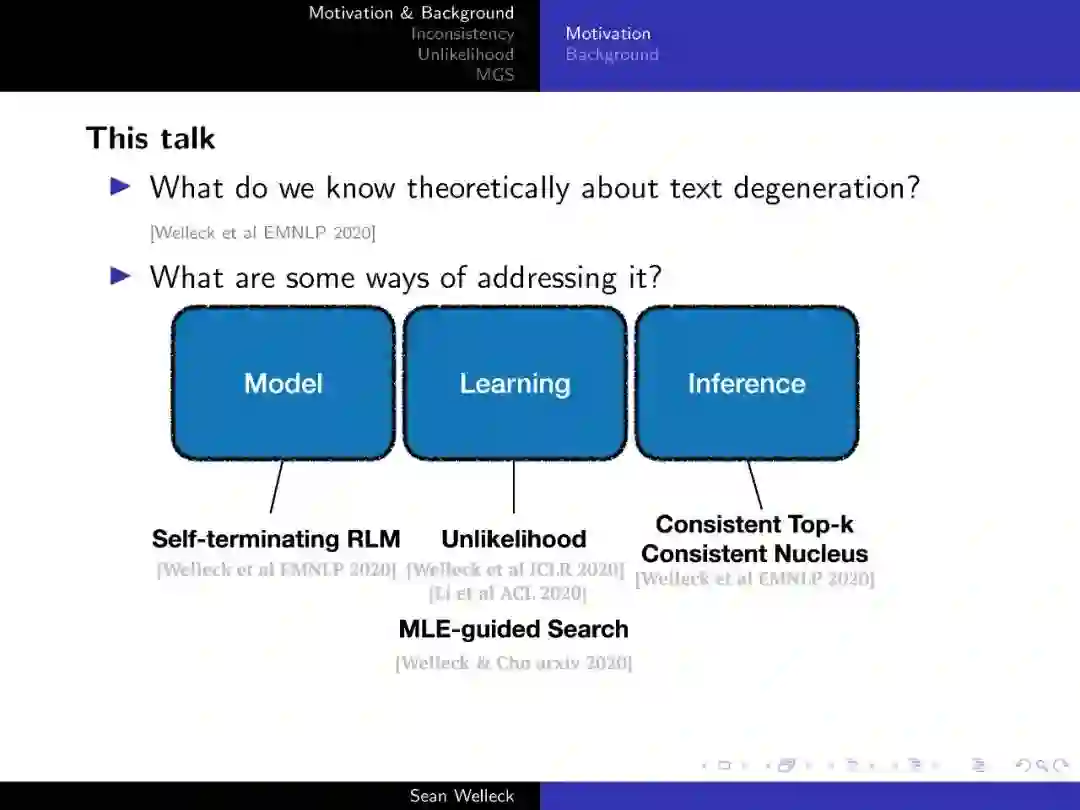

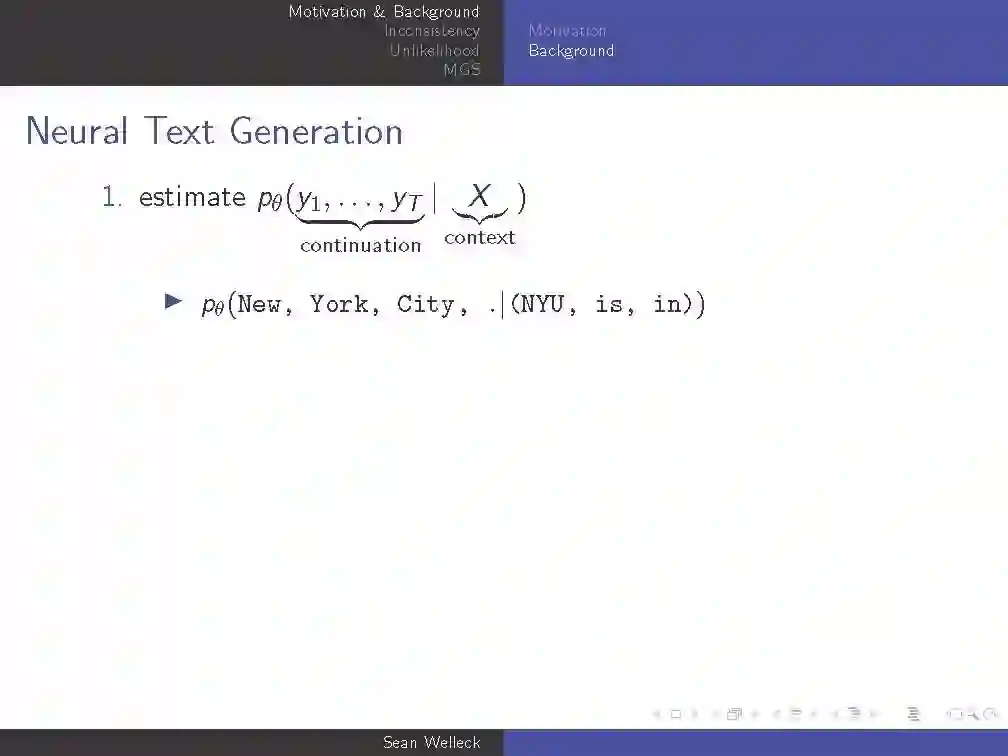

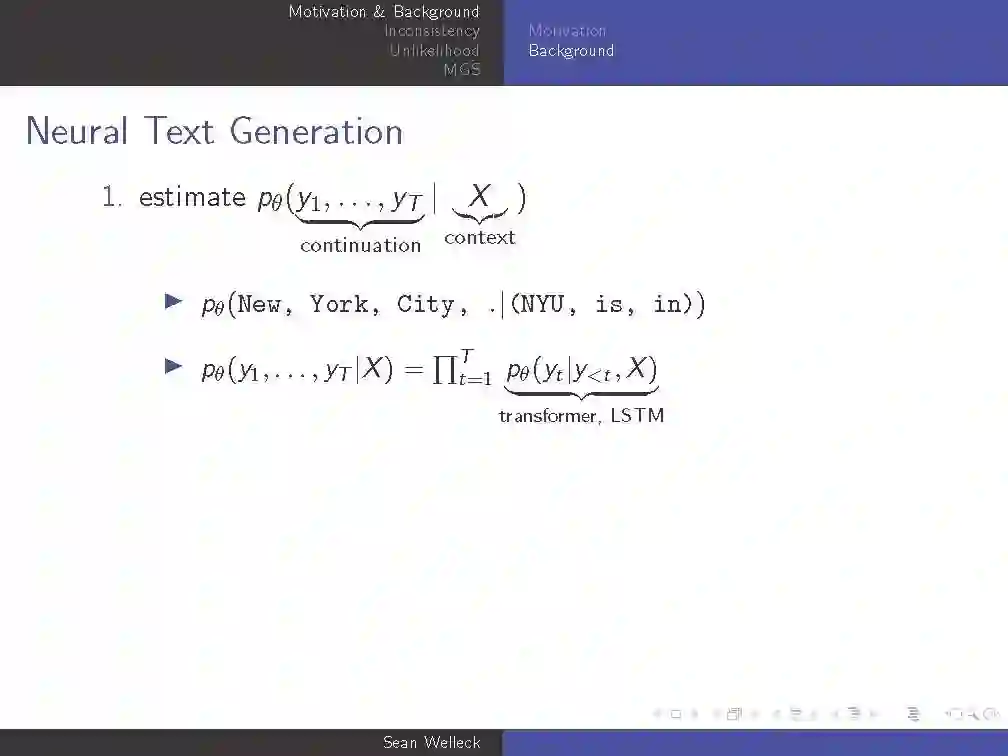

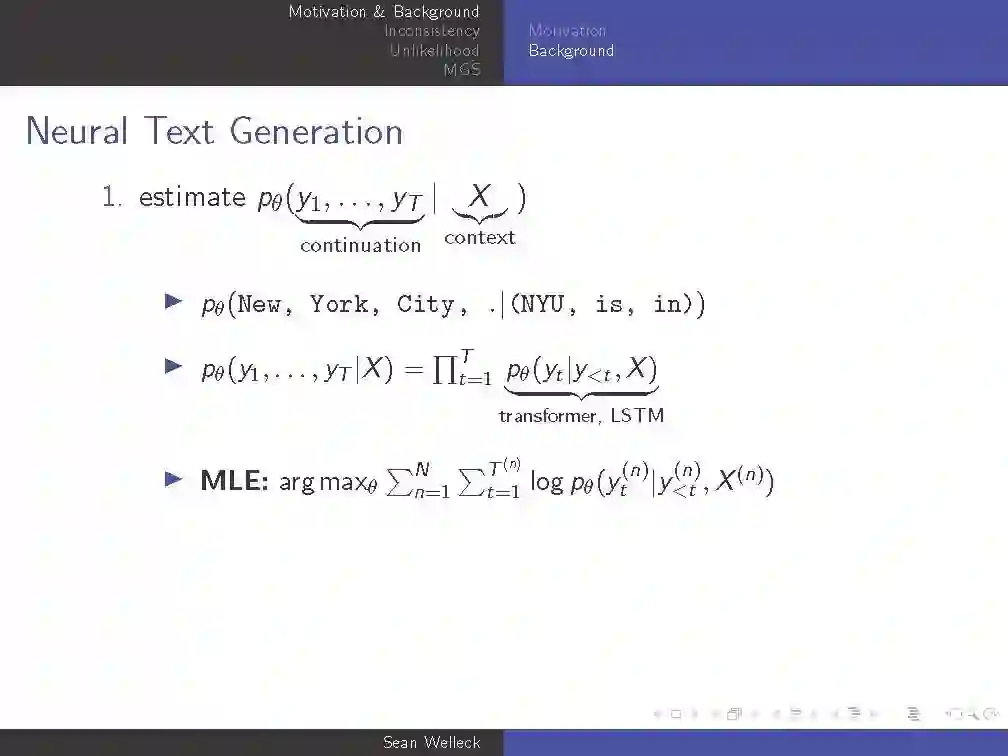

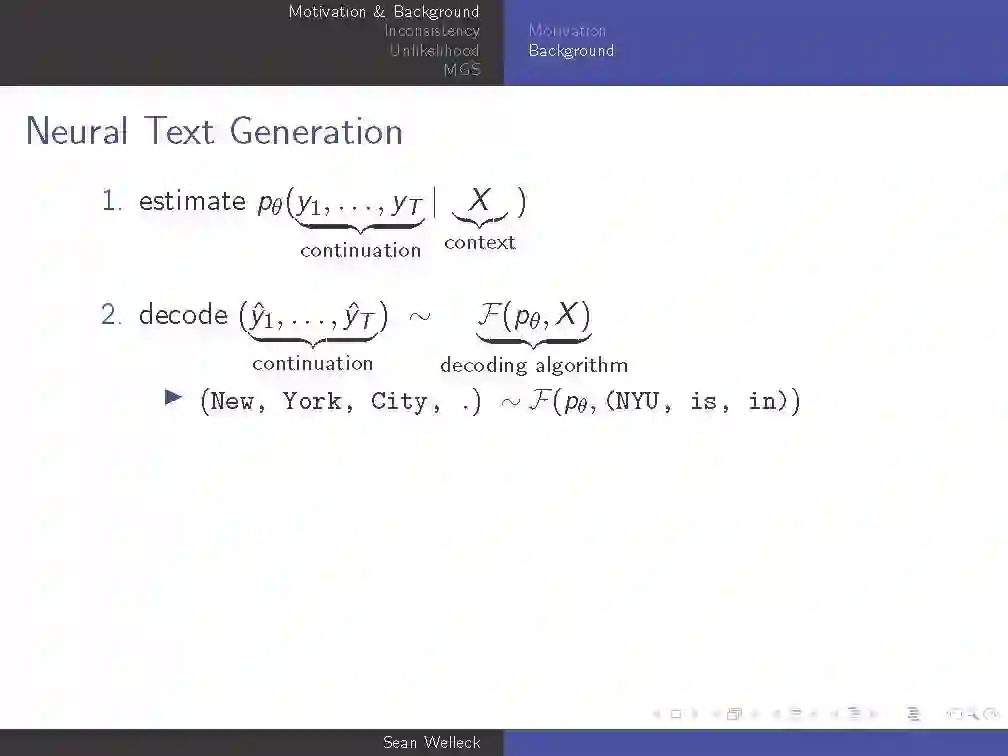

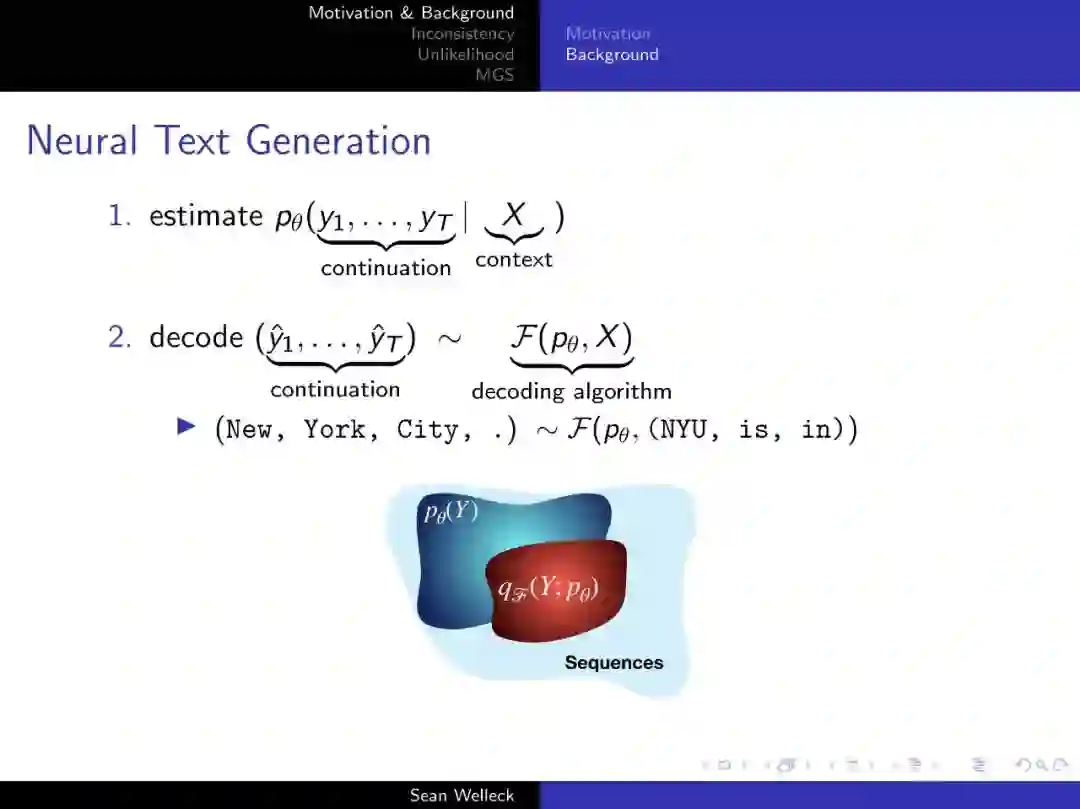

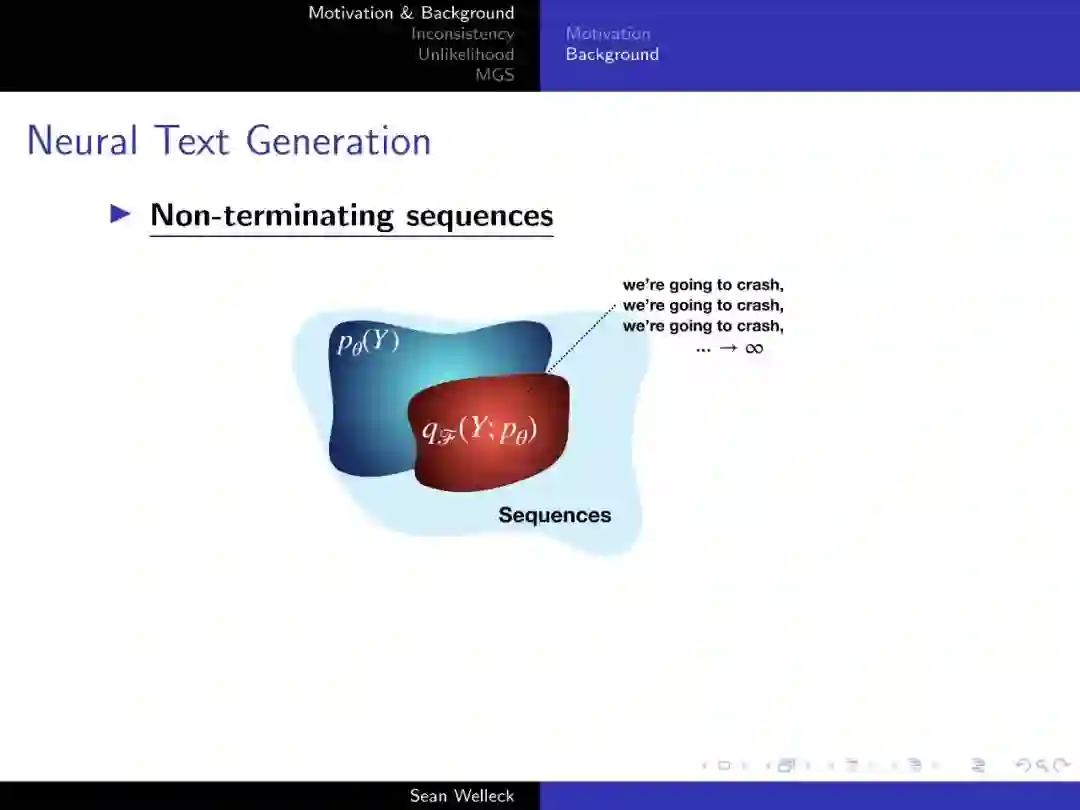

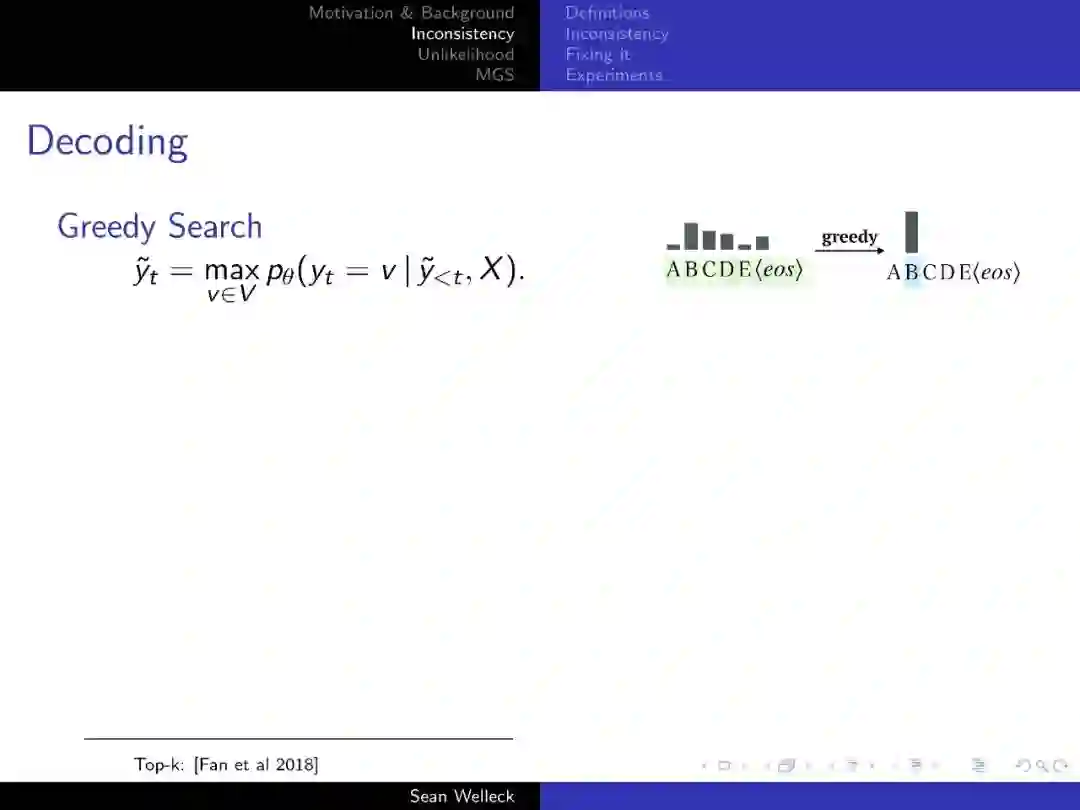

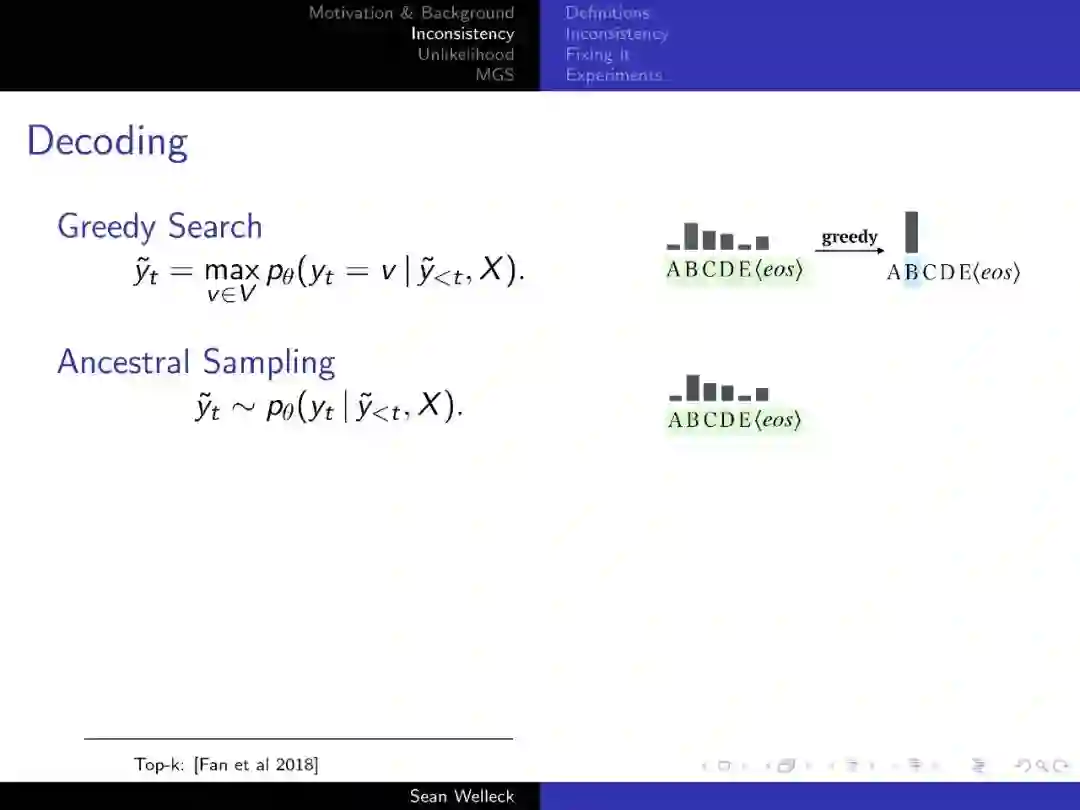

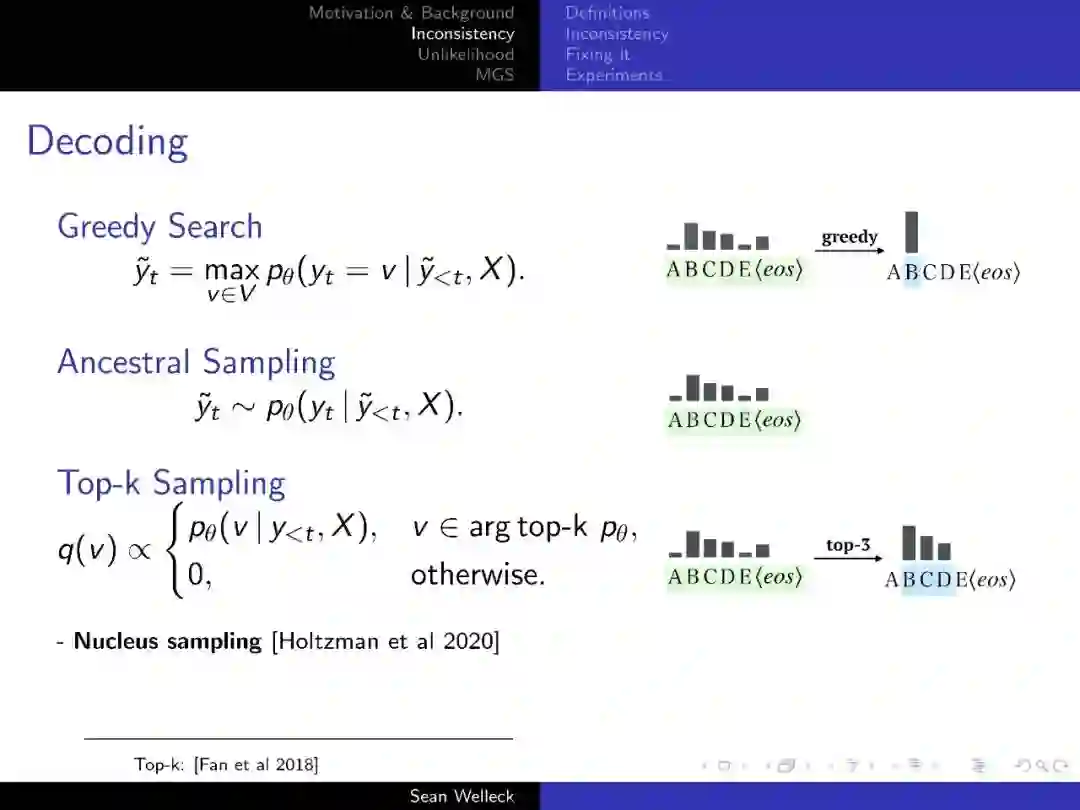

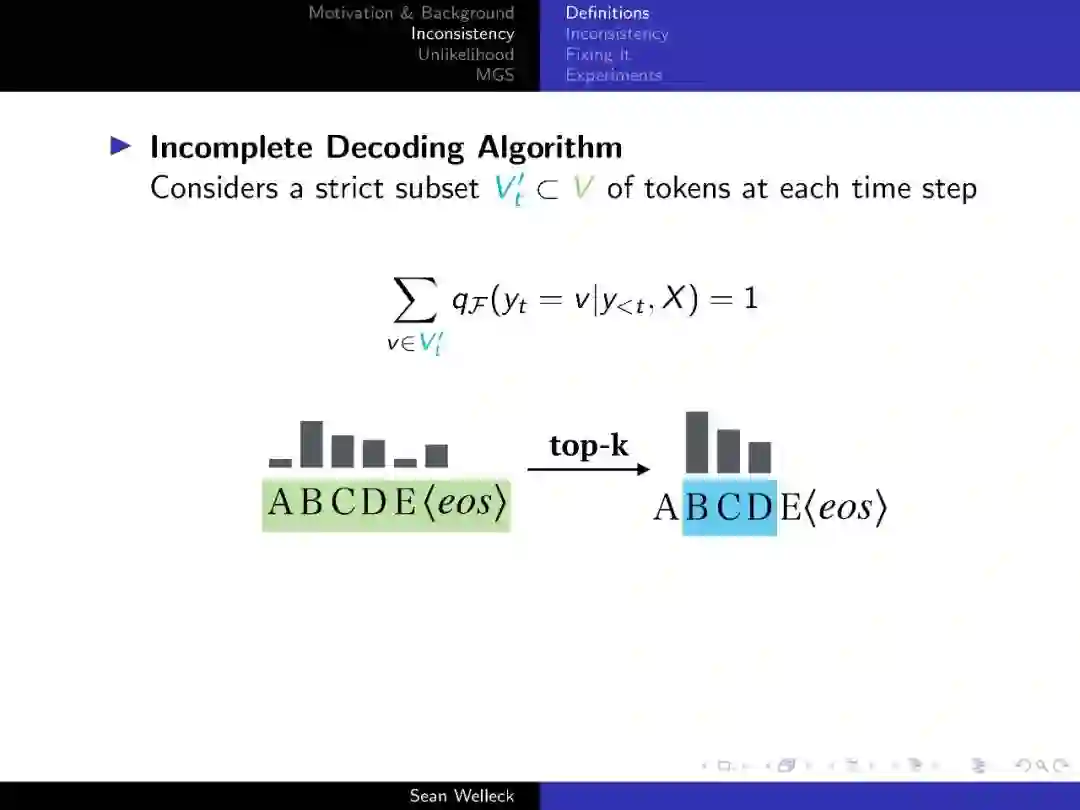

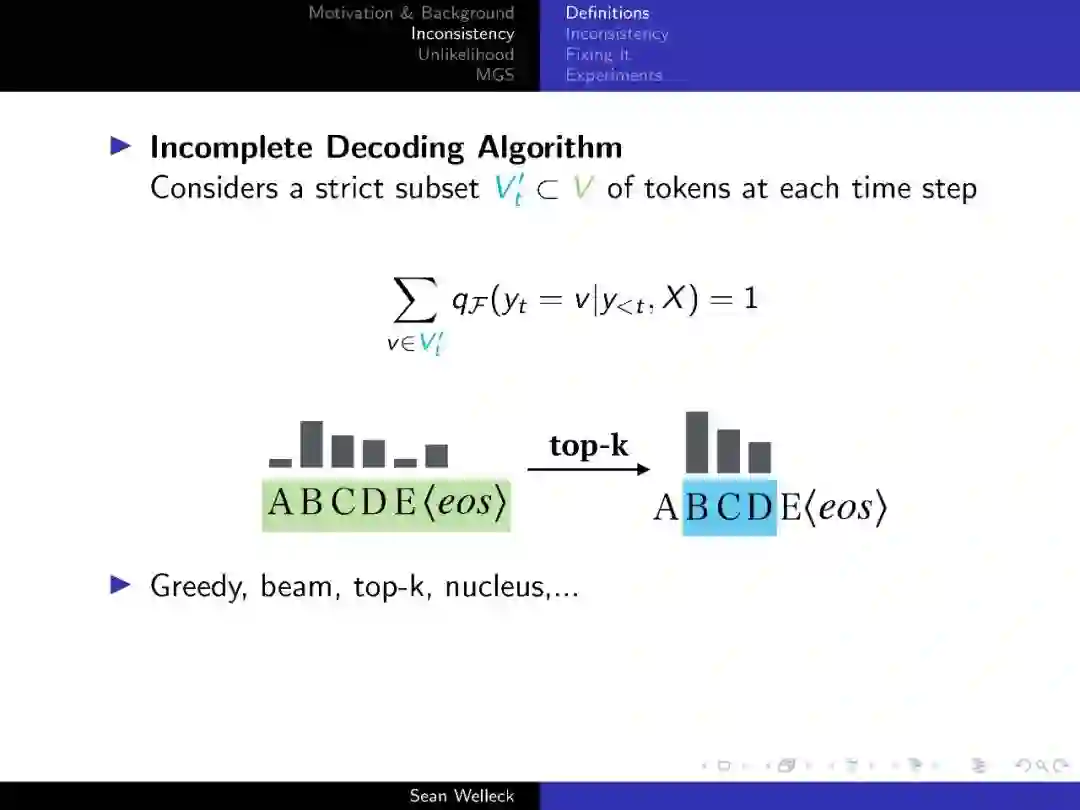

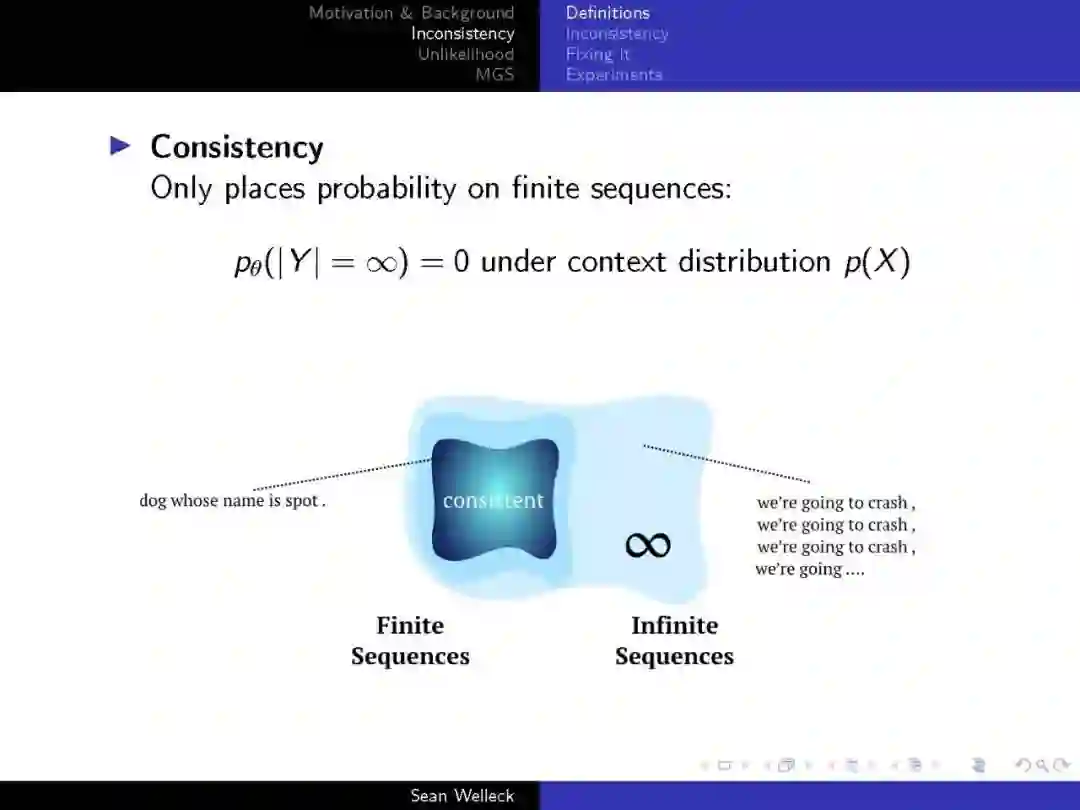

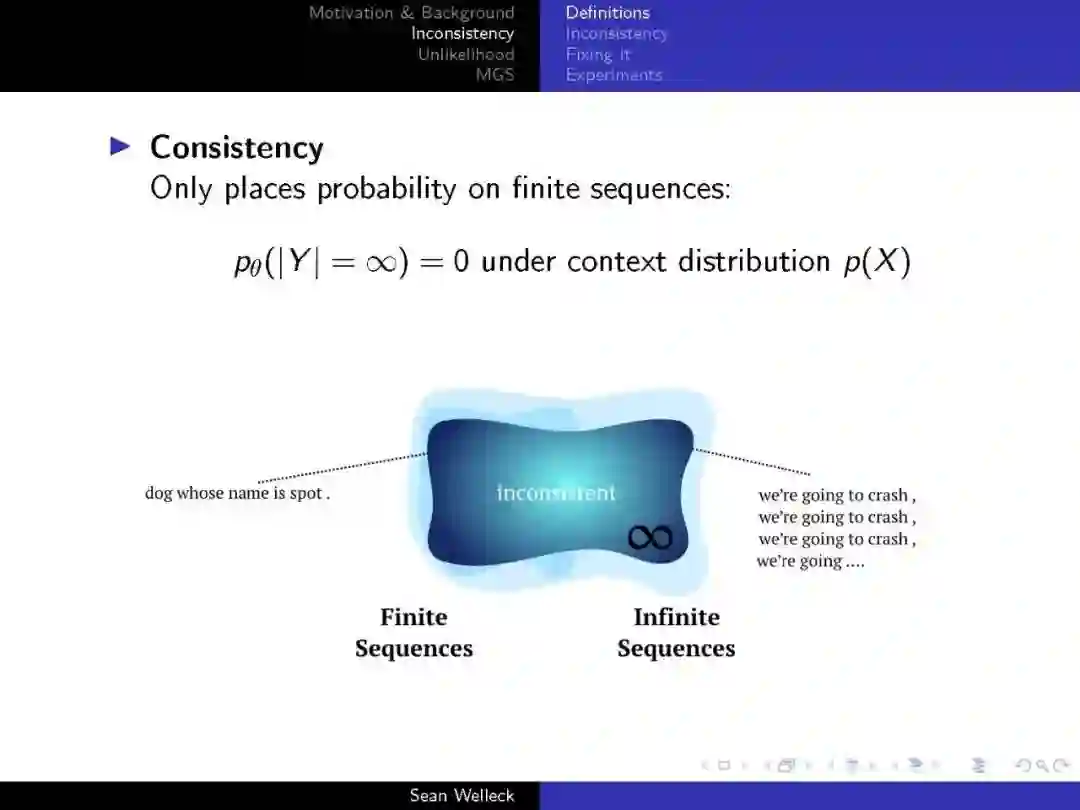

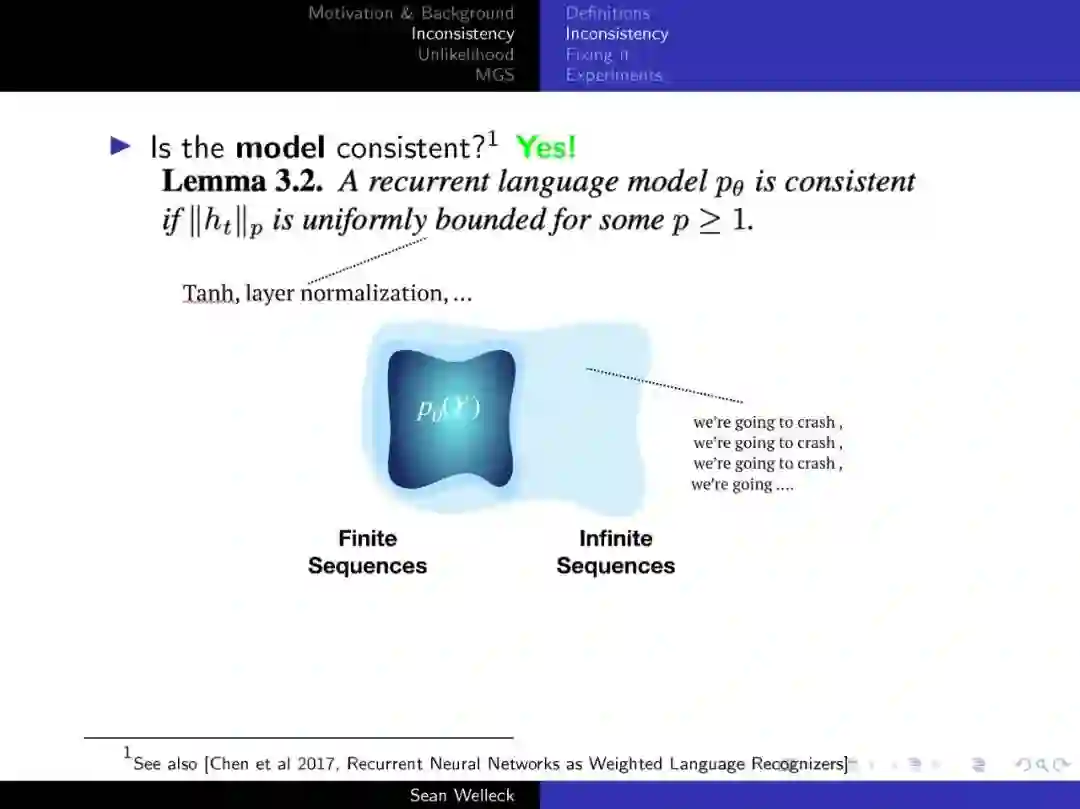

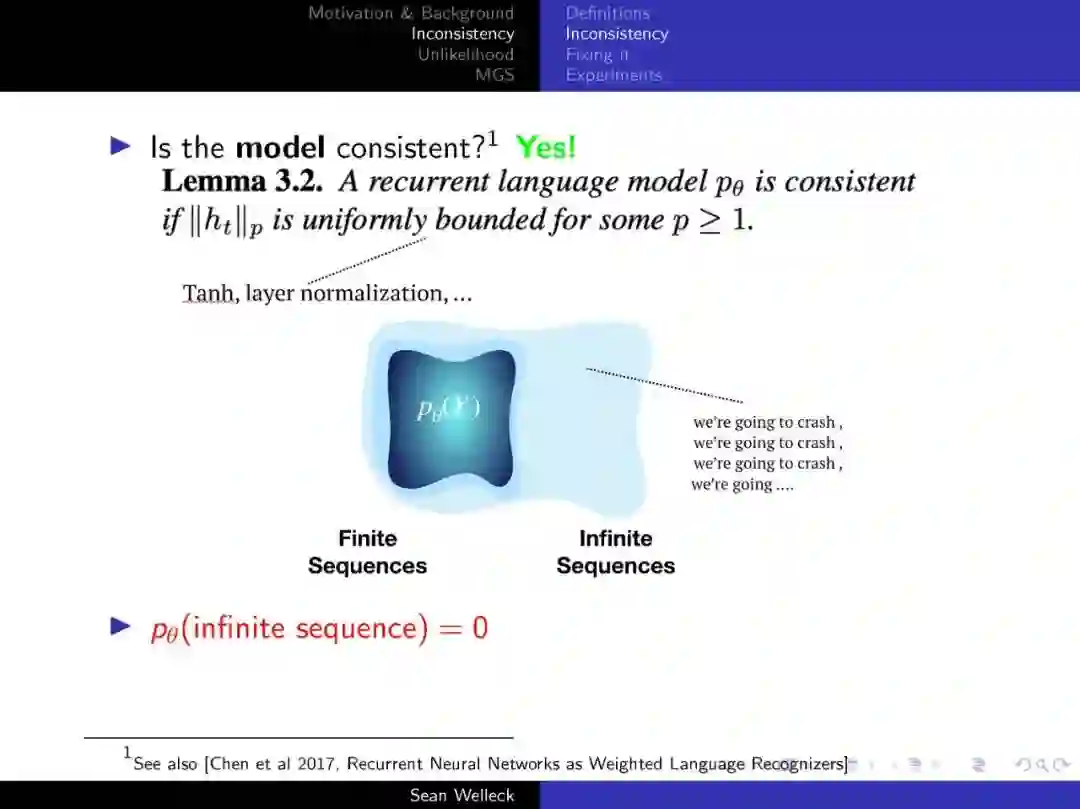

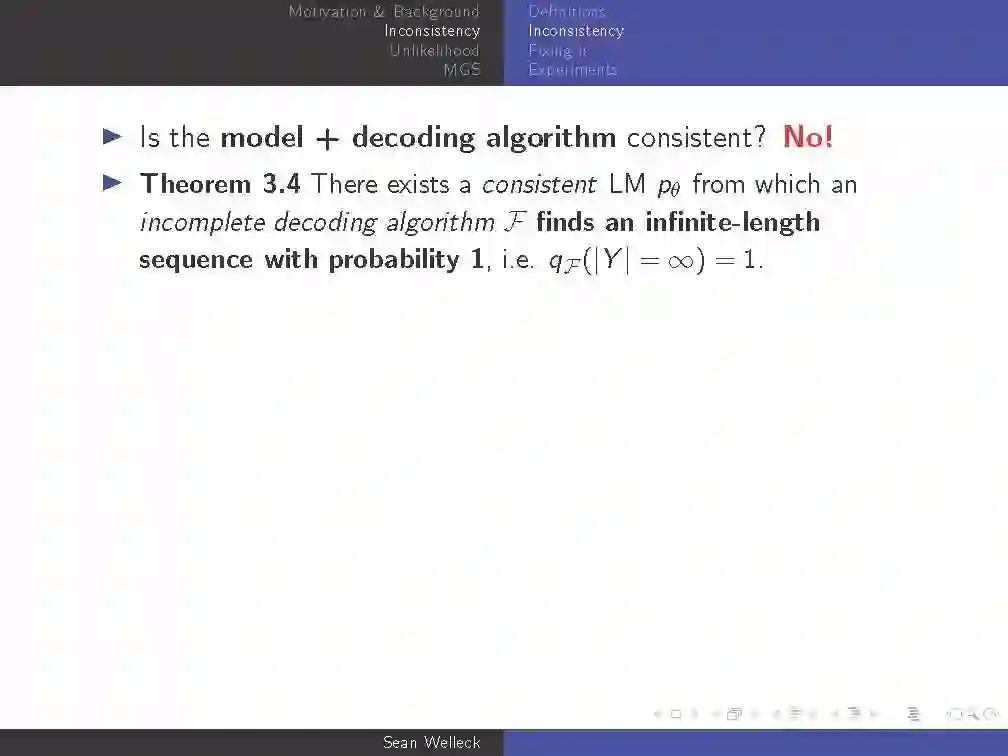

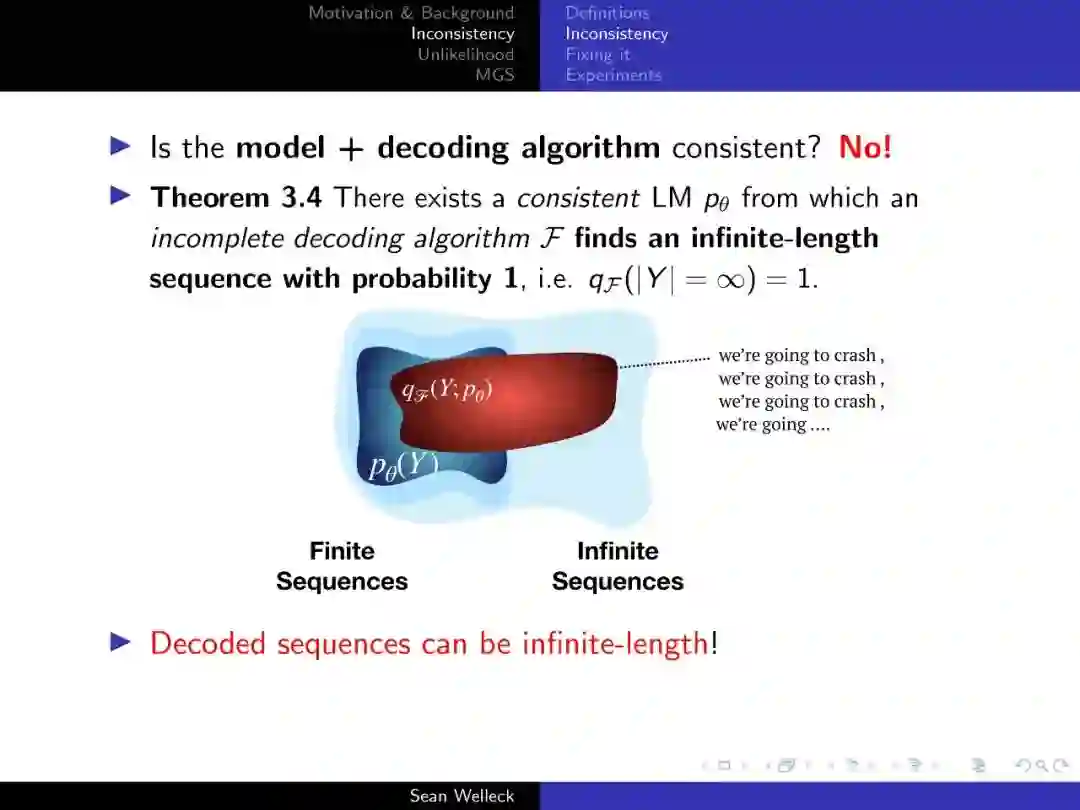

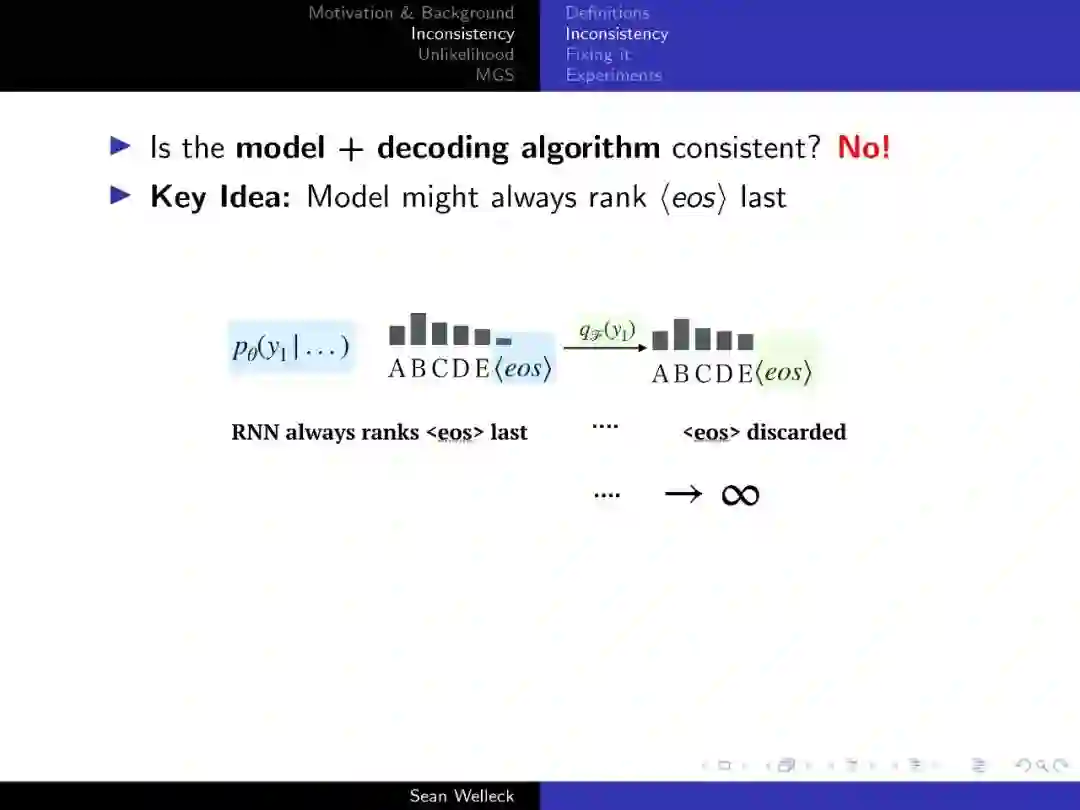

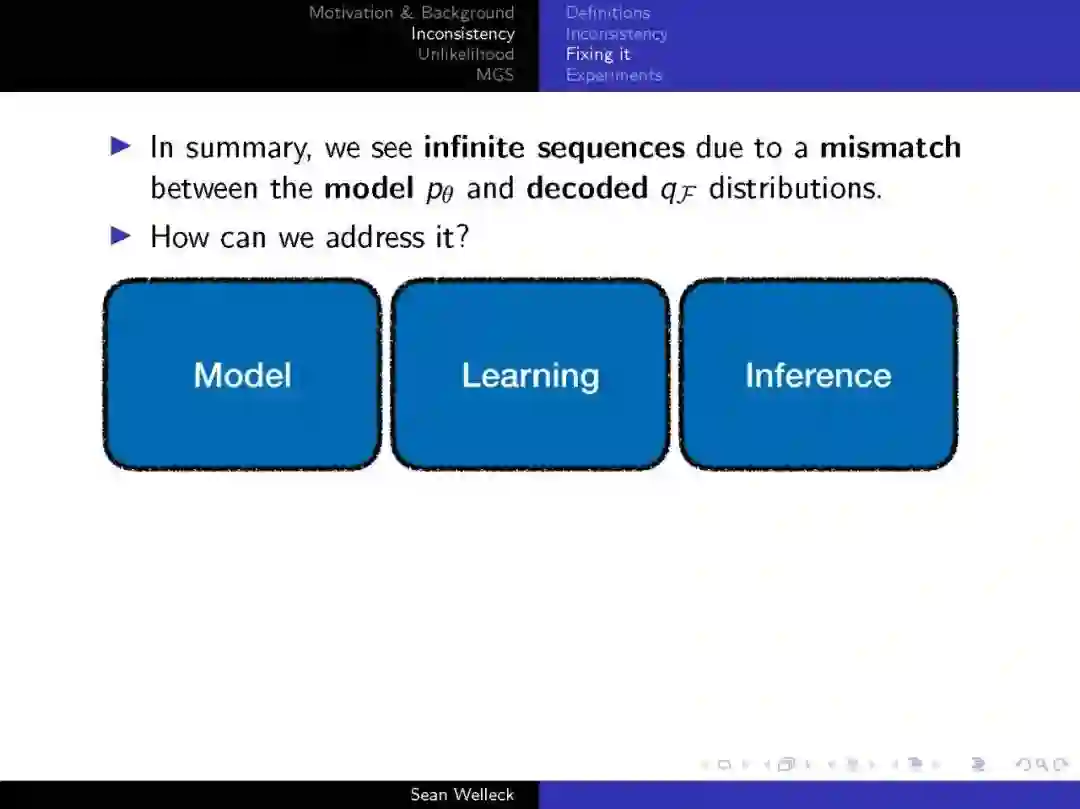

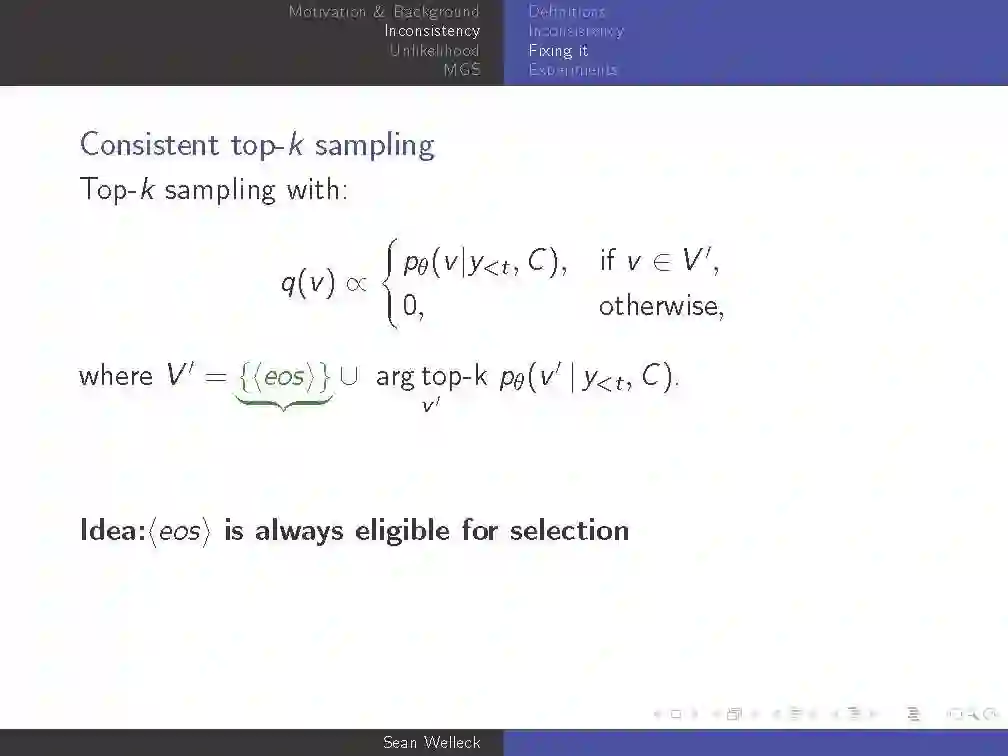

用最大似然估计训练的神经序列模型已经成为建模和生成文本的标准方法。然而,最近的研究发现了这些模型的问题。在这次谈话中,我们研究了在实践中出现的最大似然学习的退化性质,激发了新的学习方法。我们使用在生成文本中观察到的三个特性来描述简并性:非终止性、逻辑不连贯性和重复性。为了研究非终止性,我们发展了一个理论,允许我们正式证明传统的文本生成方法可以生成具有高概率的无限长序列。为了减少这三种类型的退化,我们开发了两种学习算法:非似然训练(惩罚特定任务的文本属性)和最大似然引导参数搜索(直接优化序列级损失)。

https://europe.naverlabs.com/research/seminars/neural-text-degeneration-consistency-and-learning/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“NTD93” 可以获取《【纽约大学Sean】神经文本退化:一致性和学习,93页ppt》专知下载链接索引

登录查看更多