NeurIPS 2019大奖公布!Jeff Dean推荐攻略:你该如何参加13000人的NeurIPS大会?

新智元报道

新智元报道

来源:NeurIPS 2019

编辑:小芹、大明

【新智元导读】NeurIPS 2019今天揭晓了杰出论文奖、杰出新方向论文奖、经典论文奖等重磅奖项,其中微软华人研究员Lin Xiao获得经典论文奖。此外,如何在突破13000人的大会上收获最大,我们带来了Jeff Dean 点赞的超级参会攻略,上 新智元小程序 了解更多!

杰出论文奖&杰出新方向论文奖

在会议上突出最优秀的论文一直是NeurIPS的传统。杰出论文是如何评选出来的呢?NeurIPS 2019杰出论文委员会成员包括Bob Williamson, Michele Sebag, Samuel Kaski, Brian Kingsbury 和 Andreas Krause,他们提出如下推荐。

杰出论文委员会被要求从已选作oral presentation的论文中进行选择。在阅读这些论文之前,他们同意以下准则作为评选的指导。

长期潜力——专注于主流领域,而不是旁枝末节。很可能在未来的几十年里,人们仍然会关心这个问题。

洞察力——提供新颖的(并希望是深刻的)理解;不仅仅是显示出几个百分点的性能改进。

创造性/意想不到/哇——以一种创造性的新方式看待问题;得到一个让读者惊讶的结果。

革命性——将彻底改变人们未来的思维方式。

严谨——无懈可击的严谨。

优雅——优美,整洁,流畅。

现实主义——不夸大其重要性。

科学性——确实可以证伪。

可重复性——结果实际上是可重复的;有可用的代码,并且可以在多种机器上工作;可用的数据;完整详细的证明。

委员会还同意希望避免的一些标准:

效率低下——避免那些仅仅出于资源挥霍而引人注目的工作(主要由于浪费大量资源而获得更高的排名)

趋势性——想法很新潮,但可以通过其他方法以更有效的方式来实现。

过于复杂——论文涉及了不必要的复杂性。

最后,他们决定增设一个“杰出新方向论文奖”(Outstanding New Directions Paper Award),以突出那些为未来研究开辟新道路的杰出工作。

他们可以看到论文,审稿意见以及来自(资深)领域主席的评论。

然后,他们进行了初步分类,得到一个三篇论文的短名单和一个八篇论文的长名单。然后,委员会成员各自对这八篇论文进行了评估。每位委员会成员都给每篇论文一个等级。然后,他们互相分享排名。委员会成员也可能寻求更多的专家意见(并在作出决定时加以考虑)。

最终获奖者如下:

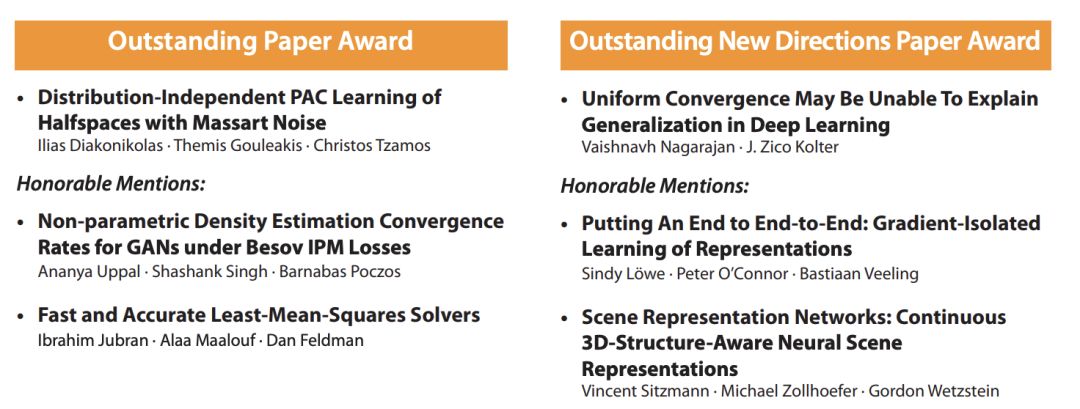

杰出论文奖(Outstanding Paper Awards)

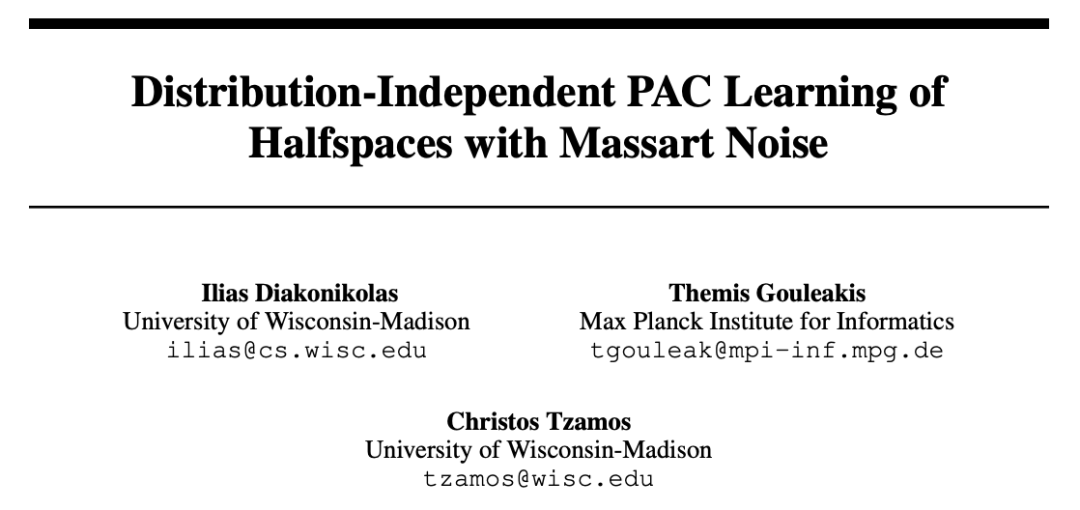

论文标题:Distribution-Independent PAC Learning of Halfspaces with Massart Noise

作者:Ilias Diakonikolas、Themis Gouleakis、Christos Tzamos

机构:威斯康辛大学麦迪逊分校、马普所

论文地址:https://papers.nips.cc/paper/8722-distribution-independent-pac-learning-of-halfspaces-with-massart-noise

本文研究了在训练数据中存在未知,有界标签噪声的情况下,用于二元分类的线性阈值函数的学习。它解决了一个长期存在的根本性问题,并提出一种有效的学习算法。本文在机器学习的一个核心开放性问题上取得了巨大进展:在Massart噪声下有效地学习半空间(half-space)。举个简单的例子,在1% Massart噪声下,即使是微弱的学习歧义(误差为49%)也是开放的。该论文展示了如何高效地实现与 Massart 噪声和 epsilon(并如预期那样及时地执行 poly(1/epsilon))相当的超额风险。该算法非常复杂,结果在技术上也难以确定。最终的目的是能够高效地获得与 epsilon(in time poly(1/epsilon))相当的超额风险。

杰出新方向论文奖

论文标题:Uniform convergence may be unable to explain generalization in deep learning

作者:Vaishnavh Nagarajan、J. Zico Kolter

机构:卡耐基梅隆大学、博世人工智能中心

论文地址:https://papers.nips.cc/paper/8722-distribution-independent-pac-learning-of-halfspaces-with-massart-noise

这篇论文提出了本质上是负面的结果,表明许多现有的(基于范数的)深度学习算法的性能界限并没有达到它们所宣称的结果。作者进一步证明,当那些研究者继续依赖于双边一致收敛机制时,他们就无法达到自己宣称的结果。虽然这篇论文没有解决(也没有假装解决)深度神经网络的泛化问题,但它是一个“指路路标”,指引社区去寻找不同的方向。

以下论文获得荣誉提名:

杰出论文奖荣誉提名

论文标题:Nonparametric Density Estimation & Convergence Rates for GANs under Besov IPM Losses

作者:Ananya Uppal、Shashank Singh、Barnabás Póczos

机构:卡耐基梅隆大学

论文地址:https://papers.nips.cc/paper/9109-nonparametric-density-estimation-convergence-rates-for-gans-under-besov-ipm-losses

本文以严格的理论方法表明,在密度估计方面,GAN的性能优于线性方法(就收敛速度而言)。利用先前关于小波收缩的结果,本文为GAN的表征能力提供了新的见解。具体来说,作者在大型函数类别(Besov空间)内的大型损失类别(所谓的积分概率度量)下,得出了用于非参数密度估计的最小极大收敛速度。审稿人认为,这篇论文将对从事非参数估计和GAN的研究人员产生重大影响。

论文标题:Fast and Accurate Least-Mean-Squares Solvers

作者:Alaa Maalouf、Ibrahim Jubran、Dan Feldman

机构:以色列海法大学

论文地址:https://papers.nips.cc/paper/9040-fast-and-accurate-least-mean-squares-solvers

从线性、Lasso回归到奇异值分解和Elastic net,最小均方算法是许多ML算法的核心。本文展示了如何在不损失精度的情况下,将其计算复杂度降低一到两个数量级,并改进了数值稳定性。该方法依赖于Caratheodory定理,建立一个coreset (d维中d2 + 1个点的集合)足以表征凸集中的所有n个点。它的新颖之处在于提出了一种分治算法,在复杂度可承受的情况下(O(nd + d5 log n),其中d << n))提取coreset。审稿人强调了该方法的重要性,因为该方法可以很容易地实现并改进现有算法,还可以扩展到其他算法,因为该方法的递归划分原则具有很强的泛化性。

杰出新方向论文奖荣誉提名

论文标题:Putting An End to End-to-End: Gradient-Isolated Learning of Representations

作者:Sindy Löwe、Peter O'Connor、Bastiaan Veeling

机构:阿姆斯特丹大学

论文地址:https://papers.nips.cc/paper/8568-putting-an-end-to-end-to-end-gradient-isolated-learning-of-representations

本文重新审视了深度网络的分层构建,使用了van Oord等人(2018)提出的自监督标准,特别是当前输入的表示与空间或时间相近的输入之间的相互信息。正如审稿人所指出的,感知网络中的这种自组织可能会在算法视角(避开端到端优化、因其巨大的内存占用和计算问题)和认知视角的交叉角度提供新的启发。

论文标题:Scene Representation Networks: Continuous 3D-Structure-Aware Neural Scene Representations

作者:Vincent Sitzmann 、Michael Zollhöfer、Gordon Wetzstein

机构:斯坦福大学

论文地址:https://papers.nips.cc/paper/8396-scene-representation-networks-continuous-3d-structure-aware-neural-scene-representations

本文将CV中的两种主要方法:多视图几何方法和深度表示方法完美地结合在一起。具体而言,本文有三大贡献:1)基于每个体素的神经渲染器,实现了场景的3D感知无分辨率渲染;2)提出一种可微的ray-marching 算法,解决了沿摄像机投射光线寻找曲面交点的难题;3)提出一种潜在的场景表示方法,利用自动编码器和超级网络对场景表示网络的参数进行回归。

经典论文奖(Test of Time Award)

与前几年一样,今年NeurIPS也成立了一个委员会来评选Test of Time Award——10年前发表在NeurIPS上的一篇论文,该论文被认为对研究社区产生了特别重要和持久的影响。

委员会成员包括Amir Globerson, Antoine Bordes, Francis Bach 和 Iain Murray。

他们从NeurIPS 2009的18篇录取论文中评选,这些论文自发表以来被引用次数最多。然后,他们把重点放在那些已经产生了持续影响的论文上,这意味着最近的论文仍然在有意义地引用和借鉴在这些论文中概述的工作上。经典论文的评选原则为“重要贡献、持久影响和广泛吸引力”。

最终,“经典论文奖”的获得者是——

Dual Averaging Method for Regularized Stochastic Learning and Online Optimization(正则化随机学习与在线优化的对偶平均法)

论文作者是雷德蒙德微软首席研究员 Lin Xiao。Lin Xiao 曾就读于北京航空航天大学和斯坦福大学,自 2006 年起就职于微软研究院。他目前的研究兴趣包括大规模优化的理论和算法,机器学习的随机和在线算法,并行计算和分布式计算。

该研究提出了用于在线最优化求解的RDA(Regularized Dual Averaging)方法,是Lin Xiao在微软10年的研究成果。该方法是Simple Dual Averaging Scheme一个扩展,并更有效地提升了特征权重的稀疏性。

论文链接:https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/xiao10JMLR.pdf

Jeff Dean推荐攻略:如何参加13000人的NeurIPS大会?

NeurIPS 2019已经开幕,作为机器学习顶级会议之一,每年都是大牛云集、人山人海,作为参会经验不多的研究人员,如何在这样的会议上得到最多的收获,而不是走马观花的看一圈?

近日,来自南非约翰内斯堡的机器学习工程师Jade Abbott在Medium上分享了自己参加顶会的几点经验之谈,尤其是年轻参会者参考。这个建议贴得到了Jeff Dean的点赞和转发。

以下是Jade Abbott给出的五点建议:

#1 提前计划,关注重点

我遇到了才华横溢的Katja Hofmann博士,我问她如何面对如此内容庞杂的会议,而不会感到不知所措。她说她为会议做了大量准备工作。对于每个session,她都阅读了所有题目和其中的一些摘要,并选择了最多3-4篇对她来说确实很有价值的文章,然后花时间重点研究。此外,与其每天晚上都去参加晚间活动,不如在晚上抽出一些时间为第二天做好计划,这是非常宝贵的。

#2 不必每天晚上都参加活动

继续Katja的建议,请抽些时间。为第二天的会议活动做准备,也可以和朋友吃吃饭。主会议需要耗费大量的体力和脑力,因此充足的睡眠和休息很重要

#3 参加聚会,但不要过于贪杯

NeurIPS上的活动都是传奇色彩的。太棒了,太过挑剔了,但最终这些活动头也会让人头晕目眩(不仅仅是因为我对于高品质鸡尾酒毫无抵抗力)。应该和大学时一样:在午夜之前离开。这样仍然有足够的睡眠来应付未来的活动。

#4 参加会议要有目标

在一次活动中,我遇到了出色的Vukosi Marivate博士,他告诉我他正在与社会学家和政治学家会面,以便可以共同开展工作。Muthoni Wanyoike和Benjamin Rosman博士经常会面与人们谈论深度学习Indaba。

我注意到了一种趋势:人们除了聆听和学习外,还有意制定了明确的目标。毕竟,很少有这么多人关心同一件事,不明确目标就太可惜了。

我自己的一些目标包括:

社区建设与支持:

我参加了WiML和Blackin AI研讨会。我花了不少时间和他人建立联系,倾听他人的想法,并为未来继续参会制定计划。观看并支持来自非洲该领域的年轻研究人员的研究成果展示真是太好了。如果你感到不知所措,请找对你的人:他们将帮助你在混乱和不知所措中找到目标。

寻找合作者:这种顶会是找到与更好的人共事的好地方!

聆听领域内大牛的演讲:如果你来自一个遥远的国家,观看所在领域的领导者在小组中相互争论的机会很少,参加顶会就成为一个难得的机会!

探索新的有趣的研究领域:我参加了因果关系研讨会。我不知道发生了什么,但是我确实理解了,然后发现了令人着迷的东西,然后在回家的飞机上买了《原因之书》(Book of Why)。

尽力挖掘所在领域:这里的意思是“利用与探索”,也就是找到更多与你一样为之真正兴奋的人,并交流思想,提出详细的问题。

作者参加DL Indaba活动时与强化学习之父Richard Sutton的集体自拍照

和自己的偶像见面:跟他们合影,或者问一直想问的问题(不要像我一样,在Jeff Dean面前显得茫然而尴尬)

寻找导师,或自己成为导师:对于年轻研究人员而言,没有什么比让某人向他们提供有关其成果的反馈更有价值了。如果你掌握专业知识,那么学术会议是指导年轻研究人员的绝佳之地。我知道,在非洲的许多机构中,学生有时并没有导师(或者至少没有在该领域有经验的导师),因此,来自专业人士的一些有建设性的反馈非常有价值。

#5对抗冒名顶替综合症

如果你并非出身名校,或者来自遥远的国家,或者刚从工业界重返研究领域,突然身处周围全是AI专家的环境,有时会感到不知所措。可能他们讨论的话题你几乎完全没听说过,也不知道原理,看上去可能永远无法理解眼前正在发生的一切。

这时候很容易产生一个想法,就是自己不配参加会议,周围的研究人员永远不会认为你有任何有价值的东西能够拿出来讨论。在某些时候,我自己也会产生这种感觉。

直到我走进“紧急通讯”Session,观看Nando De Freitas的演讲时,我才意识到,我在群体智能方面的陌生背景(我的硕士专业是关于蚂蚁和蜜蜂的交流策略研究)以及在NLP方面的较新经验,为我提供了审视该活动中成果的独特视角。

你来参会,当然有自己的价值,当然更配得上参会。保持开放的心态,不要自闭,不要逃避。没有人什么都懂,尽管提出愚蠢的问题,然后慢慢成长。