这有一份关于 2021 年 ML 和 NLP 出版物的统计数据,并以可视化的方式进行展现,例如最高产的作者、机构、主题等。

2021 年是自然语言处理(NLP)和机器学习(ML)非常高产的一年,现在是时候统计一下去年 NLP 和 ML 领域的论文了。

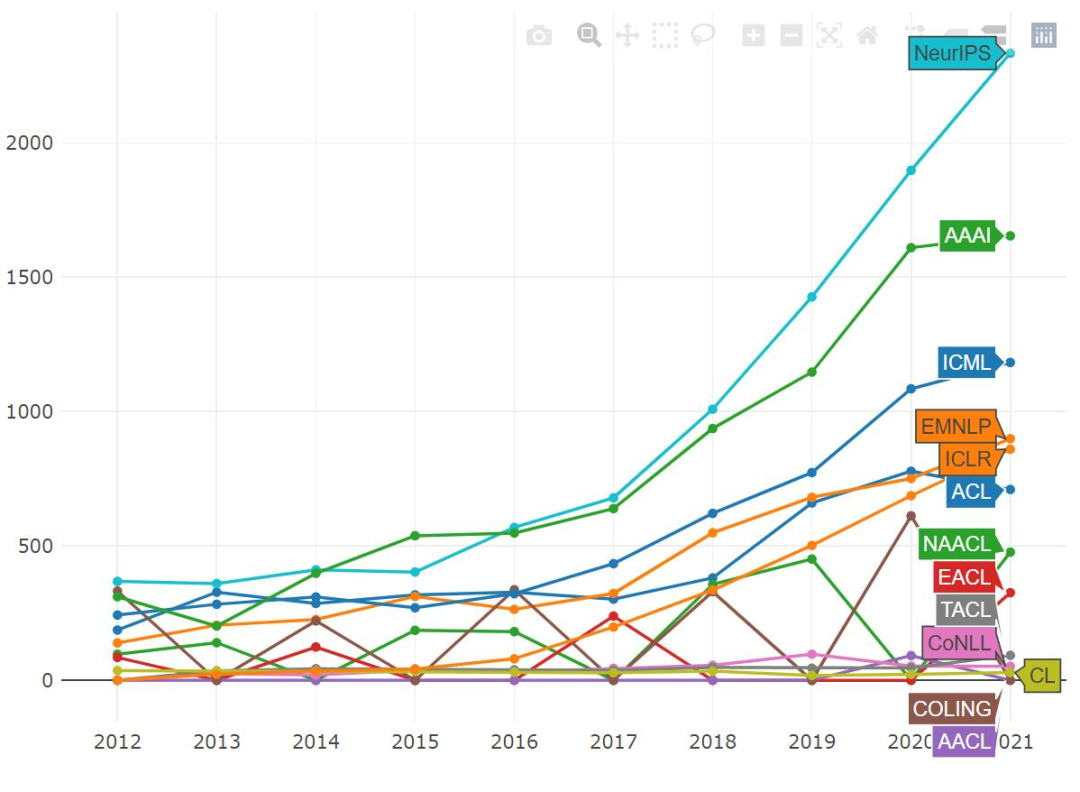

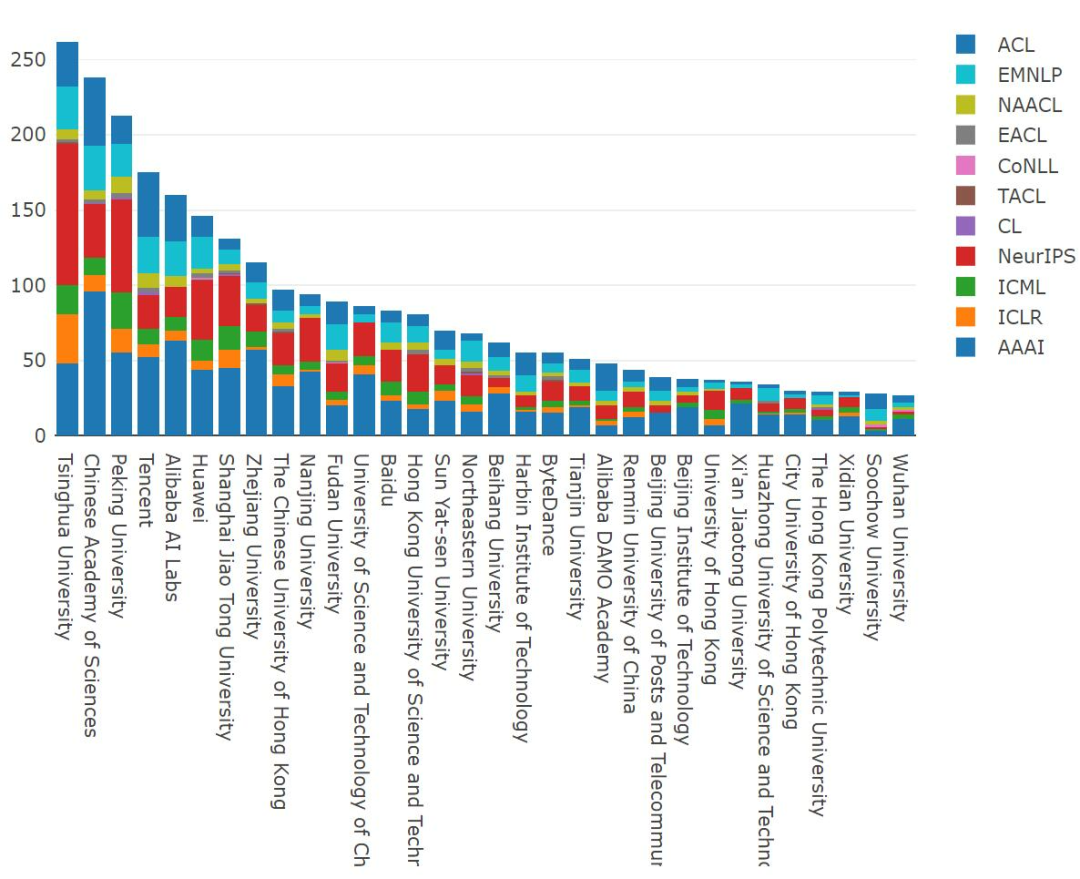

来自剑桥大学机器学习和自然语言处理的研究员 MAREK REI 总结分析了 2021 年经典论文,并归纳了 2021 年 ML 和 NLP 出版物的统计数据,他对人工智能行业的主要会议和期刊进行了分析,它们包括 ACL、EMNLP、NAACL、EACL、CoNLL、TACL、CL、NeurIPS、AAAI、ICLR、 ICML。

论文的分析是使用一系列自动化工具完成的,可能并不完美,会存在一些纰漏和错误。出于某些原因,一些作者开始以模糊的形式发布他们的论文,以防止任何形式的内容复制或自动提取内容,分析过程排除了这些论文。

大多数会议的投稿量不断上升并打破纪录。ACL 似乎是一个例外, AAAI 几乎趋于平稳,而 NeurIPS 仍保持稳定增长。

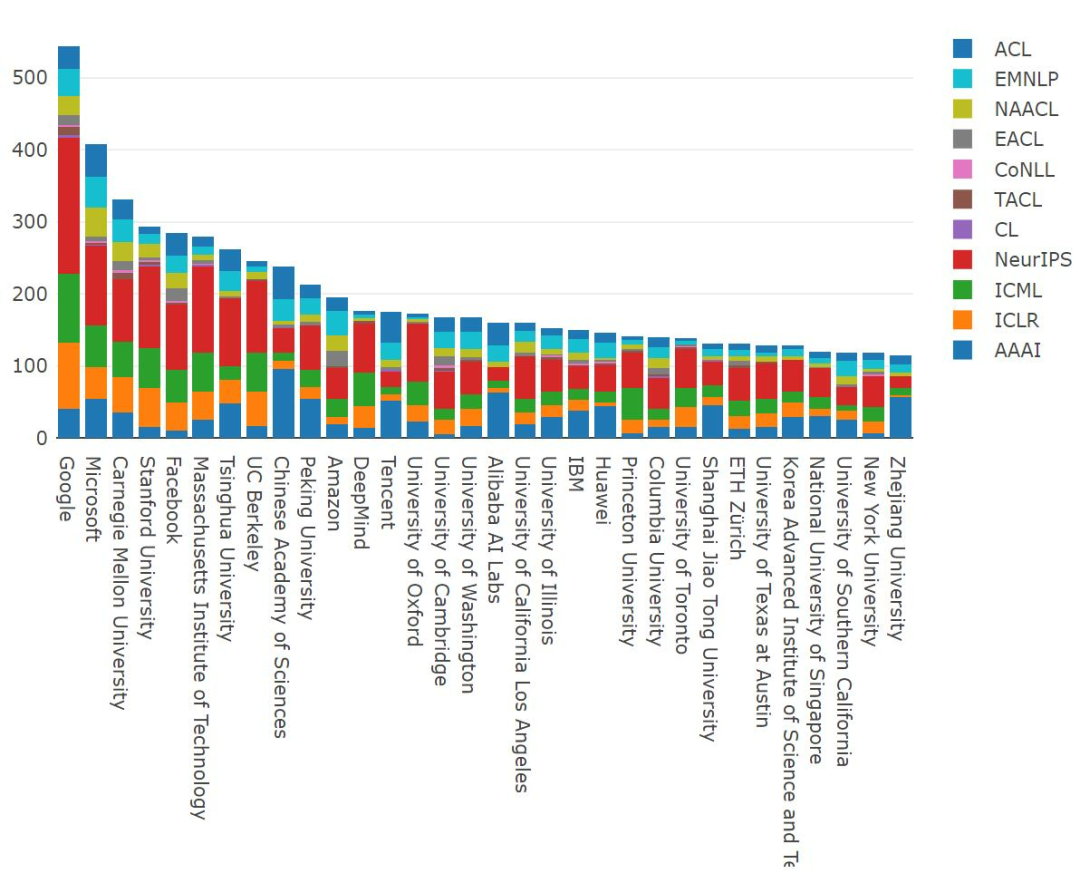

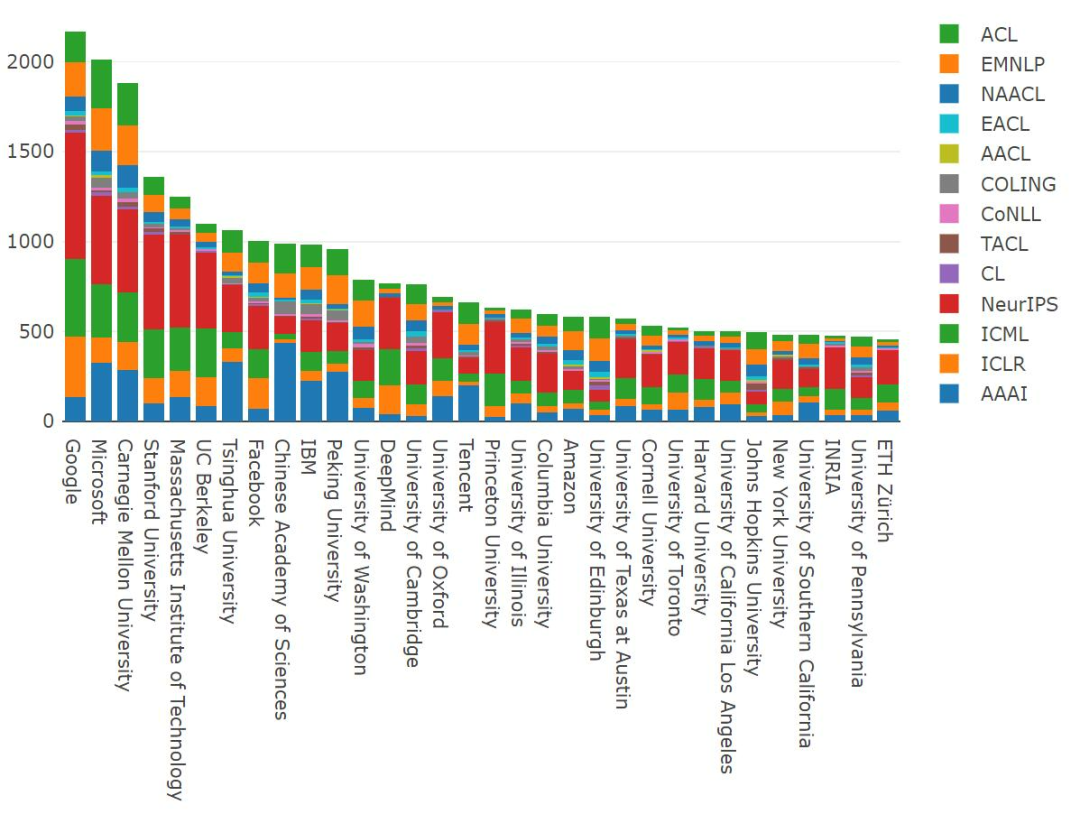

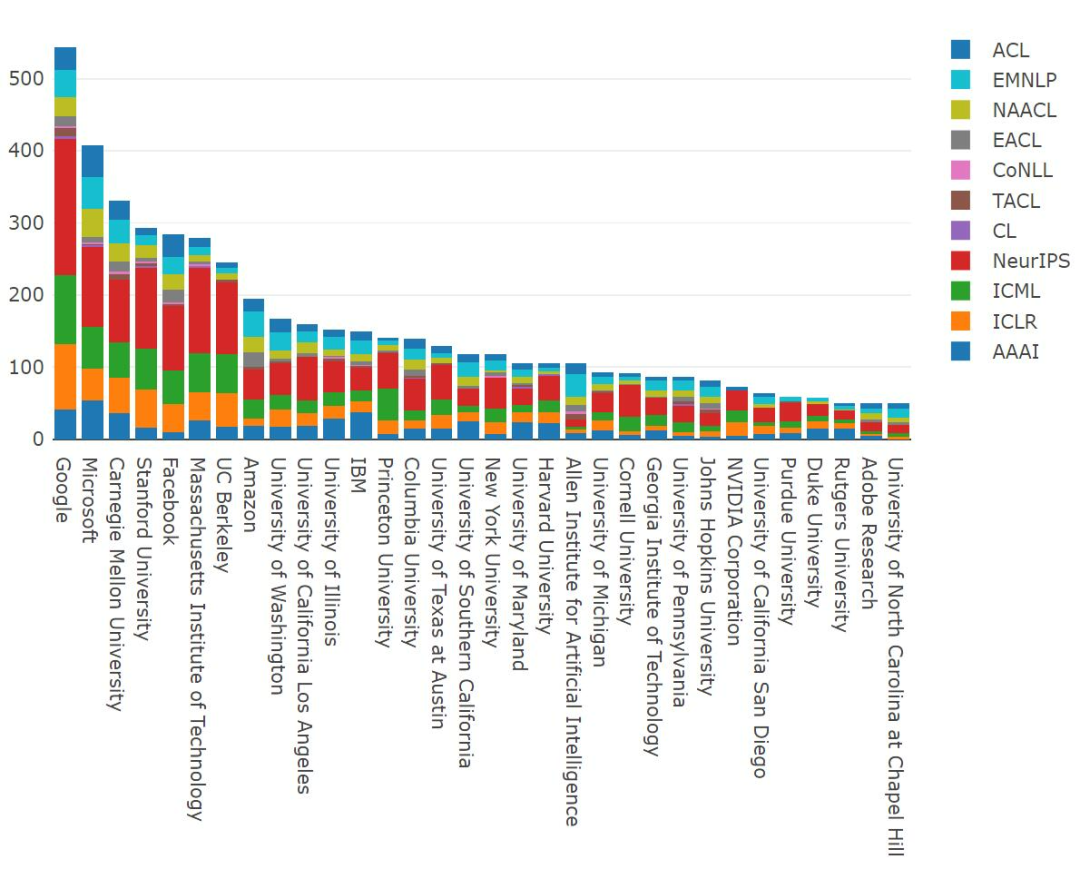

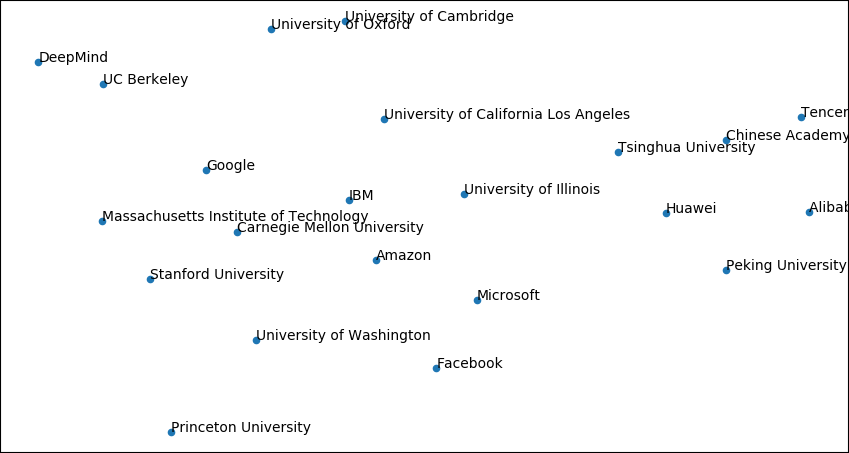

2021 年发表论文数断层式领先的研究机构当属谷歌

;微软排名第二;CMU、斯坦福大学、Meta 和 MIT 排名紧随其后,清华大学位居第七。微软、CAS、亚马逊、腾讯、剑桥、华盛顿和阿里巴巴在 NLP 会议上拥有相当大比例的论文脱颖而出,而其他顶级组织似乎主要关注 ML 领域。

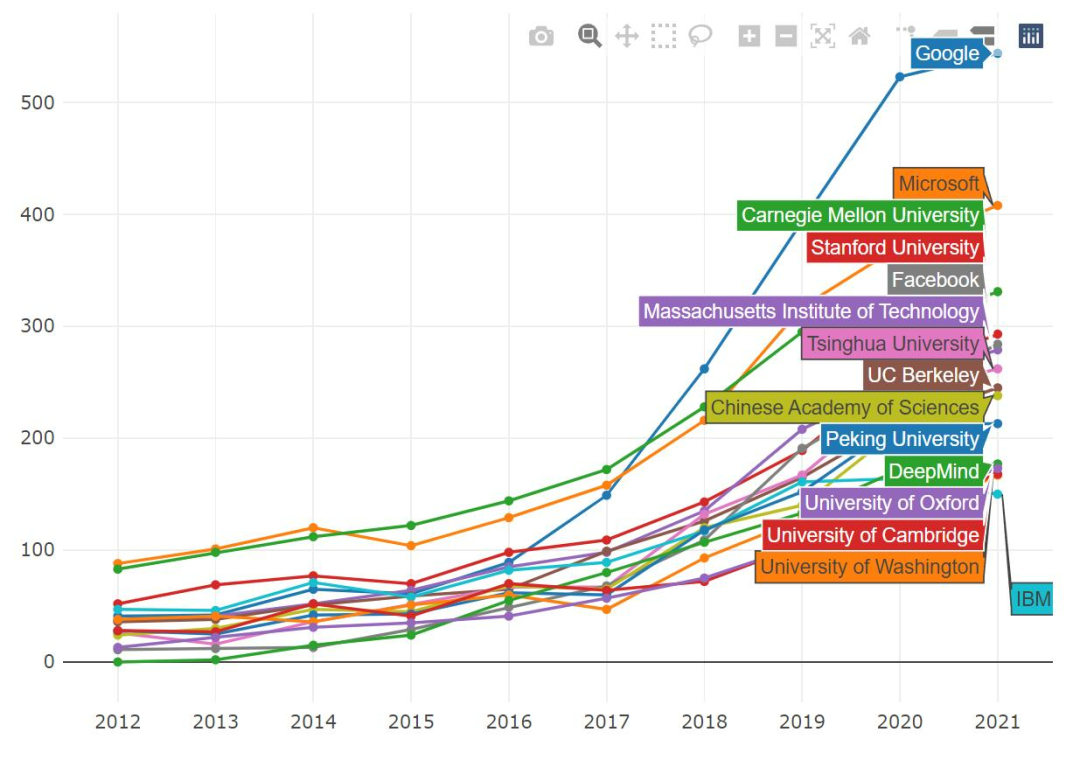

从 2012-2021 年的数据来看,谷歌发表了 2170 篇论文位居第一,超过了微软发表的 2013 篇论文。CMU 发表了 1881 篇论文,排名第三。

大多数机构还在继续增加其年度出版物数量。谷歌发表论文数量以前呈线性增长,现在这一趋势有所缓解,但仍然比以前发表的论文多;CMU 去年有一个平台期,但今年已经弥补了这一点;IBM 似乎是唯一一家发表论文略有下滑的机构。

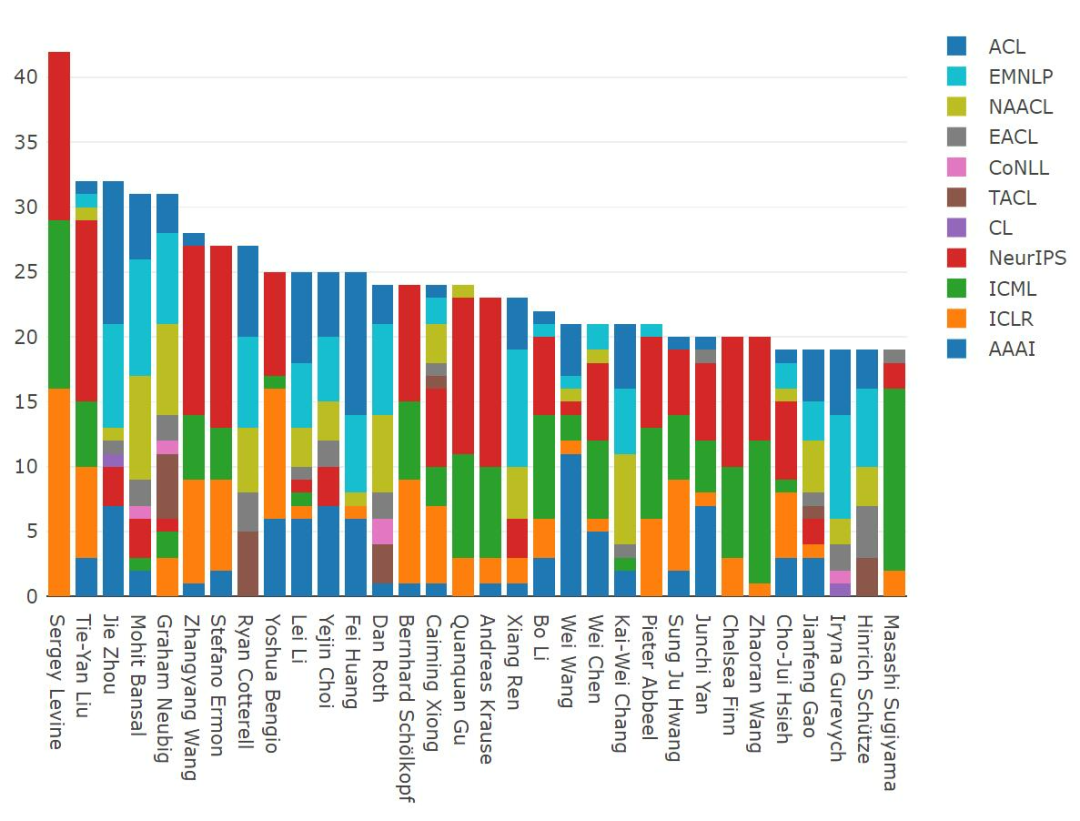

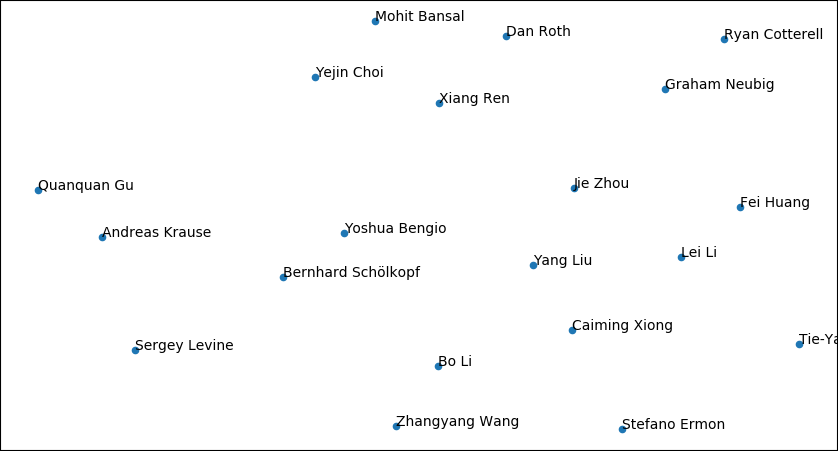

接下来,让我们看看 2021 年发表论文最多的研究人员。Sergey Levine(加州大学伯克利分校电气工程和计算机科学系助理教授)发表了 42 篇论文,排名第一;刘铁岩(微软)、周杰(清华大学)、Mohit Bansal(北卡罗来纳大学教堂山分校)、Graham Neubig(CMU)发表论文数量排名也比较靠前。

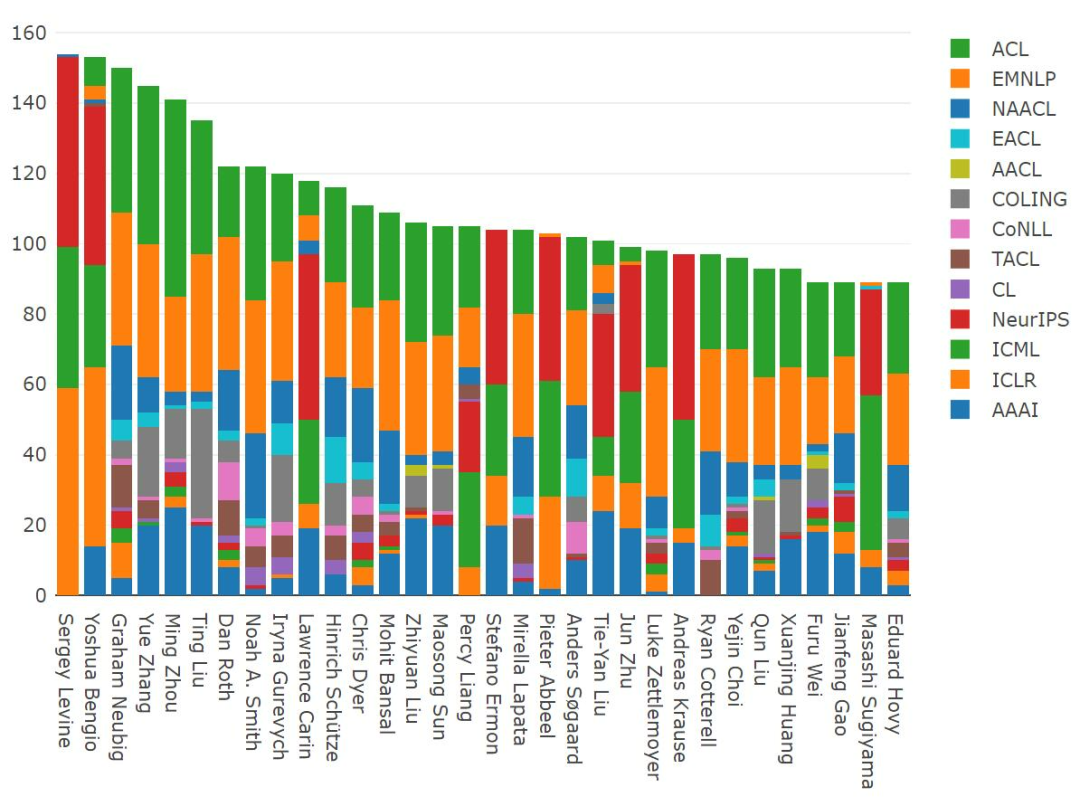

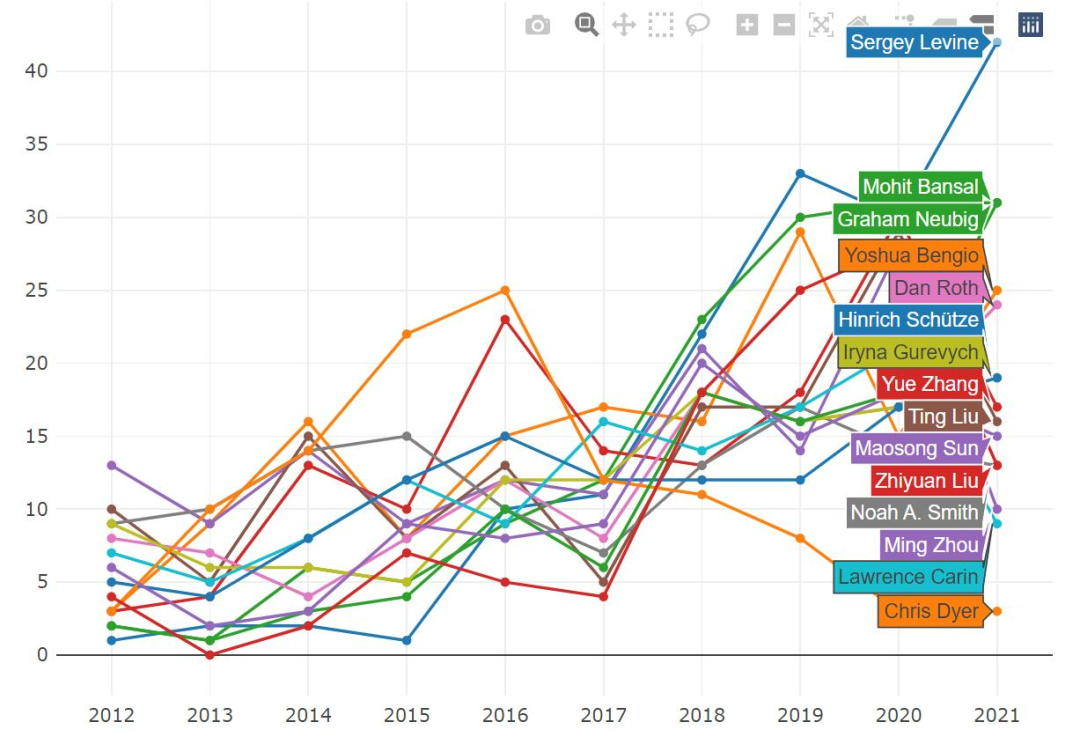

纵观 2012-2021 年,Sergey Levine 发表的论文位居榜首,去年他排名第六,今年一跃排名第一;Yoshua Bengio(蒙特利尔)、Graham Neubig (CMU)、张岳 (西湖大学)、周明 (创新工场首席科学家)、 Ting Liu (哈尔滨工业大学) 等人发表论文数量排名也比较靠前。

Sergey Levine 以相当大的优势创造了新的记录;Mohit Bansal 的论文数量也大幅增加,2021 年发表了 31 篇论文,与 Graham Neubig 持平;Yoshua Bengio 的论文数量在 2020 年有所减少,但现在又上升了。

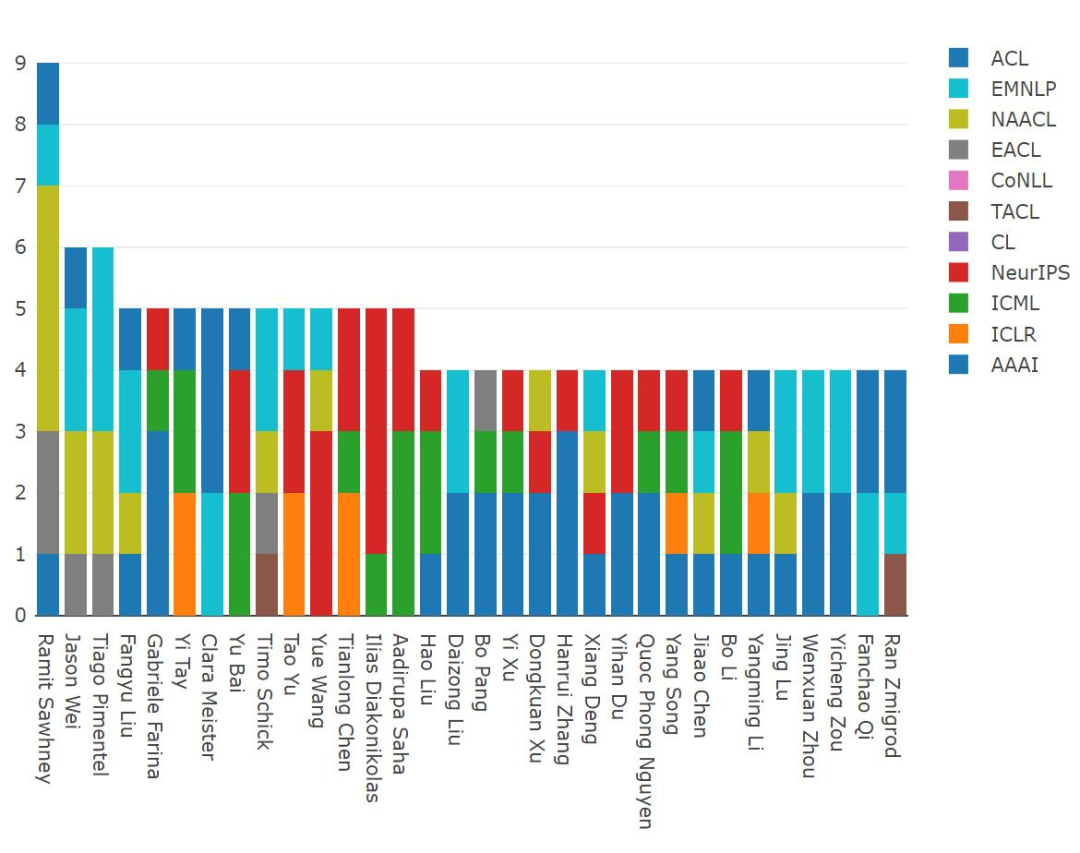

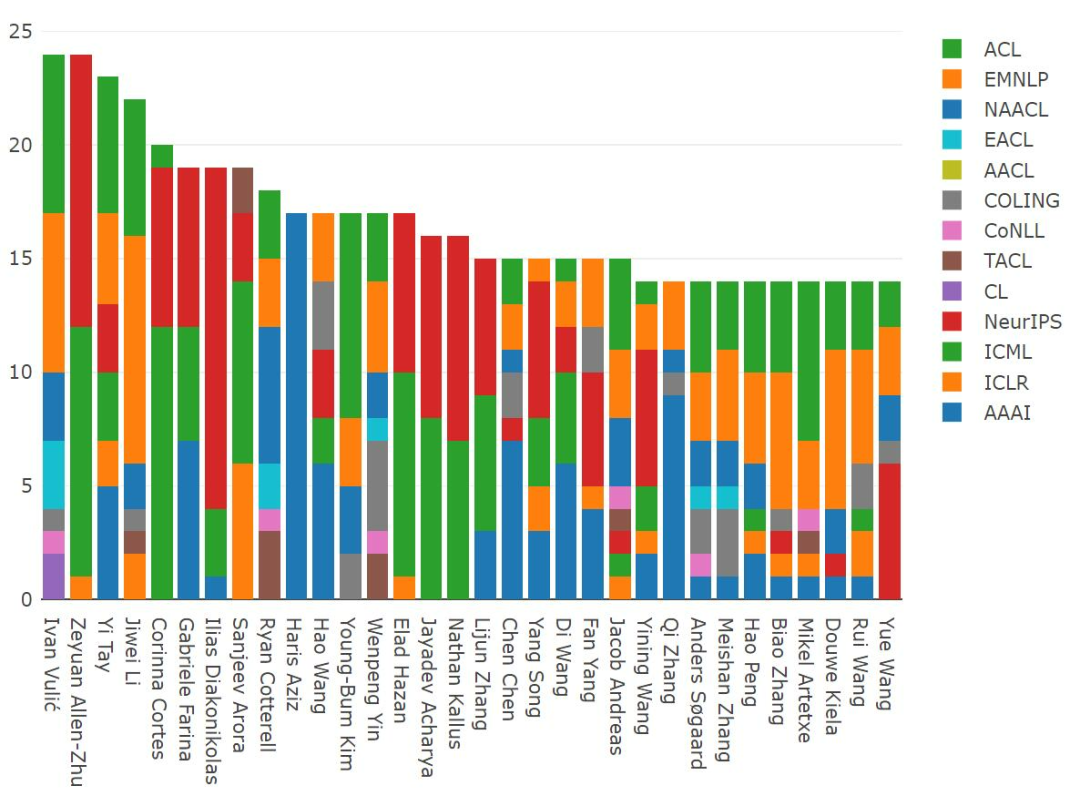

发表论文数量最多的研究人员通常是博士后和导师。相比之下,以第一作者身份发表论文较多的通常是从事实际研究的人。

Ramit Sawhney(Tower Research Capital 技术总监)在 2021 年发表了 9 篇有影响力的论文,Jason Wei(谷歌)、Tiago Pimentel (剑桥大学博士生)分别发表了 6 篇比较有影响力的论文。

从 2012-2021 年分布来看,Ivan Vulić (剑桥大学)和 Zeyuan Allen-Zhu(微软)都以第一作者身份发表了 24 篇比较有影响力的论文,并列第一;Yi Tay (谷歌)和李纪为(香侬科技)排名第二,分别以第一作者身份发表了 23 篇和 22 篇论文比较有影响力的论文;Ilias Diakonikolas (威斯康星大学麦迪逊分校)以第一作者身份发表了 15 篇 NeurIPS 论文。

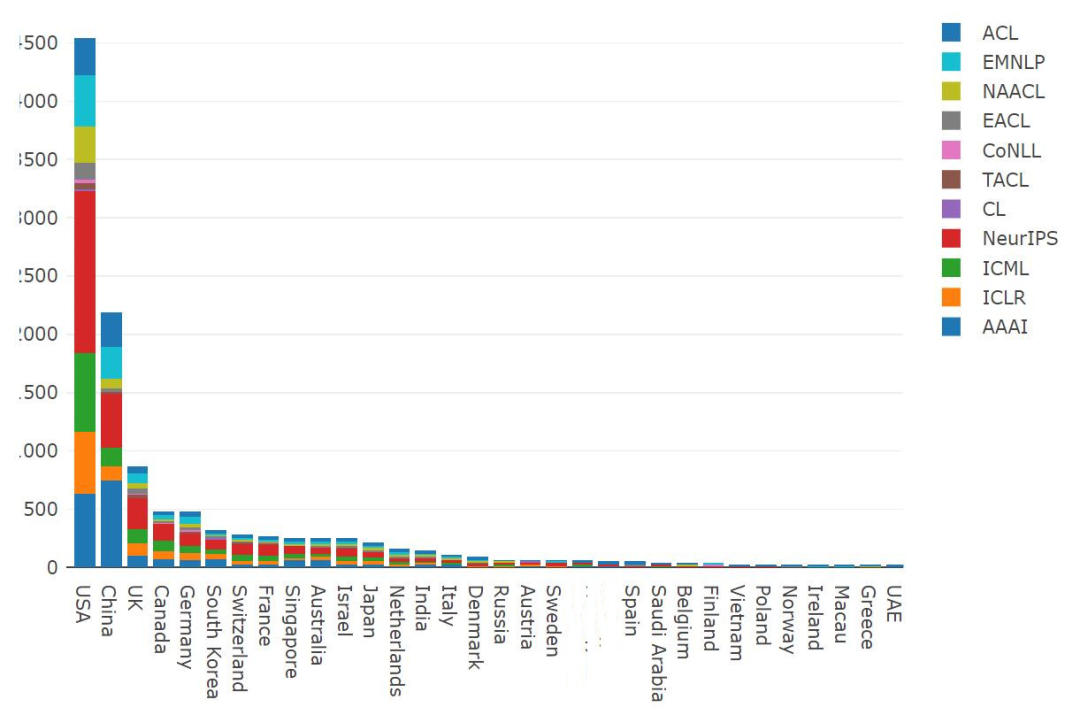

2021 年各国出版物数量,美国出版物数量最多,中国和英国分别位列第 2、第 3。在美国和英国,NeurIPS 所占比例最大,而 AAAI 在中国占比最大。

纵坐标从上到下分别为 500、1000、1500、2000、2500,依次类推

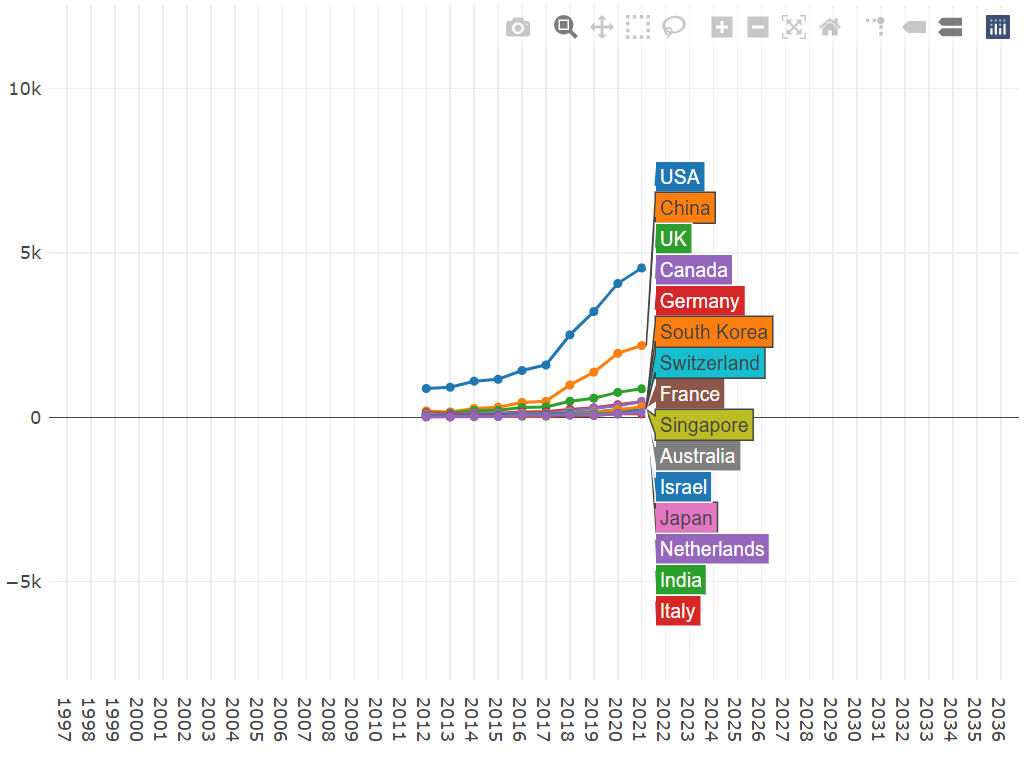

几乎所有排名靠前的国家都在继续增加其出版物数量,并在 2021 年创造了新的记录。对于美国来说,这一增长是最大的,进一步扩大了领先优势。

在美国,谷歌、微软和 CMU 再次位居出版数量之首。

在中国,清华大学、中国科学院和北京大学在 2021 年发表的论文最多。

通过可视化得出,这些组织主要是根据地理位置的接近程度聚集在一起的,公司位于中间。

我们也可以将作者进行可视化,不过这种可视化有些难以理解。

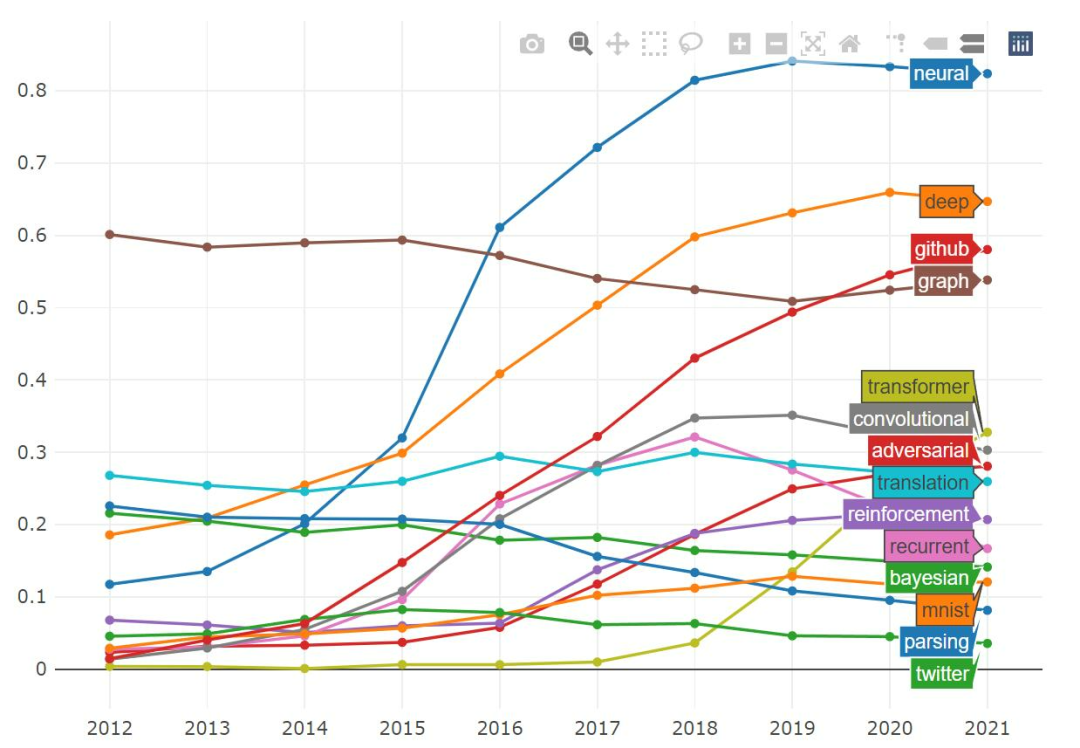

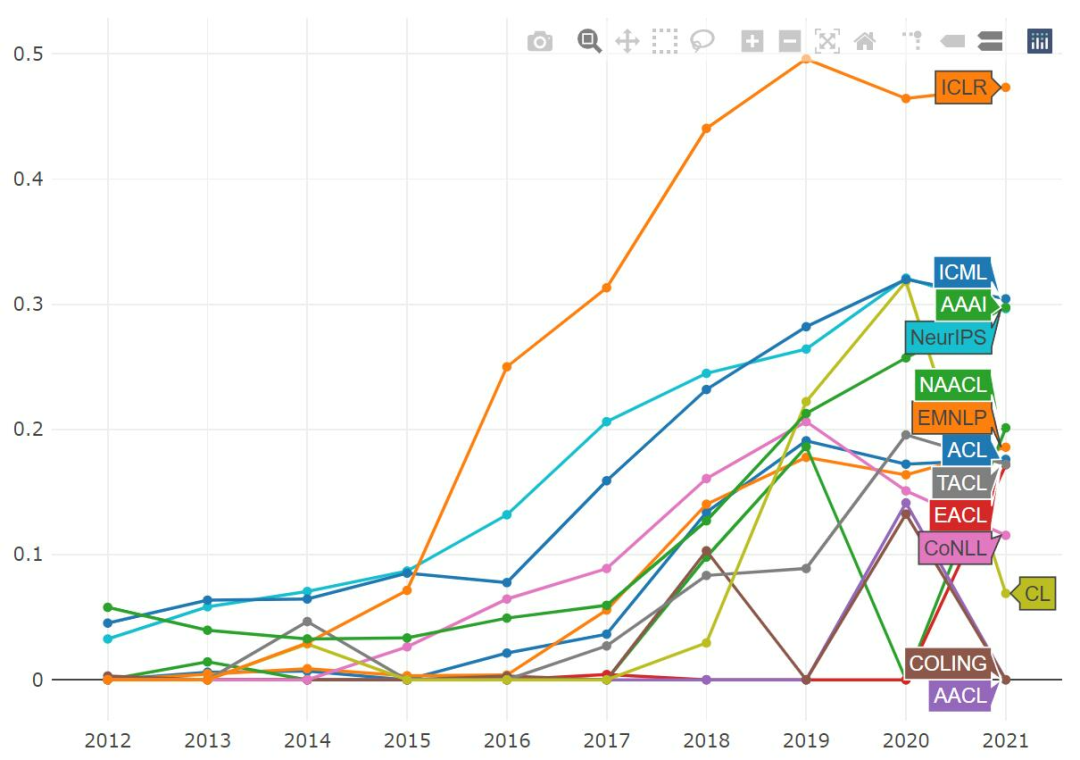

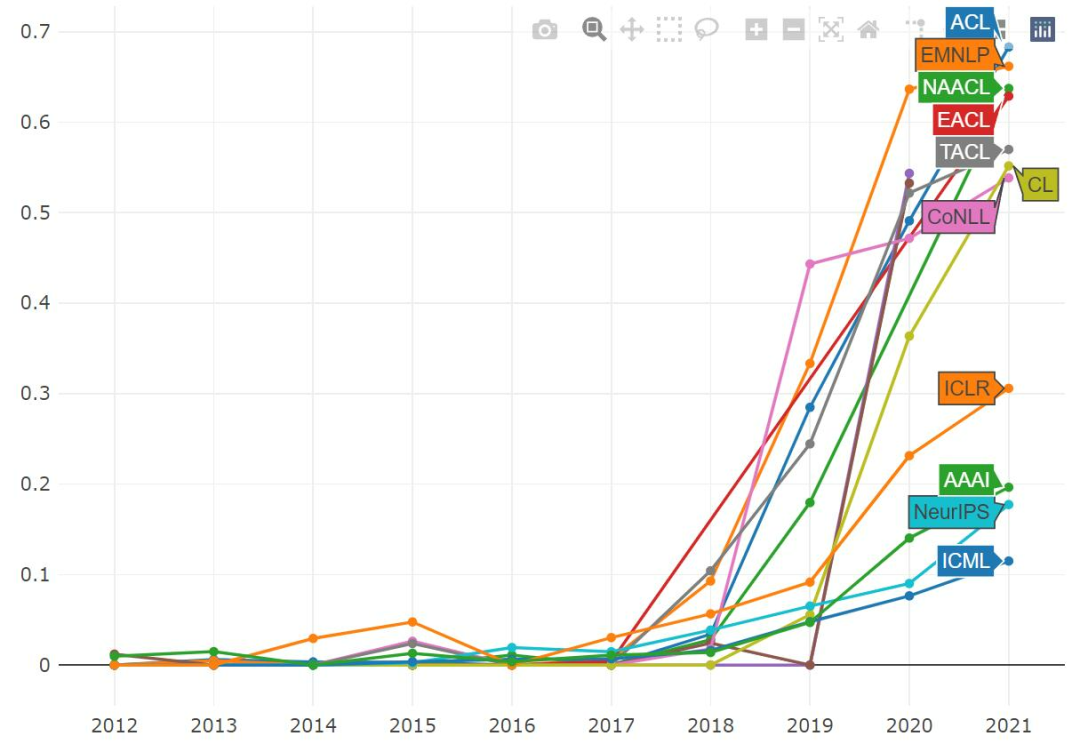

我们还可以绘制包含特定关键词的论文比例,并跟踪这一比例随时间的变化。

「neural」一词似乎有轻微的下降趋势,虽然你仍可以在 80% 的论文中见到它。同时,「recurrent」和「convolutional」的占比也在下降,而「transformer」一词出现在了 30% 以上的论文中。

如果单看「adversarial」一词,我们会发现它在 ICLR 中很常见,几乎一半的论文都提到了它。ICML 和 NeurIPS 中的「adversarial」比例似乎之前已经达到顶峰,而 AAAI 还没有。

在过去的几年里,「transformer」一词变得非常流行。它在 NLP 论文中应用尤其广泛,超过 50% 的已发表论文都包含它,在所有的 ML 会议中,它的受欢迎程度也在稳步上升。

MAREK REI 之前还做过相关统计分析,大家看看都有哪些变化:

原文链接:https://www.marekrei.com/blog/ml-and-nlp-publications-in-2021/

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com