【2020最新干货综述】 基于知识图谱嵌入的链接预测综述, 43页pdf

摘要

介绍

-

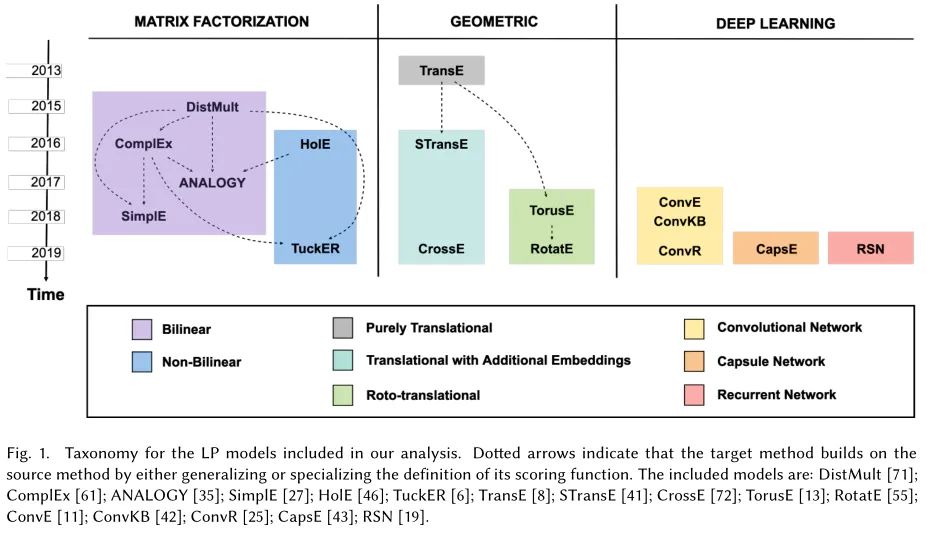

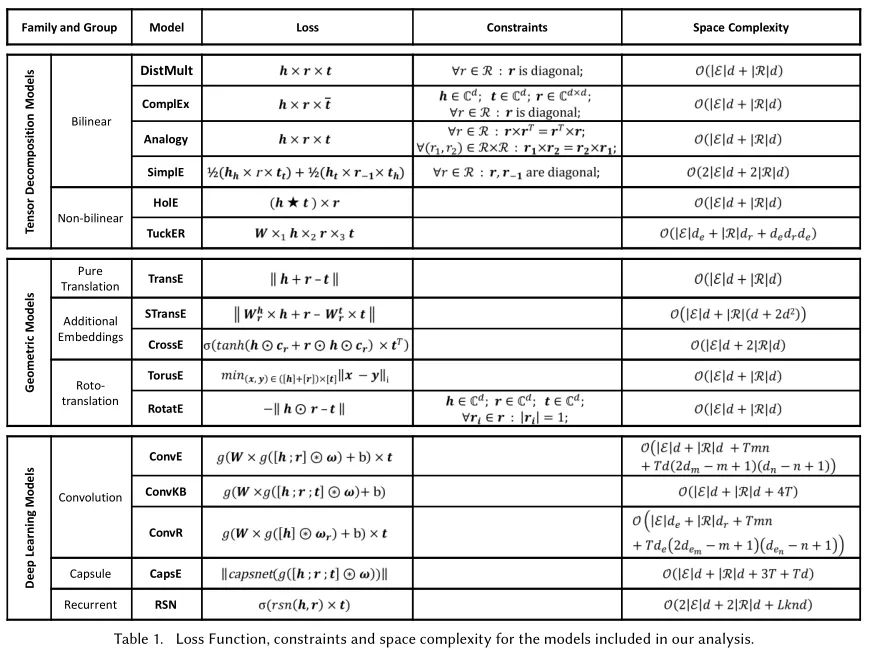

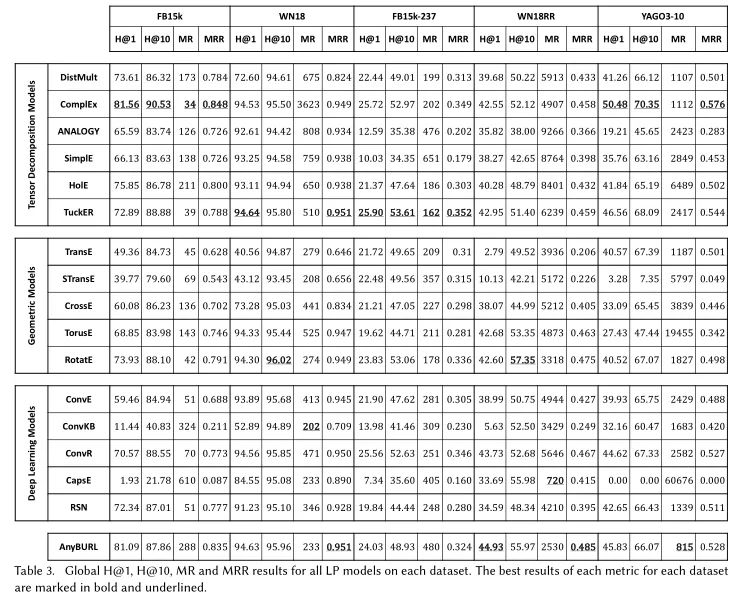

我们考虑了16个模型,属于不同的机器学习和深度学习架构;我们还采用了一个基于规则挖掘的附加的最先进的LP模型作为基线。我们提供了实验比较考虑的方法的详细描述和相关文献的总结,以及知识图谱嵌入技术的教育分类。 -

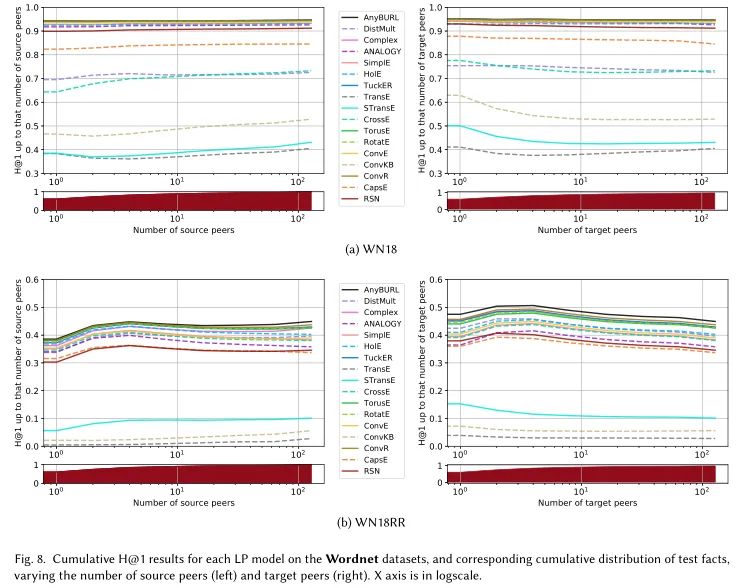

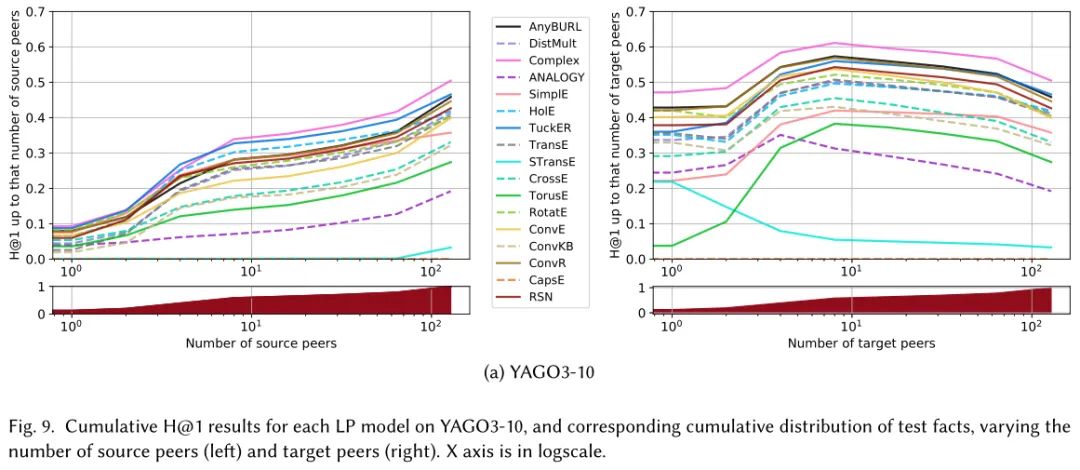

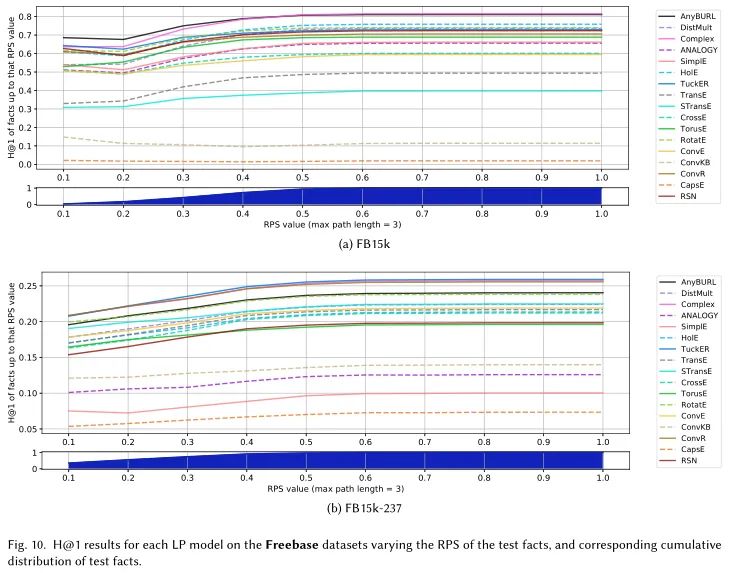

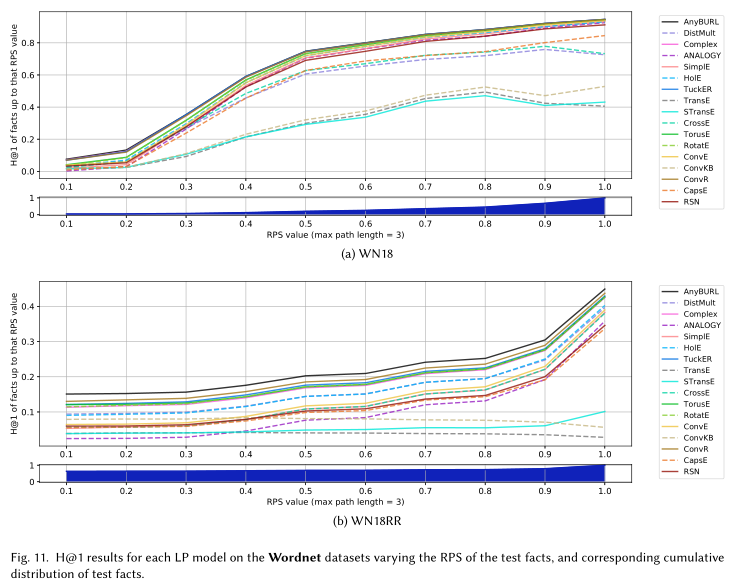

我们考虑了5个最常用的数据集,以及目前用于基准测试的最流行的指标;我们详细分析了它们的特点和特性。 -

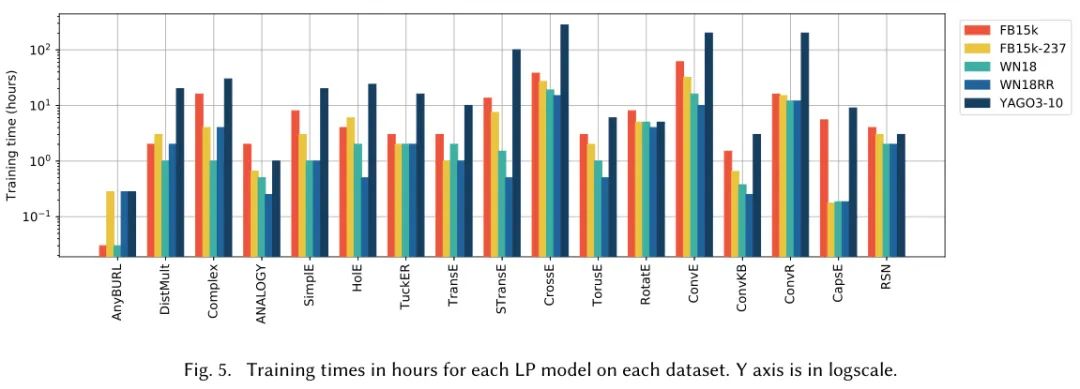

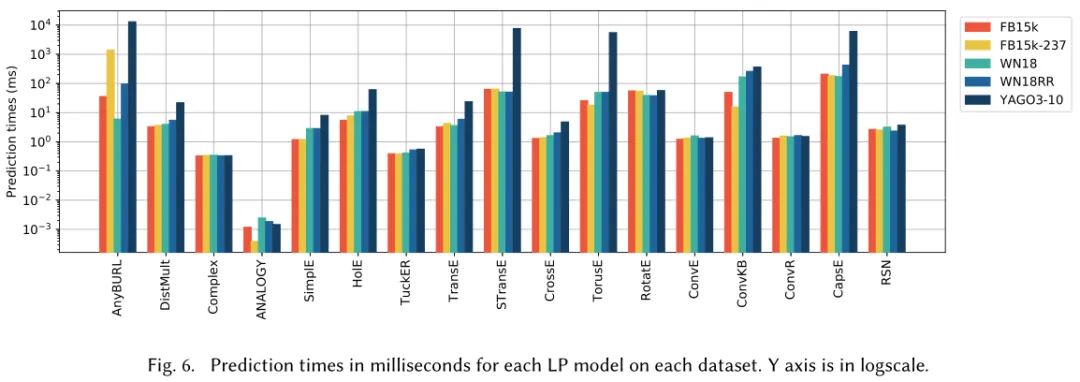

对于每个模型,我们为每个数据集提供了效率和有效性的定量结果。 -

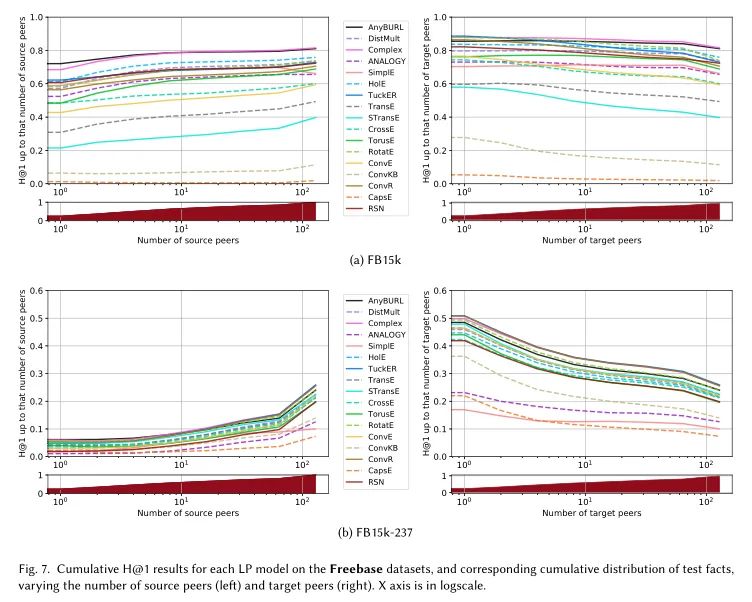

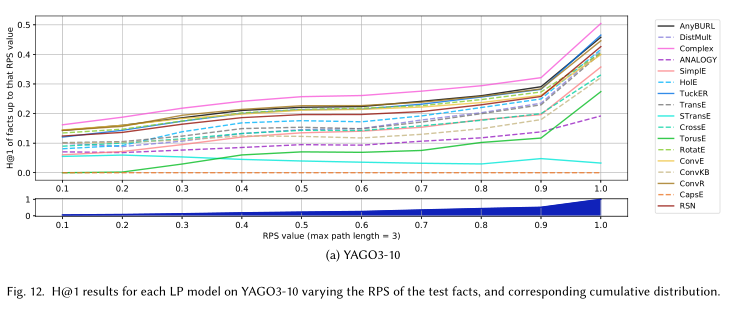

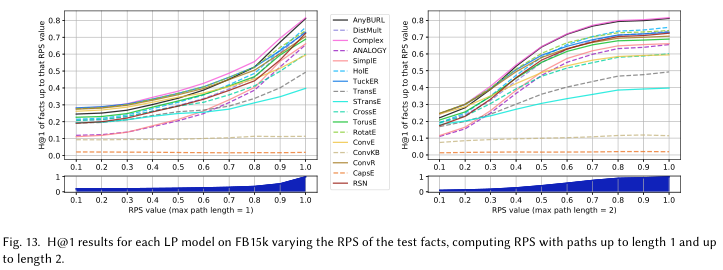

我们在训练数据中提出一组结构特征,并测量它们如何影响每个模型对每个测试事实的预测性能。

方法概述

张量分解模型

几何模型

深度学习模型

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“KGELP2020” 可以获取【2020最新干货综述】 《基于知识图谱嵌入的链接预测综述, 43页pdf》专知下载链接索引

登录查看更多

相关内容

专知会员服务

78+阅读 · 2020年5月11日

Arxiv

6+阅读 · 2019年8月17日