智源承认论文抄袭,相关责任人已离职!

文 | 金磊Alex(凹非寺)

源 | 量子位

“2处属于抄袭,4处引用不规范。”

“相关责任人均已主动离职。”

“大模型研究中心部门重组。”

……

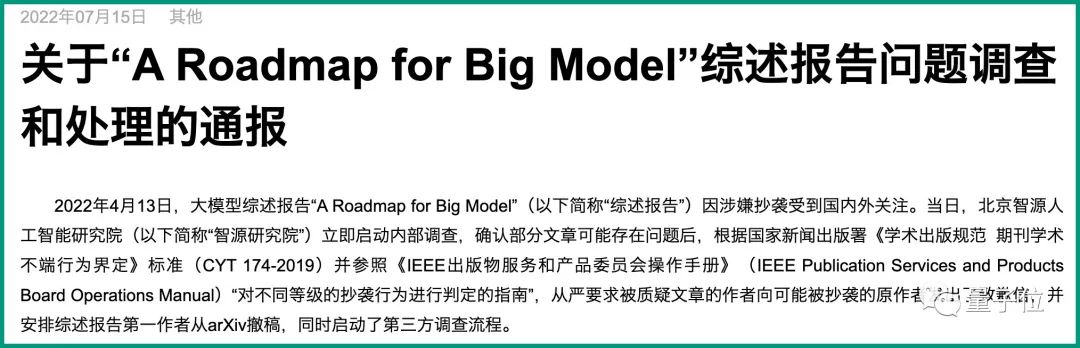

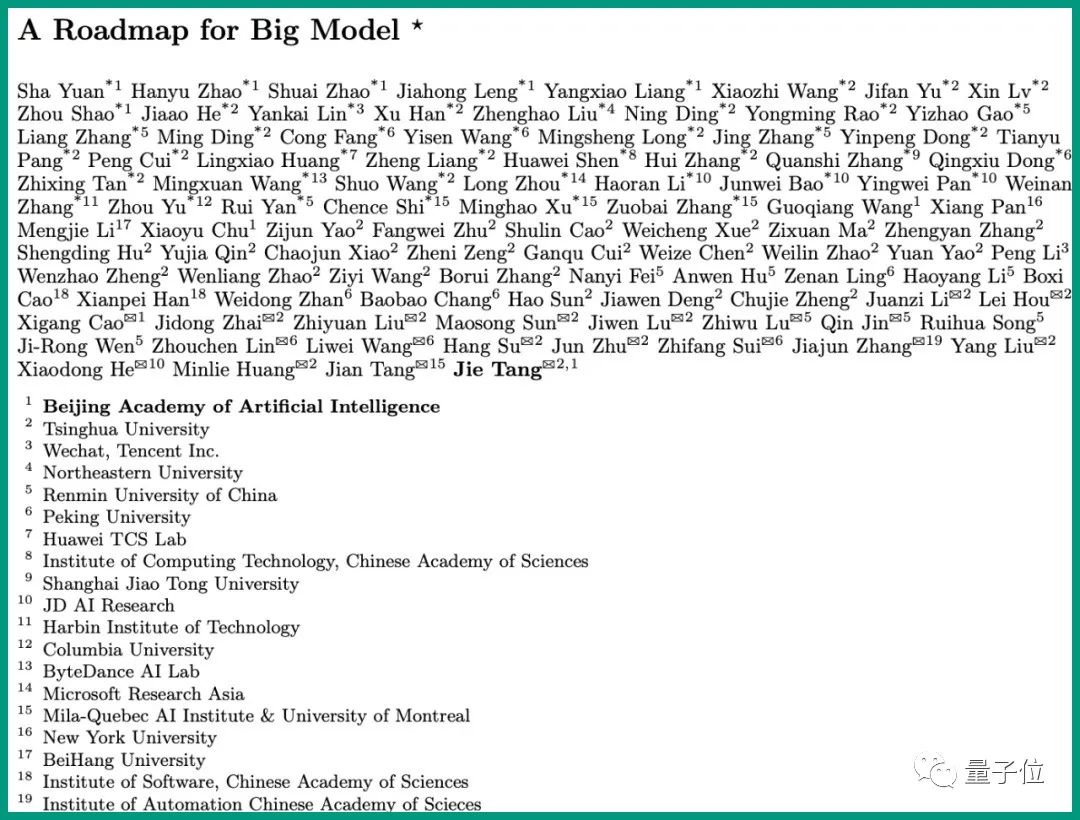

一篇名为A Roadmap for Big Model、由百人联合完成的综述报告,因涉嫌抄袭在国内外学术圈引发了不小的关注。

对此,涉事单位北京智源人工智能研究院,通报了事件调查后的最新结果。

除了刚才提到的几点外,通报还指出了担负这次“抄袭门”事件的主要组织责任人,是智源大模型研究中心人员。

那么引发国内外热议的学术抄袭事件背后,到底发生了什么?

2处抄袭,4处引用不规范

此次“抄袭门”的焦点,即这篇综述报告是由智源研究院大模型研究中心牵头,并邀请了国内外19个机构共100位科研人员撰写。

根据通报的介绍,综述共由16篇独立专题文章组成。除了第12篇之外,每篇文章都都有其对应的撰写作者和通讯作者。

而一个核心的问题便出在了“协作”的过程中。在通报里的“组织失察责任认定”中,智源研究院表示:

智源大模型研究中心人员未严格按照学术出版规范的流程执行,在未与其他作者确认的情况下,于2022年3月26日将综述报告上传至arXiv,负有主要组织责任。

除此之外,这次的通报还对此前网友们对于综述内容的质疑片段做了回应。

首先,智源研究院承认有2处质疑片段属于抄袭。第一个抄袭片段是综述报告第2篇文章的2.3.1节,存在共计179个单词的多句重复。

根据《学术出版规范:期刊学术不端行为界定》中的“论文作者学术不端行为类型”规定:

文字表述剽窃:成段使用他人已发表文献中的文字表述,虽然进行了引注,但对所使用文字不加引号,或者不改变字体,或者不使用特定的排列方式显示。

这个抄袭片段属于这种规定的类型,而且也达到了《IEEE出版物服务和产品委员会操作手册》中,“对不同等级的抄袭行为进行判定的指南”的第5级。

判定的要点是:对一篇文章的主要部分逐字复制,虽有引注但缺乏清晰区分。(注:抄袭共分5级,第1级最严重,第5级最轻微)

对此,通报表示,这篇文章中的两位作者(均为智源大模型研究中心人员)分别担负直接责任和失察责任。

第二处抄袭片段,是第8篇文章的8.3.1节,存在74个单词的整句重复。

负责该段落的作者也是来自智源大模型研究中心的人员,文章发布前未与通讯作者确认,应负直接责任。对此,智源研究院表示:

上述两名作者已经按照IEEE手册的对应纠正措施向原作者致歉,并得到原作者谅解,履行了应该承担的相关学术责任。

除此之外,通报还表示,质疑片段中的4处属于引用不规范。它们分别是:

-

第10篇文章:存在少数重复文字 -

第12篇文章:12.2.3节存在共计36个单词的重复,无整句重复 -

第14篇文章:14.2.2节一处多句63个单词重复 -

第16篇文章:16.1节一处存在多句重复

并且智源研究院对于上述问题所对应的作者也做了通报。至于剩下的被质疑片段,通报表示“属于规范引用”。

“相关责任人均已离职”

在通报的最后,智源研究院还公布了“处理和整改结果”。首先,智源研究院要求可能存在问题文章的作者,向原作者做书面致歉,并且表示“均已得到原作者反馈和谅解”。其次,由于“2处抄袭”的涉事人员均是来自智源研究院大模型研究中心的人员,因此通报决定:

重组该部门。

并且相关责任人均已主动离职。而对于此次发表流程中存在的漏洞,智源研究院表示“已经整改了论文发表流程,并修订完善了科研诚信与学风建设制度”。与此同时,鉴于此次的事件,智源研究院还做了后续的相关计划:

智源研究院计划与学界和业界合作,制定更严谨的文献引用规范,开发论文和代码开源检测工具和系统,避免再次出现类似问题。

事件回顾

在看完最新通报之后,我们也来一起回顾下这件事情的始末。

4月8日,谷歌大脑研究员Nicholas Carlini发文指出:A Roadmap for Big Model这篇文章抄袭了自己最近发表的一篇论文。

他列举了10个抄袭得比较明显的段落,并用绿色标出文字一致的部分。

Carlini发现这个情况的经历也挺戏剧的:他的一个论文合作者本来想看看智源这篇文章有什么值得学习的,结果有些部分越看越奇怪,最后发现原来该论文有些段落直接照搬了他们自己的文章。(吃瓜吃到自己头上 .jpg)

同时通过收集数据初步核查,Carlini发现这篇论文还涉嫌抄袭十余篇来自其他作者的论文。

在Carlini曝光智源这篇文章涉嫌抄袭后,很快引起国内外的广泛关注。连LeCun都评价道:

有网友认为这是一个团队的学生写的,这些学生可能不够清楚学术规范,而其他大部分人都是挂个名。

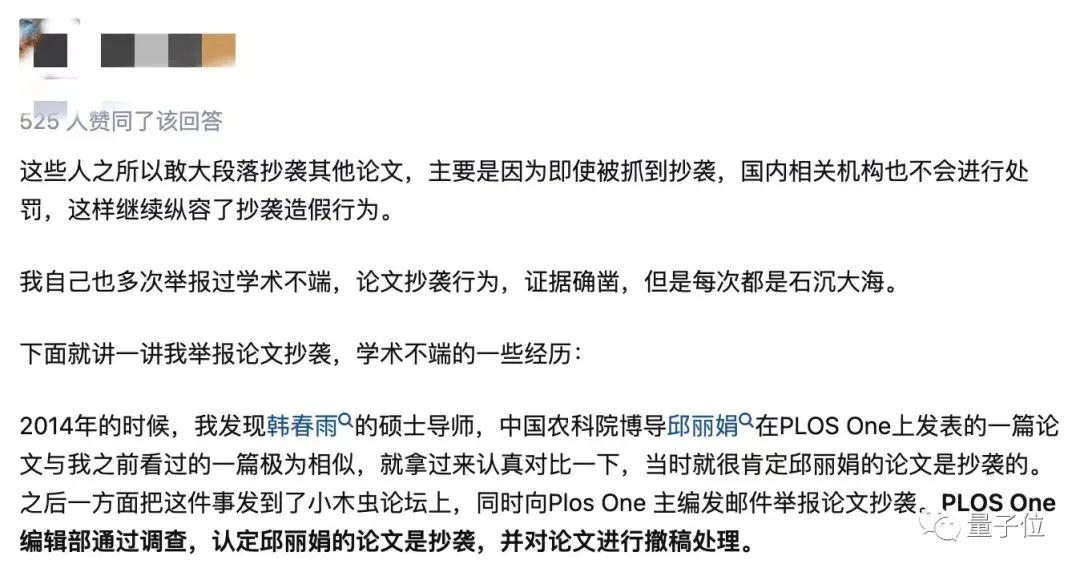

还有人分享了自己遇到过的学术不端的事情。

一位疑似涉事论文的作者出来爆料说,当时留给自己的撰稿时间非常紧迫,只有一周多,他猜留给学生的时间可能更少,所以就出现了大段照搬的情况。

想要解决问题,应该给作者们更充裕的时间和更多机会。随着事情发酵,智源官方也很快做出了回应。

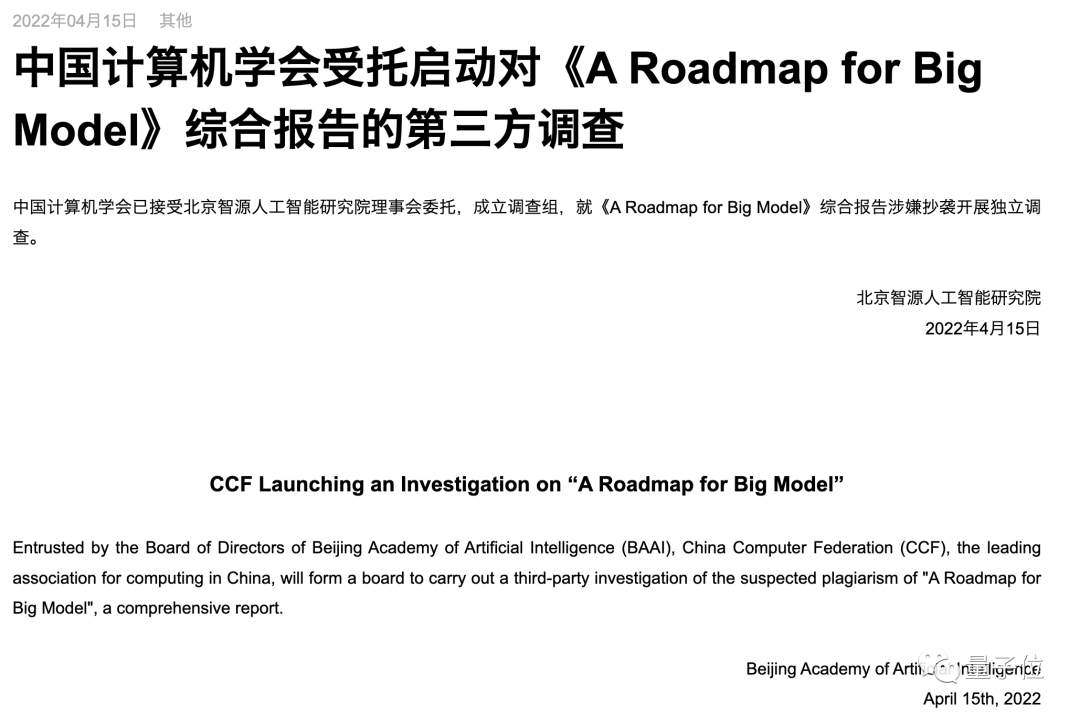

4月13日智源发布了《关于“A Roadmap for Big Model”综述报告问题的致歉信》;两天后又宣布成立调查组,就涉事论文开展独立调查。

7月15日,智源官方通报了调查结果。智源这次的排查机制,以及最后这种公开透明的结果公布,也算是比较妥当的处理方式了。

起初爆料智源论文涉嫌抄袭的Carlini后来也说,这篇文章受到的关注比自己的预期要多得多,所以恳请大家不要把这变成一场“猎巫行动”。

Carlini反对有人提出的“此类事情件中所有相关人员应当立即被解雇、应该被arXiv封禁等”,他劝各位不要对这篇文章的作者们过分苛责,而应该把更多目光投在整个学术领域的风气上。也正如智源在此次通告中所述:

除上述智源研究院相关责任人外,综述报告其他所有作者没有抄袭及学术不端行为。在此对此次事件给这些作者造成的负面影响和困扰表示诚挚歉意!再次诚挚感谢各界朋友对智源研究院的监督和批评!

后台回复关键词【入群】

加入卖萌屋NLP、CV、搜广推与求职讨论群

![]()

[1]https://www.baai.ac.cn/portal/article/index/cid/5/id/423.html

[2]https://www.baai.ac.cn/portal/article/index/cid/5/id/422.html

[3]https://www.baai.ac.cn/portal/article/index/cid/5/id/504.html

[4]https://nicholas.carlini.com/writing/2022/a-case-of-plagarism-in-machine-learning.html

后台回复关键词【入群】

后台回复关键词【入群】