ICLR 2020 | 对神经网络特征表达一致性、可靠性、知识盲点的评测与解释

机器之心编辑部

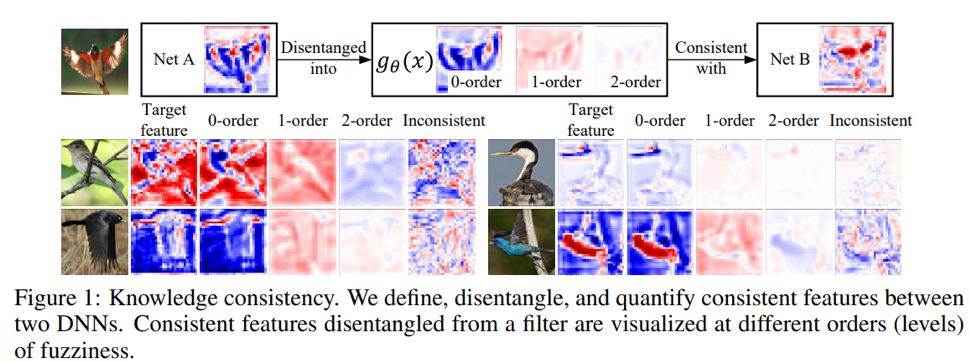

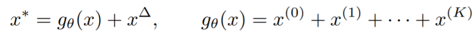

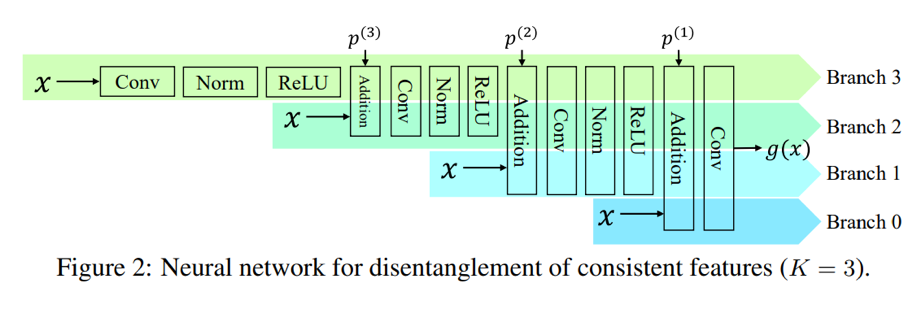

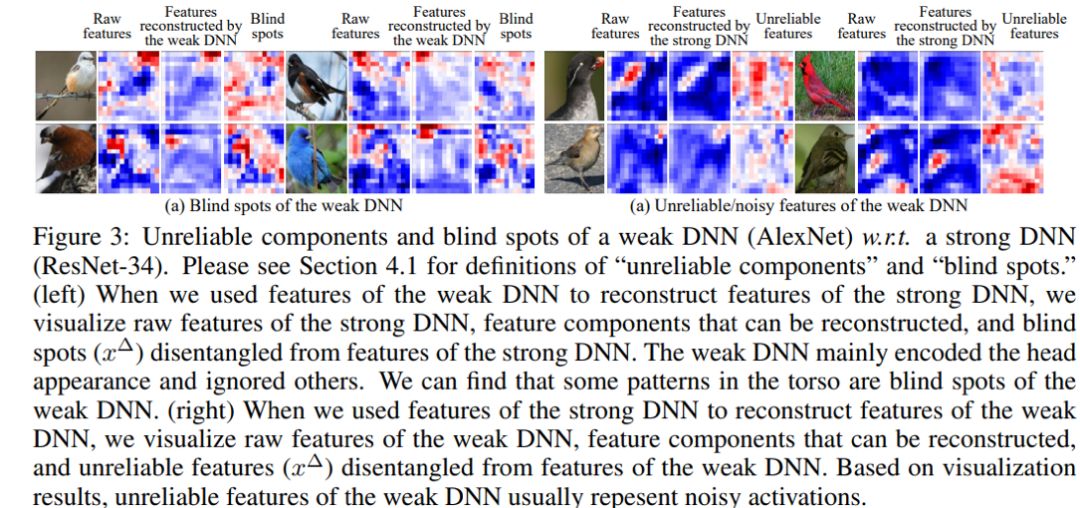

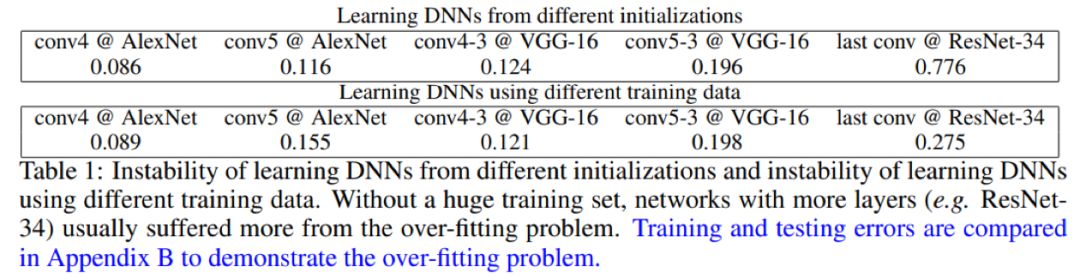

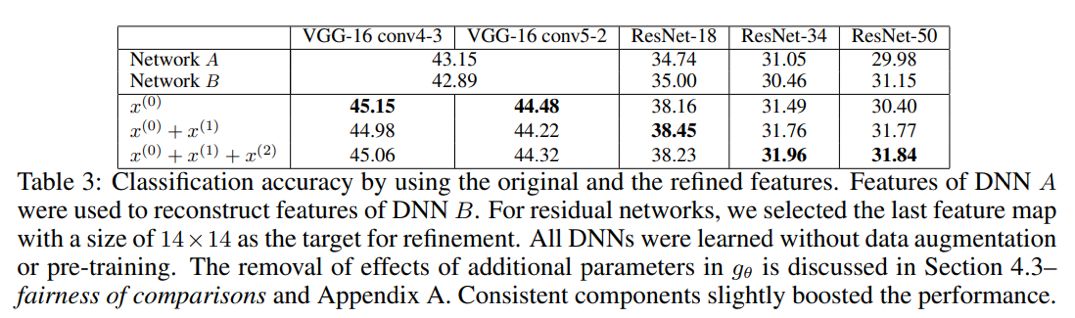

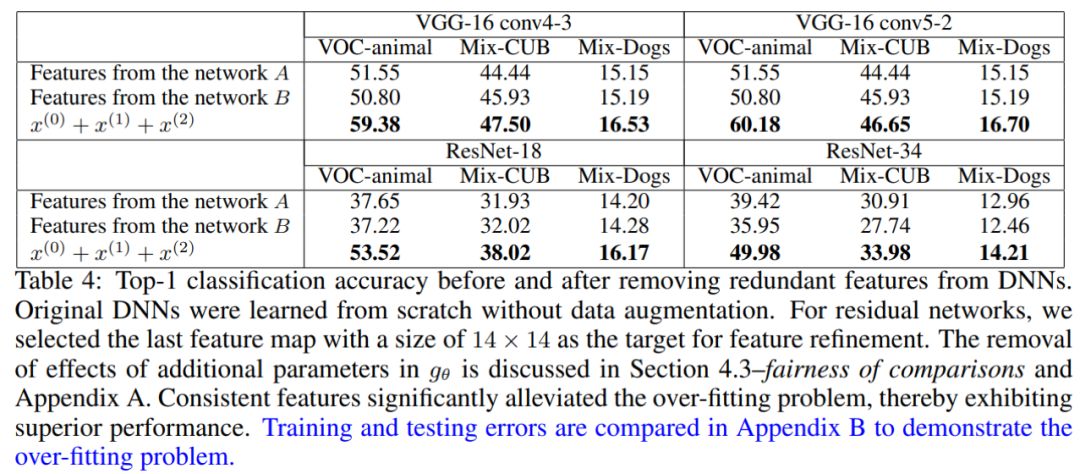

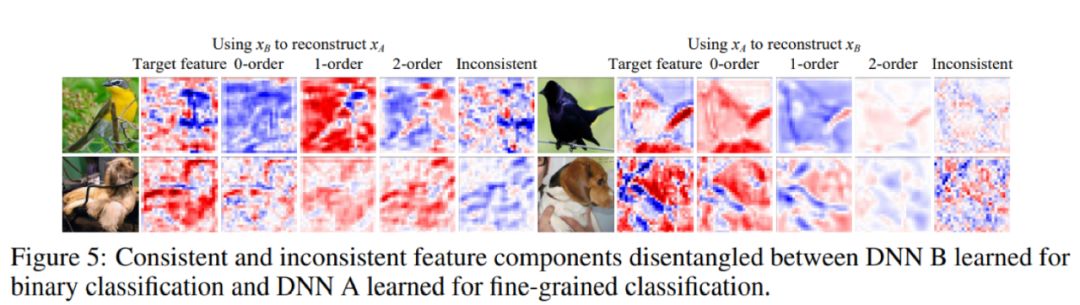

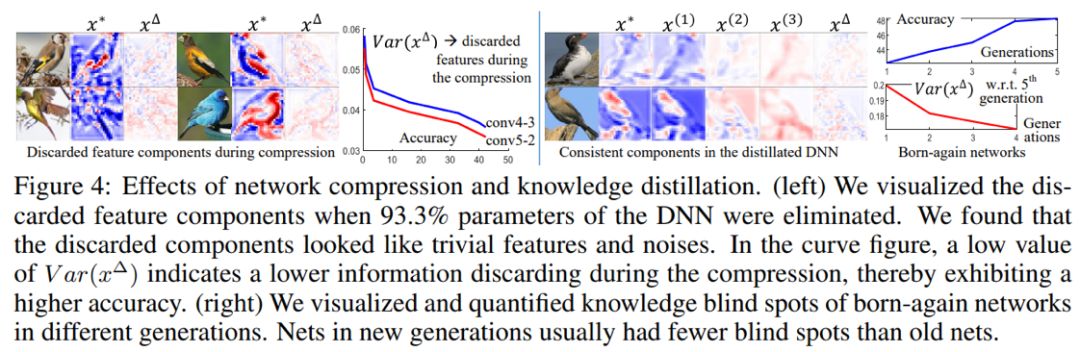

人工智能顶会 ICLR 2020 将于 4 月 26 日于埃塞俄比亚首都亚的斯亚贝巴举行。在最终提交的 2594 篇论文中,有 687 篇被接收,接收率为 26.5%。本文介绍了上海交通大学张拳石团队的一篇接收论文——《Knowledge Consistency between Neural Networks and Beyond》。在本文中,研究者提出了一种对神经网络特征表达一致性、可靠性、知识盲点的评测与解释方法。

登录查看更多

相关内容

Arxiv

11+阅读 · 2019年9月8日