虚构的对抗,GAN with the wind

“全球人工智能”拥有十多万AI产业用户,10000多名AI技术专家。主要来自:北大,清华,中科院,麻省理工,卡内基梅隆,斯坦福,哈佛,牛津,剑桥...以及谷歌,腾讯,百度,脸谱,微软,阿里,海康威视,英伟达......等全球名校和名企。

在过去的两三年中,对抗生成网络(Generative Adersarial Network GAN)获得了爆炸式的增长,其应用范围几乎涵盖了图像处理和机器视觉的绝大多数领域。其精妙独到的构思,令人拍案叫绝;其绚烂逼真的效果,令众生颠倒。一时间对抗生成网络引发了澎湃汹涌的技术风潮,纳什均衡的概念风靡了整个人工智能领域。

Goodfellow 【1】于2014年提出了GAN的概念,他的解释如下:GAN的核心思想是构造两个深度神经网络:判别器D和生成器G,用户为GAN提供一些真实货币作为训练样本,生成器G生成假币来欺骗判别器D,判别器D判断一张货币是否来自真实样本还是G生成的伪币;判别器和生成器交替训练,能力在博弈中同步提高,最后达到平衡点的时候判别器无法区分样本的真伪,生成器的伪造功能炉火纯青,生成的货币几可乱真。这种阴阳互补,相克相生的设计理念为GAN的学说增添了魅力。

GAN模型的优点来自于自主生成数据。机器学习的关键在于海量的数据样本,GAN自身可以生成不尽的样本,从而极大地减少了对于训练数据的需求,因此极其适合无监督学习;GAN的另外一个优点是对于所学习的概率分布要求非常宽泛,这一概率分布由训练数据的测度分布来表达,不需要有显式的数学表示。

GAN虽然在工程实践中取得巨大的成功,但是缺乏严格的理论基础。大量的几何假设,都是仰仗似是而非的观念;其运作的内在机理,也是依据肤浅唯像的经验解释。丘成桐先生率领团队在学习算法的基础理论方面进行着不懈的探索。我们用最优传输(Optimal mass Transportation)理论框架来阐释对抗生成模型,同时用凸几何(Convex Geometry)的基础理论来为最优传输理论建立几何图景。通过理论验证,我们发现关于对抗生成模型的一些基本观念有待商榷:理论上,Wasserstein GAN中生成器和识别器的竞争是没有必要的,生成器网络和识别器网络的交替训练是徒劳的,此消彼长的对抗是虚构的。最优的识别器训练出来之后,生成器可以由简单的数学公式所直接得到。详细的数学推导和实验结果可以在【7】中找到。

下面,我们就这一观察展开详细论述。我们首先分析WGAN的理论框架;然后简介最优传输理论,解释生成器和判别器的主要任务;我们再介绍凸几何中的基本定理,解释凸几何和最优传输的内在联系,用计算几何的语言来解释最优传输框架下的基本概念;初步试验结果比较了WGAN和几何方法;最后我们进行一些扼要的讨论。

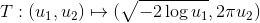

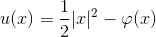

大家对于随机数的生成原理耳熟能详,GAN本质上可以被视作是一个规模宏大的随机数生成器。我们考察最为简单的线性同余生成算法

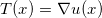

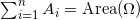

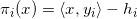

这里

由此可见,我们可以通过一个变换将均匀分布变换成高斯分布。如果我们将概率分布看成是某种质量密度,映射会带来面积的变化,因此带来密度的变化,这样就从一种概率分布变换成另外一种概率分布。

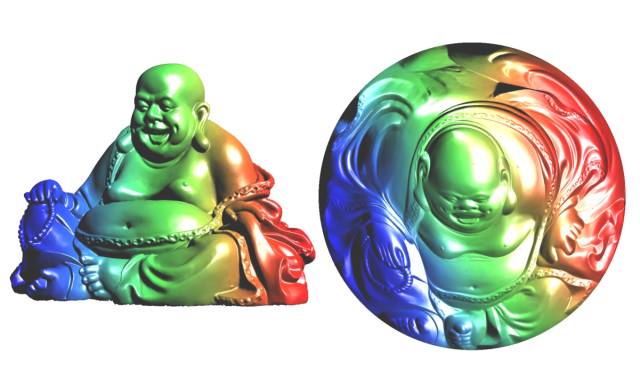

图2. GAN本质上是将一种概率分布(高斯分布)变成另外一种概率分布(人脸图像)。

在图像生成应用中,GAN模型本质上就是将一种固定的概率分布,例如均匀分布或者高斯分布,变换成训练数据所蕴含的概率分布,例如人脸图像的分布。GAN的理想数学模型如下:我们将所有

绝大多数图片并不是人脸图像,因此

是图像空间中的一个子流形,

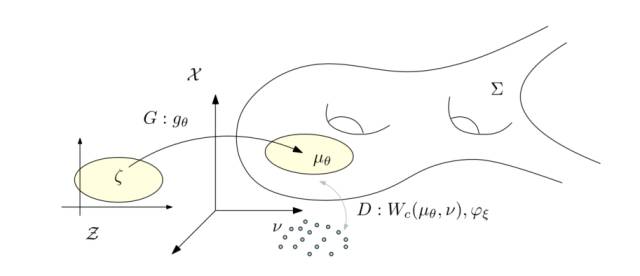

图3. WGAN【3】的理论框架。

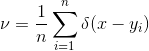

假设在隐空间有一个固定的概率分布

我们称

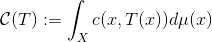

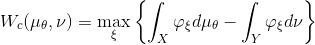

给定带有概率测度的空间

记为

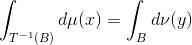

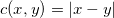

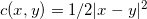

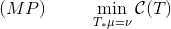

蒙日问题 法国数学家蒙日于18世纪提出了最优传输映射问题:如何找到保测度的映射,使得传输代价最小,

这种映射被称为是最优传输映射(Optimal Mass Transportation Map)。最优传输映射对应的传输代价被称为是概率测度之间的Wasserstein距离:

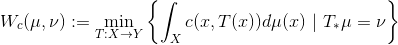

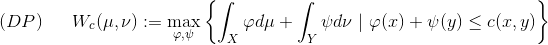

Kantorovich 对偶问题 Kantorovich证明了蒙日问题解的存在性唯一性,并且发明了线性规划(Linear Programming),为此于1975年获得了诺贝尔经济奖。由线性规划的对偶性,Kantorovich给出了Wasserstein距离的对偶方法:

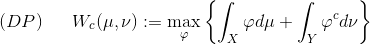

等价的,我们将

这里

WGAN模型 在WGAN【3】中,判别器计算测度间的Wasserstein距离就是利用上式:这里距离函数为

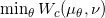

生成器极小化Wasserstein距离,

生成器极大化,判别器极小化,各自由一个深度网络交替完成。在优化过程中,解码映射

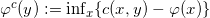

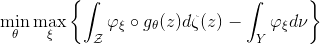

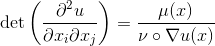

Brenier方法 Brenier理论【4】表明,如果距离函数为

关键在于,Brenier势能和Kantorovich势能满足简单的关系:

判别器计算Kantorovich势能,生成器计算Brenier势能。在实际优化中,判别器优化后,生成器可以直接推导出来,不必再经过优化过程。

最优传输的Brenier理论和凸几何理论中的Alexandrov定理彼此等价,它们都由蒙日-安培方程来刻画。

图4. Minkowski问题和Alexandrov问题。

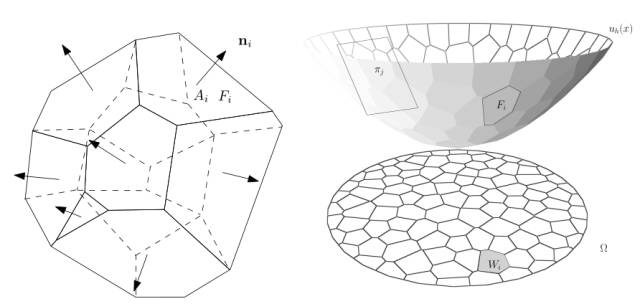

Minkowski 定理 如图4所示,左帧显示了经典的Minkowski定理:给定每个面的法向量和面积

Alexandrov 定理 右帧显示了Alexandrov定理【2】:假设

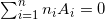

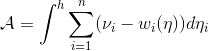

变分原理 我们在【6】中给出了一个基于变分原理的构造性算法。假设第i个面的梯度

的图(graph),这里向量

胞腔

可以证明Alexandrov势能为凹函数,其极大值点给出的高度

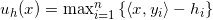

图5. Alexandrov定理和最优传输映射。

凸几何中的Alexandrov定理和最优传输理论中的Brenier定理本质是一致的,如图5所示,带测度的源区域为

我们构造一个Alexandrov凸多面体,每个面的投影面积满足

就是最优传输映射,Alexandrov势能函数就是传输代价,也等价于Wasserstein距离,即

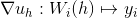

图6. Power Diagram。

Brenier定理和Alexandrov定理可以用计算几何中人所周知的Power Diagram语言来描述,这样有利于进一步理解和算法设计。如图6所示,我们为每个目标点

由此,我们定义Power Diagram

通过调节power 权重,我们可以使得每个胞腔的测度

生成器:最优映射等价于Power胞腔分解,将每个胞腔

映到

,

判别器:Wasserstein距离中

中的

等于power 权重,

判别器:Wasserstein距离Kantorovich势能

等于power距离,

生成器:Brenier势能等于Power Diagram的上包络。

WGAN的主要功能有两个:1. 编码、解码实现从隐空间到图像空间的变换;2. 概率测度的变换。这两个任务都是高度非线性的,关于测度变换数学上已经建立了严格的基础理论,我们可以进行定量研究;关于从隐空间到图像空间的变换,目前的理论基础比较薄弱,我们只能进行定性比较。

为此,我们设计了两个尽可能简单的实验,来分别验证这两个功能:

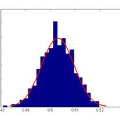

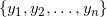

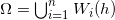

测度变换实验 给定实验数据分布

我们在这里,进行了两个实验,第一个实验的训练样本只有一个团簇,WGAN的生成分布和数据分布吻合得非常好。

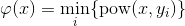

图7. WGAN计算结果。

为了可视化计算结果,我们在平面上设计了非常简单的实验,隐空间的概率分布为均匀分布。如图7所示,蓝色点代表数据样本,橙色点代表WGAN生成的样本。数据样本分成两个团簇,符合Gaussain Mixture的分布。我们看到WGAN最后的学习结果并不令人满意,橙色点的分布和蓝色点的分布相距甚远。

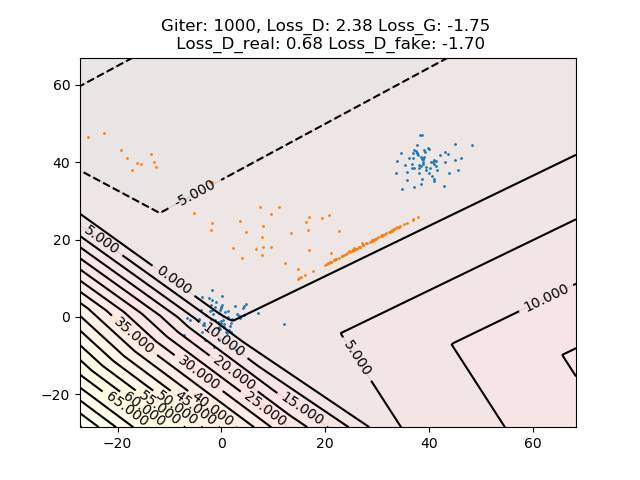

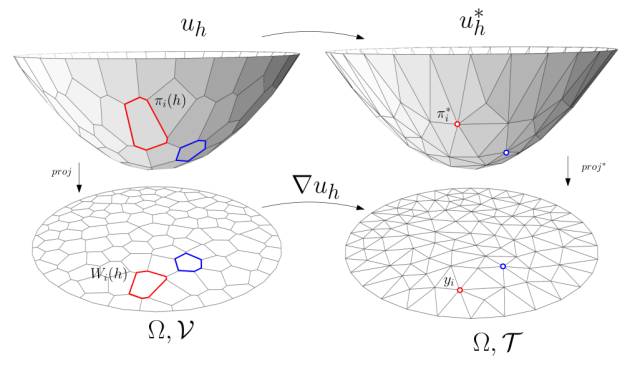

图8.几何方法计算结果。

图8显示了几何方法生成的结果:每个胞腔映到一个具有同样颜色数据样本,上包络的面和它的投影胞腔具有同样的颜色。我们可以看到,首先最优传输映射将单位圆盘映射到所有的数据样本;其次,所有的power 胞腔都具有相同的面积,这意味着几何方法完美地生成了经验分布

我们认为基本原因如下:WGAN用深度神经网络来构造测度变换映射,深度神经网络所能表达的函数为线性映射和ReLu的复合,因此

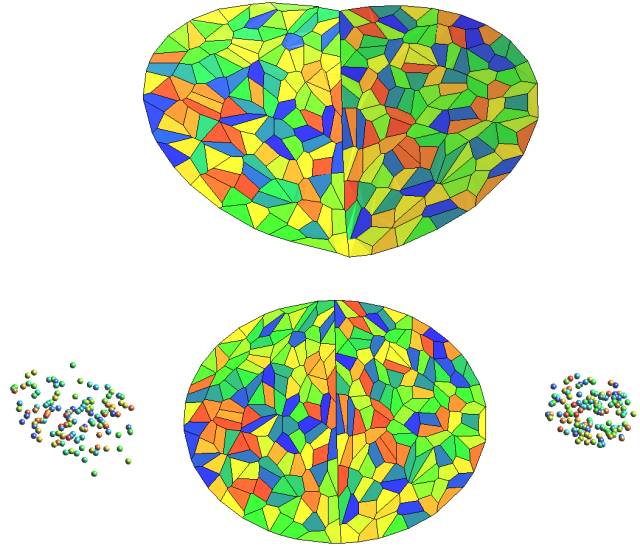

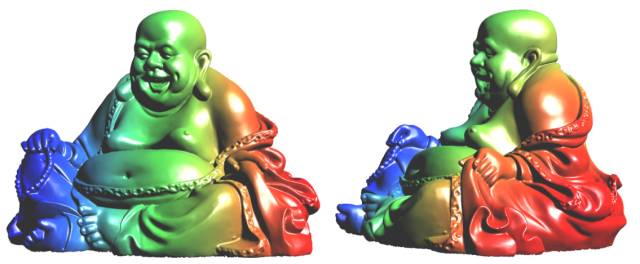

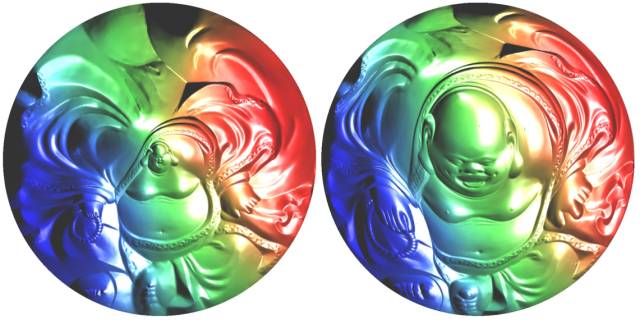

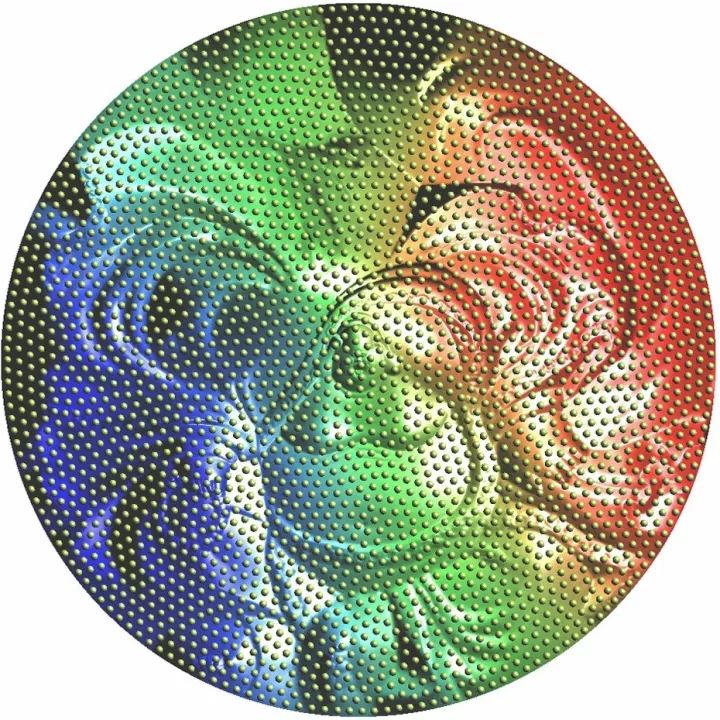

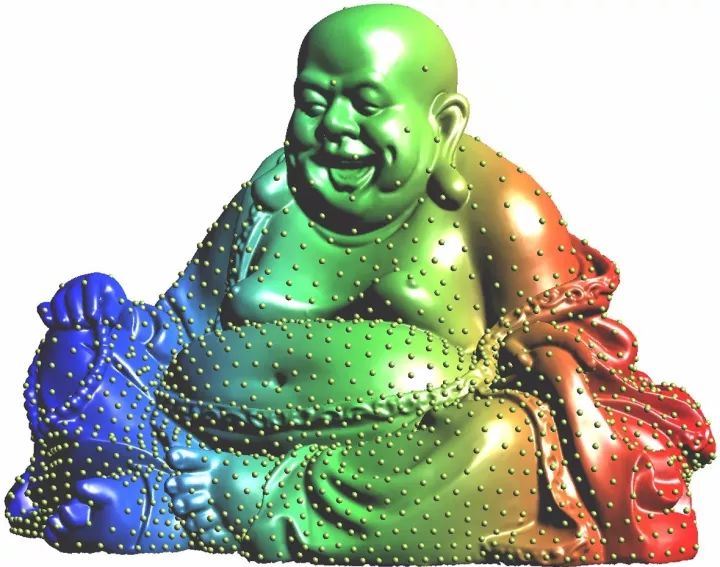

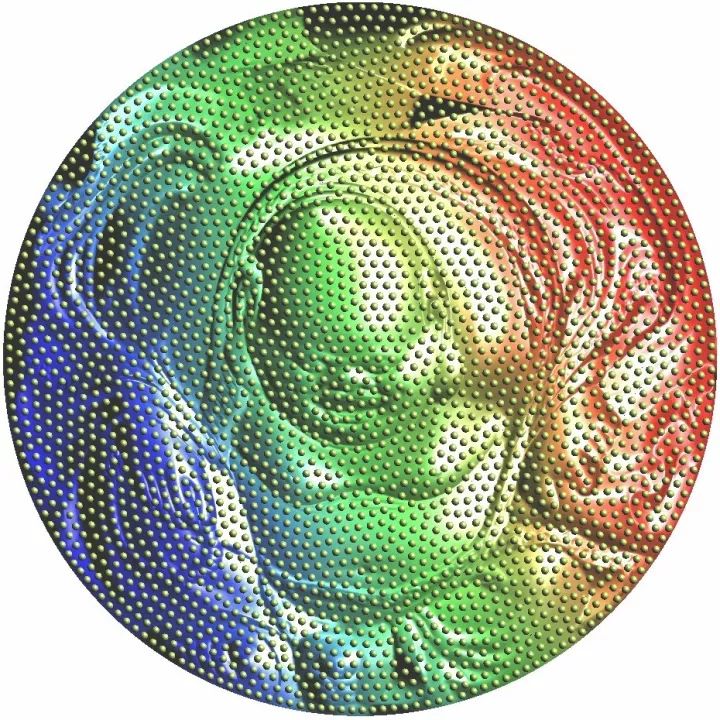

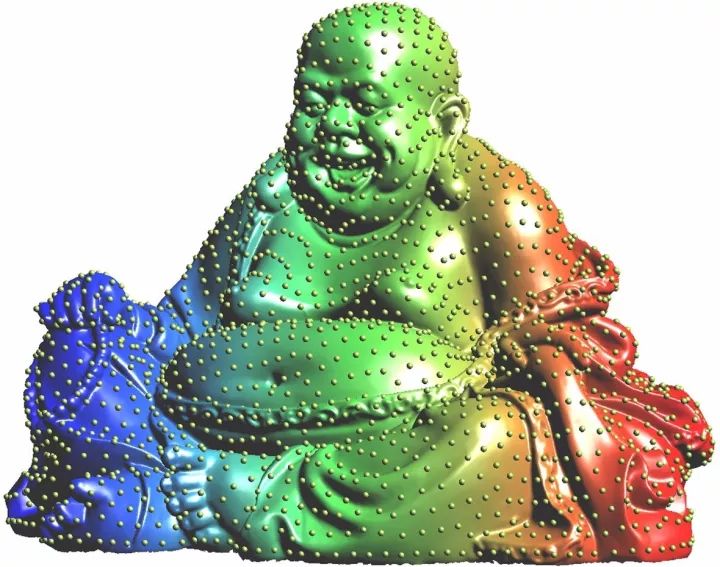

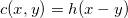

图9. 弥勒佛曲面。

图10. 几何方法构造的编码映射:左侧是保角变换,右侧是保面积映射,两者之间相差一个最优传输映射。

解码映射 我们设计的第二个实验更为复杂。我们将三维欧氏空间视为图像空间

图11. 共形映射诱导的曲面上非均匀分布。

图12. 最优传输映射诱导的曲面上均匀分布。

从图11我们看到,隐空间上的均匀分布被共形映射拉回到

但是,我们用同样的数据样本来训练WGAN模型,但是很难得到有意义的结果。如果读者有兴趣用其他深度学习模型进行研究探索,我们非常乐于分享这些数据,共同探讨提高。

在最优传输理论中,如果距离函数是

理论上,概率分布之间的变换可以在图像空间中完成,也可以在隐空间中完成。但是在实践中,隐空间的维数远低于图像空间,因此应该在隐空间中施行。因此,生成模型具有两个任务:一个是计算编码解码映射,另一个是概率分布变换。目前的模型,将这两个任务混同,因此难以分析。

我们的初步实验表明深度神经网络无法表达非连续映射,但是最优传输映射往往是有间断点的,因此目前的GAN模型需要进一步拓展。

对于降维的编解码映射,目前完备的基础理论尚未建立起来,很多方面比较含混原始,例如GAN的收敛性验证,收敛阶估计,误差分析和控制。

我们计划用更为精细的实验来详尽分析,更期待看到基础理论方面的长足发展。

我们这里给出了最优传输映射观点下GAN模型的几何解释,指出了生成器和判别器之间的对抗竞争和交替训练可以被省略,而用显示的数学关系来取代。GAN模型主要任务分为编解码和概率测度变换,概率测度变换可以用透明的几何算法来解释并改进。初步试验结果显示了GAN模型构造的函数空间具有一定的局限性,无法表示经验数据的分布。

长期以来,丘成桐先生的团队坚持用几何的观点来阐述和改进深度学习模型。早在2017年2月初,笔者就撰文写了“看穿机器学习的黑箱”系列,(可以查阅【I】,【II】,【III】),这些文章引起了很大的反响。许多学者和科研机构和团队成员联系,邀请我们前去给报告,我们将会在几个大会上详细解释我们的工作:全国计算机数学会议(10月20日,湘潭),2017中国计算机科学大会(10月26日,福州)第二届智能国际会议(10月27日,ICIS2017,上海)。我们和许多专家学者进行过讨论深入交流,特别是得到张首晟先生的鼓励,我们才总结成文,在此一并致以谢意!详细的数学推导和实验结果可以在【7】中找到。

最后,我们以张首晟先生的第一性原理来结束此文:“人类看到飞鸟遨游行空,便有了飞翔的梦想.但是早期的仿生却都失败了。理论物理指导我们理解了飞行的第一性原理,就是空气动力学,造出的飞机不像鸟却比鸟飞地更高更远。人工智能也是一样,人类的大脑给了我们智能的梦想,但不能简单地停留在神经元的仿生,而要理解智慧的第一性原理,才能有真正的大突破!”

References

Goodfellow, Ian J.; Pouget-Abadie, Jean; Mirza, Mehdi; Xu, Bing; Warde-Farley, David; Ozair, Sherjil; Courville, Aaron; Bengio, Yoshua (2014). "Generative Adversarial Networks". arXiv:1406.2661

A. D. Alexandrov. “Convex polyhedra” Translated from the 1950 Russian edition by N. S. Dairbekov, S. S. Kutateladze and A. B. Sossinsky. Springer Monographs in Mathematics. Springer-Verlag, Berlin, 2005.

Martin Arjovsky, Soumith Chintala, and Léon Bottou. Wasserstein generative adversarial networks. In International Conference on Machine Learning, pages 214–223, 2017.

Yann Brenier. Polar factorization and monotone rearrangement of vector-valued functions. Comm. Pure Appl. Math., 44(4):375–417, 1991.

Xianfeng Gu, Feng Luo, Jian Sun, and Tianqi Wu. A discrete uniformization theorem for polyhedral surfaces. Journal of Differential Geometry (JDG), 2017.

Xianfeng Gu, Feng Luo, Jian Sun, and Shing-Tung Yau. Variational principles for minkowski type problems, discrete optimal transport, and discrete monge-ampere equations. Asian Journal of Mathematics (AJM), 20(2):383 C 398, 2016.

Na Lei,Kehua Su,Li Cui,Shing-Tung Yau,David Xianfeng Gu, A Geometric View of Optimal Transportation and Generative Model, arXiv:1710.05488.

系统学习,进入全球人工智能学院

周志华点评AlphaGo Zero:这6大特点非常值得注意!

映到

映到