第 35 届 AAAI 人工智能会议已于 2 月 2 日在线上召开。在刚刚举行的开幕式上,组委会颁发了今年的最佳论文奖和提名奖,分别有三篇论文获奖。其中来自北航的学者以一作身份分别获得了一篇最佳论文奖和一篇提名奖。此外,会议还宣布了「学术新星奖」,共有多名华人获得奖项。

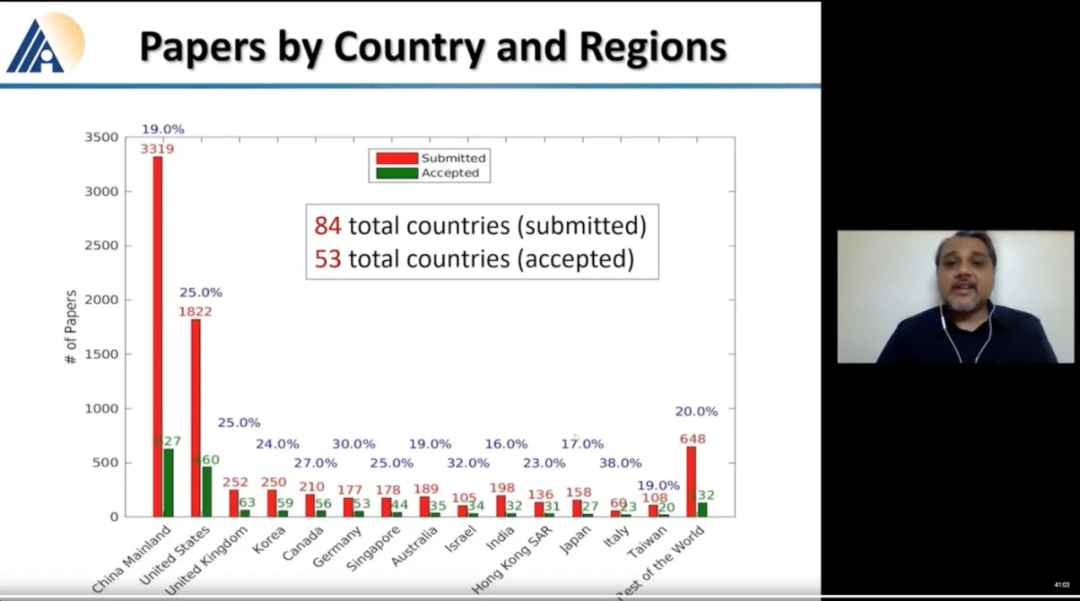

作为全球人工智能顶会之一,虽然受到疫情限制,但 AAAI 2021 的热度仍然不减,本届 9034 篇提交论文的数量又创下了历史新高(去年为 8800 篇)。其中,来自中国的 3319 篇论文数量几乎是美国(1822 篇)的两倍。在最终 7911 篇经过评审的论文中,共有 1692 篇被接收。今年的论文接收率为 21%,略高于去年(20.6%)。

![]()

AAAI 2021 大会主席为微众银行首席人工智能官杨强教授,杨强教授是 AAAI 大会历史上第二位大会主席,也是担任此职位的首位华人。

本次会议共有三篇论文获得最佳论文奖项,其中两篇获奖论文的第一作者为华人学者,他们分别是来自北京航空航天大学的 Haoyi Zhou 和来自达特茅斯学院的 Ruibo Liu。

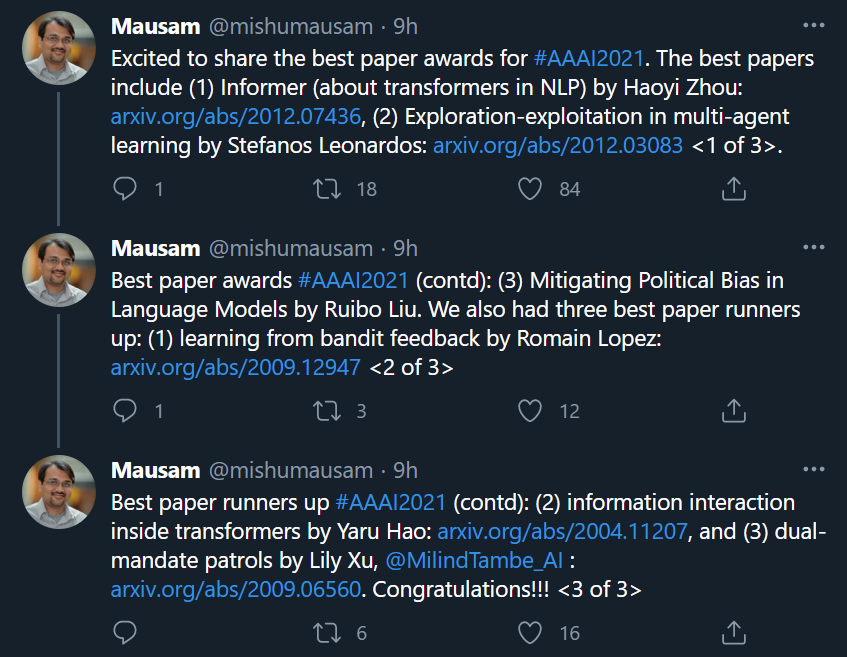

![]()

AAAI 2021程序委员会 Cochair Mausam公布论文奖项。

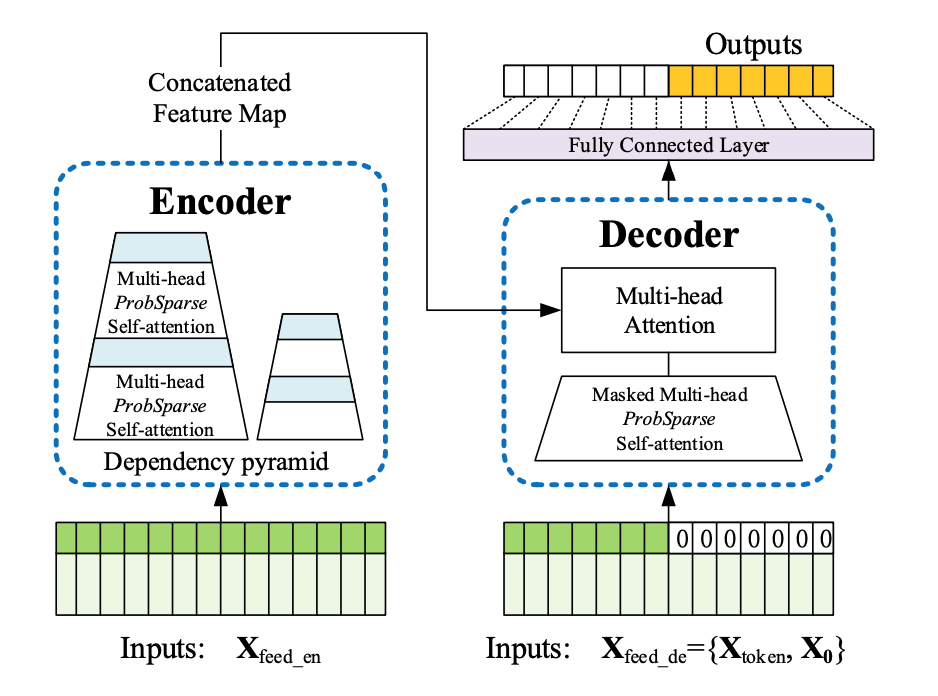

最佳论文 1:Informer: Beyond Efficient Transformer for Long Sequence Time-Series Forecasting

论文链接:https://arxiv.org/pdf/2012.07436.pdf

作者:Haoyi Zhou, Shanghang Zhang, Jieqi Peng, Shuai Zhang, Jianxin Li, Hui Xiong, Wancai Zhang

机构:北京航空航天大学、加州大学伯克利分校、罗格斯大学、北京国网富达科技发展有限责任公司

论文摘要:许多实际应用需要对长序列时间序列进行预测,例如用电计划。长序列时间序列预测(LSTF)对模型的预测能力要求很高,即能够高效捕获输出和输入之间精确的长程依赖。近年来的研究表明,Transformer 具有提高预测能力的潜力。然而,Transformer 存在几个严重的问题,因而无法直接应用于 LSTF,比如二次时间复杂度、高内存使用率以及编码器 - 解码器架构的固有局限。

为解决这些问题,该研究为 LSTF 设计了一个基于高效 transformer 的模型——Informer,该模型具备三个特征:

1)ProbSparse 自注意力机制,其时间复杂度和内存使用达到 O(L log L),在序列依赖对齐方面具有不错的性能;

2)自注意力蒸馏通过将级联层输入减半来突出注意力,并且能够高效地处理极长的输入序列;

3)尽管生成风格解码器在概念上非常简单,但它会在一次前向操作中预测较长的时序序列,而不是逐步预测,这极大地提高了长序列预测的推断速度。

![]()

该研究在四个大规模数据集上进行了大量实验,结果表明 Informer 显著优于现有的方法,为 LSTF 问题提供了一种新的解决方案。

![]()

这篇论文的作者全是华人,分别来自北京航空航天大学、加州大学伯克利分校、罗格斯大学等机构,其中一作 Haoyi Zhou 为北航博士。

最佳论文 2:Exploration-Exploitation in Multi-Agent Learning: Catastrophe Theory Meets Game Theory

论文链接:https://arxiv.org/pdf/2012.03083.pdf

作者:Stefanos Leonardos, Georgios Piliouras

机构:新加坡科技设计大学

论文摘要:探索 - 利用(exploration-exploitation)是多智能体学习(MAL)中强大而实用的工具,但其效果远未得到理解。为了探索这个目标,这篇论文研究了 Q 学习的平滑模拟。首先,研究者认为其学习模型是学习「探索 - 利用」的最佳模型,并提供了强大的理论依据。具体而言,该研究证明了平滑的 Q 学习在任意博弈中对于成本模型有 bounded regret,该成本模型能够明确捕获博弈和探索成本之间的平衡,并且始终收敛至量化响应均衡(QRE)集,即有限理性下博弈的标准解概念,适用于具有异构学习智能体的加权潜在博弈。

该研究的主要任务转向衡量「探索」对集体系统性能的影响。研究者在低维 MAL 系统中表征 QRE 表面的几何形状,并将该研究的发现与突变(分歧)理论联系起来。具体而言,随着探索超参数随着时间的演化,系统会经历相变。在此过程中,给定探索参数的无穷小变化,均衡的数量和稳定性可能会发生剧烈变化。在此基础上,该研究提供了一种形式理论处理方法,即如何调整探索参数能够可验证地产生均衡选择,同时对系统性能带来积极和消极(以及可能无限)的影响。

![]()

最佳论文 3(最佳 AISI 论文):Mitigating Political Bias in Language Models Through Reinforced Calibration

论文链接:https://www.cs.dartmouth.edu/~rbliu/aaai_copy.pdf

作者:Ruibo Liu, Chenyan Jia, Jason Wei, Guangxuan Xu, Lili Wang, and Soroush Vosoughi

机构:达特茅斯学院、德克萨斯大学奥斯汀分校、谷歌 AI

论文摘要:由于训练数据的问题,目前的大规模语言模型存在政治偏见,因此在真实场景中应用时可能导致严重的问题。这篇论文介绍了度量 GPT-2 生成中政治偏见的指标,并提出一种缓解生成文本中政治偏见的强化学习(RL)框架。该 RL 框架使用来自词嵌入或分类器的奖励,引导无偏见的文本生成,且无需访问训练数据、模型也不需要重新训练。

实验表明,对于政治偏见敏感的三种属性(性别、地域和话题),该方法都降低了偏见,同时维持文本的可读性和语义连贯性。

![]()

这篇论文的作者列表中包括多位华人,其中一作 Ruibo Liu 在达特茅斯学院攻读计算机科学博士学位,对 NLP 与社交计算的交叉领域感兴趣。多篇论文发表在 AAAI、EMNLP、CSCW、ICWSM 会议上。

除了最佳论文奖以外,本次大会还公布了最佳论文提名(Runners Up),共有三篇论文获得此奖项。

论文 1:Learning From Extreme Bandit Feedback

论文链接:https://arxiv.org/pdf/2009.12947.pdf

作者:Romain Lopez, Inderjit Dhillon, Michael I. Jordan

机构:加州大学伯克利分校、德克萨斯大学奥斯汀分校

论文 2:Self-Attention Attribution: Interpreting Information Interactions Inside Transformer

论文链接:https://arxiv.org/pdf/2004.11207.pdf

作者:Yaru Hao, Li Dong, Furu Wei, Ke Xu

机构:北京航空航天大学、微软研究院

论文 3:Dual-Mandate Patrols: Multi-Armed Bandits for Green Security

论文链接:https://arxiv.org/pdf/2009.06560.pdf

作者:Lily Xu, Elizabeth Bondi, Fei Fang, Andrew Perrault, Kai Wang, Milind Tambe

机构:哈佛大学、卡内基梅隆大学

其中,论文《Self-Attention Attribution: Interpreting Information Interactions Inside Transformer》的作者均为华人,一作 Yaru Hao 来自北京航空航天大学;论文《Dual-Mandate Patrols: Multi-Armed Bandits for Green Security》的作者中也有多名华人,一作 Lily Xu 来自哈佛大学。

在各个论文奖项之外,本次 AAAI 大会还颁发了「学术新星(New Faculty Highlight)」荣誉,上榜者包括杨笛一(Diyi Yang)、马航(Hang Ma)、杜少雷(Simon S. Du)、Noam Brown、孙举(Ju Sun)、李俊东(Jundong Li)、牟力立(Lili Mou)等。其中,来自字节跳动 AI Lab 的许晶晶博士成为了中国研究机构中的唯一入选者。

![]()

学术新星是这一届 AAAI 大会新启动的项目,重点介绍刚刚开始职业生涯的研究人员,申请条件包括:

1、在研究型大学担任教职,或在业界担任类似的职位(比如研究实验室职位、独立研究等);

2、在顶级会议 / 期刊上发表或接收至少六篇论文,或引用量累积达到 500,以及在顶级会议中获得过最佳论文奖,或将研究成果转化为涉及 1000 人以上的部署系统。

杨笛一(Diyi Yang)是佐治亚理工学院交互计算学院助理教授,该机构隶属于机器学习中心。她曾在卡耐基梅隆大学的语言技术学院获得博士学位,研究方向面向计算社会科学和自然语言处理。她的研究曾被 EMNLP 2015、ICWSM 2019 和 ACM CHI 2019 等学术会议收录。

马航本科就读于浙江大学,在麦吉尔大学和南加州大学分别获得硕士和博士学位。目前是加拿大西蒙弗雷泽大学的计算机科学助理教授,也是自主智能和机器人实验室的负责人,研究兴趣包括智能规划、多智能体 / 机器人系统、时空约束推理,概率方法应用以及与图、组合优化和算法有关的其他主题。

杜少雷目前是华盛顿大学计算机科学与工程系 Paul G. Allen School 的助理教授,他在 UC 伯克利获得硕士学位,在卡耐基梅隆大学机器学习专业获得博士学位,研究兴趣包括深度学习、表征学习和强化学习等领域。

孙举 2008 年于新加坡国立大学获得学士学位,2016 年在斯坦福大学获博士学位,现为明尼苏达大学双城分校助理教授。

李俊东现任弗吉尼亚大学电气与计算机工程系助理教授,2019 年获亚利桑那州立大学计算机科学博士学位。研究兴趣包括数据挖掘、机器学习和社交计算。他曾多次在 AAAI、KDD 等顶会上发表学术论文,论文引用次数超过 1000。李俊东还领导开发开源特征选择库(scikit-feature),多次在国际学术会议的程序委员会中任职。

牟力立,现为加拿大阿尔伯塔大学计算机科学系助理教授、阿尔伯塔机器智能研究所成员(Amii Fellow),CIFAR 人工智能主席项目成员(CIFAR AI Chair)。他分别于 2012 年和 2017 年在北京大学计算机系取得学士、博士学位,后曾在滑铁卢大学担任博士后研究工作。研究兴趣包括基于机器学习的自然语言处理和程序语言处理。

许晶晶(Jingjing Xu)

许晶晶现为字节跳动人工智能实验室研究员。2020 年从北京大学毕业加入字节跳动。过去五年已经发表了超过 10 篇顶级会议论文,包括 NeurIPS、ACL、EMNLP,研究兴趣为 green learning 和知识重用。

此外,CMU 大神 Noam Brown 也位列其中。Noam Brown 是游戏 AI 系统冷扑大师(Libratus)和 Pluribus 的开发团队成员,不完美信息博弈是他的研究重点之一。

2017 年,Noam Brown 与其导师 Tuomas Sandholm 开发的 AI 系统 Libratus 在宾夕法尼亚州匹兹堡 Rivers 赌场持续 20 天 1 对 1 无限制德扑比赛中成功战胜了 4 名全球顶级职业玩家。该研究登上了《科学》杂志,与研究相关的另一篇论文《Safe and Nested Subgame Solving for Imperfect-Information Games》还获得了 NIPS 2017 最佳论文奖。

2021年 2 月的第一周,机器之心将携手二十余位 AI 人耳熟能详的重磅嘉宾进行在线直播,通过圆桌探讨、趋势Talk,报告解读及案例分享等形式,为关注人工智能产业发展趋势的AI人解读技术演进趋势,共同探究产业发展脉络。连续七天,精彩不停。

添加机器之心Pro小助手(syncedai 或 syncedproii),备注「2021」,进群一起看直播。

![]()