用概念激活向量 (CAVs) 理解深度网络

可解释性仍然是现代深度学习应用的最大挑战之一。最近在计算模型和深度学习研究方面的进展,使创建高度复杂的模型成为可能,这些模型可以包括数千个隐藏层和数千万个神经元。虽然创建令人惊讶的高级的深度神经网络模型相对简单,但理解这些模型如何创建和使用知识仍然是一个挑战。最近,来自谷歌大脑研究小组的研究人员发表了一篇论文,提出了一种新的方法,称为概念激活载体(CAVs),这为深度学习模型的可解释性提供了一个新的视角。详见论文:https://arxiv.org/pdf/1711.11279.pdf

可解释性vs准确性

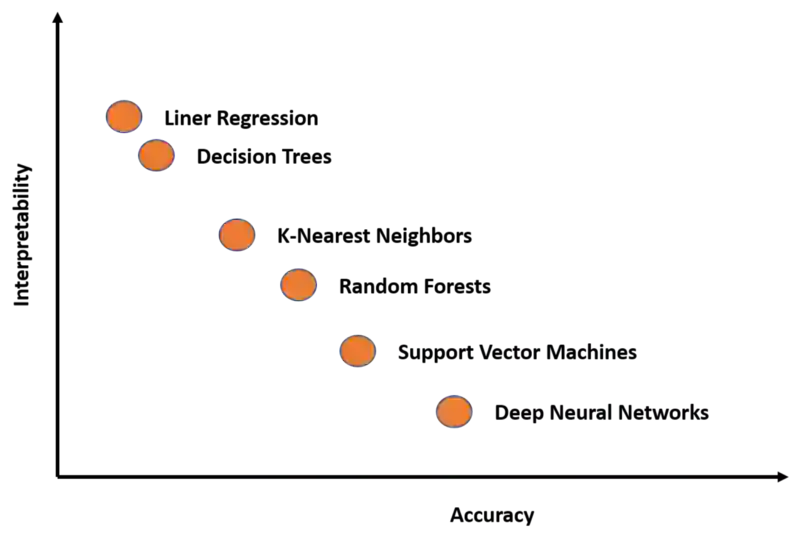

为了理解CAV技术,了解深度学习模型中可解释性的本质是非常重要的。在当前的深度学习技术中,模型的准确性和我们解释其知识表达的能力之间存在着永恒的鸿沟。可解释性-准确性的矛盾是指能够复杂知识表达的任务和理解这些任务是如何完成的之间的矛盾。知识表达vs理解,性能vs可说明性,效率vs.简单程度……任何模棱两可的事物,都可以通过在准确性和可解释性之间进行权衡来解释。

你关心的是获得较好的结果还是理解这些结果是如何产生的?这是数据科学家在每一个深度学习场景中都需要回答的问题。许多深度学习技术在本质上是复杂的,尽管它们在许多场景中都非常精确,但它们可能变得难以解释。如果我们能将一些最著名的深度学习模型绘制在一张图表上,并将其与准确性和可解释性联系起来,我们将得到如下结果:

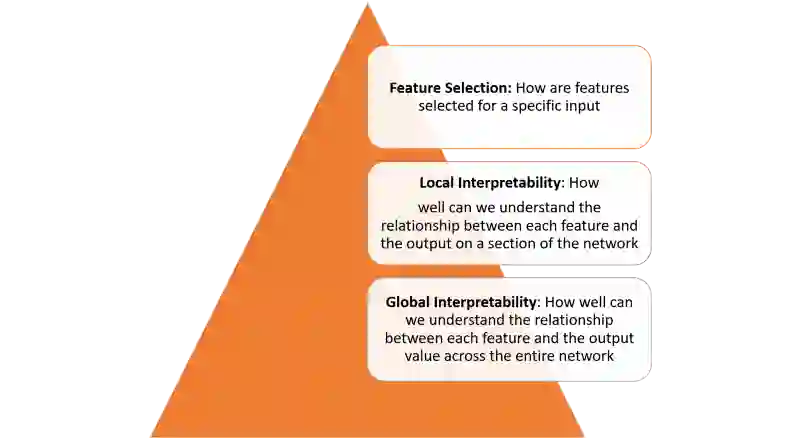

深度学习模型的可解释性不是一个单一的概念,而是需要跨越多个层次来理解:

要在前面图中定义的每一层之间实现可解释性,需要几个基本的组成部分。在最近的一篇论文中,来自谷歌的研究人员简述了他们认为的可解释性的一些基本构件,详见论文:https://distill.pub/2018/building-blocks/。

谷歌将可解释性的原则总结如下:

理解隐藏层的作用:深度学习模型中的大部分知识都是在隐藏层中形成的。在宏观层面理解不同隐藏层的功能对于能够解释深度学习模型是至关重要的。

理解节点是如何被激活的:可解释性的关键不在于理解网络中单个神经元的功能,而在于理解在同一空间位置一起激活的相互连接的神经元群。通过一组相互连接的神经元群对网络进行分割,可以提供一个更简单的抽象层次来理解其功能。

理解概念是如何形成的:理解深层神经网络是如何形成单个概念,然后将这些概念组装成最终的输出,这是可解释性的另一个关键构建模块。

这些原则是谷歌CAV技术的理论基础。

激活概念向量

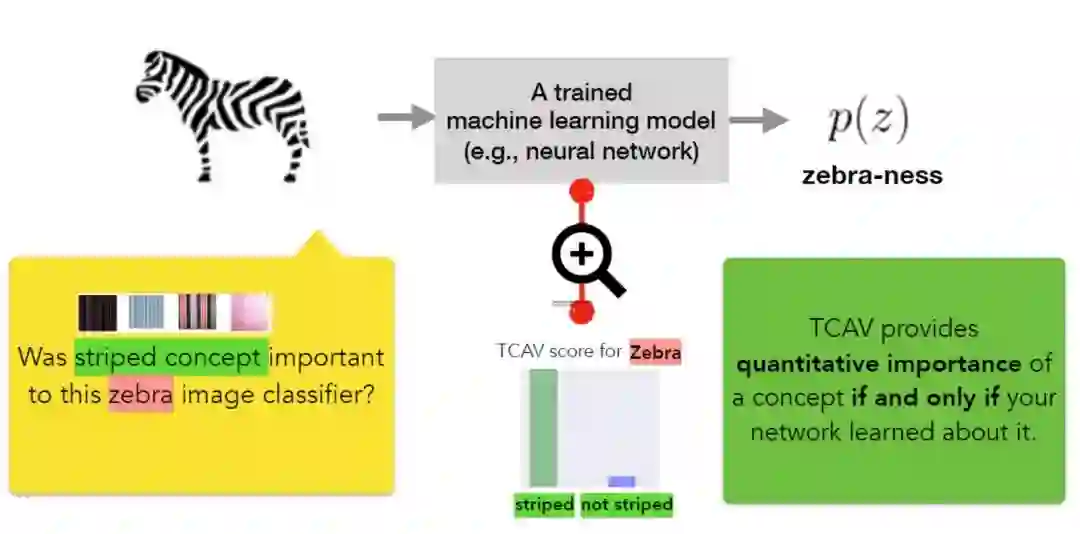

按照上一节讨论的想法,解决解释性比较恰当的方法应该是根据它所考虑的输入特性来描述深度学习模型的预测。一个经典的例子是logistic回归分类器,其中系数权重通常被解释为每个特征的重要程度。然而,大多数深度学习模型处理的特征,如像素值,并不对应于人类容易理解的高级概念。此外,模型的内部值(例如,神经元的激活)似乎是不可理解的。虽然像显著性检测这样的技术在测量特定像素区域的重要程度方面是有效的,但是它们仍然不能与更高层次的概念相关联。

CAV的核心思想是度量模型输出的概念的相关性。CAV的概念只是指一个向量,指向该概念值(例如,激活值)的方向。在他们的论文中,谷歌研究小组简述了一种新的线性可解释性方法,被称为CAV测试(TCAV),它使用方向导数来量化模型预测对于CAV学习的高级概念的敏感性。在概念上,TCAV的定义有四个目标:

易访问性:几乎不需要用户机器学习专业知识。

适应性:适应任何概念(如性别),并不限于训练中获得的概念。

即插即用:无需对机器学习模型进行任何再训练或修改即可有效。

全局量化:可以用单个量化度量解释整个类别或示例集,而不只是解释单个数据输入。

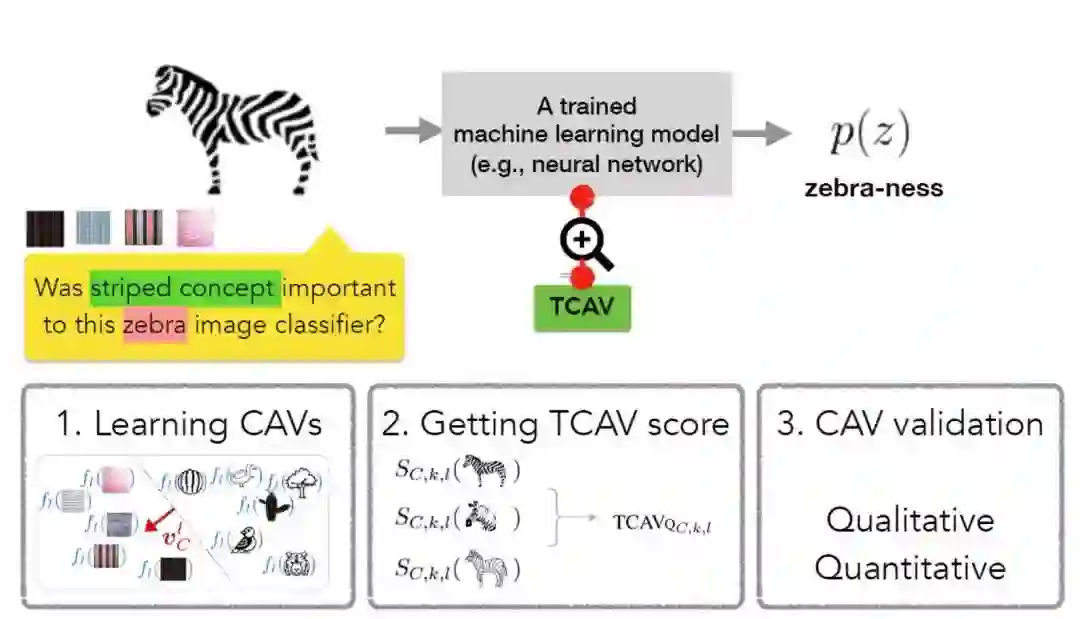

为了实现上述目标,TCAV方法定义为三个基本步骤:

1) 定义模型的相关概念。

2) 理解这些概念对预测的敏感性。

3) 对各概念相对于每个模型所需要预测的类别的相对重要性进行整体定量解释。

TCAV方法的第一步是确定感兴趣的概念(CAV)。TCAV方法只需要选择一组表示这个概念的示例,或者找到一个带有这个概念标签的数据集,就可以实现这一点。CAVs是通过训练线性分类器来区分是概念样本激活的还是其他的任意层中的样本所激活的。

第二步是生成一个TCAV评分,量化特定概念对预测结果的敏感性。TCAV是通过使用方向导数来实现这一目的的,方向导数可以在神经激活层测量ML预测相对于概念输入方向变化的敏感度。

最后一步是评估学习的CAVs的整体相关性,避免依赖于不相关的CAVs。毕竟,TCAV技术的一个缺点就是会学习可能毫无意义的CAV概念。毕竟,使用随机选择的一组图像同样会产生CAV。基于这种随机概念的测试不太可能有意义。为了解决这个问题,TCAV引入了一个重要性统计测试,它根据随机的训练次数(通常为500次)来评估CAV算法。这个想法有意义地方在于保持TCAV分数在训练过程中保持一致。

运动 TCAV

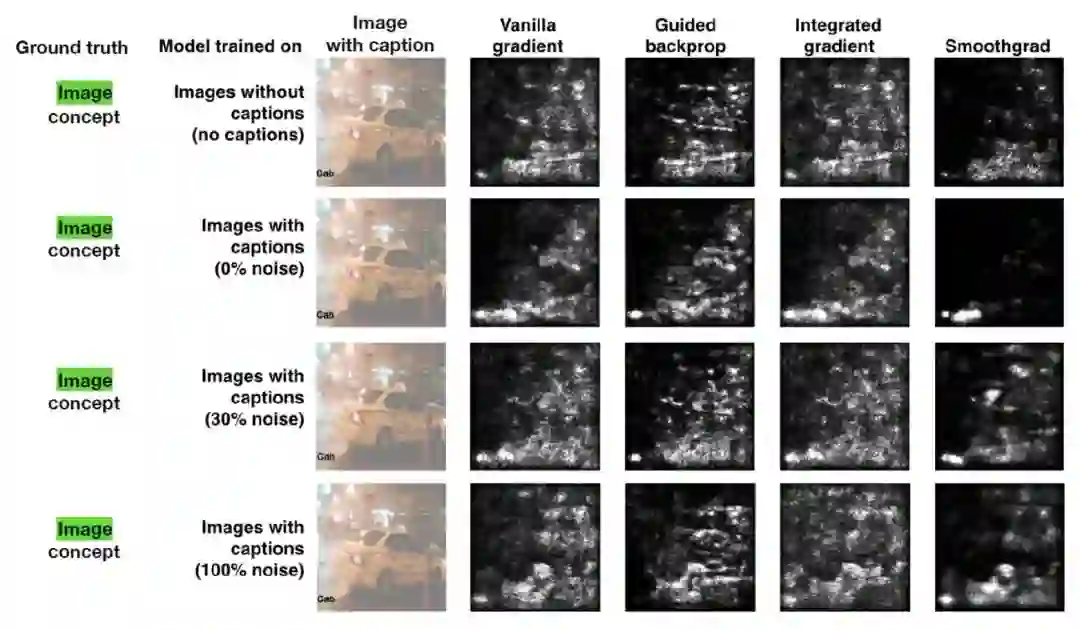

谷歌大脑进行了几项实验来评估TCAV与其他解释方法相比的效率。在其中一个最引人注目的测试中,研究小组使用了一个显著性map,试图预测标题或图片的相关性,以理解出租车的概念。显著性map的输出如下:

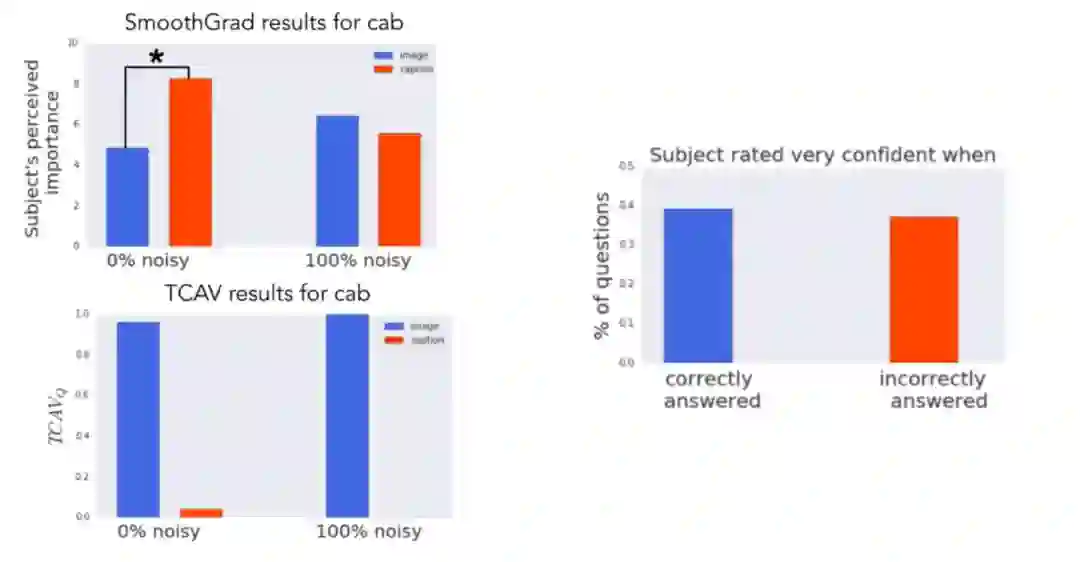

谷歌大脑研究小组使用这些图像作为测试数据集,在Amazon Mechanical Turk上对50人进行了实验。每个人做了一系列的6个任务(3个对象类 x 2个显著性map类),都是针对一个模型。任务顺序是随机的。在每一项任务中,工作人员首先看到四幅图像及其相应的显著性掩模图。然后他们对自己认为图片对模型有多重要(10分制),标题对模型有多重要(10分制),以及他们对自己的答案有多确定(5分制)进行打分。总共对60张特定的图像(120张特定的显著性map图)进行了评分。

实验的基本事实是,图像概念比标题概念更相关。然而,当人们看到显著性map时,他们认为标题概念更重要(零噪声模型),或者没有辨别出区别(100%噪声模型)。与此相反,TCAV结果正确地表明,图像概念更为重要。

TCAV是近年来研究神经网络可解释性的最具创新性的方法之一。最初技术的代码可以在GitHub上找到(https://github.com/tensorflow/tcav),我们期待看到这里的一些想法被主流的深度学习框架所采用。

via https://towardsdatascience.com/this-new-google-technique-help-us-understand-how-neural-networks-are-thinking-229f783300