【新智元导读】近日,一篇介绍了新一代AI开源计算框架MindSpore的文章引发热议。阿里巴巴副总裁贾扬清表示:虽然我相信友商是真诚的,但是,还没有开源的就不是开源。请大家不要肆意消费开发者社区的真诚,在AI领域,开源开放的精神来之不易,先开放,再吹牛,而不是相反,并呼吁共同推动真正的开源创新。来新智元 AI 朋友圈与贾扬清等AI大咖一起参与讨论吧~

北京时间15日13时33分许,美国加州旧金山湾区悦人山附近发生4.5级地震。

身处硅谷的蚂蚁金服首席工程师王益当时距离震中仅1英里,震感明显。用他自己的话说:“我还以为有个贼在房顶上摔倒了呢。”

确认安全后,王益脑海里依然萦绕着刚刚在贾扬清朋友圈看到的文章。

这篇文章题为《华为于璠:

新一代AI开源计算框架MindSpore的前世与今生 | AI ProCon 2019》,着重介绍了新一代AI开源计算框架MindSpore。

![]()

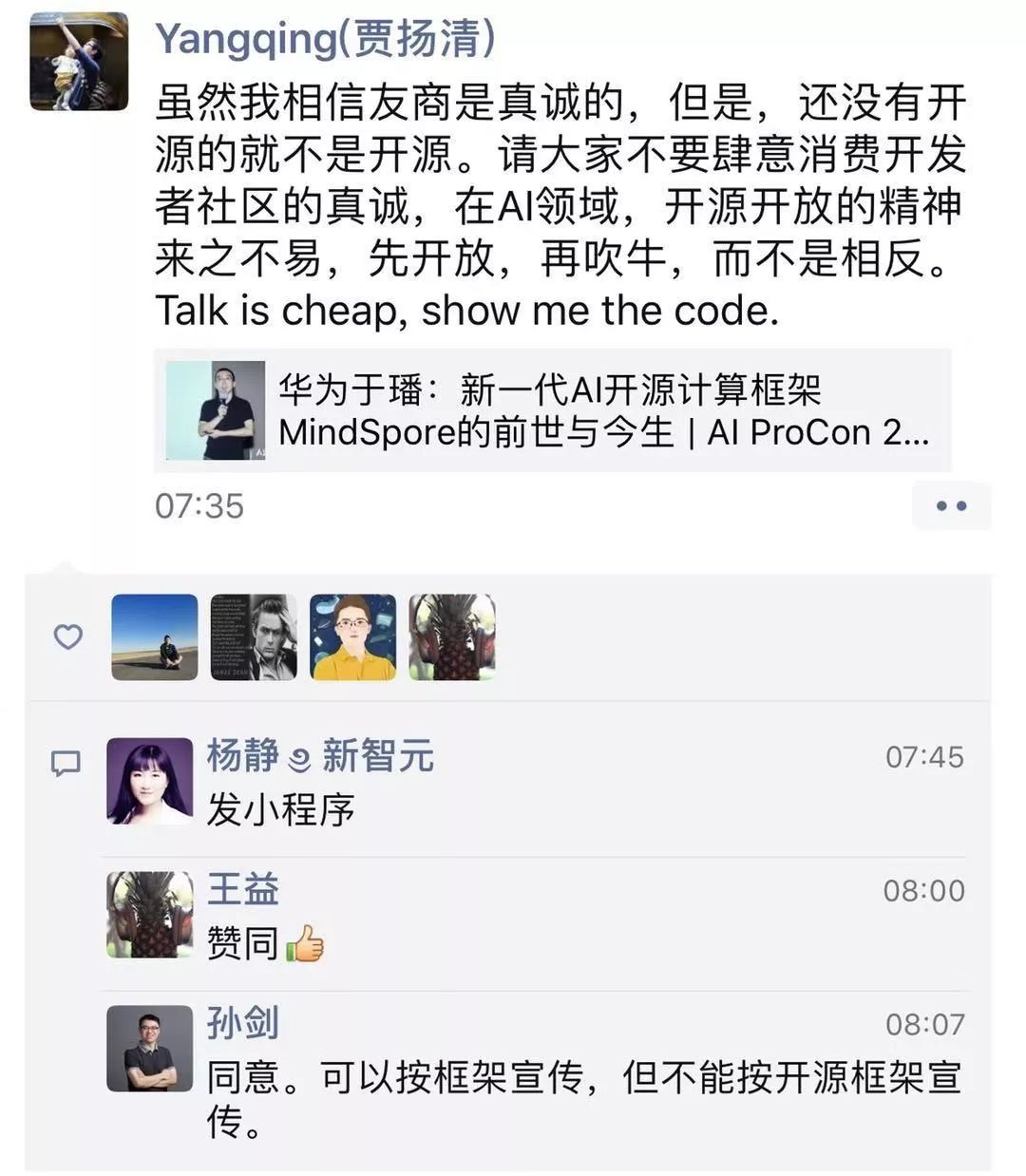

阿里巴巴副总裁贾扬清表示:虽然我相信友商是真诚的,但是,还没有开源的就不是开源。请大家不要肆意消费开发者社区的真诚,在AI领域,开源开放的精神来之不易,先开放,再吹牛,而不是相反。Talk is cheap, show me the code.

作为业内人,王益想和大家一起讨论这篇文章,于是打开了新智元AI朋友圈

,发出了自己的第一个帖子:

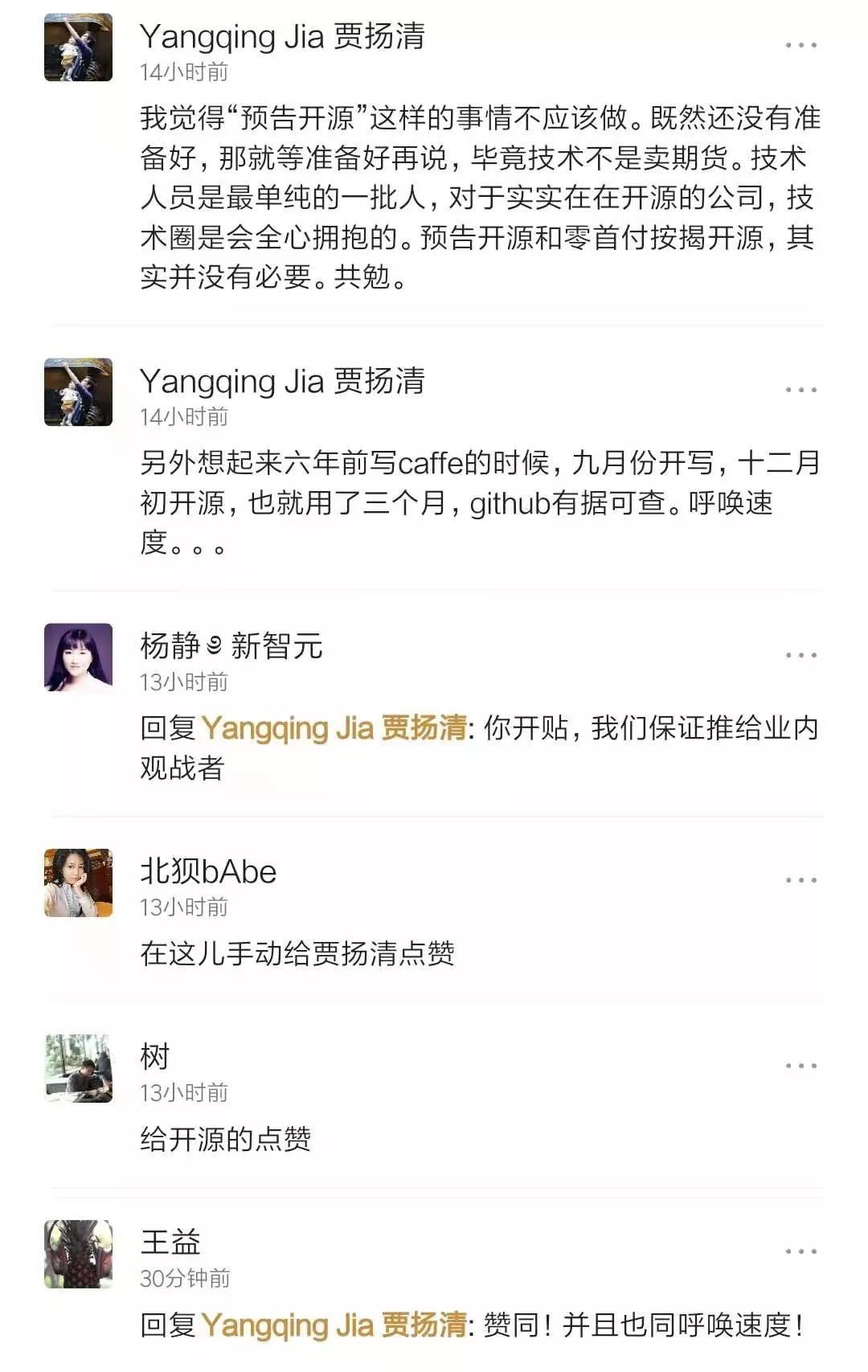

“这个‘开源框架’什么时候开源啊?”王益这一问,引发了圈里热议,贾扬清也来评论:

贾扬清表示:

我觉得“预告开源”这样的事情不应该做。既然还没有准备好,那就等准备好再说,毕竟技术不是卖期货。技术人员是最单纯的一批人,对于实实在在开源的公司,技术圈是会全心拥抱的。预告开源和零首付按揭开源,其实并没有必要。共勉。

贾扬清还回忆起自己六年前写caffe的时候,九月份开始写,十二月初开源,也就用了三个月,github有据可查。并呼唤友商要速度。

这个帖子也引起了华为方的注意,华为MindSpore社区运营负责人黄之鹏解释道:

823的发布会上已经说了,明年Q1开源,感谢大家关心。github上的MindStudio是昇腾硬件的软件库,不是MindSpore。

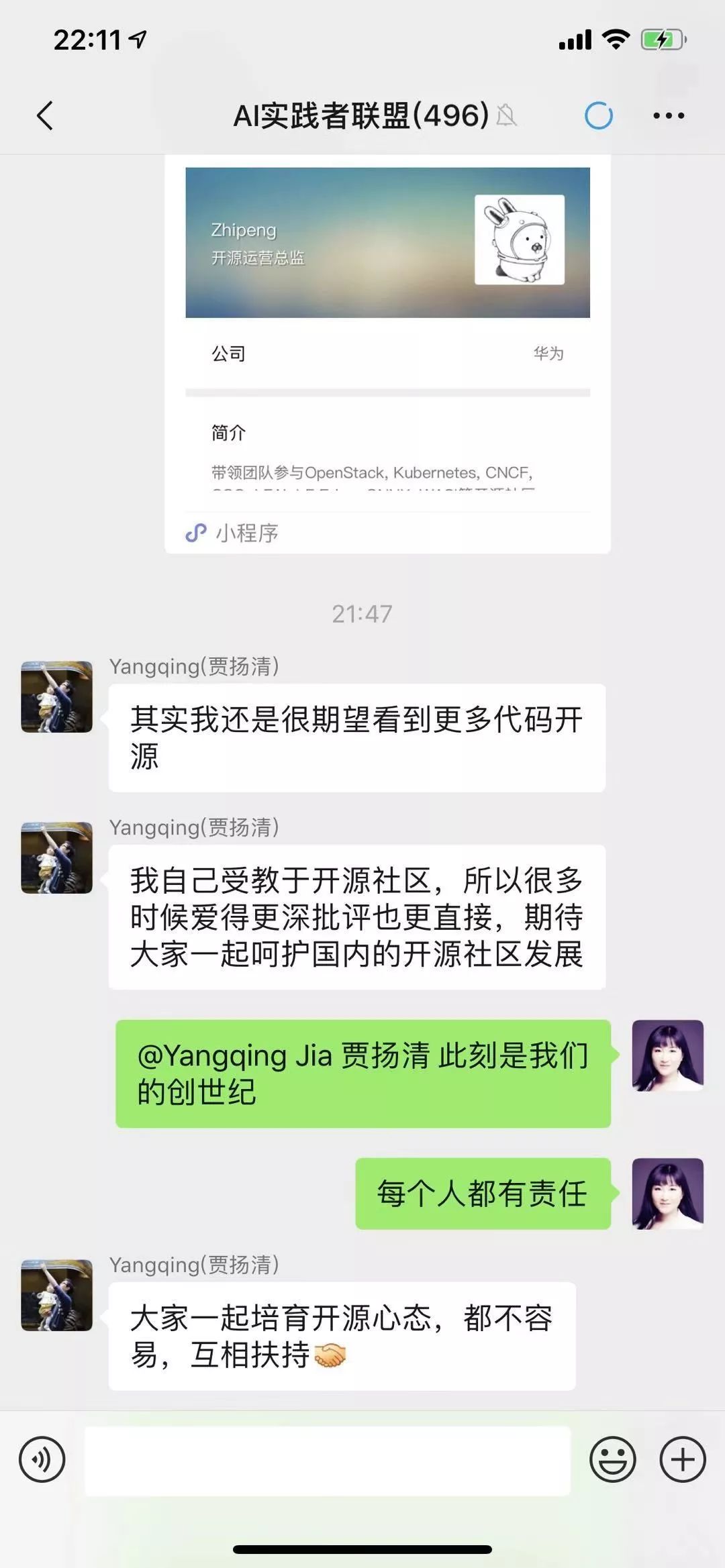

在百忙之中,贾扬清在新智元的AI实践者联盟群中表达了自己对开源的关切:

其实我还是很期望看到更多代码开源。

我自己受教于开源社区,所以很多时候爱得更深批评也更直接,期待大家一起呵护国内的开源社区发展。

作为

新智元AI朋友圈

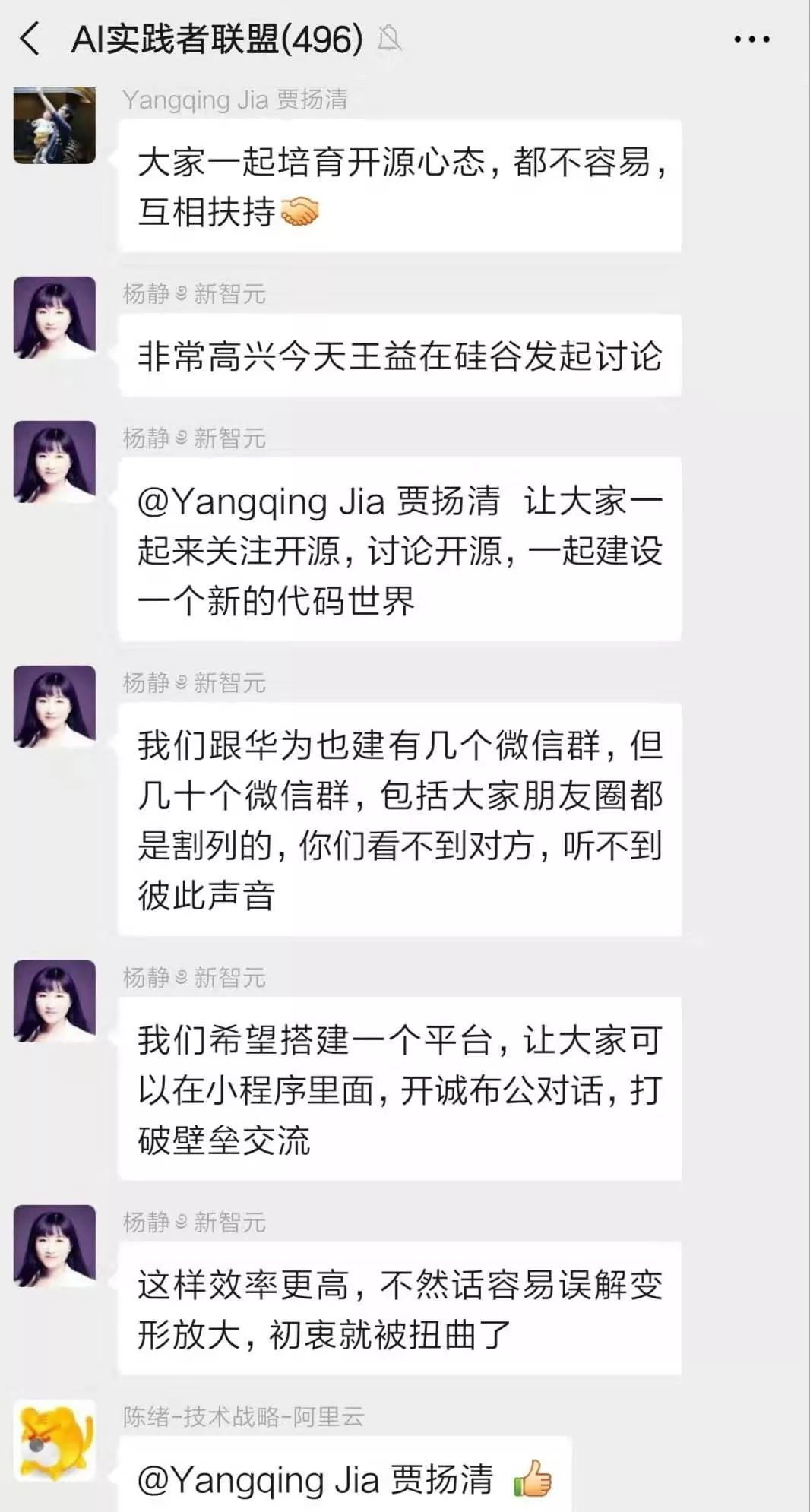

的联合创始人,新智元创始人兼CEO杨静女士也表达了自己的心声:

非常高兴今天王益在硅谷发起讨论,让大家一起来关注开源,讨论开源,一起建设一个新的代码世界。

我们跟华为也建有几个微信群,但几十个微信群,包括大家朋友圈都是割裂的,你们看不到对方,听不到彼此声音。

我们希望搭建一个平台,让大家可以在小程序里面,开诚布公对话,打破壁垒交流。这样效率更高,不然话容易误解变形放大,初衷就被扭曲了。

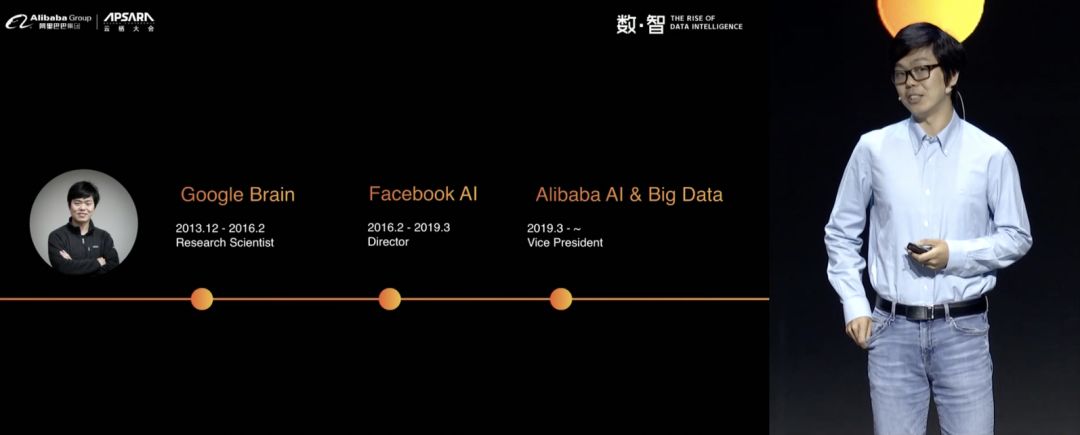

三大开源深度学习框架核心作者,贾扬清成阿里开源技术委员会负责人

在上个月的阿里云栖大会上,贾扬清正式成为阿里巴巴开源技术委员会负责人,开源升级成为阿里技术战略之一。

开源这件事,由贾扬清带领,更显得意义重大。因为他是当今最流行的三大开源深度学习框架Caffe、TensorFlow和PyTorch的核心作者之一。

熟悉贾扬清的朋友都知道,他在硅谷奠定自己AI大神的地位,是因为两个世界级的框架Caffe和TensorFlow。

Caffe是史上第一个通用深度学习框架,也是目前全球最普遍使用的深度学习框架之一,微软、雅虎、英伟达、Adobe等世界级大公司都在用。

而TensorFlow,不得不提到因围棋一战成名的机器人AlphaGo(阿尔法狗),TensorFlow就是阿尔法狗背后的强大支撑,被称为“谷歌大脑”。

他还担任过PyTorch 1.0项目的共同负责人,2017年创建了首个开放模型格式的原型,后来成了FB、微软、亚马逊和许多硬件供应商一起发布的ONNX。

那么,现任阿里巴巴开源技术委员会负责人的贾扬清要做什么事情呢?

他表示,必须把工具做好,向大家提供更加详细、经过测试的方法论,帮助开发者更容易推进自己的开源项目。如何利用开源项目和解决方案提高开发效率,包括测试部署工具,源代码管理工具,项目交流平台等。

谈到自己在伯克利开发Caffe、参与TensorFlow、Pytorch等开源框架的核心开发,贾扬清说这一切都是“机缘巧合”,Caffe用得很开心,于是把它开源出去,让社区所有人都能用到。

MindSpore 全场景AI计算框架,明年Q1开源

作为此次争议的主角,最后给大家介绍一下MindSpore。

今年8月23日,华为宣布采用达芬奇架构的又一款AI芯片——昇腾 910 ( Ascend 910) 正式商用,与之配套的Mindspore全场景AI计算框架也一同亮相。

徐直军发布了全场景AI计算框架 MindSpore,并宣布“MindSpore将在2020年Q1开源”。

![]()

一年后的今天,全场景AI计算框架MindSpore在这三个方面都取得了显著的进展:在原生适应每个场景包括端,边缘和云,并能够按需协同的基础上,通过实现AI算法即代码,使开发态变得更加友好,显著减少模型开发时间,降低了模型开发门槛。

MindSpore如何做到更快更高效?

MindSpore秉承“AI算法即代码”理念,提供一系列的关键技术,例如MindSpore自动微分,采用Source 2 Source方式实现,在性能和可编程性上,明显优于业界图和运算符重载方式。能够实现任意算子的微分表达和编译优化,同时实现反向算子自动生成,极大地方便了模型开发。

而随着数据集和模型规模越来越大,模型并行将成为必然趋势。相比手工切分的模型并行的门槛高、效率低、调优难,MindSpore只需定义单机模型,即可自动实现多机混合并行运行,无需了解AI集群细节。

主从控制模式中,CPU和GPU交互引入内存和数据开销。MindSpore在芯片上完成神经网络模型训练的所有控制和执行,减少和主机CPU的交互时间,速度更快。并在已有的分布式训练方案引入中心控制来寻找梯度同步点,MindSpore实现了去中心化的分布式梯度聚合,完全消除控制开销。

最终,软硬件优化为不同类型算子映射最佳的计算单元和数据布局,获得最佳的性能。

通过MindSpore自身的技术创新及MindSpore与Ascend处理器协同优化,实现了运行态的高效,大大提高了计算性能。除了昇腾处理器,MindSpore也支持GPU、CPU等其它处理器。

现在已有了TensorFlow、PyTorch框架,但还没有任何一个现有框架支持全场景,而这就是华为要做的——覆盖端-边缘-云,做一个能支持全场景的框架,实现AI无所不在越来越基础的需求,这也是MindSpore的重要特色。

针对不同的运行环境,MindSpore框架架构上支持可大可小 ,适应全场景独立部署。同时,MindSpore框架通过协同经过处理后的、不带有隐私信息的梯度、模型信息,而不是数据本身,以此实现在保证用户隐私数据保护的前提下跨场景协同。除了隐私保护,MindSpore还将模型保护Built-in到AI框架中,实现模型的安全可信。

为了降低AI开发者的开发门槛,MindSpore创造性地实现了AI算法即代码,使开发态变得更加友好,显著减少模型开发时间。以一个NLP(自然语言处理)典型网络为例,相比其他框架,

用MindSpore可降低核心代码量20%,开发门槛大大降低,效率整体提升50%以上。

写在最后:其实这次事件大家争议的地方在于还没有开源却在宣传时用“开源框架”到底合不合适?正如贾扬清所言:大家一起培育开源心态,都不容易,互相扶持。 我们期待看到更多的开源,也希望大家一起呵护国内的开源社区发展。