谷歌发布迄今最准确商用端到端语音识别系统,词错率将至5.6%,性能提升16%

新智元编译

来源:research.googleblog.com

【新智元导读】谷歌大脑和Speech团队发布最新端到端自动语音识别(ASR)模型,词错率将至5.6%,相比传统的商用方法实现了16%的改进。新方法利用联合训练,结合多种优化算法显著提升LAS模型的性能,在多语言/方言识别方面有令人瞩目的潜在应用。

论文:https://arxiv.org/pdf/1712.01769.pdf

在谷歌的各种语音搜索应用中使用的传统的自动语音识别(ASR)系统,包括一个声学模型(AM),一个发音模型(PM)和一个语言模型(LM),所有这些模型都是在不同的数据集上独立训练,并且通常是手动设计的。AM提取声学特征,并预测一组子词单元(subword unit),通常是上下文相关的或与上下文无关的音素。然后,一个手动设计的词典(PM)将声学模型生成的音素序列映射到单词。最后,LM将概率分配给单词序列。对独立的组件进行训练会增加复杂性,与联合训练所有组件相比并不是最佳的方法。在过去几年里,开发端到端系统越来越受欢迎,这些端到端系统试图将这些单独的组件作为一个单一的系统来学习。虽然这些端到端模型在已有研究中已经显示出不错的结果[2,3],但目前尚不清楚这种方法是否能够改进现有的最先进的传统系统。

谷歌最近公开了他们的最新研究:State-of-the-art Speech Recognition With Sequence-to-Sequence Models(“使用序列到序列模型的最先进的语音识别模型”)[4]。这篇论文描述了一个新的端到端模型,它的性能优于目前已商用的传统方法[1]。在谷歌的研究中,新的的端到端系统的词错率(WER)降到5.6%,相比使用传统方法的一个强大系统(词错率为6.7%),性能提高了16%。此外,这个端到端模型在任何假设重评分( hypothesis rescoring)之前输出初始词假设,由于不包含单独的LM和PM,它的大小只有传统模型的1/18。

这个系统建立在Listen-Attend-Spell(LAS)端到端架构上,最早是由William Chan等人在Listen, Attend and Spell [2]这篇论文中提出。LAS架构由3个组件组成。分别是 listener 编码器,它与标准AM类似,接受输入语音信号x的时频表示,并使用一组神经网络层将输入映射到一个更高级的特征表示 henc。编码器的输出被传递给一个 attender,它使用henc来学习输入特征x和预测的子词单元{yn,...,y0}之间的对齐,其中每个子词通常是一个字素。最后,attention模块的输出被传递给类似LM的speller(即,解码器),它产生一组假设词的概率分布。

LAS端到端模型的组件

LAS模型的所有组件都作为单一的端到端神经网络进行联合训练,而不是像传统的系统那样作为单独的模块进行训练,这使得训练更简单。

此外,由于LAS模型完全是神经网络,所以不需要外部的、手工设计的组件,例如有限状态转换器,词典或文本标准化模块。最后,与传统模型不同的是,训练端到端模型不需要从一个单独的系统中生成的决策树或时间校准引导,并且可以在给定的文本记录和相应的声学特征对下训练。

在文献[4]中,我们介绍了一系列新的结构上的改进,包括优化传递给解码器的注意力向量,以及用更长的子字单元(即字符)进行训练。此外,我们还介绍了优化训练过程的一些方法,包括使用最小词错率训练[5]。正是这些结构化和优化改进使得新模型相对传统模型得到16%的性能提升。

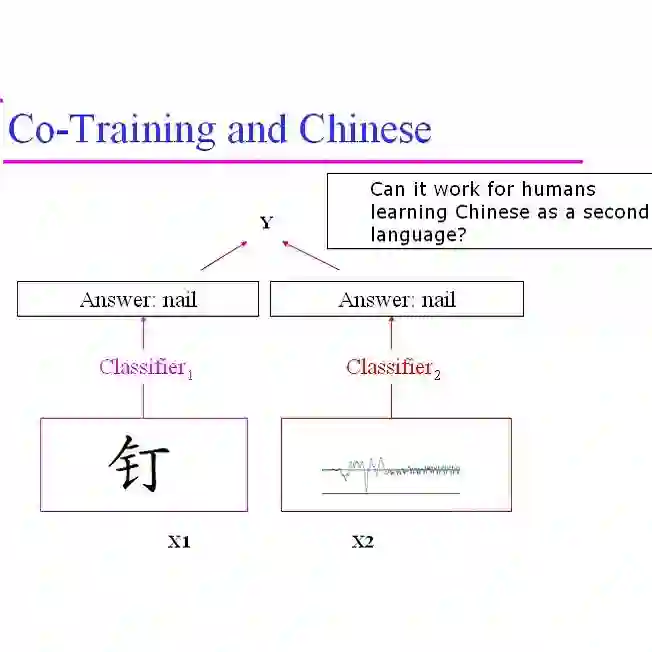

这项研究的另一个令人兴奋的潜在应用是多方言和多语言系统,其中优化单个神经网络的简单性使得这样的模型非常有吸引力。在这里,所有的方言/语言的数据可以组合起来训练一个网络,而不需要为每种方言/语言单独设置AM,PM和LM。我们发现,这些模型在7种英语方言[6]和9种印度语方言[7]上运作良好,表现比单独在各种语言/方言上分别训练的模型更好。

虽然结果令人瞩目,但研究人员认为目前的工作尚未完成。目前,这些模型不能实时处理语音[8,9,10],而实时处理对于语音搜索等对延迟敏感的应用是很强的需求。另外,在现场生产的数据上评估时,这些模型仍然不够好。 此外,我们的端到端模型是在22000个音频-文本对上学习的,而传统的系统通常是在大得多的语料库上训练。最后,这个新模型不能学习罕用词汇的正确拼写,例如专有名词,通常需要手动设计的PM。谷歌接下来的努力将集中在这些挑战上。

摘要

基于attention的编码器-解码器架构,例如Listen, Attend and Spell(LAS),将传统的自动语音识别(ASR)系统的声学模型、发音模型和语言模型组件组合成一个单独的神经网络。我们以前的工作已经证明这样的架构在听写任务上可以媲美最先进的ASR系统,但对于语音搜索等更具挑战性的任务,这样的架构是否可行还不明确。在这项工作中,我们探索了LAS模型的各种结构化和优化改进,从而显着提高了其性能。在结构方面,我们表明,字段(word piece)模型可以用来代替字素(grapheme)。

我们提出了一种新的多头注意力架构(multi-head attention architecture),它比常用的单头注意力有所改进。在优化方面,我们探索了同步训练,scheduled sampling,标签平滑,以及应用最小词错率优化等技术,这些都是为了提高准确性。我们用一个单向LSTM编码器来呈现流式识别结果。在一个12500小时的语音搜索任务中,我们发现所提出的改进方案将LAS系统的WER从9.2%降低到5.6%,这相对当前最优的传统系统提高了16%(当前最优的传统系统WER为6.7%)。

参考文献:

[1] G. Pundak and T. N. Sainath, “Lower Frame Rate Neural Network Acoustic Models," in Proc. Interspeech, 2016.

[2] W. Chan, N. Jaitly, Q. V. Le, and O. Vinyals, “Listen, attend and spell,” CoRR, vol. abs/1508.01211, 2015

[3] R. Prabhavalkar, K. Rao, T. N. Sainath, B. Li, L. Johnson, and N. Jaitly, “A Comparison of Sequence-to-sequence Models for Speech Recognition,” in Proc. Interspeech, 2017.

[4] C.C. Chiu, T.N. Sainath, Y. Wu, R. Prabhavalkar, P. Nguyen, Z. Chen, A. Kannan, R.J. Weiss, K. Rao, K. Gonina, N. Jaitly, B. Li, J. Chorowski and M. Bacchiani, “State-of-the-art Speech Recognition With Sequence-to-Sequence Models,” submitted to ICASSP 2018.

[5] R. Prabhavalkar, T.N. Sainath, Y. Wu, P. Nguyen, Z. Chen, C.C. Chiu and A. Kannan, “Minimum Word Error Rate Training for Attention-based Sequence-to-Sequence Models,” submitted to ICASSP 2018.

[6] B. Li, T.N. Sainath, K. Sim, M. Bacchiani, E. Weinstein, P. Nguyen, Z. Chen, Y. Wu and K. Rao, “Multi-Dialect Speech Recognition With a Single Sequence-to-Sequence Model” submitted to ICASSP 2018.

[7] S. Toshniwal, T.N. Sainath, R.J. Weiss, B. Li, P. Moreno, E. Weinstein and K. Rao, “End-to-End Multilingual Speech Recognition using Encoder-Decoder Models”, submitted to ICASSP 2018.

[8] T.N. Sainath, C.C. Chiu, R. Prabhavalkar, A. Kannan, Y. Wu, P. Nguyen and Z. Chen, “Improving the Performance of Online Neural Transducer Models”, submitted to ICASSP 2018.

[9] C.C. Chiu* and C. Raffel*, “Monotonic Chunkwise Attention,” submitted to ICLR 2018.

[10] D. Lawson*, C.C. Chiu*, G. Tucker*, C. Raffel, K. Swersky, N. Jaitly. “Learning Hard Alignments with Variational Inference”, submitted to ICASSP 2018.

[11] T.N. Sainath, R. Prabhavalkar, S. Kumar, S. Lee, A. Kannan, D. Rybach, V. Schogol, P. Nguyen, B. Li, Y. Wu, Z. Chen and C.C. Chiu, “No Need for a Lexicon? Evaluating the Value of the Pronunciation Lexica in End-to-End Models,” submitted to ICASSP 2018.

[12] A. Kannan, Y. Wu, P. Nguyen, T.N. Sainath, Z. Chen and R. Prabhavalkar. “An Analysis of Incorporating an External Language Model into a Sequence-to-Sequence Model,” submitted to ICASSP 2018.

论文:https://arxiv.org/pdf/1712.01769.pdf

谷歌博客:https://research.googleblog.com/2017/12/improving-end-to-end-models-for-speech.html