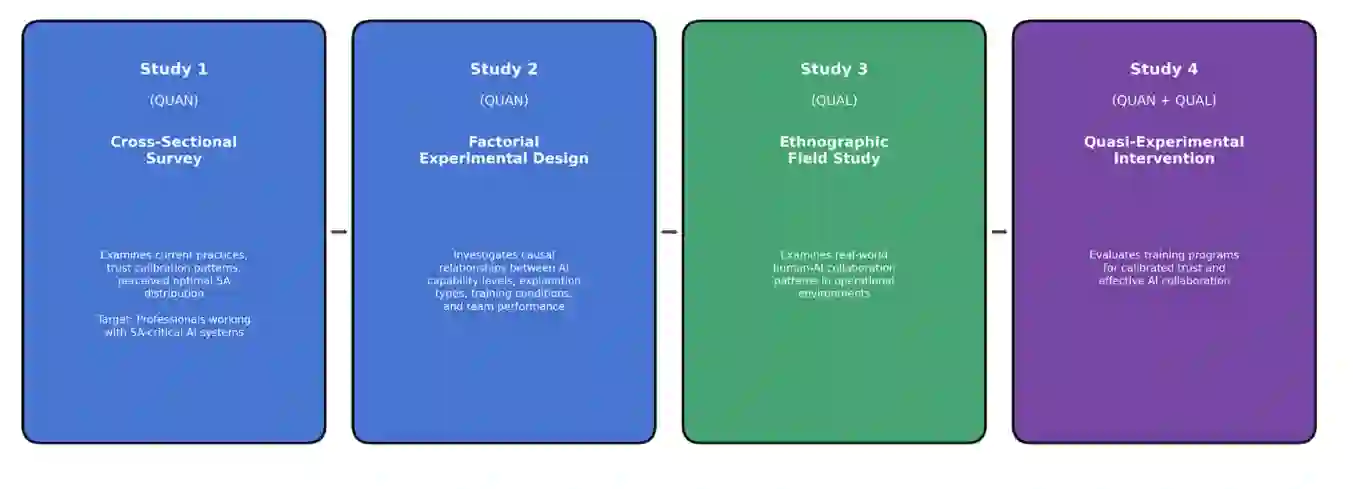

本文研究了高压决策环境中的人机协作,探讨了情境感知应如何在人类操作员与人工智能系统之间分配、影响校准信任的因素、人工智能解释模式对团队绩效的影响以及培训干预的有效性。本研究基于分布式认知理论、联合认知系统框架、三级SA模型以及自动化信任框架,弥补了面向安全关键环境的人机组队配置在实证验证方面的关键空白。研究进行了四项互补性研究:一项针对航空、医疗保健和安全领域512名专业人员的横断面调查;一项涉及240名参与者、操纵人工智能能力、解释类型和培训条件的因子实验;一项在操作环境中对48名参与者进行的定性实地研究;一项对180名参与者进行的随机对照干预研究。关键发现表明,最优SA分配取决于任务特征和AI能力水平,个体SA显著预测团队绩效。信任校准呈现为一个包含感知能力、信任对齐、不确定性识别和元认知监控的四因素结构。与侧重于感知或理解的解释相比,聚焦于预测的三级SA解释产生了显著更优的团队绩效。培训干预对信任校准和团队绩效均产生了较大效应,其益处在八周后的跟踪评估中得以保持。这些发现推进了对人机协作的理论理解,同时为人工智能系统设计、组织培训计划以及管理安全关键领域人工智能部署的监管框架提供了基于证据的指导方针。

关键词:人机协作,情境感知,信任校准,高压决策,分布式认知,可解释人工智能,混合方法,安全关键系统

成为VIP会员查看完整内容