在开放世界环境中部署机器学习模型时,如何确保其可靠性与安全性是当前人工智能安全研究中的核心挑战。本文旨在从算法设计与理论基础两个维度出发,系统研究在分布不确定性和未知类别情形下,从传统神经网络到现代基础模型(如大型语言模型(LLMs))所面临的关键可靠性问题。 本论文的主要挑战在于:如何评估现有机器学习算法的可靠性。当前主流模型通常仅关注在分布内(in-distribution, ID)数据上的误差最小化,却未充分考虑在分布外(out-of-distribution, OOD)情形下可能出现的不确定性。例如,广泛应用的经验风险最小化(empirical risk minimization, ERM)假设训练和推理阶段不存在分布漂移(即封闭世界假设)。在此假设下训练出的模型,往往在OOD数据上会做出过于自信的预测,这是因为其决策边界缺乏保守性。

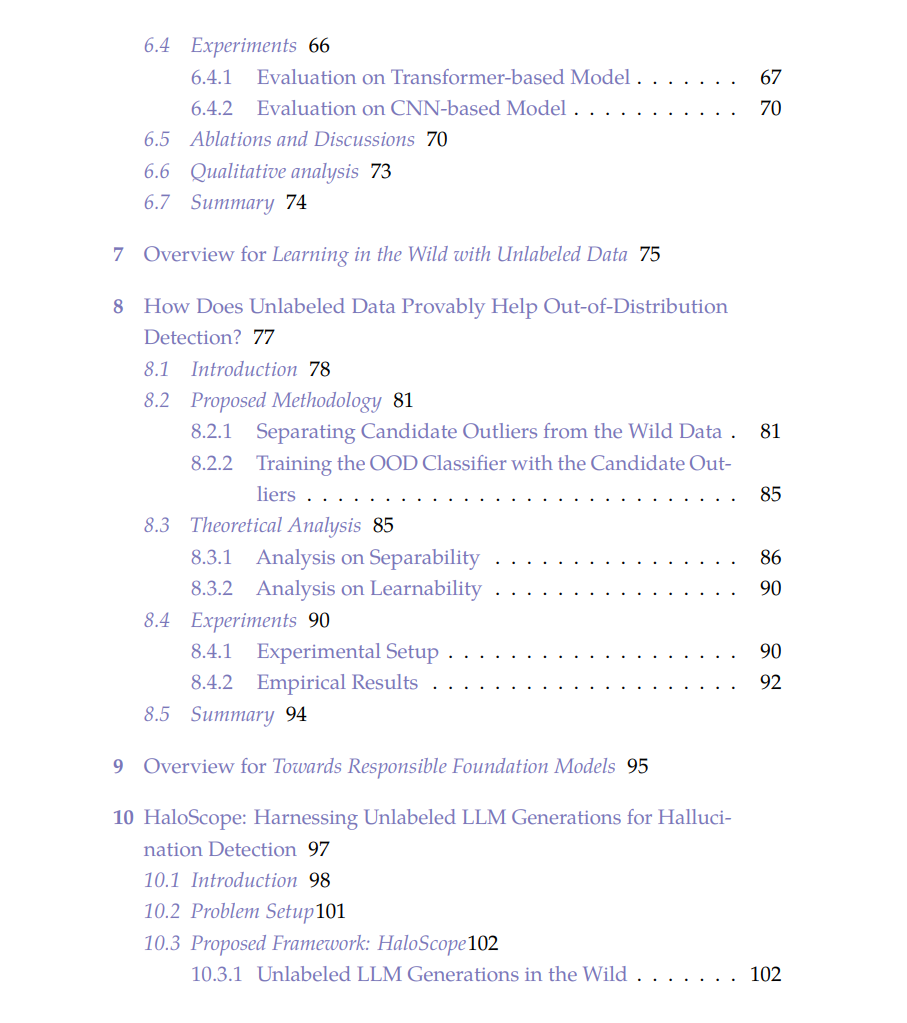

为应对这一挑战,本文提出了一系列联合优化框架,目标是同时实现:(1) 对ID样本的准确预测,以及 (2) 对OOD数据的可靠处理。 为解决上述问题,我们提出了一种未知感知(unknown-aware)学习框架,使得模型无需预先了解未知类别的明确信息,便能够识别和处理新颖输入。具体而言,本文首先设计了几种新的异常样本合成范式(如 VOS、NPOS 和 DREAM-OOD),用于在训练阶段生成具有代表性的“未知”样本,从而在无需任何标注OOD数据的前提下,提升模型的分布外检测能力。 在此基础上,本文进一步提出了适用于真实环境的野外未知感知学习(SAL, unknown-aware learning in the wild)方法,通过利用未标注的部署数据来增强模型对OOD样本的可靠性。这些方法不仅提供了理论上的性能保证,还实证表明:可以有效利用大量未标注数据来检测并适应未知输入,从而在现实条件下显著提升模型的可靠性。 此外,本文还扩展了对大规模基础模型(包括最新的文本模型与多模态大型语言模型)的可靠性研究。提出了以下关键技术: * HaloScope:用于检测模型生成内容中的幻觉现象(hallucinations); * MLLMGuard:用于防御恶意提示(malicious prompts); * 对齐数据清洗技术:用于去除训练过程中的噪声或偏见反馈数据。

通过缓解上述失败模式,本文提升了最前沿AI系统的交互安全性。 本研究不仅在方法论上具有创新性,在应用影响上也具有广泛意义:它们共同推动了可靠AI决策系统的构建,并奠定了未知感知学习作为未来主流范式的基础。我们希望这些工作能够激发更多关于分布外泛化与未知处理的研究,助力构建更加安全、稳健的智能系统,同时降低对人力干预的依赖。