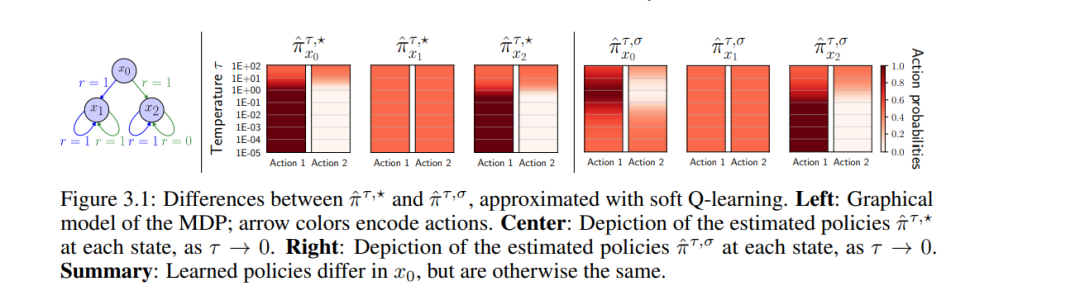

在寻找最优策略的过程中,强化学习(RL)方法通常除关注期望回报之外,很少顾及已学习策略的其他性质。因此,即便训练成功,也难以刻画将被学得的是哪些策略以及它们将如何行动。本文提出了一个用于策略优化的理论框架,通过熵正则化温度趋零与一种温度解耦手法,保证收敛到某个特定的最优策略。我们的做法在正则化温度趋于零时,实现一个可解释且保持多样性的最优策略,并确保由策略派生的对象——价值函数与回报分布——也随之收敛。在该方法的一个具体实例中,得到的策略将以均匀概率对所有最优动作进行采样。借助所提出的温度解耦手法,我们进一步给出一种算法,能够以任意精度估计与其可解释、保持多样性的最优策略相对应的回报分布。

成为VIP会员查看完整内容