开源微服务编排框架:Netflix Conductor

一 简介

-

允许创建复杂的业务流程,流程中每个独立的任务都是由一个微服务所实现。 -

基于JSON DSL 创建工作流,对任务的执行进行编排。 -

工作流在执行的过程中可见、可追溯。 -

提供暂停、恢复、重启等多种控制模型。 -

提供一种简单的方式来最大限度重用微服务。 -

拥有扩展到百万流程并发运行的服务能力。 -

通过队列服务实现客户端与服务端的分离。 -

支持 HTTP 或其他RPC协议进行数据传送

二 基本概念

1 Task

-

System Task:被conductor服务执行,这些任务的执行与引擎在同一个JVM中。

-

Worker Task:被worker服务执行,执行与引擎隔离开,worker通过队列获取任务后,执行并更新结果状态到引擎。Worker的实现是跨语言的,其使用Http协议与Server通信。

-

功能性Task:

-

HTTP:发送http请求

-

JSON_JQ_TRANSFORM:jq命令执行,一般用户json的转换,具体可见jq官方文档

-

KAFKA_PUBLISH: 发布kafka消息

-

流程控制Task:

-

SWITCH(原Decision):条件判断分支,类似于代码中的switch case

-

FORK:启动并行分支,用于调度并行任务

-

JOIN:汇总并行分支,用于汇总并行任务

-

DO_WHILE:循环,类似于代码中的do while

-

WAIT:一直在运行中,直到外部时间触发更新节点状态,可用于等待外部操作

-

SUB_WORKFLOW:子流程,执行其他的流程

-

TERMINATE:结束流程,以指定输出提前结束流程,可以与SWITCH节点配合使用,类似代码中的提前return语句

-

对于System Task,Conductor提供了WorkflowSystemTask 抽象类,可以自定义扩展实现。

-

对于Worker Task,可以实现conductor的client Worker接口实现执行逻辑。

2 Workflow

-

Workflow由一系列需要执行的Task组成,conductor采用json来描述Task的流转关系。

-

除基本的顺序流程外,借助内置的SWITCH、FORK、JOIN、DO_WIHLE、TERMINATE任务,还能实现分支、并行、循环、提前结束等流程控制。

3 Input&Output

-

Task有自己的输入和输出,输入输出都是jsonobject类型。

-

Task可以引用其他Task的输入输出,使用${taskxxx.output}的方式引用。引用语法为json-path,除最基础的${taskxxx.output}的值解析方式外,还支持其他复杂操作,如过滤等,具体见json-path语法。

-

启动Workflow时可以传入流程的输入数据,Task可以通过${workflow.input}的方式引用。

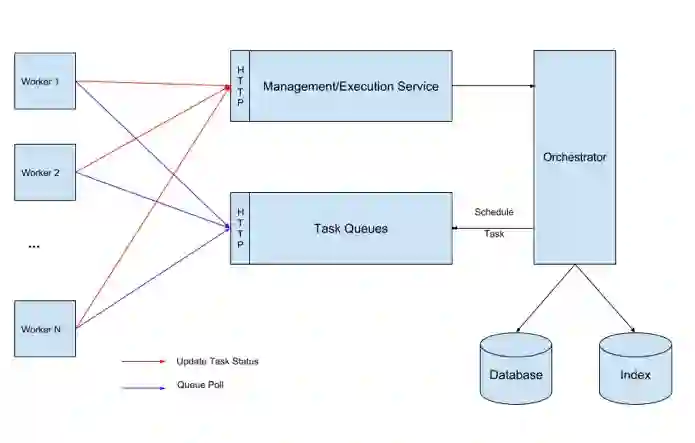

三 整体架构

-

Orchestrator: 负责流程的流转调度工作;

-

Management/Execution Service: 提供流程、任务的管理更新等操作;

-

TaskQueues: 任务队列,Orchestrator解析出来的待执行Task会放到队列中;

-

Worker: 任务执行worker,从TaskQueues中获取任务,通过Execution Service更新任务状态与结果数据;

-

Database: 元数据&运行时数据库,用于保存运行时的Workflow、Task等状态信息,以及流程任务定义的等原信息;

-

Index: 索引数据库,用于存储执行历史;

四 运行模型

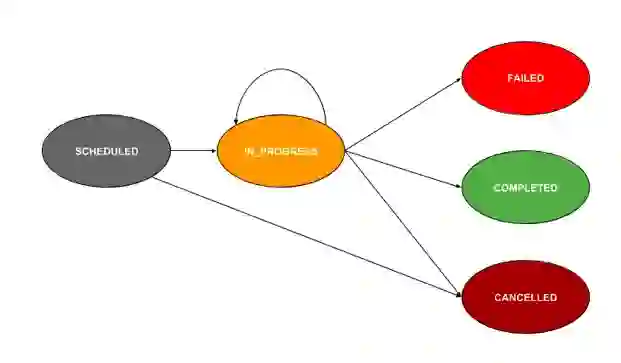

1 Task状态转移

-

SCHEDULED:待调度,task放到队列中还没有被poll出来执行时的状态 -

IN_PROGRESS:执行中,被poll出来执行但还没有完成时的状态 -

COMPLETED:执行完成 -

FAILED:执行失败 -

CANCELLED:被中止时为此状态,一般出现在两种情况:

-

1.手动中止流程时,正在运行中的task会被置为此状态;

-

2.多个fork分支,当某个分支的task失败时,其它分支中正在运行的task会被置为此状态;

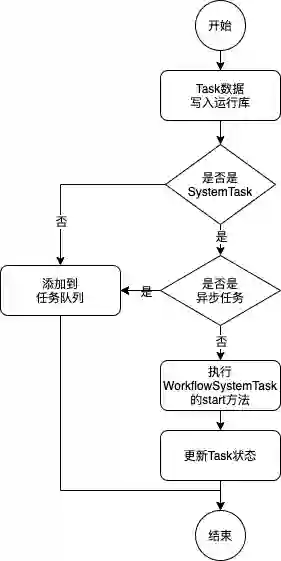

2 任务队列

-

任务队列,是一个带有延迟、优先级功能的队列;

-

每种类型的Task是一个单独的队列,此外,如果配置了domain、isolationGroup,还会拆分成多个队列实现执行隔离;

-

decider service是生产者,其根据流程配置与当前执行情况,解析出可执行的task后,添加到队列;

-

任务执行器(SystemTaskWorker、Worker)是消费者,其长轮询对应的队列,从队列中获取任务执行;

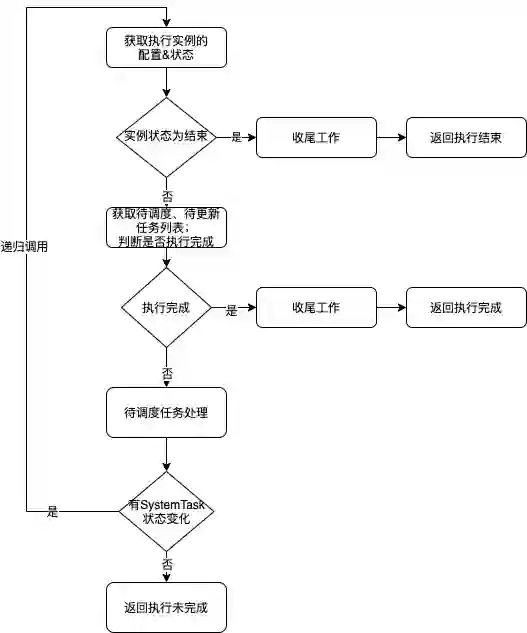

3 核心功能实现机制

decide的触发时机

-

新启动执行时,会触发decide操作 -

系统任务执行完成时,会触发decide操作 -

Workder任务通过ExecutionService更新任务状态时,会触发decide操作

流程控制节点的实现机制

1)Task & TaskMapper

-

Task:任务的执行逻辑代码,它的作用是Task的执行

-

TaskMapper:任务的映射逻辑代码,它通过Task的定义配置、当前实例的执行状态等信息,返回实际需要执行的Task列表

2)条件分支(SWITCH)的实现机制

// 待调度的Task list,最终返回结果List<Task> tasksToBeScheduled = new LinkedList<>();// evalResult是分支条件变量的值(case)// decisionCases是一个Map结构,key为分支的case值,value为对应分支的任务定义list(分支内的任务定义会有多个)// 根据分支变量的实际值,获取对应分支的任务定义listList<WorkflowTask> selectedTasks = taskToSchedule.getDecisionCases().get(evalResult);// default的逻辑:如果获取不到对应的分支或者分支为空,则用默认的分支if (selectedTasks == null || selectedTasks.isEmpty()) { selectedTasks = taskToSchedule.getDefaultCase();}if (selectedTasks != null && !selectedTasks.isEmpty()) { // 获取分支的第一个(下标0)task,返回给decider service去做调度(decider会把任务添加到队列里,交给worker去执行) WorkflowTask selectedTask = selectedTasks.get(0); // 调用了deciderService的getTasksToBeScheduled方法,此方法里又获取到TaskMapper调用了getMappedTasks。这里采用了递归调用的方式,解析嵌套的Task List<Task> caseTasks = taskMapperContext.getDeciderService() .getTasksToBeScheduled(workflowInstance, selectedTask, retryCount, taskMapperContext.getRetryTaskId()); tasksToBeScheduled.addAll(caseTasks); switchTask.getInputData().put("hasChildren", "true");}return tasksToBeScheduled;

3)并行(FORK)的实现机制

// 待调度的Task list,最终返回结果List<Task> tasksToBeScheduled = new LinkedList<>();// 配置中的所有fork分支List<List<WorkflowTask>> forkTasks = taskToSchedule.getForkTasks();for (List<WorkflowTask> wfts : forkTasks) { // 每个分支取第一个Task WorkflowTask wft = wfts.get(0); // 调用了deciderService的getTasksToBeScheduled方法,此方法里又获取到TaskMapper调用了getMappedTasks。这里采用了递归调用的方式,解析嵌套的Task List<Task> tasks2 = taskMapperContext.getDeciderService() .getTasksToBeScheduled(workflowInstance, wft, retryCount); tasksToBeScheduled.addAll(tasks2);}return tasksToBeScheduled;

重试的实现机制

五 完整性保障机制

1 WorkflowReconciler

2 decideQueue

3 ExecutionLockService

if (!executionLockService.acquireLock(workflowId)) {return false;}

PostgreSQL实战进阶

PostgreSQL被誉为“世界上功能最强大的开源数据库”,是以加州大学伯克利分校计算机系开发的POSTGRES 4.2为基础的对象关系型数据库管理系统。PostgreSQL支持大部分 SQL标准并且提供了许多其他现代特性:复杂查询、外键、触发器、视图、事务完整性、MVCC。同样,PostgreSQL 可以用许多方法扩展,比如,通过增加新的数据类型、函数、操作符、聚集函数、索引。开发者可以免费使用、修改、和分发 PostgreSQL,不管是私用、商用、还是学术研究使用。

本课程由PostgreSQL社区核心成员出品,带你快速从0-1深入PostgreSQL核心特性。点击阅读原文查看详情。

登录查看更多

相关内容

专知会员服务

158+阅读 · 2020年1月29日