近年来,各大著名人工智能会议提交的论文数量一直在稳步增长。以 AAAI 为例,该会议前 33 年 (1980-2012 年) 收到的提交材料都不足 1000 份,到 2015 年收到的提交材料不足 2000 份,到 2018 年收到的提交材料不足 4000 份。但到了 AAAI 2021,已经有超过 9000 份提交。

为了跟上日益增长的提交数量,AAAI 程序委员会也做出了相对调整,比如近 10000 名审稿人参与了 AAAI 2021 的会议审稿。鉴于这种大型会议的规模和紧迫的时间安排,分配审稿人并提供高质量的 review 正成为一个越来越具有挑战性的问题。

其中一些关键的问题包括:评估既有的审稿人如何审阅一篇论文;如何确定好的审稿人 - 论文匹配关系;确定哪些论文可能在没有完整 review 的情况下被拒稿;以及鉴定参与 bid、review 或评分等影响论文结果的审稿人。

![]()

论文链接:https://arxiv.org/abs/2202.12273

在 AAAI 2021 的论文匹配过程中,官方组委会解决了这些挑战,并提出了一个新颖的自动化 pipeline 审稿人。pipeline 由三个关键特征组成:

(1)收集和处理输入数据,以识别有问题的匹配项,并产生审稿人的评审分数;

(3)将评审过程分为两个阶段,以便更好地将评审资源分配给 borderline paper。

这项研究引入了一种新颖的方法来替代摘要拒稿(summary rejection),称为两阶段评审(two-phase reviewing)。不仅 AAAI 2022 延续了这一方法,IJCAI 2022 和 ICML 2022 也采用了这一方法。

大致而言,对于一篇投稿,最初只分配两个 review,而不是分配三个 review。如果这两个 review 一致认为一篇论文应该被拒稿,那么它就不会得到进一步的 review。审稿的第二阶段是为剩下的论文分配两个额外的 review。这种方法的意义在于:

a)将 review 重新分配给 borderline paper,同时保证给了第一阶段被拒稿的论文作者提供有意义的反馈(两次全面的 review) ;

b)避免了单独摘要拒稿阶段的以同样方式处理所有论文的成本;

c)作为奖励,它会给程序主席第二次机会,为确定有问题或第一阶段审稿人误判的论文分配额外的审稿人。

在 AAAI 2021 的投稿中,2615 篇论文 (37%) 收到了两个「建议拒稿」的 high-confidence 评论,因此在第一阶段被拒稿了。这提供了剩余的 2615 个 review 可供第二阶段的 borderline paper 中使用。

当然,一个关键的问题是,第一阶段被拒稿的论文如果得到了 4 个完整 review,是否最终会被接收?因此这项研究也提供了一个对照组,对照组里的论文不需要经过两阶段评审,即那些在第一阶段没有经过两次完整 review 的文件。通过对这些论文最终收到的大量 review 进行二次抽样,研究者估计,第一阶段被拒稿的论文最终被 AAAI 2021 接收的概率只有 2.9% 。

研究的其余部分结构如下:第 2 部分描述了数据收集和处理方法的细节;第 3 部分提出了审稿人 - 论文匹配问题的混合整数规划公式;第 4 部分描述了两阶段评审方案;第 5 部分包括了 AAAI 2021 部署该方法后的详尽实验分析数据;最后,第 6 部分总结了该方法的贡献。在此之前,许多相关的工作已经研究了审稿人与论文匹配问题的不同方面,研究者也在相应的部分讨论了相关的工作。

在论文中,研究者介绍了用于收集和处理有关审稿人及论文原始数据,并将其转化为审稿人 - 论文匹配度总分的技术。

首先要关注的是「利益冲突」问题,如果审稿人由于与论文的一个或多个作者的关系而无法对论文提供公正的 review,那么审稿人和论文之间就存在利益冲突(COI,Conflict of Interest),这些审稿人可能对论文的接收或拒稿更感兴趣,甚至会超出期望看到高质量论文发表的愿望。例如,假如一篇论文的作者是之前的导师,我们中的大多数人很难提供一个完全没有偏见的意见。显然,审稿人不应该与他们拥有利益冲突的论文相匹配。

此外,bid 中包含了关于审稿人偏好的重要信息。研究者认为,将它们考虑在内将大大有助于审稿人对分配的满意度。但审稿人可能恶意误报 bid,以确保论文的接收或拒稿 [Noothigattu et al., 2021]。过去的大多数会议都试图通过区域主席(AC) 监督、抽查讨论和告密者举报来发现这种不当行为。但是这些方法是劳动密集型的,也是不可扩展的。

还有一个审稿人 - 论文自动匹配中的关键问题是,如何量化将审稿人与提交的论文进行匹配的价值。简而言之,如果审稿人对论文的主题有专业知识并且对论文感兴趣,那么我们认为,这次匹配就是好的。这项研究通过聚合三个互补的信号来评估专业知识: 多伦多论文匹配系统 (TPMS) 分数; ACL 匹配分数; 论文主要和次要主题领域关键词与审稿人关键词的匹配程度。

研究者通过 bid 来评估审稿人对论文的兴趣程度,先假设一个对论文感兴趣的基线水平,对于这些论文,预计审稿人具备专业知识,而且审稿人没有提交任何明确 (正面或负面) 的 bid。

2014 NeurIPS 的组织者曾做过一个很有影响力的实验 [Lawrence and Cortes, 2014] ,让两个独立的项目委员会各自 review 10% 的提交材料。研究发现,最强的论文(一小部分) 和最弱的论文 (更多的一部分) 能被可靠地识别出来,但是许多靠近决策边界(decision boundary)的论文,可能被一个项目委员会接收,却被另一个项目委员会拒稿。自那时以来,会议组织者一直设法将几乎肯定会被拒稿的论文的 review 资源重新分配给有现实机会被接收的文件,以提高后一类论文的 review 质量。

其中一个比较受欢迎的方法是,采用简单的启发式设计来检测低质量的论文,这个过程被称为「摘要拒稿(summary rejection)」或「直接拒稿(desk rejection)」。例如在 IJCAI 2020 中,区域主席被要求花费一小段时间浏览每篇论文,以决定它是否值得更仔细的 review[Bessiere,2020]。Neurips 2020 采用了一个类似的系统: 在三个星期内,区域主席浏览了 9000 多份论文,以确定明确拒稿和高级区域主席交叉 review 等进一步选择,而 11% 的提交收到了摘要拒稿[Yuan, 2020]。

考虑到人工智能会议的规模,这样的摘要拒稿程序对于区域主席来说是非常耗时的。此外,它们很可能是有噪声的,也可能反映出对论文表面性质的无意识偏见,这意味着它们可能不够可靠,不足以拒掉相对较小的论文部分。最后,这样的程序往往不受作者欢迎,没有人喜欢他们的论文通过一个不透明的过程被拒稿,甚至没有产生任何评论。基于这些原因,NeurIPS 大会在 2020 年收到的负面反馈的基础上,决定在 2021 年不采用这种方法。

他们提出了一种新的的提前拒稿方法,同时满足几点要求:将会议的审查预算集中在接近决策边界的论文上,为提前拒稿论文的作者提供有意义的反馈,减少提前拒稿最终可能被接收的论文。

该方法将审稿分成两个阶段。在第一阶段,每篇论文分配两名审稿人,那些收到了两份 high-confidence review 建议拒稿的论文会被拒稿,作者会立即收到这些全面的 review,并且没有机会提出 rebuttal。然后,审稿过程进入第二阶段,为剩下的每篇论文分配两个或两个以上的额外审稿人。

在第二轮 review 之后,作者会进行 rebuttal,两个阶段的审稿人都会被要求阅读 rebuttal 和彼此的 review,参与由 SPCs 和 ACs 的讨论,并最终相应地修改他们的 review。然后,项目主席根据委员会的建议作出决定。

在 AAAI 2021 会议中,部署了这项研究中的审稿人 - 论文匹配方法。研究者分析了来自主会议 8072 个审稿人的 6729 个提交文件及其评论的数据集。受限于现实因素,此处不能公布用于任何分析的数据,因为关于会议审查过程的数据本质上是敏感的,研究者将发现总结如下:

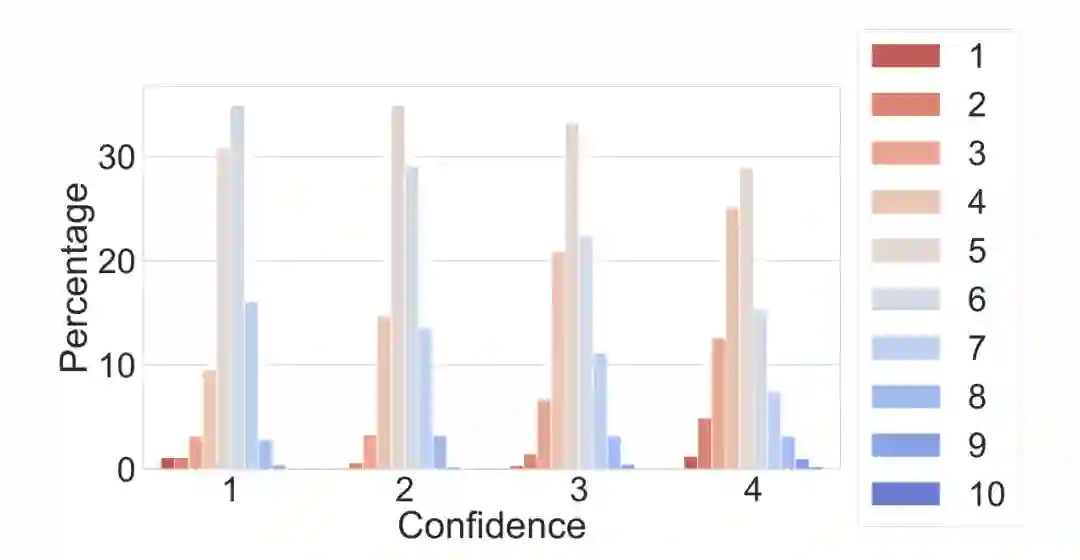

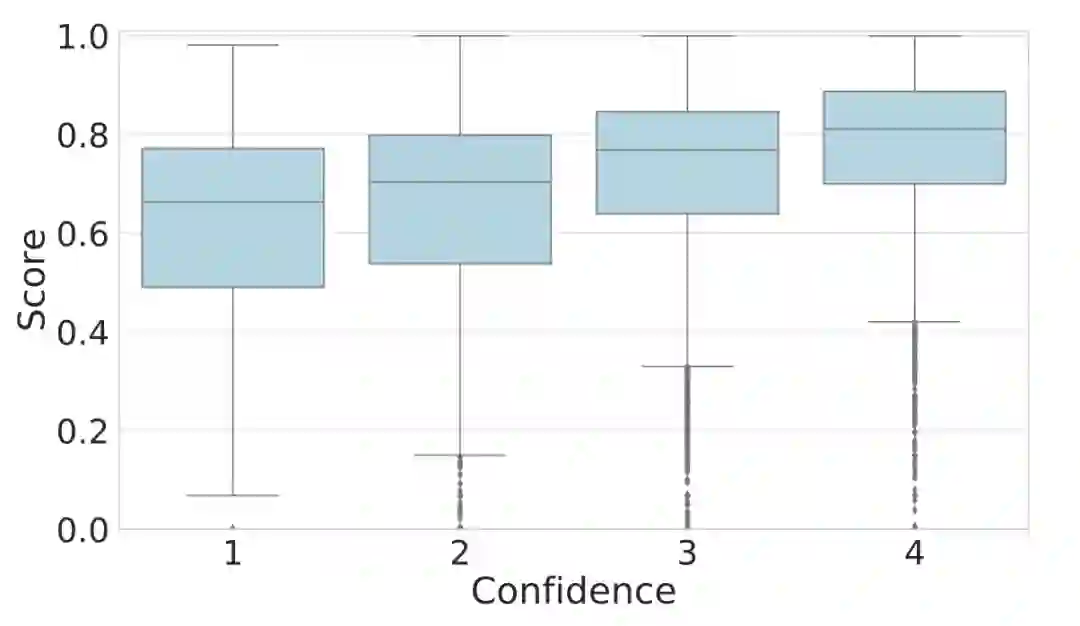

一个问题是,评分机制是否充分考虑到了审稿人的专业度?如图 1 所示,越 confident 的审稿人倾向于给出的论文分数分布越广(更少给出临界的 5 分和 6 分)。考虑到 higher confidence 的 review 信息量更大,研究者研究了评分机制和报告的审稿人 confidence 程度之间的关系。如图 2 所示,评分函数与 confidence 呈正相关: 随着 confidence 的增加,评分的第 25、50 和 75 百分比也增加了。

![]()

图 1: 审稿人 confidence 的论文分数分布。

![]()

图 2:在 AAAI 2021 上匹配的所有审稿人 - 论文中,最终 review 的 confidence vs. 预测总分。

此外,研究者还评估了这一方法的 COI 检测效果。这里将自我报告的冲突、明确给定的冲突以及提交给 AAAI 2021 的论文合著者之间的冲突视为「微不足道的」。研究者发现,在检测出的总共 2674372 个冲突中,96.4% 都属于此类。

其余 3.6% 的冲突中,2.8% 是由于未报告的合作关系,随后通过 DBLP 验证。其余 0.8% 的冲突发生在被预测到的学生 - 导师组合或同一导师的学生之间。总的来说,该系统在大多数 (78.8%) 的提交中检测到了至少一个重要的冲突。

在第一阶段拒掉论文最大的风险是,这篇论文如果有另一次审查、rebuttal 和讨论的机会,能否被接收?

要估计这些论文最终被接收的概率,最简单的方法就是随机推广一部分在第一阶段被拒稿的论文,并观察结果。研究者没有进行这个实验,但是用真实的数据提供了一个非常相似的自然实验。具体来说,可以考虑所有因为一个或多个 review 或审稿人 confidence 不足而被提升到第二阶段的论文,并检查最终被接收的这些论文的子集。总共有 231 份论文以这种方式推广,其中 16 份最终被接收。

这些论文最终都得到了四次或更多的高 confidence 的 review,这样就可以计算出两次随机选择的 review 都是负评价的概率,也就是说,基于这些 review,论文在第一阶段就会被拒。

在本文实验的数据中,这个概率大约是 2.9% ,这表明第一阶段的拒稿的假阴性概率是很低的。

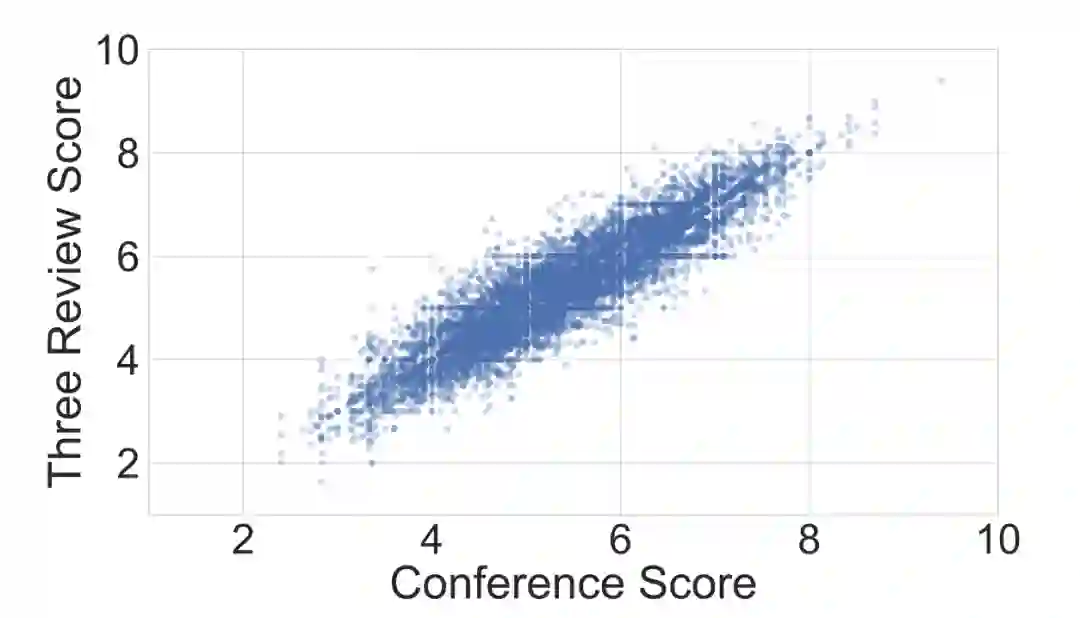

最后,研究者也评估了额外 review 的重要性,并将结果展示在图 7 中。每一个点相当于一篇论文的 3 次 review。X 轴给出论文在 AAAI 2021 会议上的得分(在那里它收到了超过 3 个 review) ; y 轴给出了 3 个 review 得分的范围。虽然许多低于这个门槛的论文被接收,而且许多高于这个门槛的论文被拒稿,但决策边界的录取通过率降到了 6.4 左右。

![]()

图 7:Confidence 权重的平均得分,第二阶段中论文 vs.3 次 review 的组合。

公众号后台回复“数据集”获取50+深度学习数据集下载~

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~

觉得有用麻烦给个在看啦~

![]()