ICML 2019 最佳论文公布:继霸榜后,谷歌再添重磅奖项!

「锦上添花」!

AI 科技评论按:彼时,为期 7 天(6 月 9 日至 15 日)的 ICML 2019(国际机器学习大会)正在美国加州如火如荼地举行。据 ICML 2019 前不久公布的论文结果,今年大会共收到 3424 篇有效投稿论文,最终收录的论文数量为 774 篇,接收率为 22.6%。而今天,万众瞩目的 ICML 2019 最佳论文结果最新出炉,将会议推向了高潮。

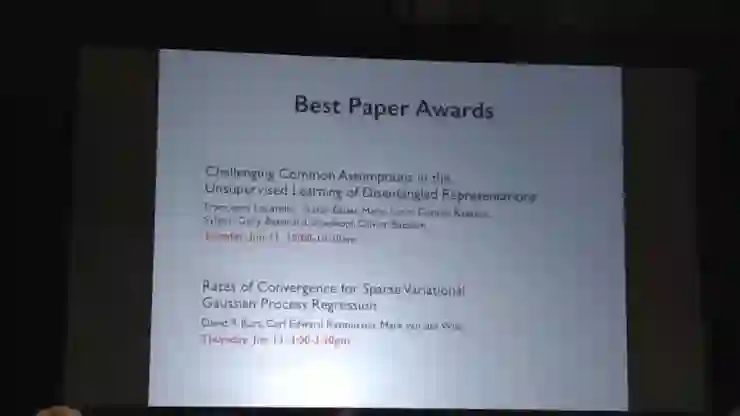

(图片来源:Twitter 网友)

本届最佳论文共有 2 篇,分别是:

《挑战无监督解耦表示学习中的常见假设》,论文作者分别来自谷歌大脑、马克斯·普朗克学会( Max-Planck-Gesellschaft )以及苏黎世联邦理工学院(ETH Zurich);

《稀疏变分高斯过程回归的收敛速度》,论文作者来自剑桥大学。

《挑战无监督解耦表示学习中的常见假设》

Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations

论文作者:Francesco Locatello, Stefan Bauer, Mario Lucic, Gunnar Rätsch, Sylvain Gelly, Bernhard Schölkopf, Olivier Bachem

论文下载地址:https://arxiv.org/abs/1811.12359

论文摘要:无监督解耦表示学习背后的关键思路是,真实世界的数据是由大量的变量解释因子生成的,而无监督学习算法可以对这些因子实现修复。在本论文中,我们严谨地回顾了该领域的最新进展,并对一些常见假设提出了异议。我们首先从理论上验证,如果模型和数据都没有归纳偏置,无监督解耦表示学习基本上是不可能实现的。之后,我们在 7 个不同的数据集上训练了 12000 多个模型,涵盖了可重复、大规模实验研究中最重要的方法和评估指标。我们发现,虽然不同的方法都成功地执行了由相应损失「鼓励」的属性,但是在无监督的情况下,这些方法似乎都无法识别出良好解耦的模型。除此之外,增加解耦似乎并不会降低下游任务学习的样本复杂度。而我们的研究结果最终表明,未来对于解耦学习的研究应该明确归纳偏见和(隐式)监督在其中所发挥的作用,探究强制学习到的表示解耦的明确利好,并考虑涵盖多个数据集的可重复的实验设置。

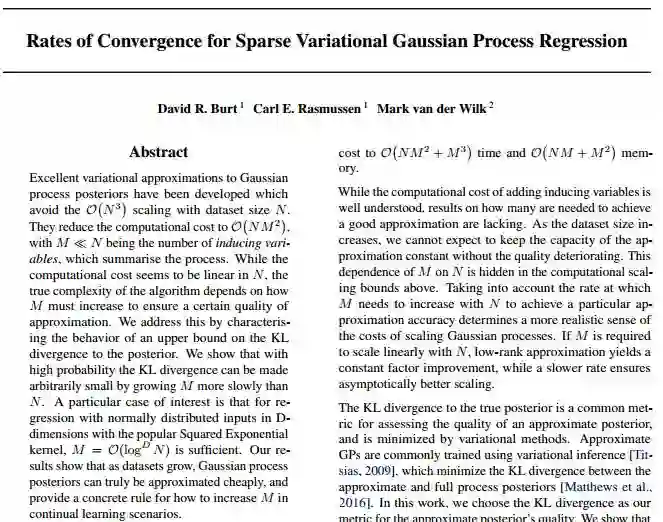

《稀疏变分高斯过程回归的收敛速度》

Rates of Convergence for Sparse Variational Gaussian Process Regression

论文作者:David R. Burt, Carl E. Rasmussen, Mark van der Wilk

论文下载地址:https://arxiv.org/abs/1903.03571

论文摘要:此前,我们对高斯过程后验提出了效果很不错的变分近似法,从而避免了数据集大小为 N 时,O(N3) 发生缩放。这些方法将计算成本降到了 O(NM2),其中 M≤N 作为诱导概括高斯过程的变量的数值。虽然大小为 N 的数据集的计算成本几乎呈线性,但算法真正的复杂性取决于 M 如何增加以确保一定的近似质量。对此,我们通过描述 KL 向后发散的上界行为来解决这个问题,并证明了在高概率情况下,通过让 M 的增长速度慢于 N,从而使得 KL 的发散度可随意减小。其中一个特别受关注的案例是,具有 D 维度中正态分布输入为的回归,使用常用的平方指数核函数 M=O(logDN) 便足够了。我们的研究结果表明,随着数据集的增加,高斯过程后验可以真正近似地逼近,并为如何在连续学习场景中增加 M 提供了具体规则。

(图片来源:Twitter 网友)

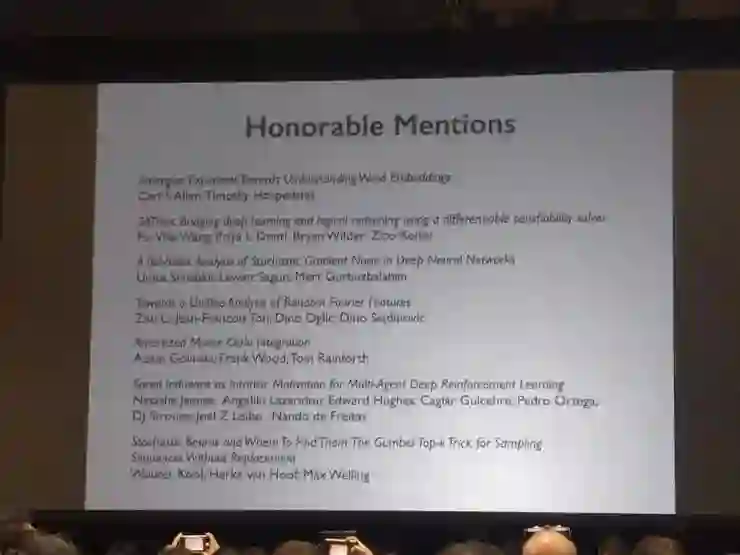

同期,ICML 2019 也公布了 7 篇摘得提名奖(Honorable Mentions)的论文,分别如下:

《类比可解释性:趋向理解词嵌入》

Analogies Explained: Towards Understanding Word Embeddings

作者:Carl Allen,Timothy Hospedales

论文下载地址:https://arxiv.org/pdf/1901.09813.pdf

《SATNet:使用差分可满足性求解器来桥接深度学习和逻辑推理》

SATNet: Bridging deep learning and logical reasoning using a differentiable satisfiability solver

作者:Po-WeiWang,Priya L. Donti,Bryan Wilder,Zico Kolter

论文下载地址:https://arxiv.org/pdf/1905.12149.pdf

《深度神经网络中随机梯度噪声的尾指数分析》

A Tail-Index Analysis of Stochastic Gradient Noise in Deep Neural Networks

作者:Umut Şimşekli,L, event Sagun, Mert Gürbüzbalaban

论文下载地址:https://arxiv.org/pdf/1901.06053.pdf

《趋向随机傅里叶特征的统一分析》

Towards A Unified Analysis of Random Fourier Features

作者:Zhu Li,Jean-François Ton,Dino Oglic,Dino Sejdinovic

论文下载地址:https://arxiv.org/pdf/1806.09178.pdf

《分期偿还的蒙特卡罗积分》

Amortized Monte Carlo Integration

作者:Adam Golinski、Yee Whye Teh、Frank Wood、Tom Rainforth

论文下载地址:http://www.gatsby.ucl.ac.uk/~balaji/udl-camera-ready/UDL-12.pdf

《多智能体深度强化学习的内在动机的社会影响》

Social Influence as Intrinsic Motivation for Multi-Agent Deep Reinforcement Learning

作者:Natasha Jaques, Angeliki Lazaridou, Edward Hughes, Caglar Gulcehre, Pedro A. Ortega, DJ Strouse, Joel Z. Leibo, Nando de Freitas

论文下载地址:https://arxiv.org/pdf/1810.08647.pdf

《随机波束以及找到它们的地方:取样序列无需更换的 Gumbel-Top-k 方法》

Stochastic Beams and Where to Find Them: The Gumbel-Top-k Trick for Sampling Sequences Without Replacement

作者:Wouter Kool, Herke van Hoof, Max Welling

论文下载地址:https://arxiv.org/pdf/1903.06059.pdf

5 月中,我们在《ICML 2019 论文收录 TOP 榜单:清华领衔七家国内高校、企业登上榜单》一文中提到,谷歌在 reddit 网友根据 ICML 2019 论文收录名单统计出的几大 TOP 榜单中霸榜,让排名其后的研究机构们都望尘莫及:

在研究机构收录论文 TOP 榜单中,谷歌以 80+ 篇收录论文数量位列第一且遥遥领先于排在其之后的 MIT、加州大学伯克利分校、谷歌大脑、斯坦福大学、CMU 以及微软。另外在将工业界单拎出来的工业界研究机构收录论文 TOP榜单中,谷歌及其附属公司谷歌大脑、DeepMind 夺得前四席位,更是以压倒性优势拔得头筹。

在以唯一作者、第一作者身份被收录论文的作者 TOP 榜单中,来自谷歌的 Ashok Cutkosky 拿下了该榜单的第一名,在其被收录的 3 篇论文中,有 1 篇唯一作者被收录的论文、1 篇以第一作者被收录的论文。

在各研究机构相对贡献 TOP 榜单中,谷歌依旧独占鳌头,相对贡献接近 40,遥遥领先于其后的斯坦福大学、加州大学伯克利分校、MIT、CMU。

而如今最佳论文奖揭晓,则是为谷歌在本届 ICML 中所取得的佳绩再添了一层光辉!

封面图来源:

LIONS lab,https://actu.epfl.ch/news/lions-icml-2019/

由中国计算机学会主办、雷锋网和香港中文大学(深圳)联合承办的 2019 全球人工智能与机器人峰会( CCF-GAIR 2019),将于 2019 年 7 月 12 日至 14 日在深圳举行。

届时,诺贝尔奖得主JamesJ. Heckman、中外院士、世界顶会主席、知名Fellow,多位重磅嘉宾将亲自坐阵,一起探讨人工智能和机器人领域学、产、投等复杂的生存态势。

今日限量赠送3张850元门票优惠码,门票原价1999元,打开以下任一链接即可使用,券后仅1149元,限量3张,先到先得,送完即止。

https://gair.leiphone.com/gair/coupon/s/5cff23c18b3cc

https://gair.leiphone.com/gair/coupon/s/5cff23c18b0c7

https://gair.leiphone.com/gair/coupon/s/5cff23c18ad7c