超强大自动NLP工具!谷歌推出AutoML自然语言预训练模型

新智元报道

新智元报道

来源:venturebeat

编辑:肖琴

【新智元导读】谷歌近日宣布面向全球用户推出AutoML Natural Language的通用版本,支持分类、情绪分析和实体提取等任务,以及支持各种文件格式,包括扫描的pdf文件。现在戳右边链接上 新智元小程序 了解更多!

今年早些时候,谷歌发布了AutoML自然语言(AutoML Natural Language),这是其Cloud AutoML机器学习平台向自然语言处理领域的扩展。

经过数月的beta测试,谷歌近日宣布面向全球用户推出AutoML Natural Language的通用版本,支持分类、情绪分析和实体提取等任务,以及支持各种文件格式,包括扫描的pdf文件。

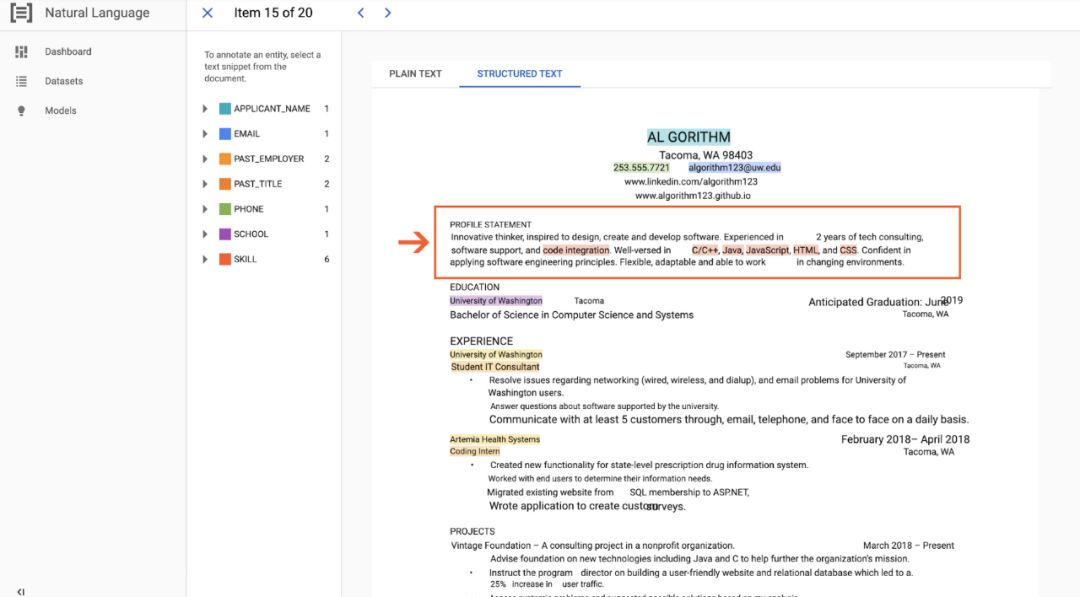

AutoML自然语言利用机器学习来揭示电子邮件、聊天日志、社交媒体帖子等文本的结构和含义。它可以从上传或粘贴的文本、或谷歌云存储的文档中提取关于人、地点和事件的信息,允许用户训练自己的自定义AI模型来对情绪、实体、内容和语法等进行分类、检测和分析。此外,它还提供自定义实体提取功能,该功能可以在文档中识别出标准语言模型未出现的特定于领域的实体。

AutoML Natural Language有超过5000个分类标签,并允许训练多达100万个文档,文档的大小最大10MB。谷歌表示,这使得它非常适合“复杂”的用例,比如理解法律文件或为拥有大量内容的组织进行文档分割。

自发布以来的几个月中,它已经得到很大改进,特别是在文本和文档实体提取方面。谷歌表示,AutoML自然语言现在可以考虑附加上下文(例如文档的空间结构和布局信息)来训练模型和预测,提高发票、收据、简历和合同等类型文本的识别能力。

此外,谷歌表示,AutoML Natural Language现在已经获得FedRAMP的中级授权(FedRAMP 是为政府启用安全云计算的美国程序),使联邦机构更容易利用AutoML的功能。

赫斯特集团(Hearst,美国出版界巨头)已经在使用AutoML Natural Language来帮助组织其国内和国际杂志的内容,日本出版商日经集团(Nikkei Group)也在利用AutoML Translate来发布不同语言的文章。Chicory是第三个早期采用者,利用它为Kroger、Amazon和Instacart等杂货零售商开发定制数字购物和营销解决方案。

AutoML Natural Language的产品经理Lewis Liu在一篇博客文章中解释说,他们的最终目标是为需要定制机器学习模型的组织、研究人员和企业提供一种简单、实用的训练方法。“自然语言处理是揭示文本结构和意义的宝贵工具,”他说,“我们通过更好的微调技术和更大的模型搜索空间,与Google AI研究部门合作,不断提高模型的质量。我们还引入了更高级的特性来帮助 AutoML自然语言更好地理解文档。”

值得注意的是,AutoML是在AWS Textract之后推出的。AWS Textract是亚马逊开发的针对文本和数据提取的机器学习服务,于今年5月推出。微软在Azure Text Analytics中也提供类似的服务。

官网:

https://cloud.google.com/natural-language/#how-automl-natural-language-works