2018,一文看尽AI发展真相(上)

点击上方“公众号”可以订阅哦!

来源:stateoftheart.ai

编辑:文强、三石、元子

【导读】2018年还剩20天,人工智能的热度一点没减。除了下围棋、认人脸,人工智能究竟发展到了什么地步?汇总各领域学术论文最先进成果,今天,让我们来看计算机视觉和自然语言处理这两个领域AI进展的真实情况。

2018年,人工智能热度不减,成果不断。

虽然少了去年动辄“超越人类”的锐气,但“辅助人类”的人工智能,如今究竟发展到什么程度?就让我们在2018即将结束的时候,来一个简单的回顾。

抛开剂量谈毒性是耍流氓,抛开数据集和特定任务谈人工智能进展也一样。“state of the art.ai”是MIT和UNAM的学生做的一个网站,收进了目前最优的算法,涵盖了计算机视觉、游戏、自然语言处理、网络图和知识库、程序归纳和程序合成、音频处理、时间序列处理七个领域。

下面,我们就根据已经发表的科研论文,先来看看计算机视觉和自然语言处理这两大AI领域的情况。

3D/3D Reconstruction

“3D”可以说是眼下CV领域最火的一个词。今年各家智能手机宣传里都提到了“3D结构光”。那么,3D视觉发展到了什么程度?

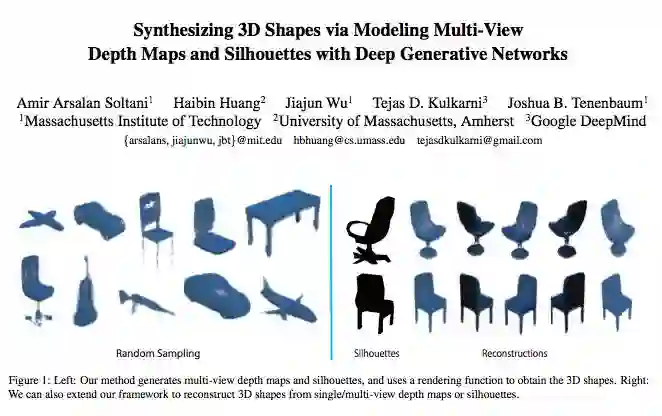

2017年的CVPR,MIT、马萨诸塞大学阿默斯特分校和谷歌DeepMind的研究人员展示了一项成果,使用自动编码器(VAE),构建了一个名叫SingleVPNet的框架,能从多个视角的深度图或其相应的轮廓(silhouette)学习生成模型,并使用渲染函数从这些图像生成细节精致的3D形状。

不仅如此,他们提出的框架还能通过综合不同视角的2D深度图(甚至在有遮挡的情况下),生成新的3D形状。

SingleVPNet在3D形状数据集SharpNetCore上取得了平均误差0.35的结果。换句话说,生成逼真的3D形状还有一段距离。

补充,SharpNetCore是ShapeNet的一个子集,目前包括55个常见对象类别(覆盖了计算机视觉领域常用的3D基准数据集PASCAL 3D+的12个对象类别),约有51300个独特的3D模型,每个模型都有手动验证的类别和对齐注释,由普林斯顿、斯坦福和丰田技术研究所(TTIC)的研究人员共同创建。

动作识别

动作识别指从视频中识别不同的动作,这个动作可能贯穿整个视频,也可能不会。动作识别是图像识别的扩展,涉及从多帧视频中进行图像识别,然后从每一个帧中聚集预测结果。

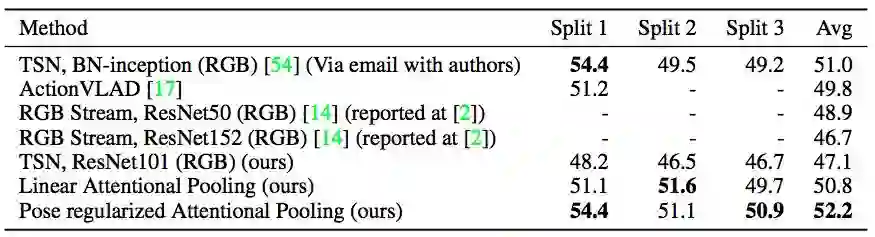

2017年的NeurIPS,CMU机器人学院的研究人员Rohit Girdhar 和 Deva Ramanan 利用注意力机制(Attentional Pooling),在保持网络复杂度和计算量基本不变的情况下,在三个静态图像和视频标准动作识别数据集上提升了动作识别的基准。其中,在MPII人体姿态数据集上取得了12.5%的相对改进。

不过,看绝对值,平均精度还停留在52.2个百分点上面。

人脸识别

根据美国国家标准与技术研究院(NIST)今年11月16日公布的结果,在被誉为工业界“黄金标准”的全球人脸识别算法测试(FRVT)中,依图科技以千万分之一误报下的识别准确率超过99%,继续保持全球人脸识别竞赛冠军。

千万分位误报下的识别准确率超过99%,意味着更多核心关键的安防场景被解锁。相比于去年同期,全球人脸识别性能提升了80%。

值得一提,在这份官方公布的报告中,中国人工智能公司实力展现,依图科技(yitu)、商汤科技(sensetime)、旷视科技(megvii)囊括了前十中的五席,加上排名第五的中国科学院深圳先进技术研究院(siat),中国团队已经超过半数,并稳稳“霸屏”前五,领跑全球人脸识别算法。

人体姿态估计

今年2月,上海交通大学卢策吾团队MVIG实验室AlphaPose 系统上线,是首个在 COCO 数据集上可达到 70+ mAP 的开源姿态估计系统。

今年9月,AlphaPose系统升级,采用 PyTorch 框架,在姿态估计标准测试集COCO validation set上,达到 71mAP的精度(比 OpenPose 相对提升17%,Mask-RCNN相对提升8%),同时,速度达到了20FPS(比 OpenPose 相对提高66%,Mask-RCNN相对提高300%)。

AlphaPose系统,是基于上海交大MVIG组提出的 RMPE 二步法框架(ICCV 2017论文)构建的,相比其他开源系统在准确率有很大提高,比OpenPose相对提高17%,Mask-RCNN相对提高8.2%。

升级后,各个开源框架在COCO-Validation上性能,时间在单卡1080ti GPU测出指标如下:

开源系统 |

准确率 |

平均速度 |

Openpose(CMU) |

60 mAP |

12 FPS |

Mask-RCNN(Facebook) |

67 mAP |

5 FPS |

Alphapose(SJTU) |

71 mAP |

20 FPS |

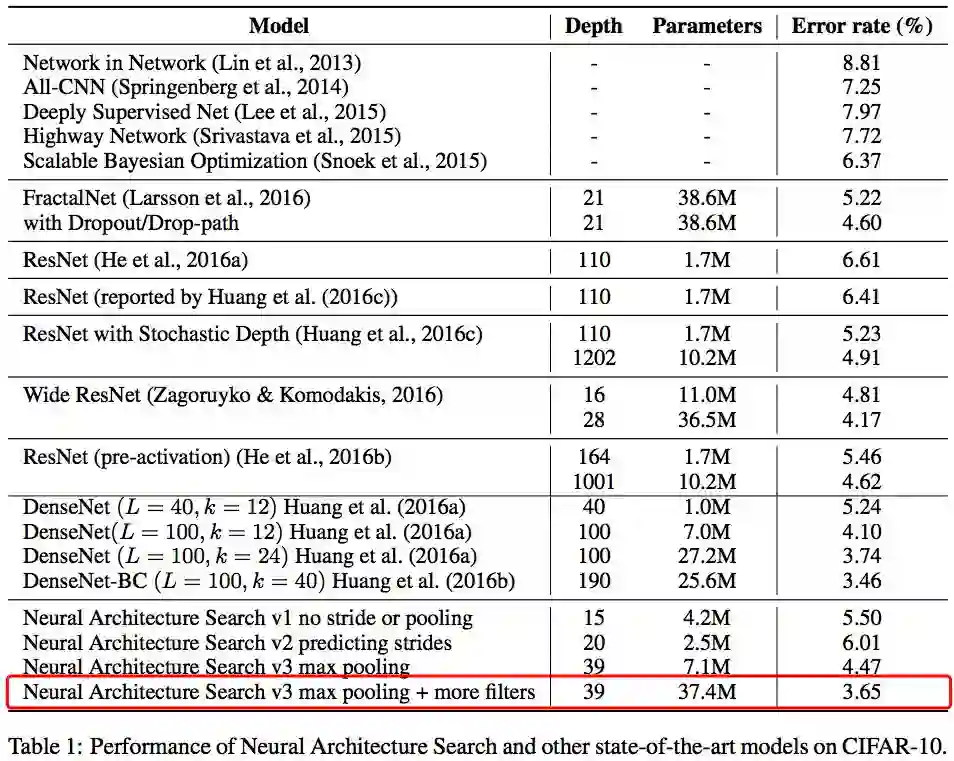

图像分类

计算机在图像分类任务上的精度早已超越了人类,因此当前图像分类精度的最好成绩,往往是其他研究的副产物。ICLR 2017,谷歌大脑 Barret Zoph 和 Quoc V. Le 发表了“Neural Architecture Search with Reinforcement Learning”,他们用强化学习自动搜索神经网络结构,最终AI自己设计出的模型,在 CIFAR-10数据集上做图像分类取得了96.35%的精度。

或许令人意外,图像分类目前最好结果是 Facebook AI Research 的 Benjamin Graham 在他2015年Arxiv论文“Fractional Max-Pooling”中得到的,经过100次测试后在CIFAR-10上误差仅为3.47%。这篇论文提出了一种新的 fractional max-pooling 方法,降低了各种数据集上的过拟合。

图像生成

说到图像生成,那自然就是生成对抗网络(GAN)。

GAN在今年不断发展,今年ICLR DeepMind 提出的 BigGAN,可谓当前最强图像生成模型,在128x128分辨率的ImageNet上训练,BigGAN的 Inception 分数(IS)可以达到 166.3 ,Frechet Inception 距离(FID)9.6。

关于BigGAN更详细的介绍看这里。

未来GAN还能提升到什么程度,值得期待!

图像分割

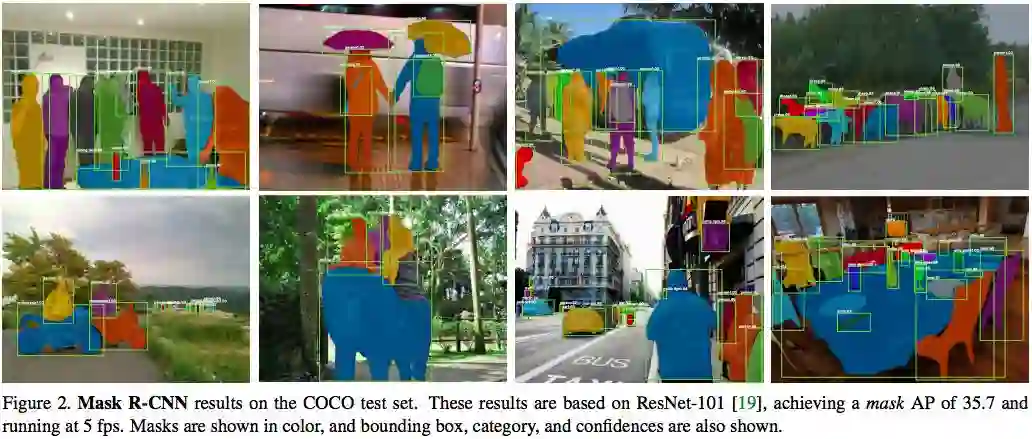

是的,图像分割王者是何恺明等人2017年提出的Mask-RCNN,mAP值26.2。

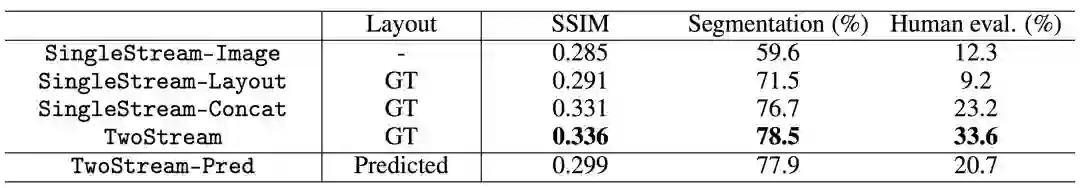

2018年8月,密歇根大学和谷歌大脑的研究人员合作,提出了一种图像语义分层处理框架,可以实现像素级别的图像语义理解和操纵,在图像中任意添加、改变、移动对象,并与原图浑然一体,实现真正的“毫无PS痕迹”。

虽然相关论文还未经过同行评议,但是根据上述研究人员在Arxiv论文汇报的结果,他们在图像分割上更胜一筹。

分类/语义相似度/语法/电影评论/语义等价/问答/实体识别

BERT这个名字近来在NLP领域可谓是红红火火。

10月13日,谷歌AI团队新发布的BERT模型,在机器阅读理解顶级水平测试SQuAD1.1中表现出惊人的成绩:全部两个衡量指标上全面超越人类!并且还在11种不同NLP测试中创出最佳成绩,包括将GLUE基准推至80.4%(绝对改进7.6%),MultiNLI准确度达到86.7% (绝对改进率5.6%)等。

谷歌团队的Thang Luong直接定义:BERT模型开启了NLP的新时代!

BERT的新语言表示模型,它代表Transformer的双向编码器表示。与最近的其他语言表示模型不同,BERT旨在通过联合调节所有层中的上下文来预先训练深度双向表示。因此,预训练的BERT表示可以通过一个额外的输出层进行微调,适用于广泛任务的最先进模型的构建。

如前文所述,BERT在11项NLP任务中刷新了性能表现记录!在此举出其中一项结果。

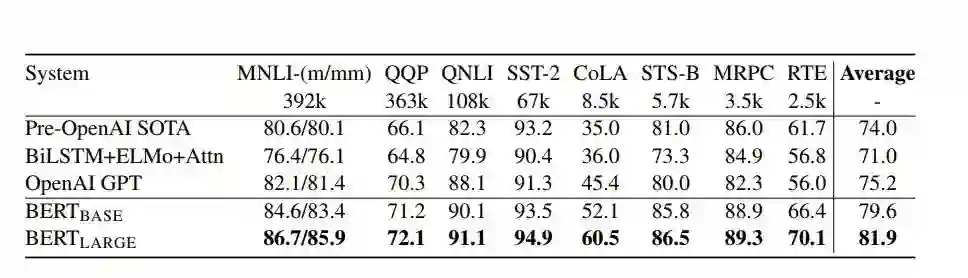

GLUE测试结果,由GLUE评估服务器给出。每个任务下方的数字表示训练样例的数量。“平均”一栏中的数据与GLUE官方评分稍有不同,因为我们排除了有问题的WNLI集。BERT 和OpenAI GPT的结果是单模型、单任务下的数据。所有结果来自https://gluebenchmark.com/leaderboard和https://blog.openai.com/language-unsupervised/

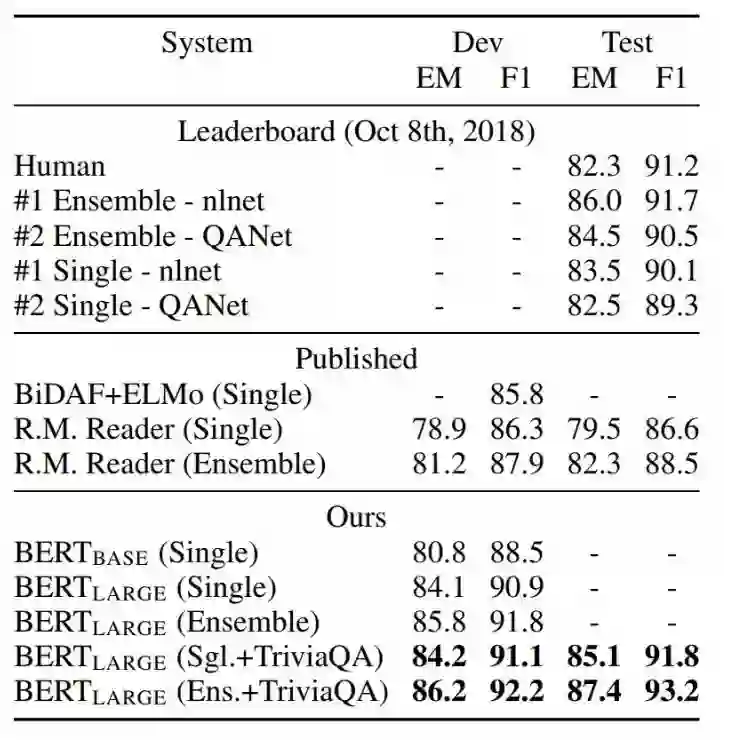

SQuAD 结果。BERT 集成是使用不同预训练检查点和微调种子(fine-tuning seed)的 7x 系统。

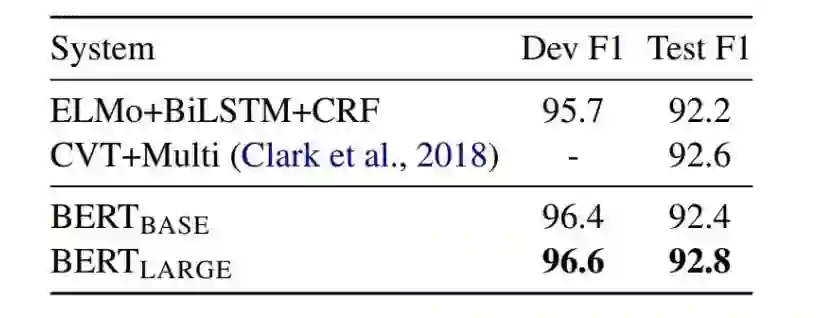

CoNLL-2003 命名实体识别结果。超参数由开发集选择,得出的开发和测试分数是使用这些超参数进行五次随机重启的平均值。

总体而言,BERT模型在NLP领域中的多项任务取得目前最佳效果,包括

分类、语义相似度、语法、电影评论、语义等价、问答、实体识别等等。

常识推理

在常识推理方面(Commensense Inference),目前取得最先进水平的是Antonio Lieto等人于2017年发布的文章:Dual PECCS: a cognitive system for conceptual representation and categorization。

当然,该篇文章的结果在概念分类准确率(Concept Categorization Accuracy)上目前最佳,为89;但在Dev和Test准确率方面,目前依旧BERT模型结果最佳,分别为86.6和86.3。

机器翻译

在机器翻译任务中(Machine Translation),目前取得最佳结果来自于Zhen Yang等人于今年4月在Arxiv上发布的文章:

该文章的算法主要结合了Transformer+BR-CSGAN,在BLEU上取得的评分结果为43.01,为目前最佳结果。

自然语言推断

在自然语言推断(Natural Language Inference)任务中,目前最佳结果来自于Yichen Gong等人于今年5月在Arxiv上发布的文章:

该论文采用的算法是DIIN,在准确率方面目前为89.84,目前处于最佳水平。

以上是计算机视觉和自然语言处理两个领域的最新发展情况。想要了解AI其它领域中各任务目前取得的最佳结果可以参考如下链接:

https://www.stateoftheart.ai/

注:投稿请电邮至124239956@qq.com ,合作 或 加入未来产业促进会请加:www13923462501 微信号或者扫描下面二维码:

文章版权归原作者所有。如涉及作品版权问题,请与我们联系,我们将删除内容或协商版权问题!联系QQ:124239956