学界 | 多 GPU 加速学习,这是一份崭新的 XGBoost 库

选自arXiv

机器之心编译

参与:思源、李亚洲

随着数据规模越来越大,很多经典的机器学习算法也越来越需要 GPU 的并行计算能力。以前 XGBoost 也能使用 GPU 与 CUDA,但效率并不是很高。而最近怀卡托大学和英伟达提出了一种新型决策树加速方法,它能支持多 GPU 高效加速 XGBoost。目前这一改进与实现已经加入到了标准 XGBoost 库中,我们可以直接在 GPU 环境下进行编译与使用。

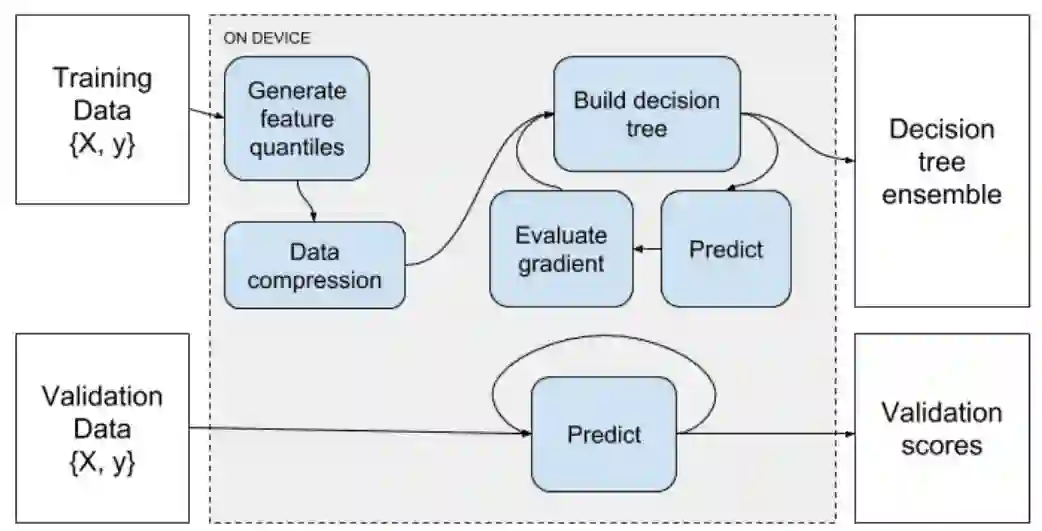

梯度提升是一种可以获得当前最佳性能的监督学习方法,它在分类、回归和排序方面有很好的表现。XGBoost 是一般化梯度提升算法的实现,它在多核和分布式机器上有着高度优化的实现,且能处理稀疏数据。怀卡托大学和英伟达在这一篇论文中描述了标准 XGBoost 库的扩展,它支持多 GPU 的执行,并能显著地减少大规模任务的运行时间。本论文提出的扩展是原版 GPU 加速算法的新进展,它展现出拥有更快速和更高内存效率的策树算法。该算法基于特征分位数(feature quantiles)和梯度提升树其它部分的并行化算法。作者们在 GPU 上实现决策树构建、分位数生成、预测和梯度计算算法,并端到端地加速梯度提升流程。这一过程使得 XGBoost 库可以利用显著提升的内存带宽和大规模并行化 GPU 系统集群。

作者实现的 GPU 加速扩展现在已经可以在标准 XGBoost API 中进行获取,我们只需要编译为 GPU 版本就行了。该 GPU 加速版本目前可用于 C++、Python、R 和 Java,并支持所有 XGBoost 的学习任务,如回归、分类、多类别分类和排序等。这一实现目前支持 Windows 系统与 Linux 系统,且与原版 XGBoost 算法一样支持稀疏输入数据。

XGBoost 项目地址:https://github.com/dmlc/xgboost

论文:XGBoost: Scalable GPU Accelerated Learning

论文地址:https://arxiv.org/abs/1806.11248

我们于本论文中描述了在 XGBoost 库中实现的多 GPU 梯度提升算法。我们的算法允许使用多 GPU 系统实现快速、可扩展的训练,并且支持 XGBoost 的所有特征。我们使用数据压缩技术以最大限度降低 GPU 显存的占用,但仍然允许高效地实现。根据算法性能,我们可以在公有云计算实例上三分钟内处理 1.15 个训练样本。该算法使用端到端的 GPU 并行算法实现,其中预测、梯度计算、特征量化、决策树构建和评估阶段都在本地进行。

2. 描述

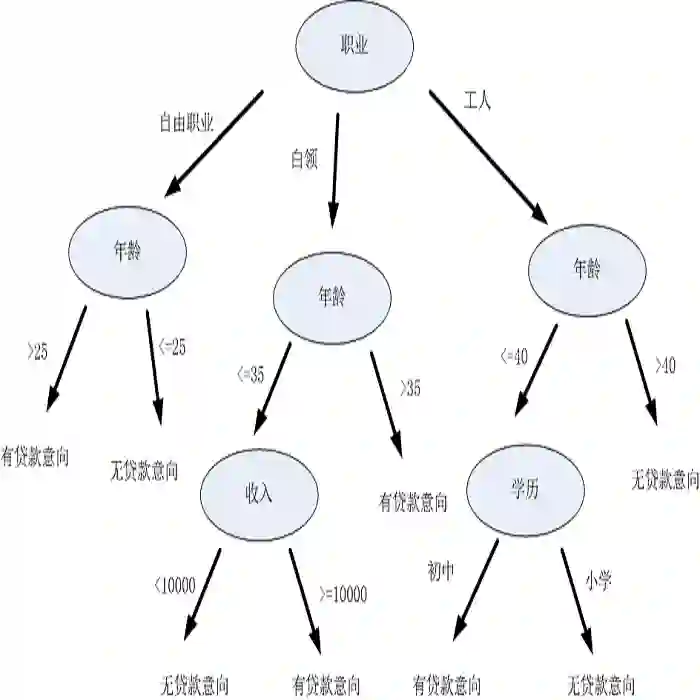

监督梯度提升将标注的训练数据集作为输入,并反复定义一系列树来渐进改善目标函数的准确率。图一在更抽象层面上展示了这一过程,我们在一个或者多个 GPU 上实现了这些重要的运算。

图 1:梯度提升流程

3. 评估

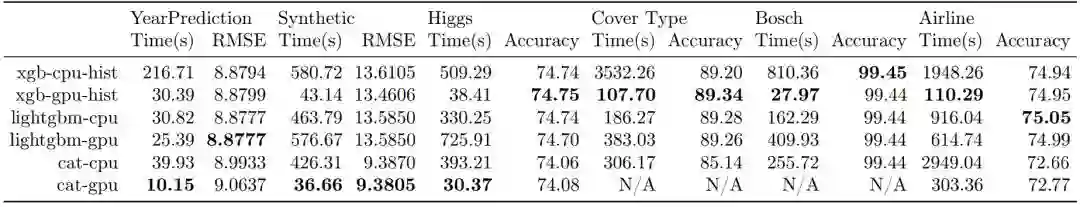

我们把最新的实现与 XGBoost 的两个主要对手:LightGBM 与 CatBoost 做了对比,它们都是用多核 CPU 和 GPU 训练实现。评估是在带有 8 块 Tesla V100 GPU 和 64 个 CPU 计算核心的云上完成的。

复现参数与基准请查看:https://github.com/RAMitchell/GBM-Benchmarks

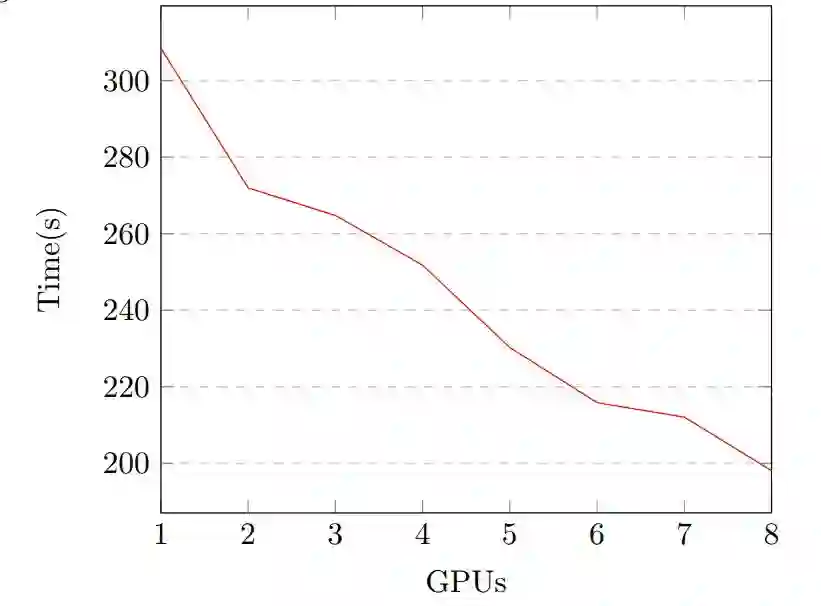

图 2:XGBoost 在 Airline 数据集上的运行时间:1-8 块 V100 GPU。

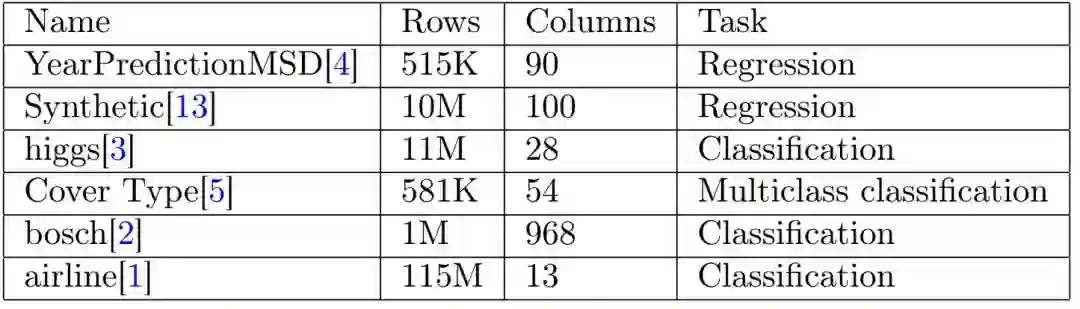

表 1 :数据集

表 2:评估结果

在 6 种数据集中,我们的算法(xgb-gpu-hist)在其中 3 种数据上是最快的,在两种数据集上是最准确的。例如在最大的数据集(1.15 亿条数据)上,我们的算法要比其它算法快了 3 倍。在任意数据集上,它的运行时间都不会超过 2 分钟。图 2 展示了在 airline 数据集上加上额外 GPU 的运行时间。通过在 8 块 GPU 上作压缩与分布式训练,每块 GPU 只需要 600MB 来存储整个矩阵。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com