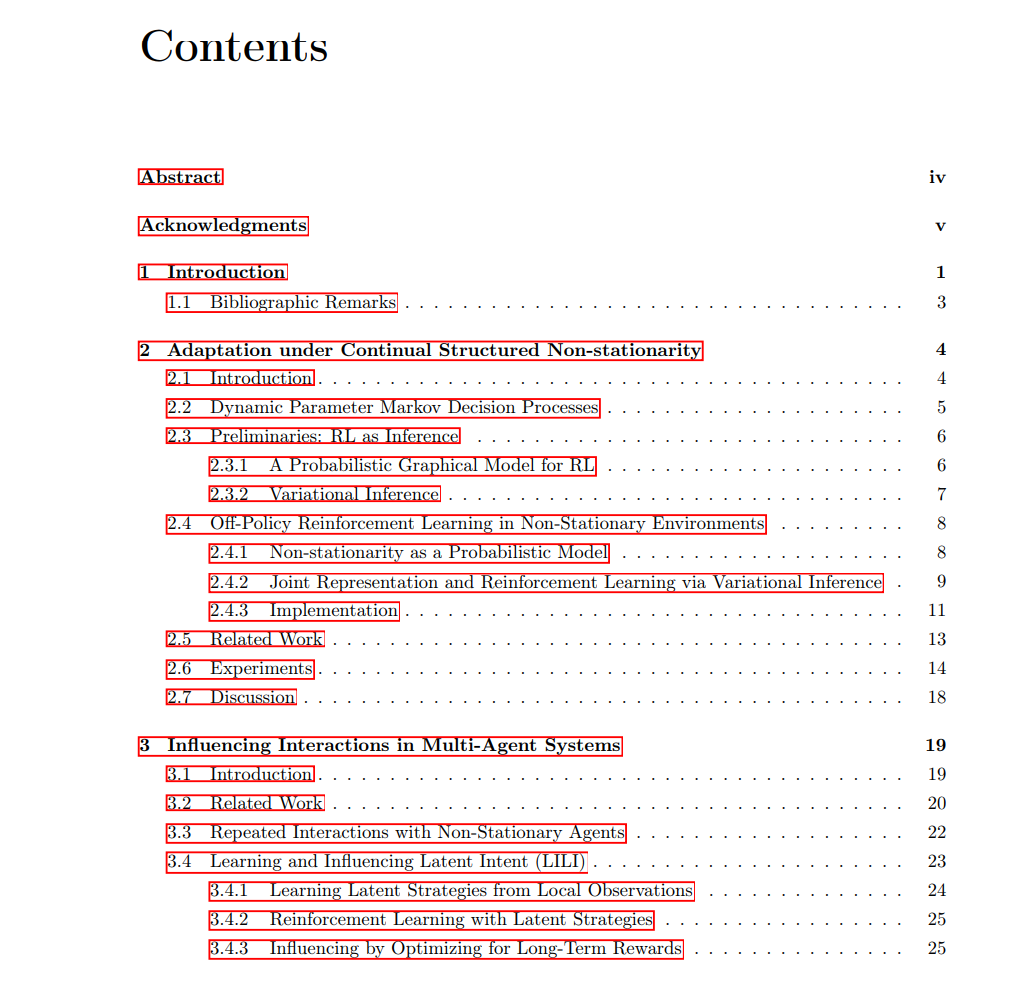

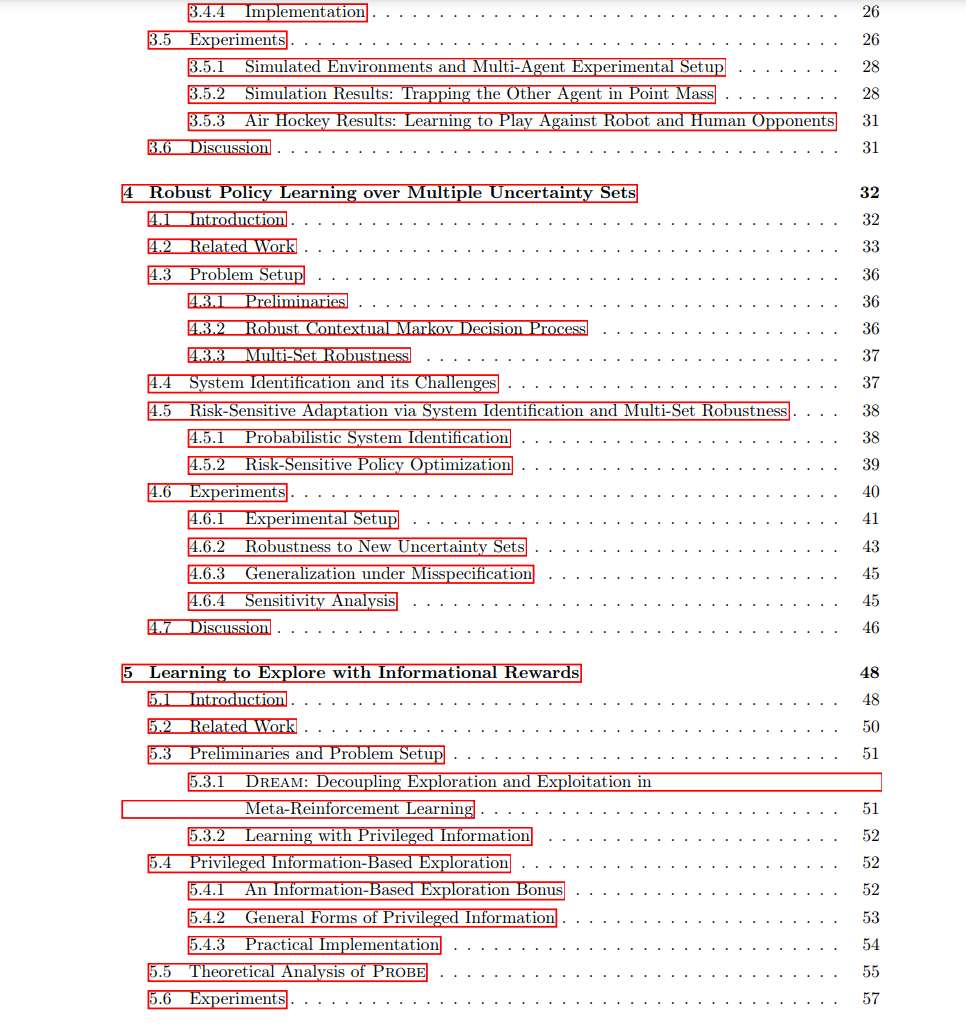

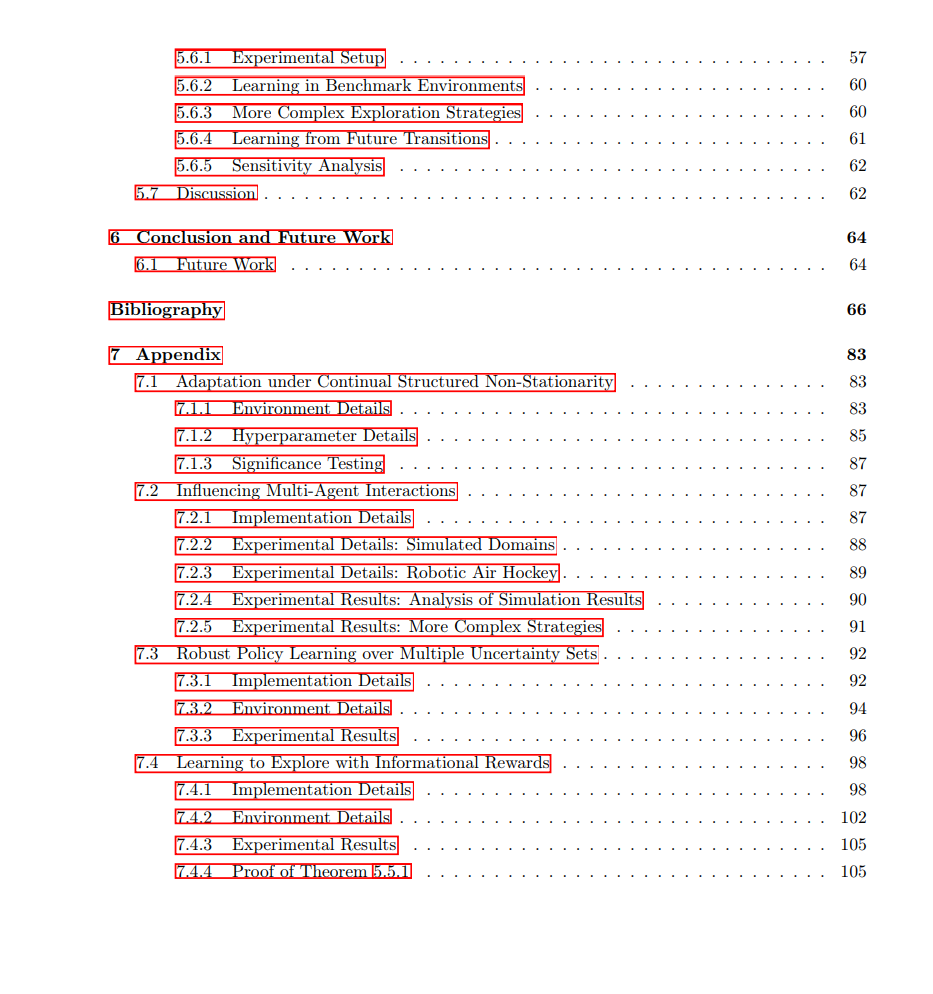

强化学习通常假设代理的学习环境是静态且不变的。然而,这一假设在强化学习的实际应用中很少成立。例如,在机器人应用中,非平稳性可能以多种方式表现出来,如需要在不可预测的地形中导航,或帮助人类用户处理其随时间变化的偏好。因此,快速适应环境变化的能力对于成功的决策系统至关重要。为了更正式地建模这种非平稳性,我们考虑一个在决策时间步上不断发展的学习环境。更具体地说,学习环境中存在随时间变化的特征,并且这些特征可能会随着代理的行为而变化。为了应对这种动态性,代理必须学会最终独立应对这种非平稳性,并根据环境变化调整其行为,例如做出不同的决策以更好地帮助具有新偏好的用户。 在本论文中,我们聚焦于为这种动态环境设计算法。具体而言,我们首先提出一个统一的框架,将环境的相关特征捕捉到一个紧凑的表示中。我们证明,在环境具有某些特性的情况下,这种表示可以仅通过与环境的交互来学习,而无需在训练过程中额外访问潜在特征。通过将环境视为一个顺序潜变量模型,其中随时间变化的特征为潜变量,我们可以利用无监督表示学习技术的进展,从数据中学习这一表示。此外,在可以建模这些特征的动态性的情况下,我们学习它们的预测模型,以预测它们如何变化,特别是在代理采取不同动作时如何响应。

在获得这样的表示后,我们可以设计学习目标来塑造代理的行为。本论文中我们刻画了几种非平稳性类型,如被动性与主动性,以及变化的频率,并利用这些特性设计更有效的策略学习算法。具体来说,利用所学的表示,我们提出了能够使代理(i)预测未来环境特征,从而实现更快速和更稳健的适应,和(ii)影响或塑造这些特征变化,以获得更高的长期奖励的目标。最后,当未来的潜在特征不可预测时,我们设计了能够通过探索环境主动收集有关这些特征信息的代理。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日