现有的强化学习(Reinforcement Learning, RL)系统在应用于真实世界场景时面临重大挑战,其核心原因在于:这些系统难以在与训练条件不同的环境中实现良好的泛化能力。本论文探索的一条研究路径是:通过赋予强化学习智能体以类似人脑中有助于系统性泛化的推理行为,从而增强其零样本(zero-shot)系统性泛化能力。

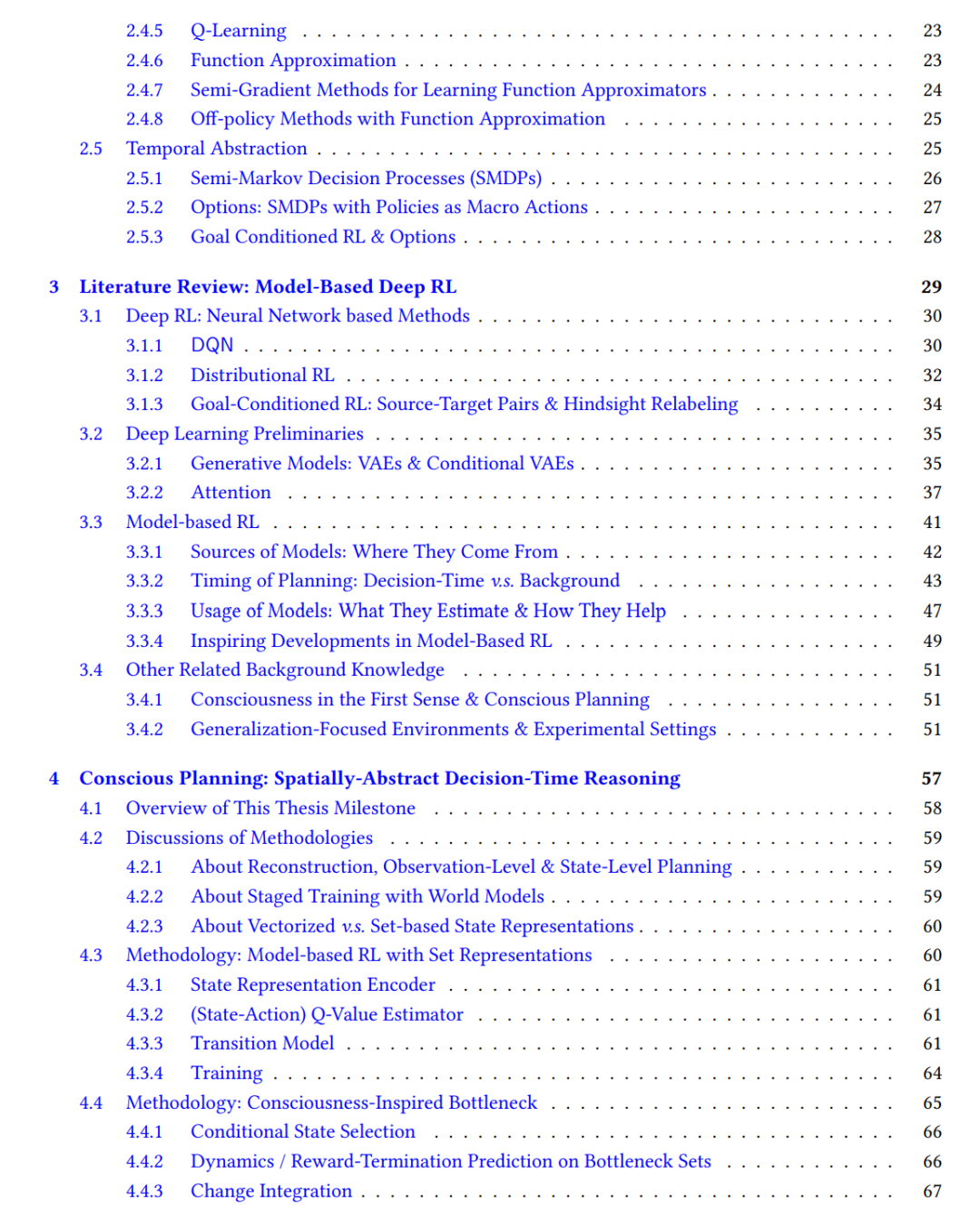

受人类有意识规划行为的启发,我们首先引入了一种自顶向下的注意力机制,使智能体能够在决策时动态地将推理过程聚焦于在当前意图下与环境状态最相关的部分,我们将这一过程称为“空间抽象”(spatial abstraction)。该方法显著提升了智能体在训练任务之外的系统性泛化能力。

在空间抽象的基础上,我们进一步提出了 Skipper 框架,用于自动将复杂任务分解为更简单、更易处理的子任务。通过聚焦环境中相关的空间与时间要素,Skipper 在应对分布偏移(distributional shift)时展现出较强的鲁棒性,并在长期、可组合规划中表现出高效性。

最后,我们识别了一类常见的失败模式及安全风险:依赖生成模型在规划过程中生成目标状态的规划智能体通常会“盲目信任”其自身臆想的目标,从而导致“妄想式规划”行为。受到人脑拒绝妄想性意图机制的启发,我们提出为智能体学习一个“可行性评估器”,用于拒绝那些由智能体生成但不可行的目标。结果表明,这一方法在多类规划智能体中都带来了显著的性能提升。

本文最后提出了未来研究方向,包括实现更通用的任务抽象机制,以及进一步推动真正意义上的抽象规划能力。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日