论文解读者:北邮 GAMMA Lab 硕士生 李晨

![]()

题目: Graph Neural News Recommendation with Long-term and Short-term Interest Modeling

期刊: Information Processing & Management (Volume 57, Issue 2)

论文链接:

https://www.zhuanzhi.ai/paper/72ea3ae6903561941f3bef5ea83d036e

随着新闻文章的信息爆炸,个性化的新闻推荐因为能够让用户快速找到自己感兴趣的文章,已经越来越受到业界和学术界的关注。现有的新闻推荐方法主要包括基于用户-新闻直接交互的协同过滤方法和基于用户历史阅读内容特征的基于内容的方法。虽然这些方法取得了良好的性能,但由于大多数方法无法广泛利用新闻推荐系统中的高阶结构信息(例如U-D-T-D-U隐含相似的用户倾向于阅读相似的新闻文章信息),存在数据稀疏问题。在本文中,我们提出构建一个异质图来明确地建模用户、新闻和潜在主题之间的交互。附加的主题信息将有助于捕捉用户的兴趣,并缓解用户-新闻交互的稀疏性问题。然后我们设计一个新颖的异质图神经网络学习用户和新闻表示,通过在图上传播特征表示来编码高阶结构信息。通过异质图完整的用户点击历史学习到的用户嵌入能够捕获用户的长期兴趣。此外,我们还设计了融合注意力的LSTM模型使用最近的阅读历史来建模用户最近的短期兴趣。

1 引言

个性化新闻推荐的典型方法有很多种,包括协同过滤(CF)方法和基于内容的方法。基于ID的协同过滤方法经常遇到冷启动问题,因为过时的新闻经常被更新的新闻替换。而基于内容的方法则完全忽略了协同信息。针对这一问题,提出了协同过滤与内容相结合的混合推荐方法。但这些方法都存在数据稀疏性问题,不能广泛利用高阶结构信息(如

关系表示用户

和

之间的行为相似度)。此外,它们大多忽略了潜在的主题信息,这些信息有助于表明用户的兴趣,并减少稀疏的用户-新闻交互。直觉上来讲,当用户点击很少的新闻条目时,可以通过主题作为桥梁聚合更多的信息。同时,现有的新闻推荐方法很少考虑到用户的长期和短期兴趣。用户通常具有相对稳定的长期兴趣,也可能会被某些事物暂时吸引,即短期兴趣,在新闻推荐中应该考虑到这一点。例如,用户可能会持续关注政治事件,这是一个长期的兴趣。相比之下,某些突发新闻事件,如恐怖分子暴动,通常会引起暂时的兴趣。

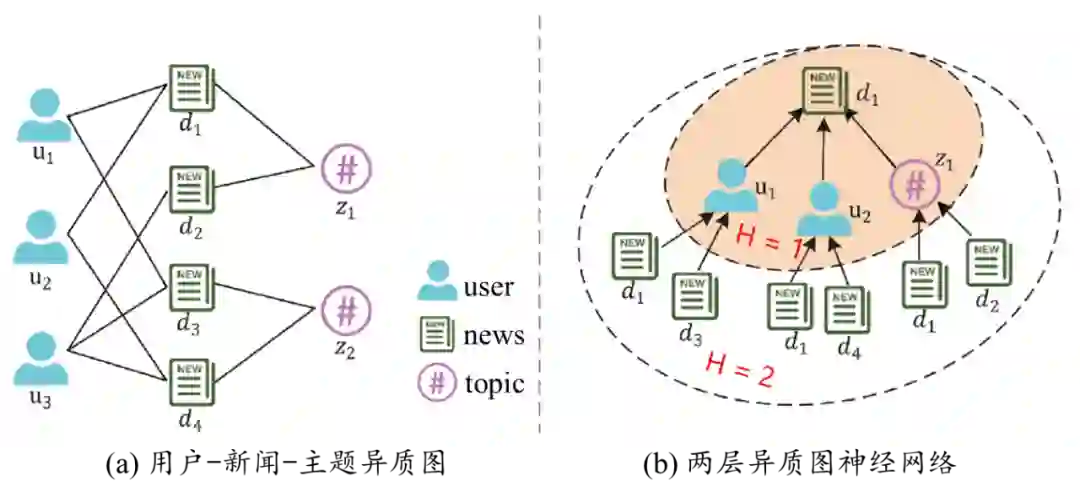

为了解决上述问题,本文提出了一种新的异质图神经网络新闻推荐模型(简称GNewsRec)。具体而言我们首先构建一个异构的用户-新闻-主题图,如图1(a)所示,以明确的建模用户、新闻和主题之间的交互。主题信息可以帮助更好地反映用户的兴趣,并缓解用户-新闻交互的稀疏性问题。为了编码用户、新闻和主题之间的高阶关系,本文利用图神经网络(GNN)在图上传播特征表示来学习用户和新闻表示,通过异质图完整的用户点击历史学习到的用户嵌入能够捕获用户的长期兴趣。此外本文还设计了基于注意力的LSTM,使用最近的用户阅读历史来建模用户的短期兴趣。最后将用户的长期和短期兴趣融合起来,然后将其与候选新闻表示拼接计算以预测最终的评分。

![]()

图1. 用户-新闻-主题异质图与两层异质图神经网络。

2 模型介绍

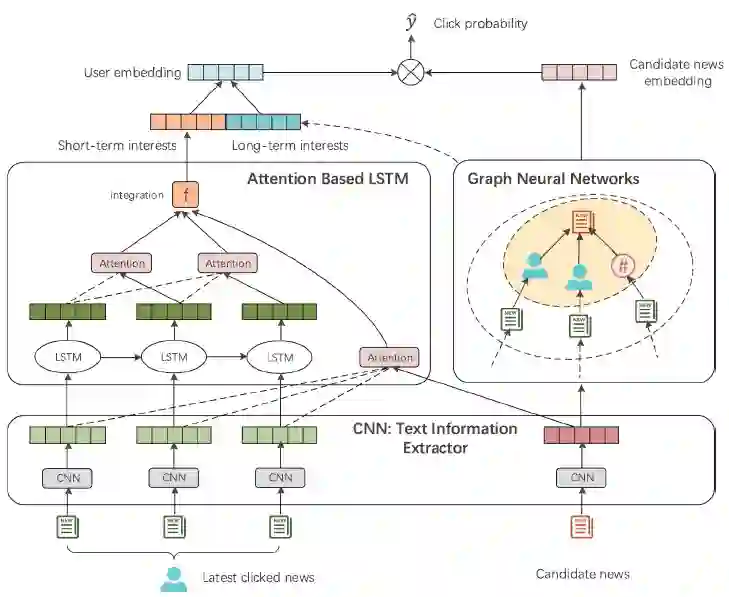

如图2所示,GNewsRec模型包含三个主要部分:用于文本信息提取的CNN,用于长期用户兴趣建模和新闻建模的GNN,以及用于短期用户兴趣建模的基于注意力的LSTM模型。第一部分是通过CNN从新闻标题和概要中提取新闻特征。第二部分构建具有完整用户点击历史记录的用户-新闻-主题异质图,并应用GNN编码高阶结构信息。附加的潜在主题信息可以缓解用户-项目的稀疏性,因为用户点击较少的新闻项目可以通过主题作为桥梁而聚合更多的信息。在图上具有完整的用户点击历史学习到的用户嵌入能够建模相对稳定的长期用户兴趣。在第三部分,我们还通过一个基于注意力的LSTM模型编码最近的阅读历史来建模用户的短期兴趣。最后,我们将用户的长期和短期兴趣结合起来得到用户最终表示,然后将其与候选新闻表示进行比较以进行推荐。

![]()

2.1 文本信息提取器

我们使用两个并行的CNN作为新闻文本信息提取器,分别以新闻的标题和概要作为输入,学习新闻的标题级和概要级表示。这两个表示相拼接作为新闻的最终文本特征表示。

2.2 用户长期兴趣建模与新闻建模

我们将潜在的主题信息整合到新闻文章中,以更好地表明用户的兴趣,缓解用户-新闻稀疏问题。因此,本文构造一个异质无向图G=(V,R),如图1(a)所示,其中V和R分别是节点集和边集。此图包含三种类型的节点:用户U、新闻I和主题Z。主题Z可以通过主题模型LDA来挖掘。

在构建的用户-新闻-主题异质图的基础上,利用GNN通过传播嵌入来捕获用户与新闻的高阶关系。以下是计算单个GNN层学习某节点表示的一般形式:

![]()

其中

AGGREGATE是聚合函数,它聚合来自相邻节点的信息,在本文中,我们使用的是均值聚合函数,它简单地取相邻节点向量的平均值。

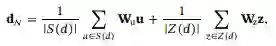

考虑具体的用户u和新闻d候选对,我们使用U(d)和Z(d) 分别表示与新闻文档d直接相连的用户和主题集合。在真实应用场景中,U(d)的大小对于不同新闻文档可能有较大的差异,为了保持每个批次的计算模式固定和高效性,我们对每篇新闻d统一采样一组固定大小的邻居|S(d)| = L,而不是使用其完整的邻居 。 根据上述GNN计算一般形式,为了刻画新闻d的拓扑结构,计算如下:

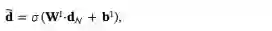

![]()

![]()

上文介绍的是一个单层的GNN新闻节点的表示学习,候选新闻的最终表示仅依赖于它的近邻。用户节点计算方式相似,就不赘述。为了捕捉用户和新闻之间的高阶关系,我们可以将GNN从一层扩展到多层,以更广更深的方式传播嵌入。

通过GNN,我们可以得到经过高阶信息编码的最终用户和新闻嵌入。通过完整的用户点击历史学习到的用户嵌入能够捕获相对稳定的长期用户兴趣。但是,我们认为用户可能会短暂被某些东西所吸引,即用户具有短期的兴趣,这也应该在个性化新闻推荐中考虑到。

2.3 用户短期兴趣建模

在本小节中,我们将介绍如何通过基于注意力的LSTM模型,使用用户最近的点击历史来建模用户的短期兴趣。我们不仅关注新闻内容,而且关注新闻的阅读顺序信息。

(1)内容上的注意力机制

给定用户u和他/她最近点击的l条新闻

,我们使用注意力机制来建模用户最近点击的新闻对候选新闻d的不同影响:

![]()

(2)时序上的注意力机制

除了使用注意力机制来建模用户当前基于内容的兴趣外,我们还关注最近阅读新闻的点击时序信息,因此我们使用基于注意力的LSTM来捕捉时序特征。如图2所示,LSTM将用户最近点击的新闻嵌入作为输入,输出用户的序列特征表示。由于每个用户当前的点击会受到之前交互历史的影响,因此我们使用上文介绍的注意力机制(内容上的注意力机制)应用于LSTM输出的每个隐含状态

与其之前的隐含状态

上来获得不同时刻的序列特征表示s_j。这些特征

通过CNN融合,最终得到用户关于最近l条点击历史的序列特征表示

我们将用户当前基于内容的兴趣表示

与序列特征表示

拼接输入到一个全连接层中,得到用户最终的短期兴趣嵌入:

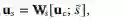

![]()

2.4 预测与模型优化

最后,通过对用户长期和短期兴趣嵌入向量的拼接进行线性变换,得到用户的最终表示:

![]()

然后将最终用户嵌入与候选新闻嵌入输入一层全连接层以预测用户点击新闻的概率:

![]()

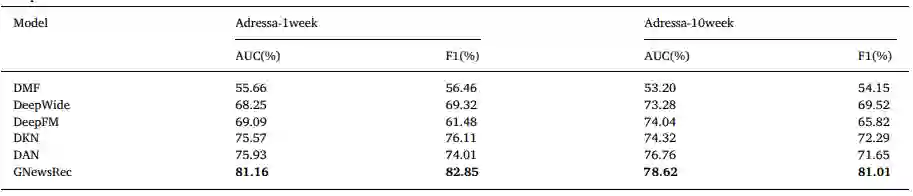

为了优化我们的模型,我们使用交叉熵作为我们的损失函数:

![]()

3 实验

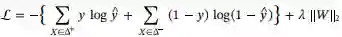

3.1 性能实验

![]()

从表1中我们可以看到,我们的模型对比最优对比模型在F1和AUC上都分别提高了10.67%和2.37%。我们将我们的模型的显著优势归结于以下三个方面:(1)我们的模型构建了一个异质的用户-新闻-主题图,并且使用异质图神经网络更好的编码了用户和新闻嵌入的高阶信息。(2)我们的模型既考虑了用户的长期兴趣,又考虑了用户的短期兴趣。(3)在异质图中引入主题信息,可以更好地反映用户的兴趣,即使很少用户点击的新闻仍然可以通过主题聚合相邻的信息,从而缓解用户-新闻交互的稀疏性问题。

我们还发现,所有基于内容的模型都比基于协同过滤的模型具有更好的性能。这是因为新闻推荐问题存在冷启动问题,基于协同过滤的方法不能很好地解决此问题。而我们的模型作为一个混合模型可以结合基于内容的推荐算法和基于协同过滤的模型的优点。此外,没有用户点击的新文档也可以通过主题连接到现有的图中,并通过GNN更新它们的嵌入。综合以上因素,我们的模型可以获得更好的性能。

3.2 消融实验

进一步,我们比较了GNewsRec的不同变体,以证明我们的模型设计在以下方面的有效性:GNN学习带有高阶结构信息编码的用户和新闻嵌入,结合用户长期和短期兴趣以及引入主题信息。结果如下表2所示。

正如我们从表中看到的,当我们删除用于建模长期用户兴趣和新闻的GNN模块时,性能会有很大的下降。该模块通过构造异质图并应用GNN在图上传播嵌入在图中编码了高阶关系,这证明了我们模型的优越性。 去掉短期兴趣建模模块将在AUC和F1方面降低约2%的性能。这说明同时考虑用户的长期和短期利益是必要的。 与没有主题信息的变体模型相比,GNewsRec在这两个指标上都取得了显著的改进。这是因为主题信息可以缓解用户-新闻稀疏性带来的冷启动问题,很少用户点击的新文档可以通过主题聚合相邻的信息。

表2. GNewsRec变体模型的性能比较实验结果

![]()

3.3 参数实验

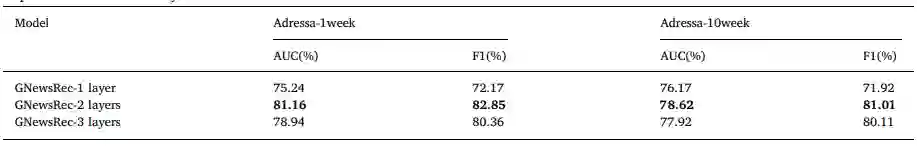

在本节中,我们主要探讨不同参数对GNewsRec的影响。我们研究了不同GNN层数的影响,以及新闻、用户和话题嵌入D的不同维度的影响。

![]()

我们将GNN的层数从1层设置到3层。从表3中,我们可以发现带有2层GNN的GNewsRec性能最好。这是因为1层GNN无法捕获用户和新闻之间的高阶关系,而3层GNN可能会给模型带来大量的噪声,因为层级越高,关系链越长,在推断节点间相似性时就越没有意义。因此,我们在GNewsRec模型中选择使用两层GNN。

![]()

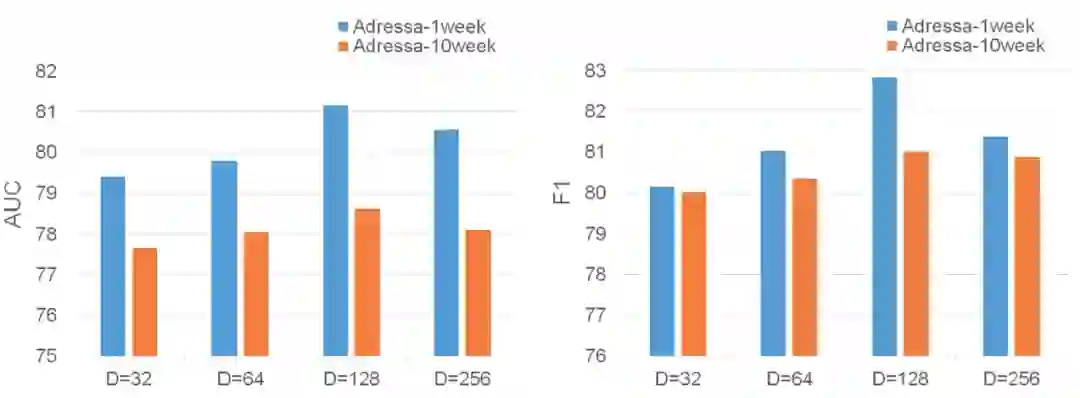

图3. 嵌入向量不同维度对GNewsRec性能的影响

图3显示了嵌入向量不同维度对GNewsRec性能的影响结果,从图上可得:(1)我们的模型在D = 128时性能最好,表明在该维度下最能表达新闻、用户和主题空间的语义信息。(2)模型效果先随着D的增加而增加,而后随着D的增加反而下降。这是因为过低的维数不足以捕获必要的信息,而过大的维数会引入不必要的噪声,降低泛化能力。

4 总结

在本章中,我们提出了一个新颖的融合长期和短期兴趣建模的异质图神经新闻推荐模型GNewsRec。我们的模型构建了一个用户-新闻-主题异质图来建模用户-新闻交互,从而缓解了用户-新闻交互的稀疏性。然后应用异质图卷积网络学习用户嵌入和新闻嵌入,通过在图上传播特征信息捕获高阶结构与语义信息。在真实新闻推荐数据集上的实验结果表明,我们的模型显著优于最先进的方法。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

![]()

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取5000+AI主题干货知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程资料和与专家交流咨询!

点击“

阅读原文

”,了解使用

专知

,查看获取5000+AI主题知识资源