![]()

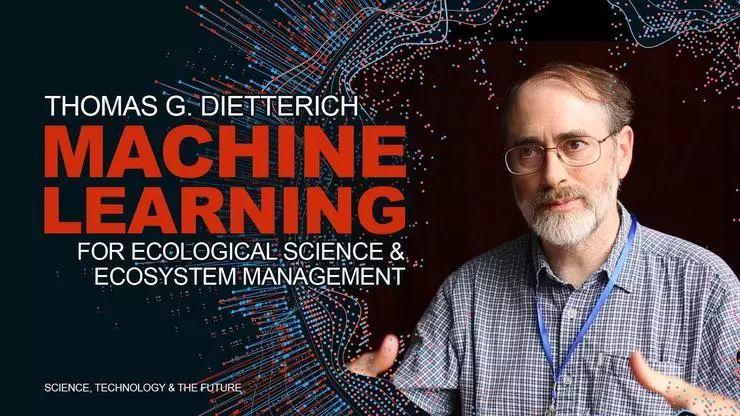

作者 | Thomas G. Dietterich

编译 | Fawn

AI 领域所取得的最新进展给 AI 系统带来的进步,举世瞩目,但是仍有一些批评者声称,即便如此,这些系统仍旧无法实现

“真实”、“准确”、“可信赖”的理解

。

在他们看来似乎 AI 系统必须是万能的,才能真正被人类称为“理解”。

Thomas G. Dietterich 是机器学习领域的奠基人之一,针对这个问题,他认为对AI系统的这种要求有点过分,因为我们对人类自身也没有这么高的标准。

他指出,

“理解”以一种连续的能力谱而存在

,比如大部分人对“水”的理解,可能限于水的一般属性,而不知道水的导电等属性,但我们

只会认为他们对水的理解不全面,而不会说他们的理解不“真实”、“准确”、“可信赖

”。

他既不赞成“如今的基于深度学习的系统没有表现出真正的理解,因此应放弃深度学习”的观点,也反对 “当今基于深度学习的系统已经取得了巨大进步,进一步研究它们将‘搞定智能’”的观点。

作为机器学习领域的奠基人之一,Thomas G. Dietterich的研究贡献主要包括将纠错输出编码应用于多类分类问题,他发明了多示例学习、层次强化学习MAXQ框架及将非参数回归树整合到概率图模型中的方法。此外,Dietterich教授也参与撰写了美国白宫发布的两份重磅AI报告:《为人工智能的未来做准备》和《美国国家人工智能研究与发展策略规划》。

一、关于“理解”之争

运用“真实”、“准确”、“真正”这类词意味着“理解”是二元的,即:

一个系统要么能“真正”的理解,要么不能。

这种思维方式的纰漏在于,人类的理解也是不完整和不完美的。

Thomas G. Dietterich 教授主张“理解”以一种连续的能力谱而存在。

比如,对于“水”这一概念,很多人能想到水的性质:

潮湿、可饮用、植物必需、遇冷结冰等等。

但同时,很多人并不知道,水也是一种电导体,因此淋浴的时候不能使用吹风机。

即便如此,我们也不能说这些人没有“真实”、“准确”、“真正”地理解 “水”,只能说他们的理解是不全面的

。

因此,

我们应该以同样的态度来评估 AI 系统。

现有的系统已表现出某种程度的理解。

例如:

当我对 Siri 说 “打给 Carol”,而 Siri 也拨出了正确号码,这能够表明系统理解了我的指令;

当我问 Google “IBM的Deep Blue系统击败了谁?

”,它回答:

“Kasparov”,这也能证实系统理解了我的指令。

当然这种理解有一定限度,当我继续问 Google:

“when?

”它就只能给我解释词典上关于“when”的解释。

显然它没有把我第二个问题当做对话的一部分。

关于“理解”的争论可以追溯到亚里斯多德,而在 Searle的“Chinese Room argument”(无论程序如何聪明或像人类一样,执行程序的数字计算机都不能表现出“头脑”,“理解”或“意识”)对于“理解”的认识更为清楚。

我坚持主张功能主义,他们以功能上的理解为特征,并根据它们在产生测量功能中的因果作用来评估大脑或AI系统中各种内部结构的贡献。

从软件工程的角度来看,功能主义鼓励我们设计一系列测试来衡量系统的功能。

我们可以问一个系统(或一个人),如果“我把水冷却到20度会怎么样?”或者“如果我在淋浴时使用吹风机会发生什么?” 然后测试反应。

当系统的回答在一定范围内是适当的,我们认为系统理解正确;

当系统的回答在一定范围内是错误的,针对这一点我们已经发现了系统不理解的情况。

为了使系统能够理解,它必须在不同的概念、状态和动作之间建立联系。

当今的语言翻译系统可以正确地将英语中的“水”与西班牙语中的“水”连接起来,但是在“水”和“导电体”之间没有任何联系。

二、批评的进步意义

第一,

围绕人工智能的炒作(由研究人员、他们工作的组织、甚至政府和资助机构制造)已经达到了极端的程度

。

它甚至引发了“超级智能”或“机器人末日即将来临”的恐惧。

要反驳这种无稽之谈,批评是必不可少的。

第二,

批评是关于人工智能技术未来研究方向以及政府拨款分配的辩论的一部分

。

一部分批评者是联结主义的倡导者,他们发展了深度学习并支持继续进行这一研究。另

一部分批评者倡导基于符号的构造和操纵(例如,使用形式逻辑)的AI方法。

也有越来越多的社区主张在混合架构中结合这两种方法的系统。

批评对于此讨论也至关重要,因为 AI 社区必须不断挑战我们的假设,并选择如何投入社会的时间和金钱来促进AI科技的发展。

然而,Thomas G. Dietterich 教授反对这样的论点,即“如今的基于深度学习的系统没有表现出真正的理解,因此应放弃深度学习。

”

他认为,这个论点与 “当今基于深度学习的系统已经取得了巨大进步,进一步研究它们将‘搞定智能’”的论点一样是错误的。

我们应该继续追求联结主义方案,象征主义方案,以及新兴的混合方案,因为它们都将继续富有成效。

对深度学习的批评已经引领了新的方向。

特别是,深度学习系统可以在各种基准任务上与人类的表现相匹配,但却不能推广到超级的、真正非常相似的任务,这已经在机器学习中产生了危机。

科学家们用一些新的思想诸如学习不变量、发现因果关系等模型来回应此类问题。

这些思想既适用于符号学习,也适用于联结主义机器学习。

三、专注于功能的进步

我们应该在不涉及“什么才是真正的理解”的争论的情况下,追求人工智能科学技术的进步。

相反地,Thomas G. Dietterich 教授鼓励我们将重点放在我们应该在未来 5 年、10年或50年内努力实现的系统功能上。

我们应该根据可以在 AI 系统上执行的测试来定义这些功能,以衡量它是否具有这些功能。

为此,这些能力必须付诸实施。

简而言之,他指出测试驱动的AI发展,

这就要求我们

将模糊的理解和智力概念转化为具体的、可衡量的能力

。

这本身就是一个非常有用的练习。

操作测试不必只考虑AI系统的输入输出行为。

它们还可以检查产生此行为的内部结构(数据结构,知识库等)。

人工智能优于神经科学的一大优势是,我们可以更轻松地在人工智能系统上进行实验,以了解和评估其行为。

然而,需要注意的是,

包括深度学习在内的联结主义方法通常会创建难以解释的内部结构,和大脑有些类似

。

因此,

我们不应该将确保某些结构(例如,符号表示)存在作为研究目标。

相反,我们应该专注于所需的行为能力,并寻求内部机制如何实现这些能力。

例如,要进行成功的对话,每个参与者都必须跟踪互动的历史。

但是现已有很多方法可以做到这一点,我们不一定要期望在深度学习系统中建立明确的历史记忆。

相反地,仅仅因为我们编写了一个特定的内部结构,也并不意味着它就按我们所希望的那样运行。

Drew McDermott 在他的著名评论《人工智能与自然愚蠢》中详细讨论了这个问题。

四、直面成功与批评

人工智能不断发展和批评的浪潮的结果之一就是所谓的“人工智能效应”,其中人工智能领域被认为是失败的,因为最先进的系统没有表现出真正的理解或真正的智慧,

其结果就是AI的成功被忽视,经费被取消

。

例如,曾经有一段时间,下棋或下围棋被认为是衡量智力的一种标准。

但是,1997年,当Deep Blue击败Kasparov时,一位著名的人工智能研究人员认为,在国际象棋中击败人类已经展现出真正的智能,而同时必须解决“卡车倒车的问题”,这涉及将一辆铰接式半挂车倒进停车位(个人通信)。

实际上,九年前 Nguyen 和 Widrow 已经使用强化学习解决了这个问题。

如今,许多有思想的评论家再次提出新任务,并提出新的必要或充分条件,以声明系统“可以理解”。

同时,人工智能研究与开发正在提供功能越来越强大的系统,这些系统可以为社会带来价值。

人

工智能研究人员应该为人工智能的成功正名,同时也应该承认人工智能的缺点,这对学术诚信和持续的资助都很重要。

Thomas G. Dietterich 教授指出,我们必须遏制围绕 AI 新进展的炒作,我们必须客观地衡量 AI 系统在哪些方面了解用户(是否了解用户)、它们的目标,以及他们操作的更广泛的真实世界。

“让我们不要再认为人工智能的成功是虚假的、不真实的,让我们继续以诚实和富有成效的自我批评向前迈进。

”

via

https://medium.com/@tdietterich/what-does-it-mean-for-a-machine-to-understand-555485f3ad40

![]() 点击“阅读原文” 前往 问卷填写页面

点击“阅读原文” 前往 问卷填写页面